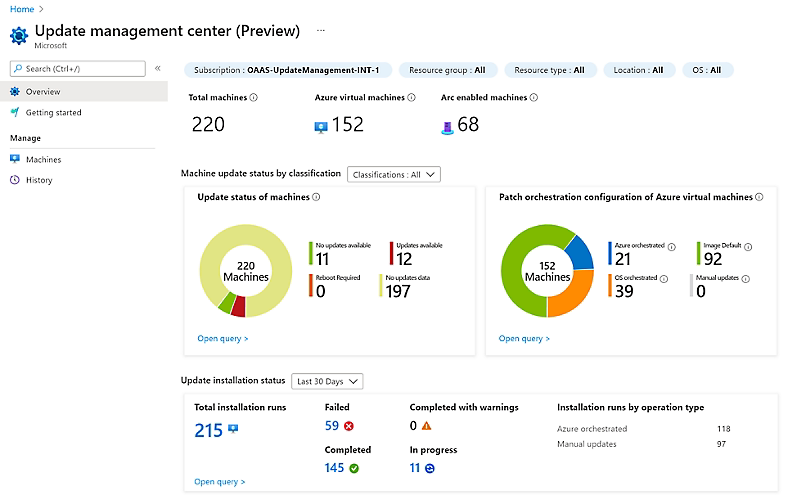

Microsoft nous prévient déjà depuis assez longtemps : la fin du support de Windows Server 2012 R2 et SQL 2012 sont prévues pour le 10 octobre 2023 😖. Après cette date, ces produits ne recevront plus de mise à jour, sécurités incluses ! Trois s’options s’offrent alors à vous :

- Migrer vers une nouvelle version Windows ou SQL plus récente.

- Acheter les Mises à jour de sécurité étendue (ESU).

- Migrer les serveurs vers Azure pour recevoir gratuitement les ESUs.

Pas de panique !

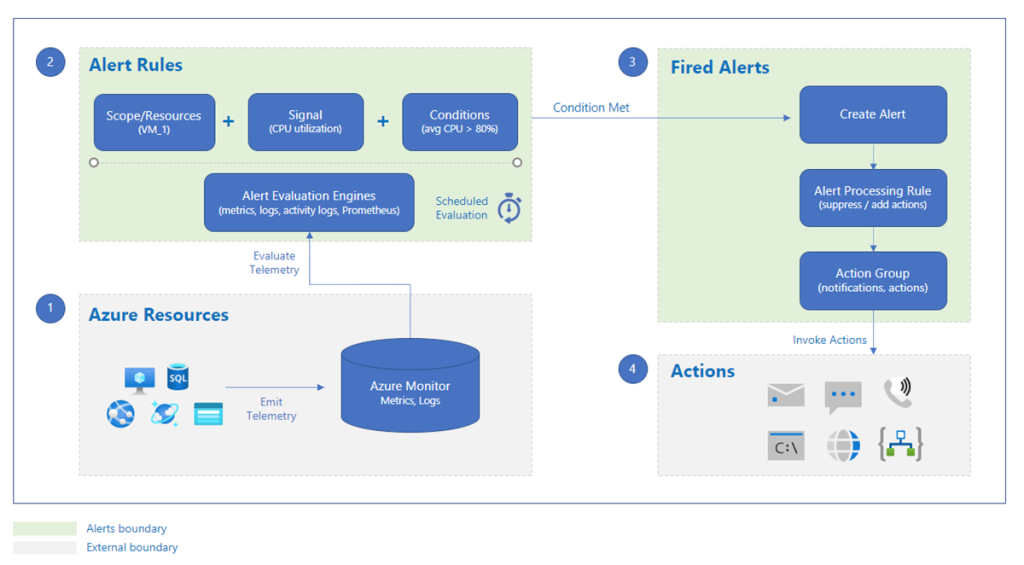

Microsoft vous aide à planifier la fin de support Windows Server 2012/2012 R2 et SQL Server 2012. Plusieurs ressources sont mises à disposition :

- Vue d’ensemble des mises à jour de sécurité étendue (ESU) pour Windows Server

- Sécuriser maintenant ; mettre à niveau et transformer lorsqu’elles sont prêtes

- Conditions d’éligibilité de l’ESU

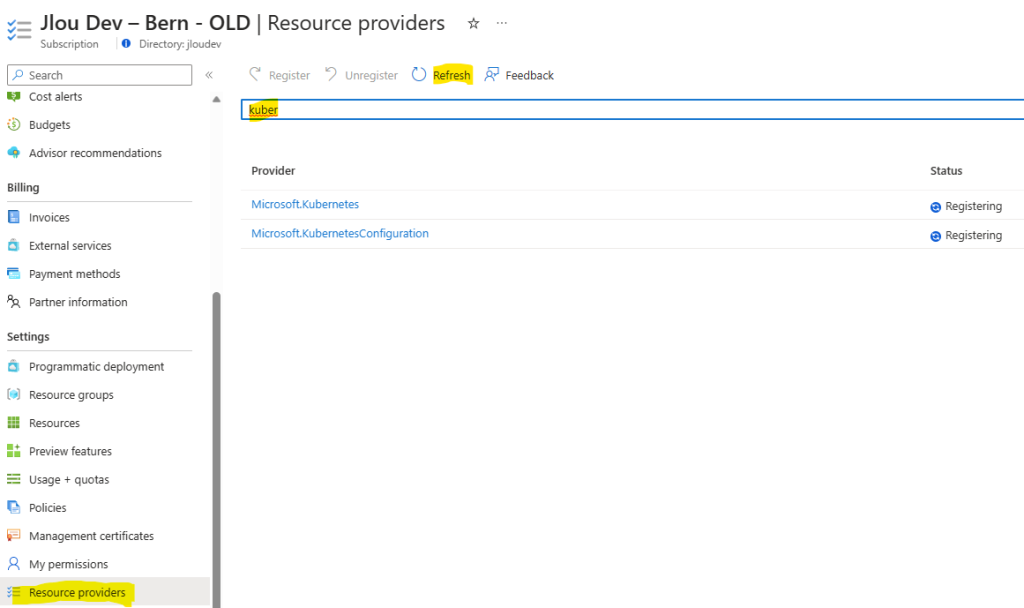

En plus de la documentation Microsoft, Dean Cefola de l’Azure Academy nous propose un petit exercice d’upgrade d’un Active Directory, actuellement hébergé sur un serveur Windows 2012R2 vers un Azure en version 2022 :

La vidéo est vraiment bien faite et très explicative, je souhatais donc vous proposer en détail l’explicatif étape par étape en français afin que vous puissiez le tester par vous-même :

- Etape 0 – Rappel des prérequis

- Etape I – Déploiement des ressources Azure

- Etape II – Déploiement de la passerelle VPN Azure

- Etape III – Ajout du second contrôleur de domaine Azure

- Etape IV – Transfert des 5 rôles FSMO

- Etape V – Décommissionnement l’Active Directory DC2012R2

- Etape VI – Mise à niveau du domaine Active Directory

- Etape VII – Test de connexion depuis le réseau on-premise

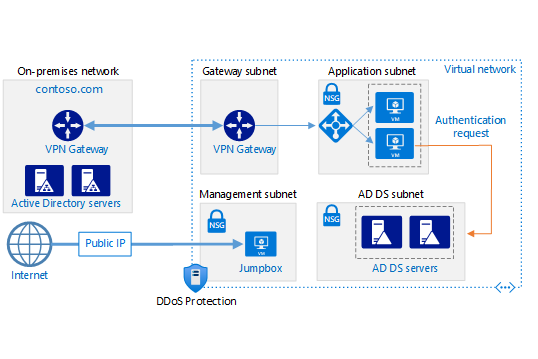

Enfin, Microsoft met aussi à disposition un article dédié à ce sujet : Déployer AD DS dans un réseau virtuel Azure

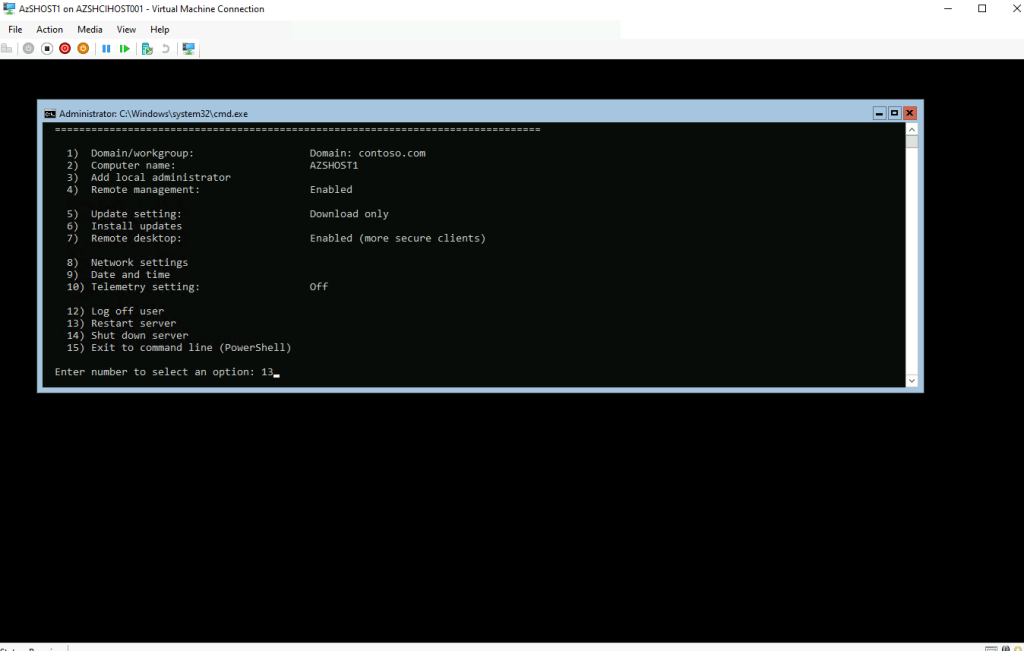

Etape 0 – Rappel des prérequis :

Pour réaliser cet exercice sur la migration Active Directory vers Azure, il vous faudra disposer de :

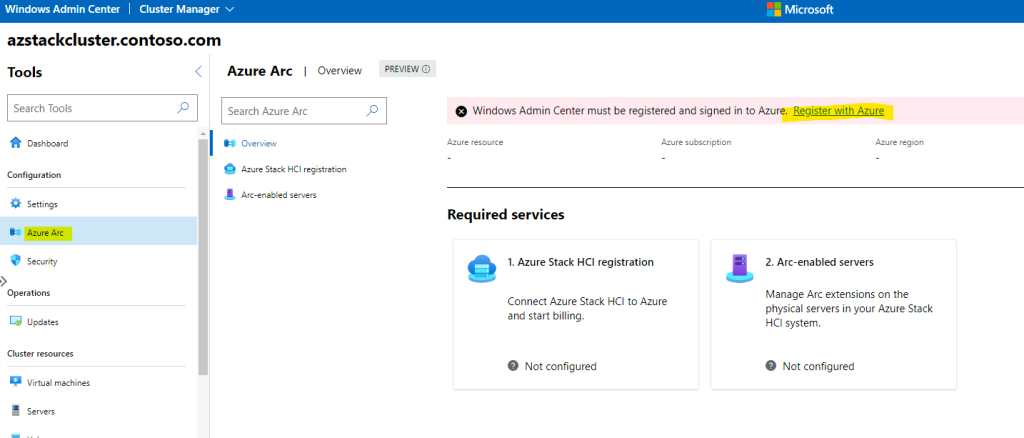

- Un tenant Microsoft

- Une souscription Azure valide

- Un environnement Active Directory on-premise (point de départ)

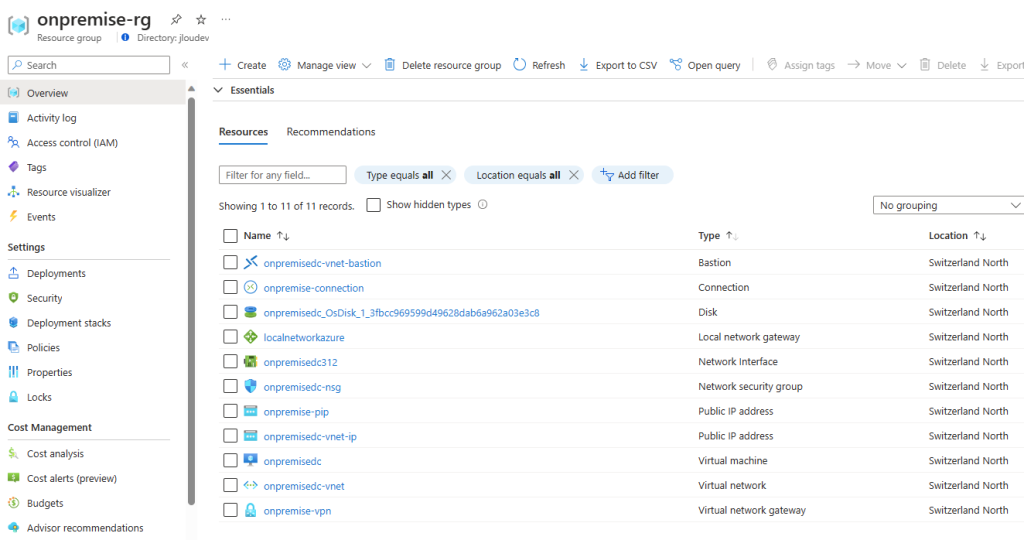

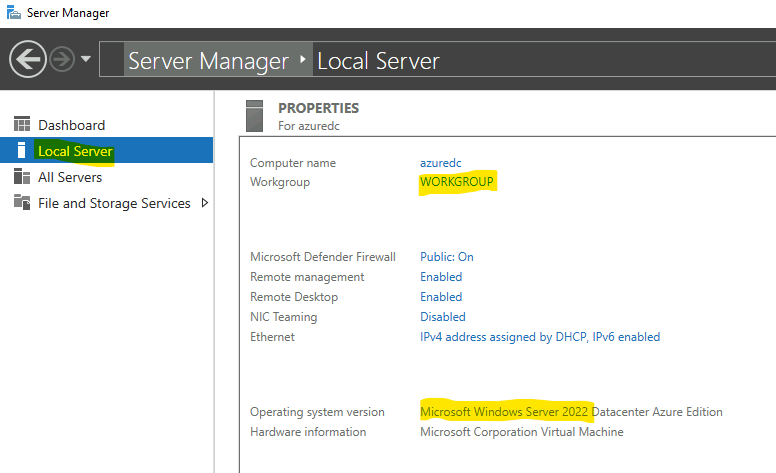

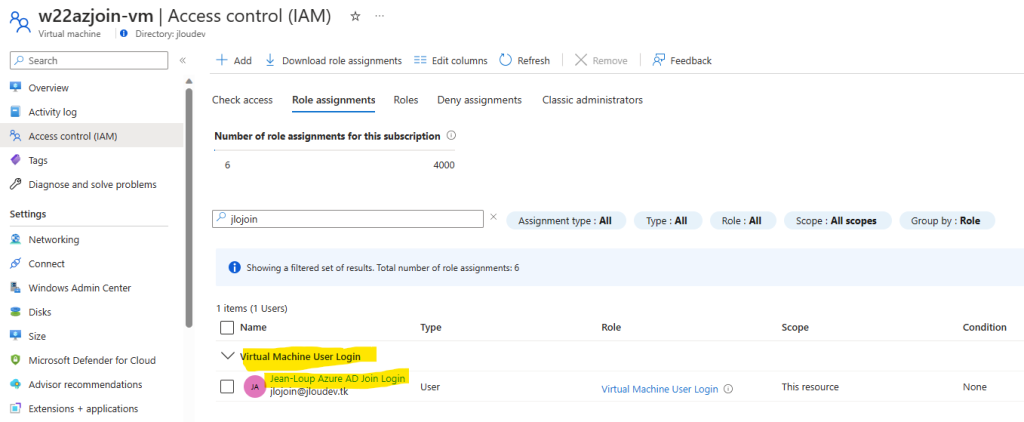

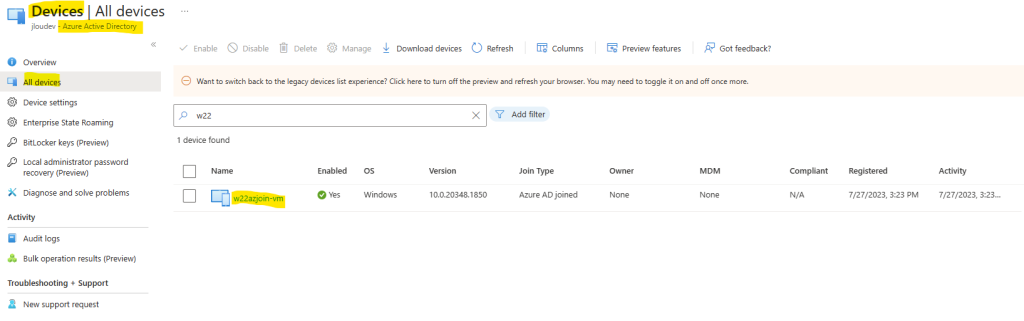

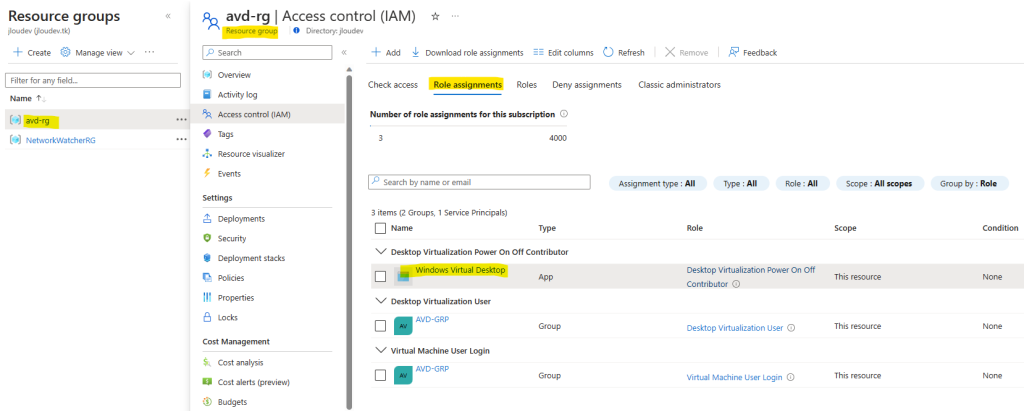

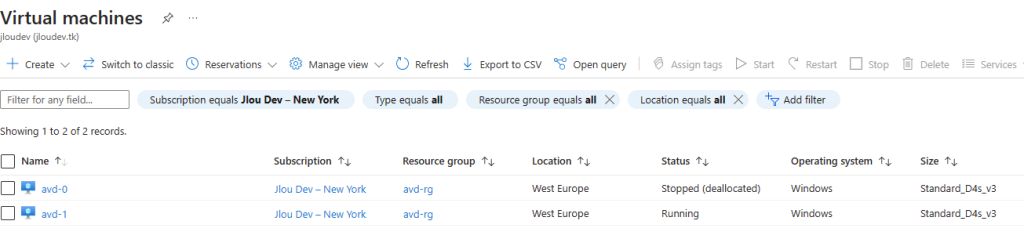

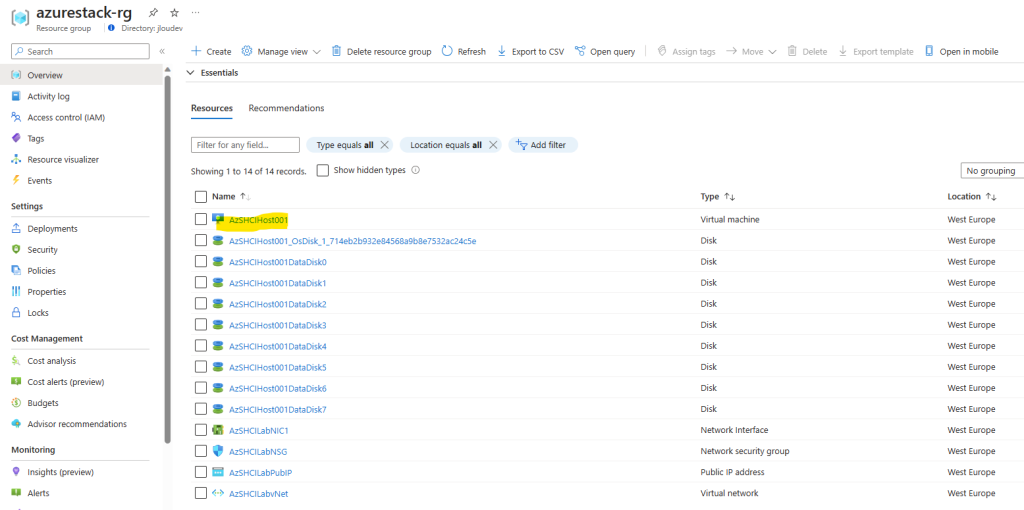

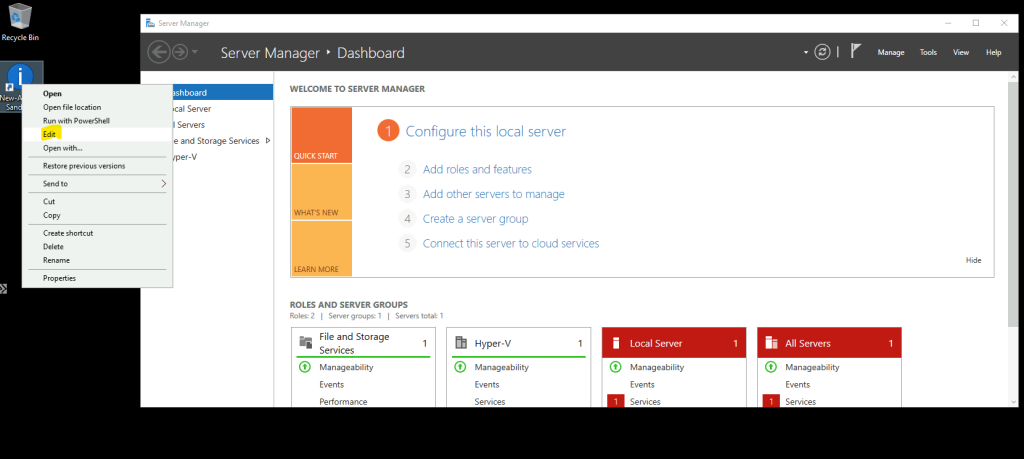

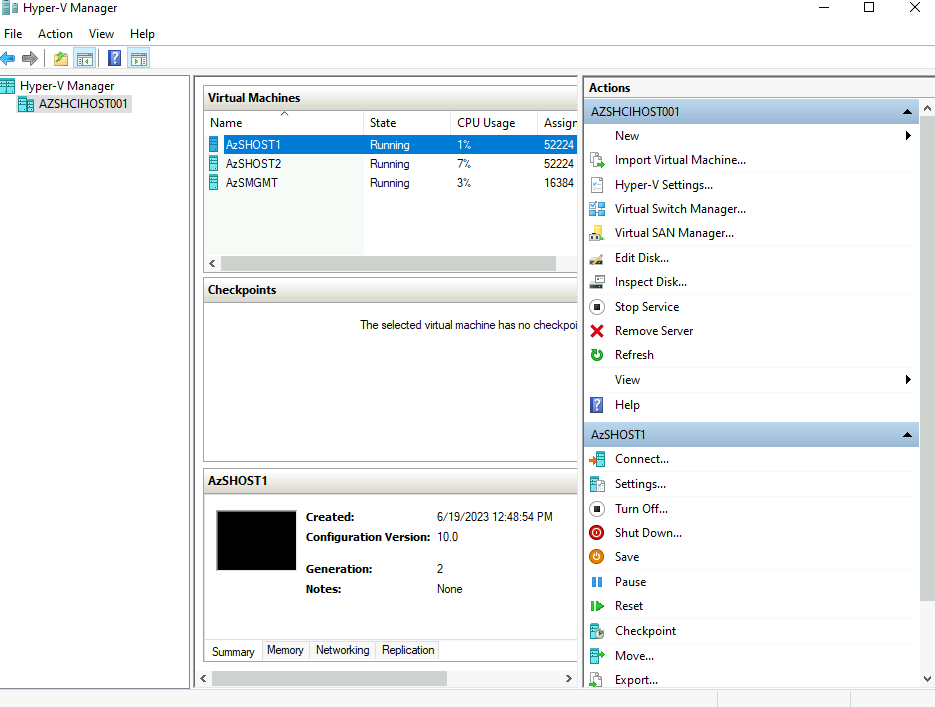

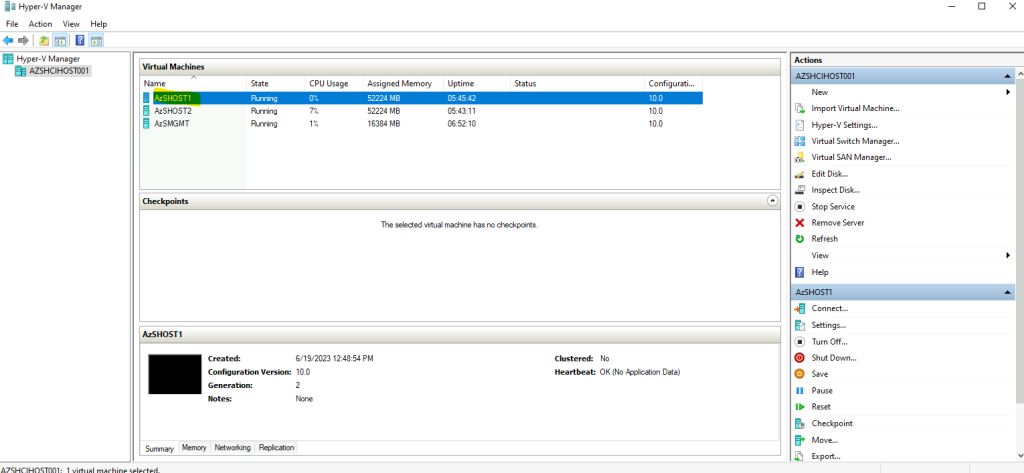

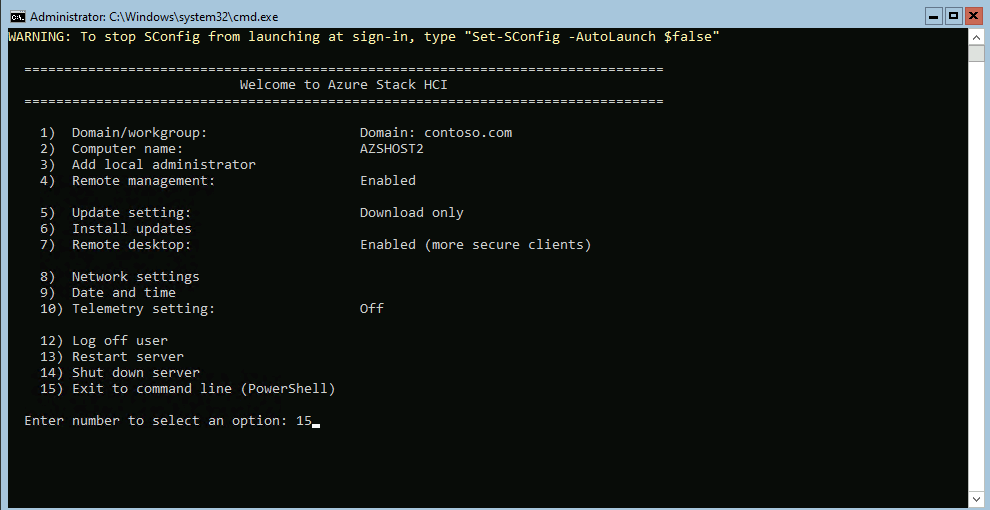

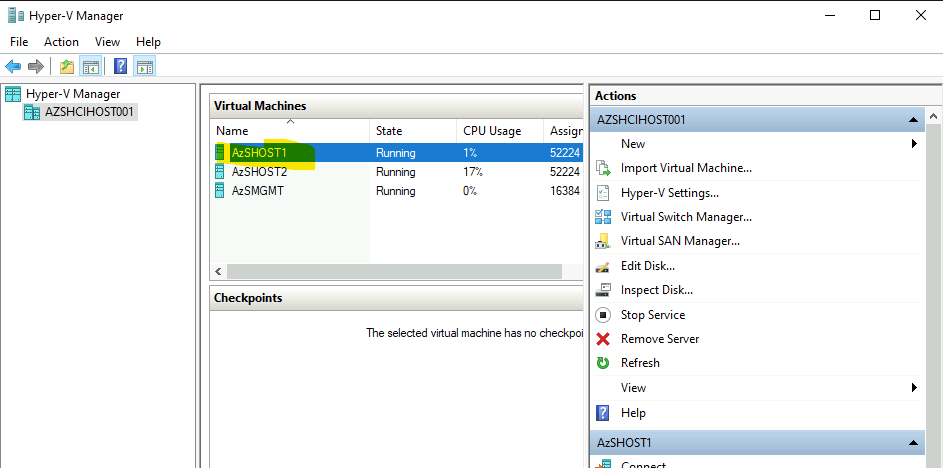

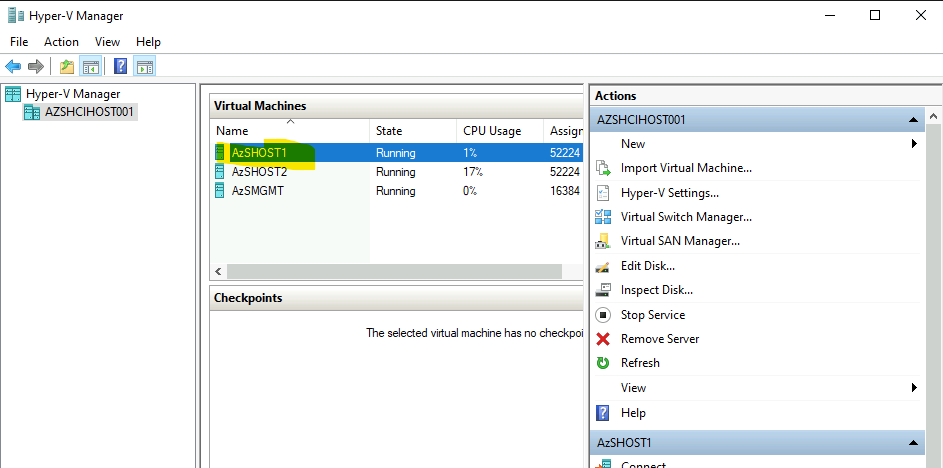

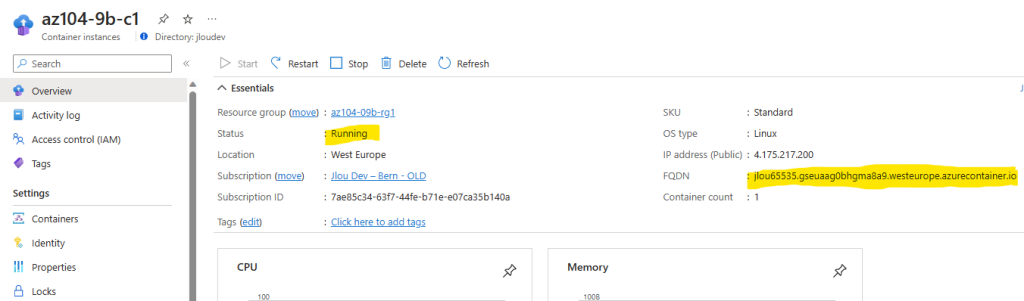

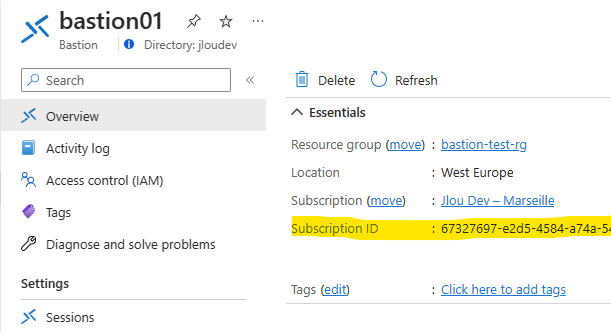

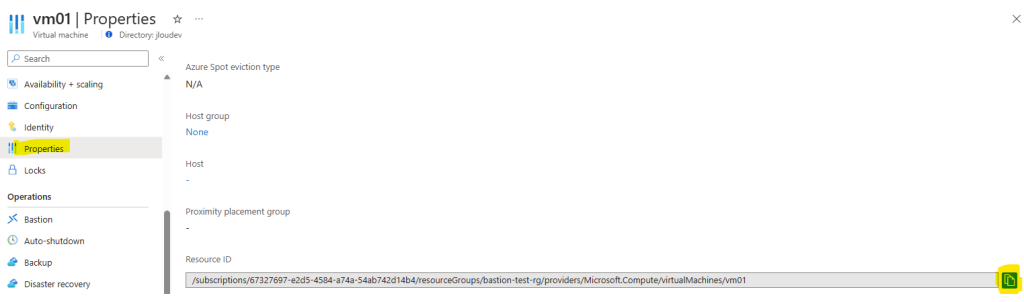

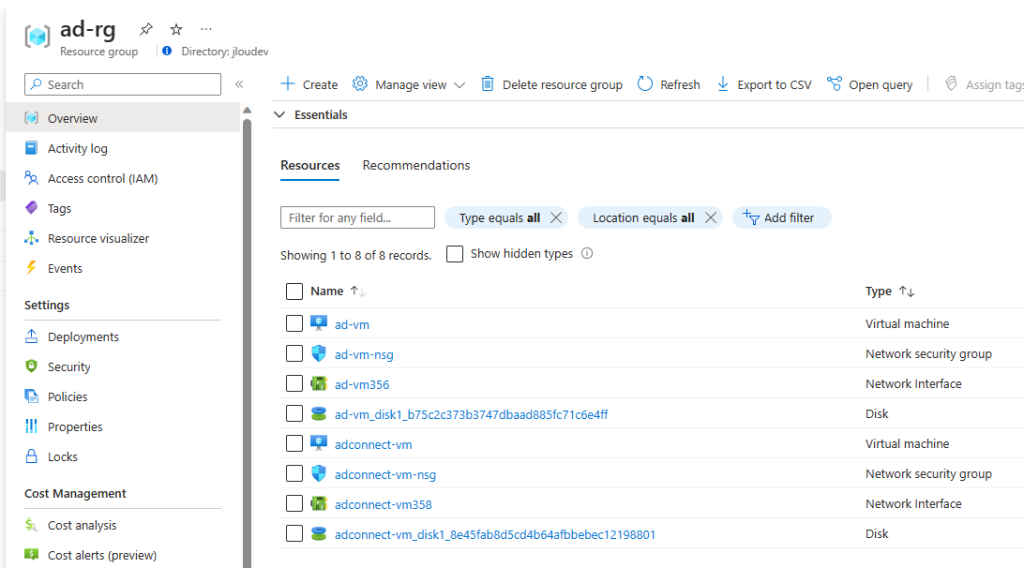

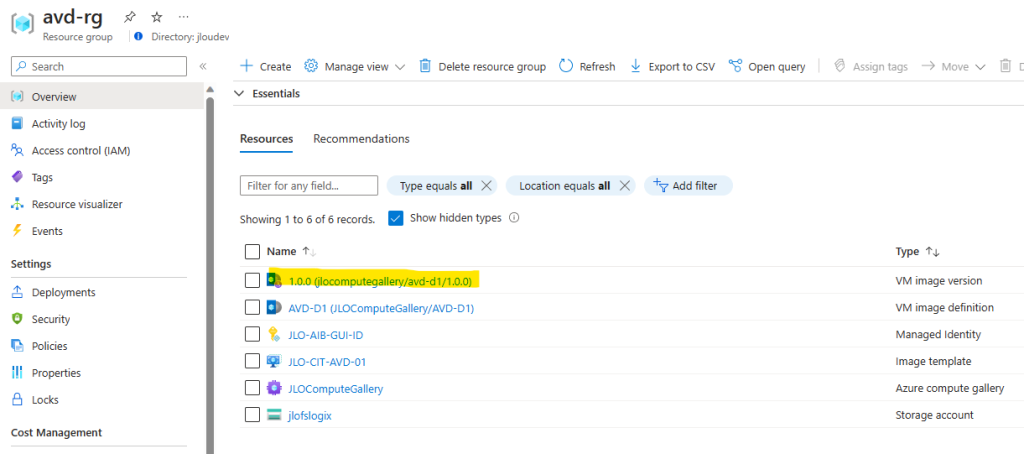

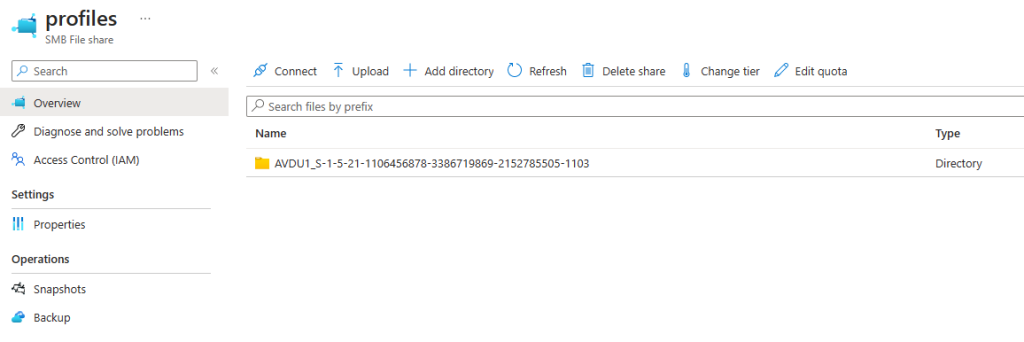

De mon côté, j’ai simulé mon environnement Active Directory on-premise sur Azure. Voici donc les ressources Azure déjà en place :

- Machine virtuelle en Windows Server 2012R2

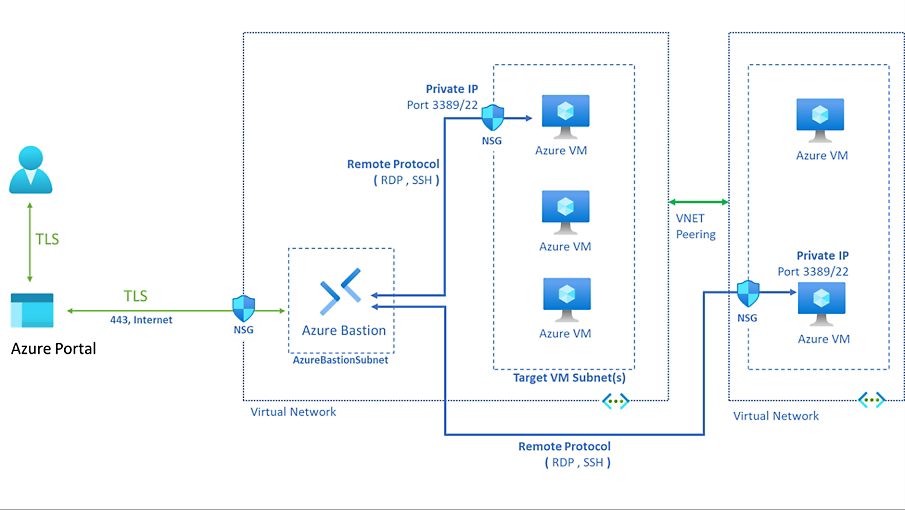

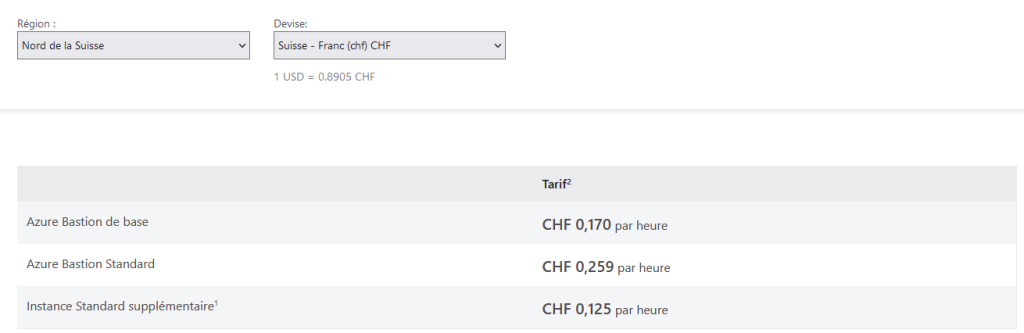

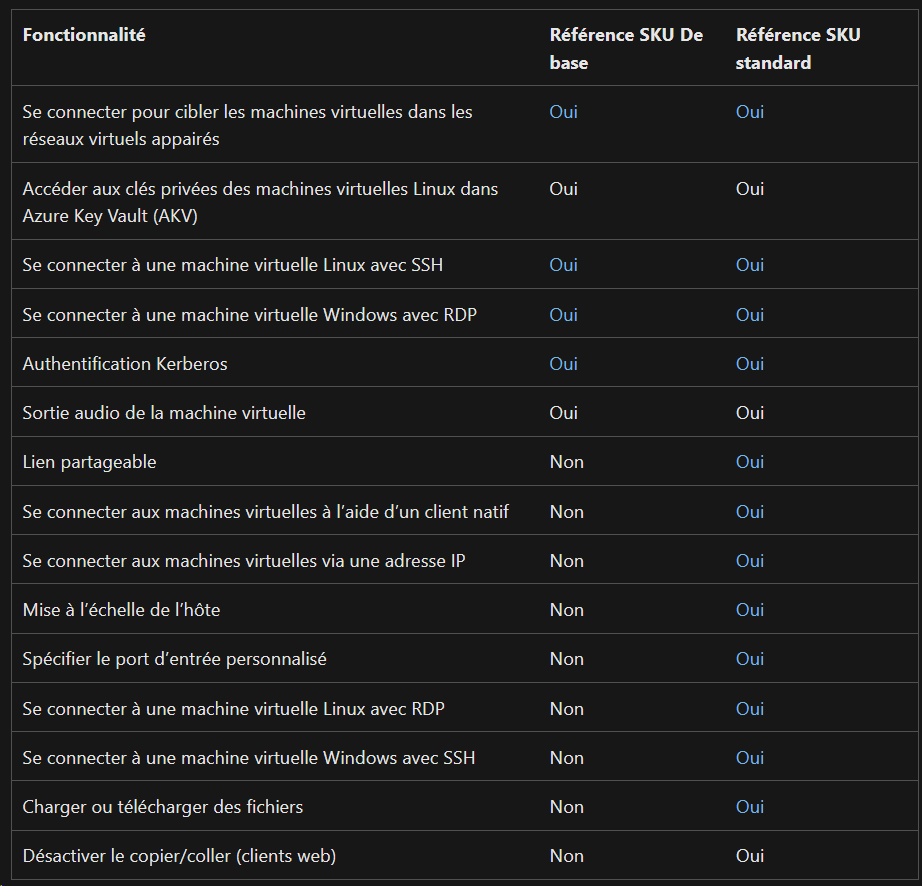

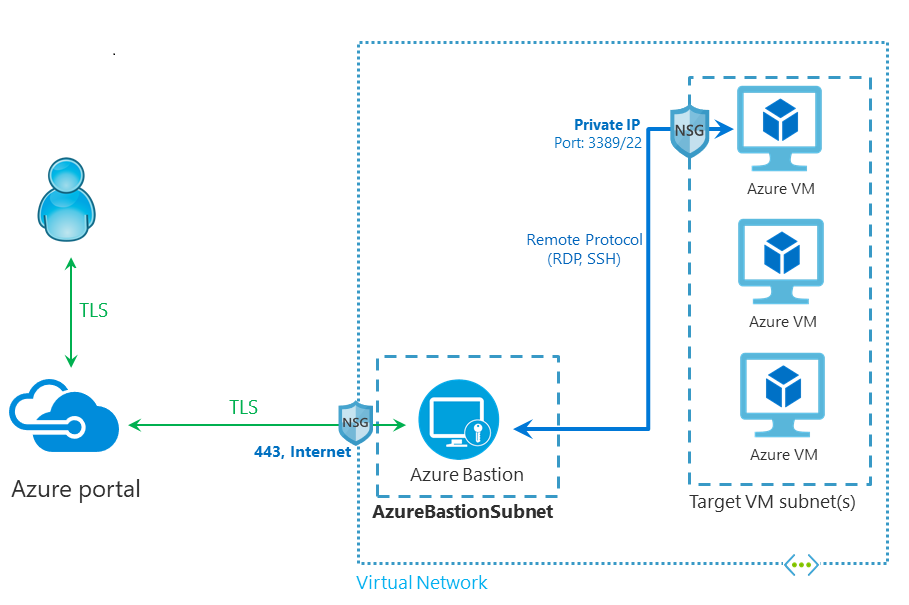

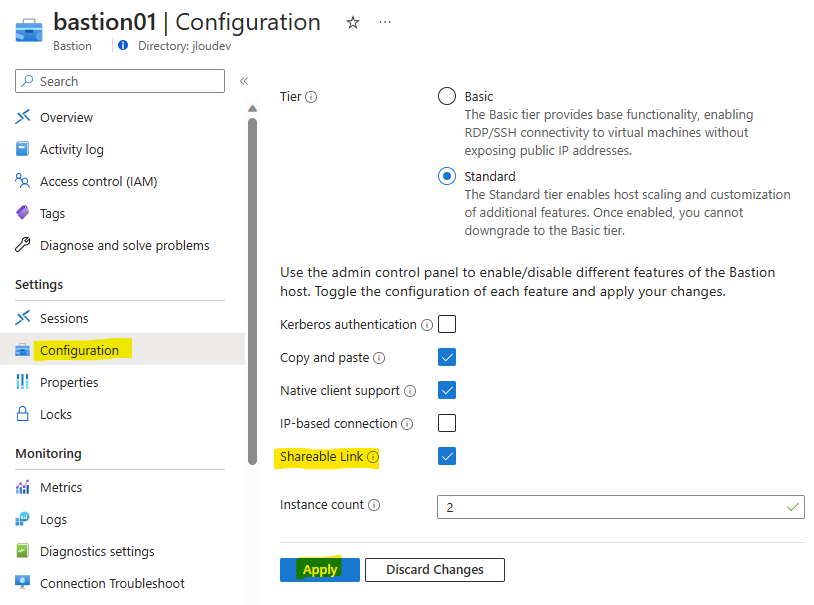

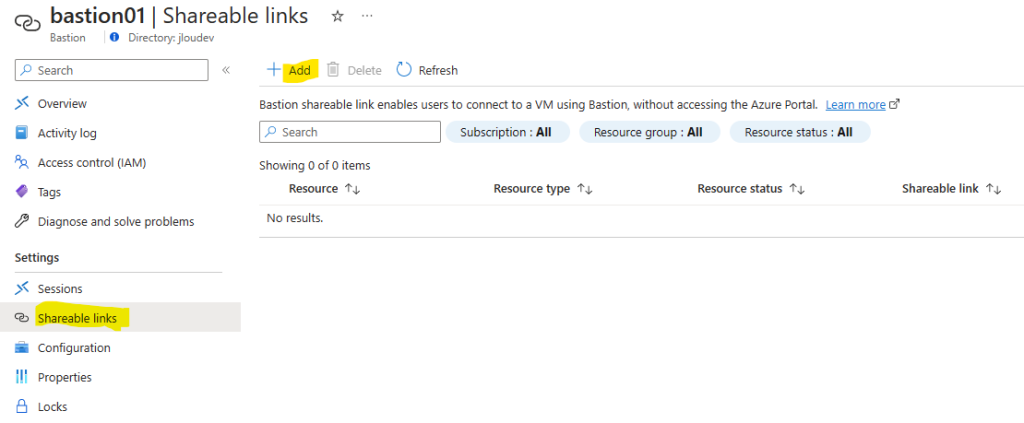

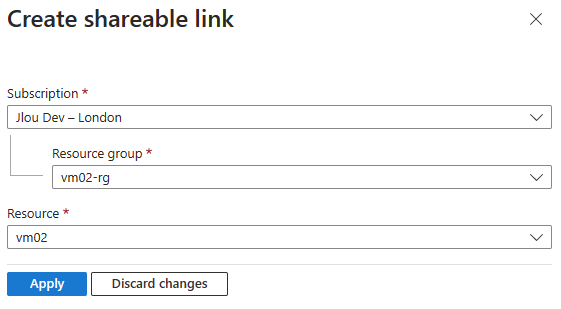

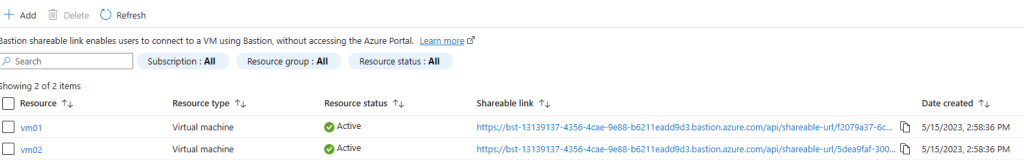

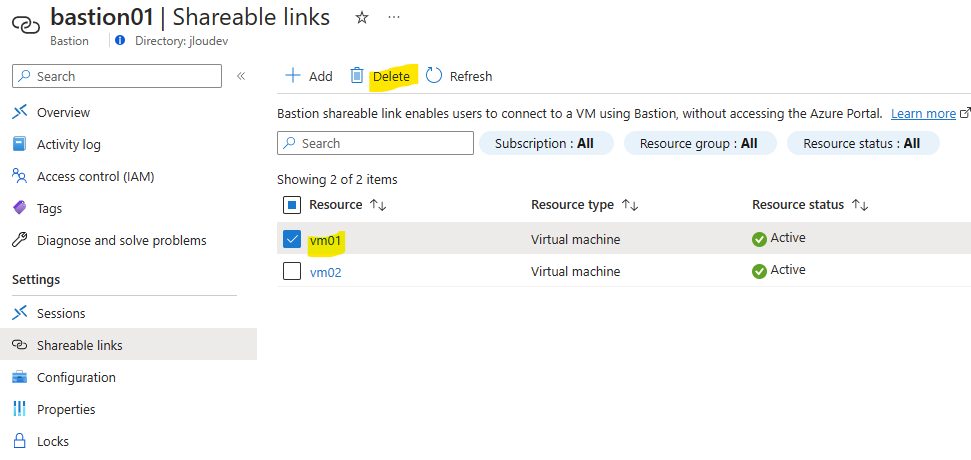

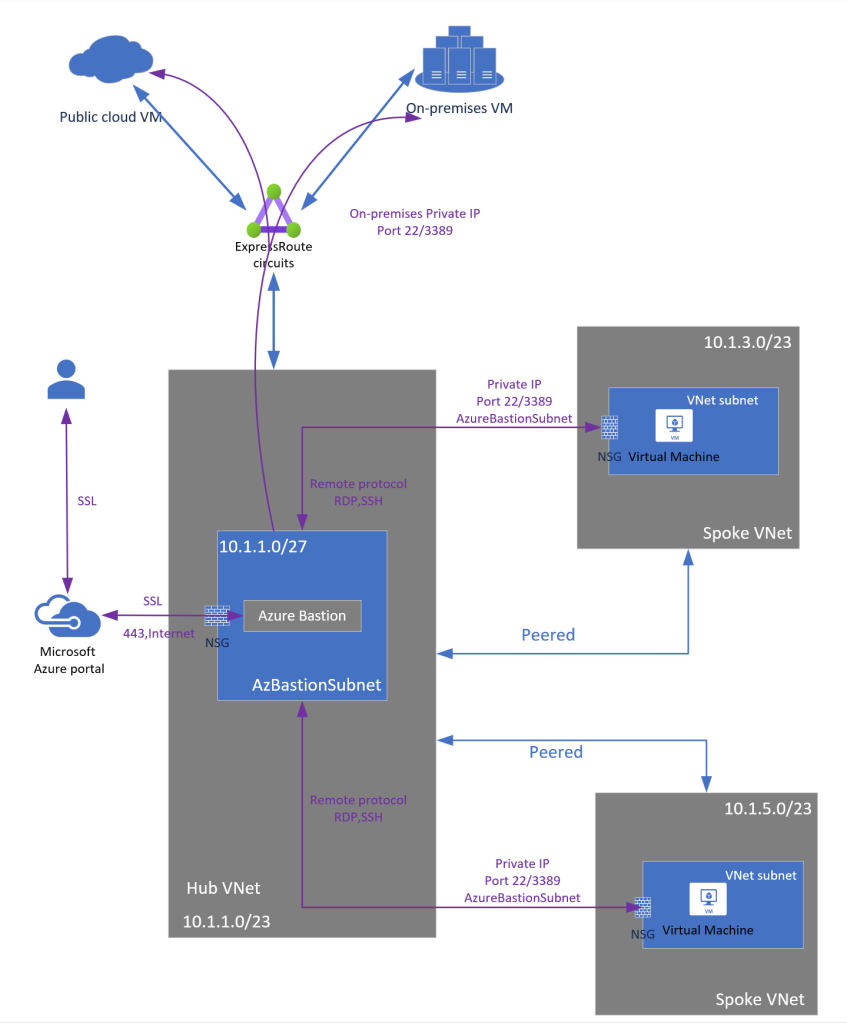

- Azure Bastion

- Azure VPN Site à Site

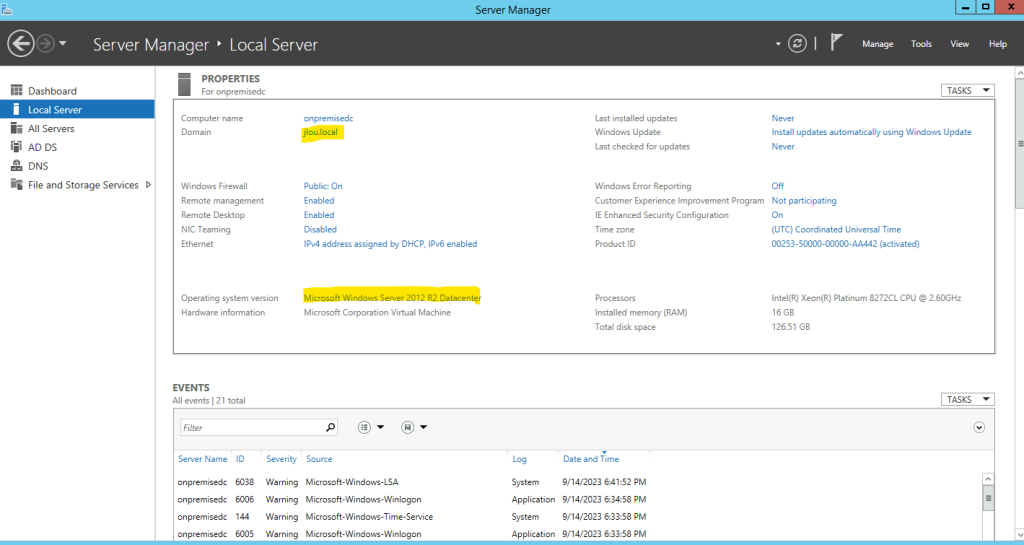

En me connectant à mon serveur AD (nous l’appellerons DC2012R2), nous y retrouvons mon domaine on-premise, ainsi que la version de l’OS : Windows Server 2012R2.

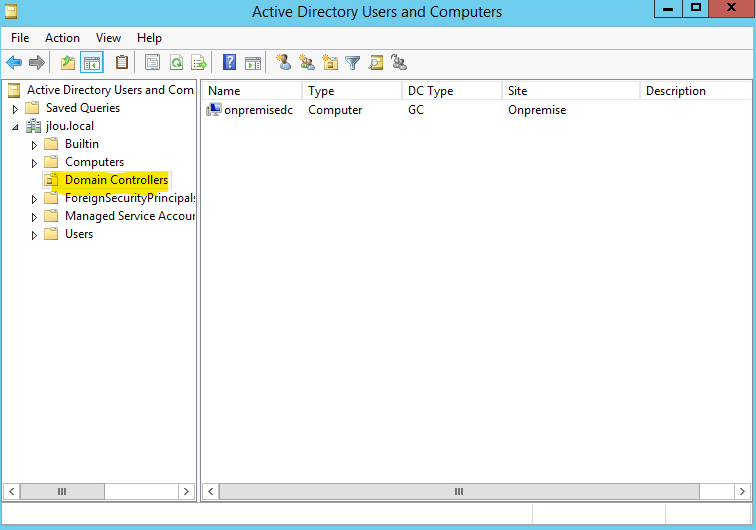

Actuellement, mon environnement de test ne comporte qu’un seul serveur en tant que contrôleur de domaine AD :

Nous allons donc maintenant déployer un nouvel environnement sur Azure afin de simuler la transition AD vers le Cloud de Microsoft.

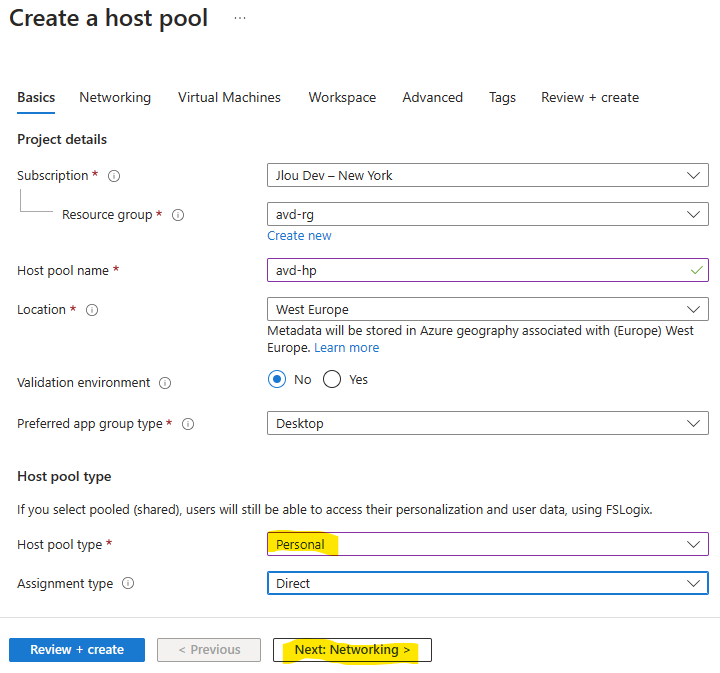

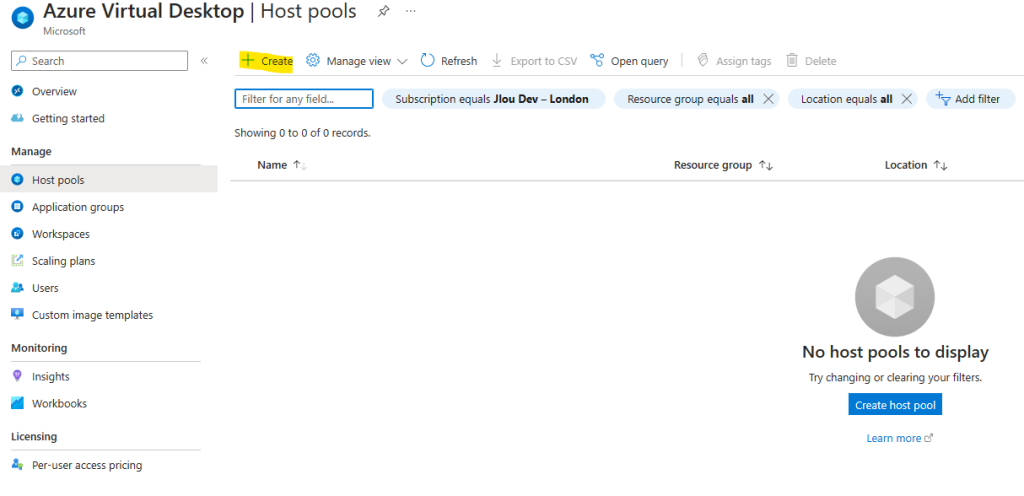

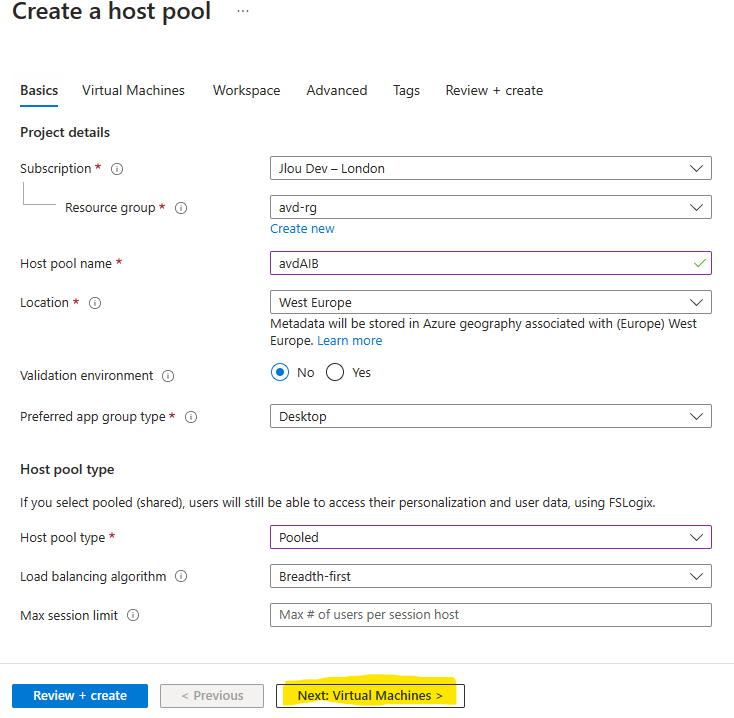

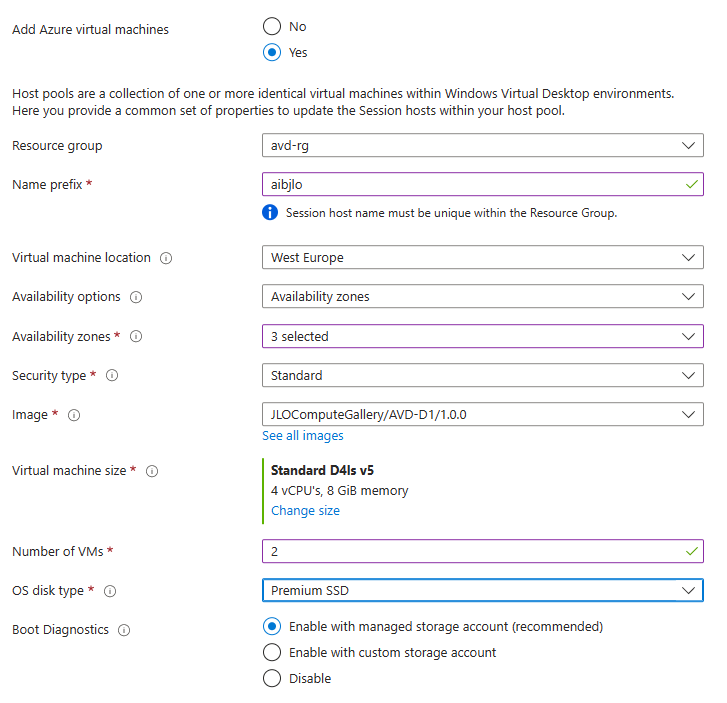

Etape I – Déploiement des ressources Azure :

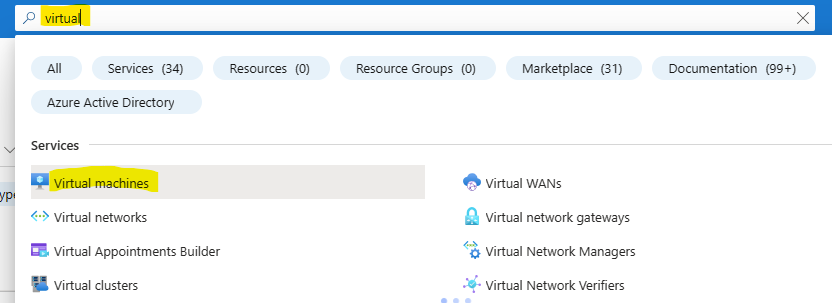

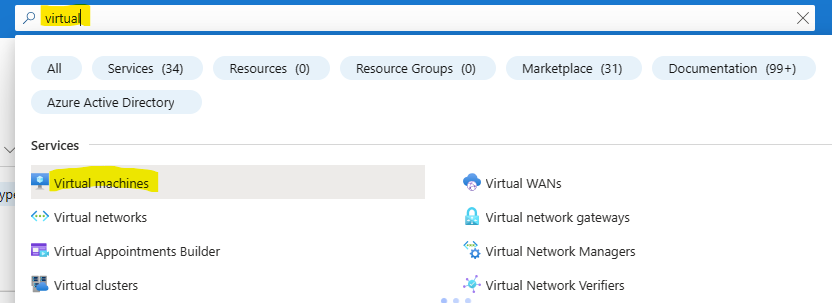

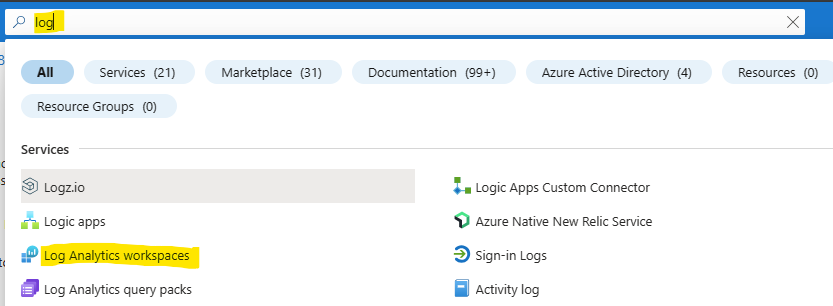

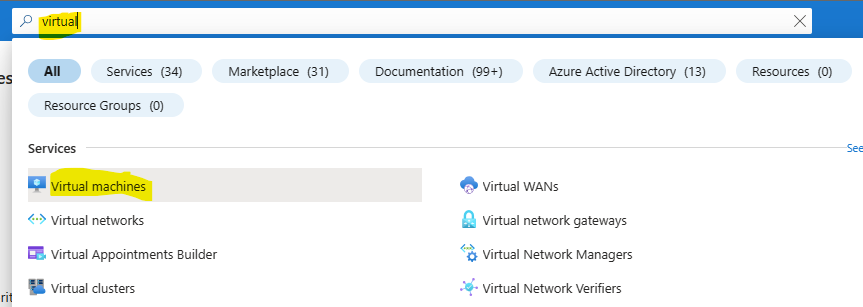

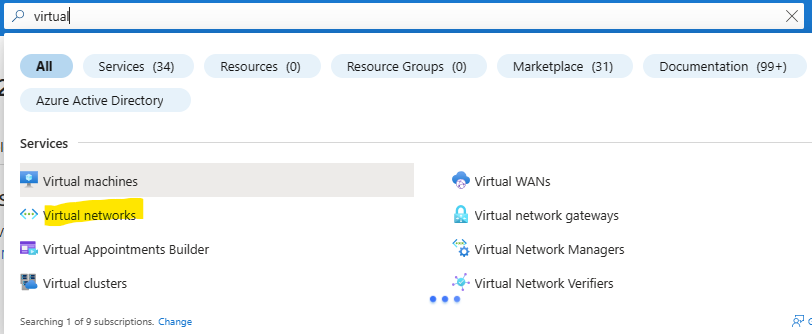

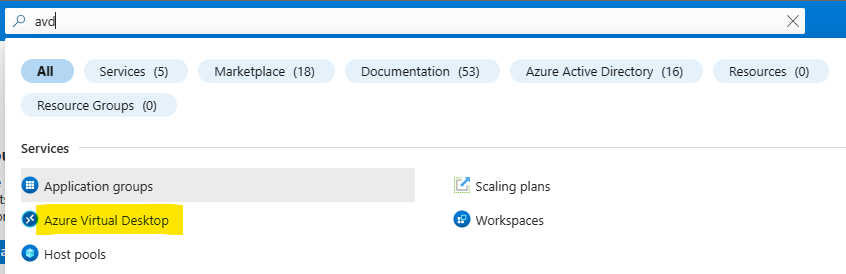

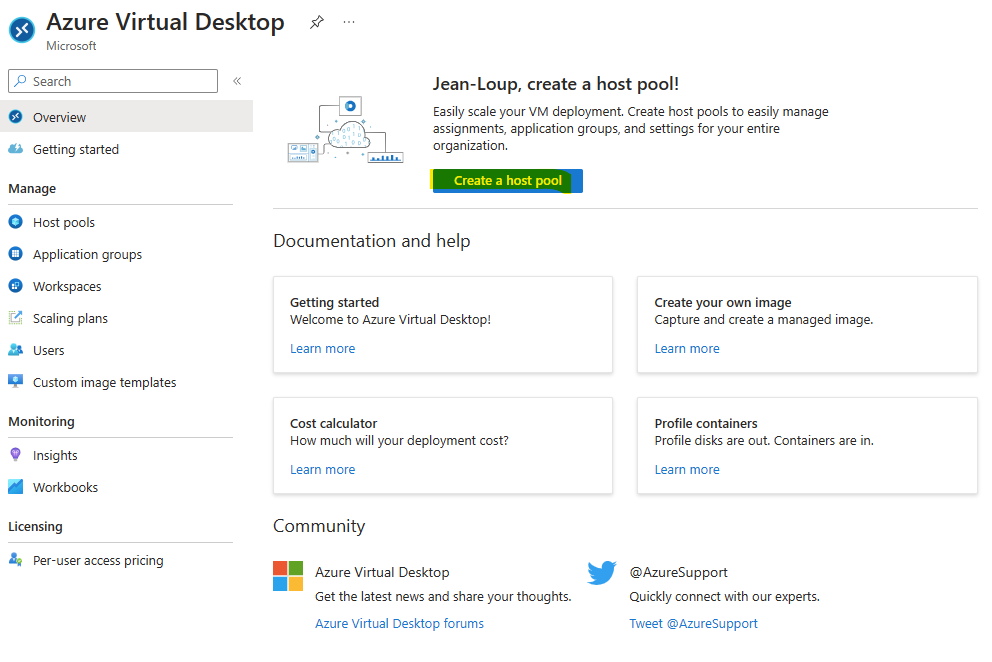

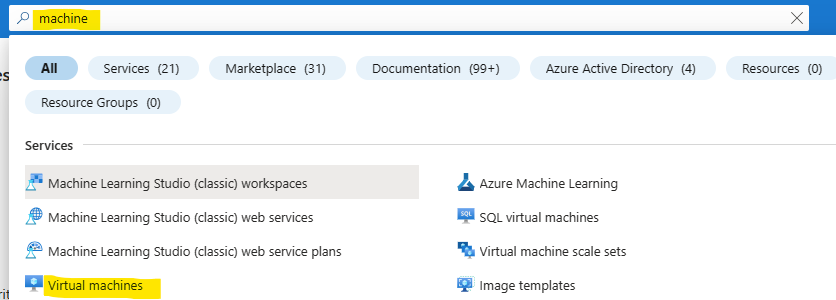

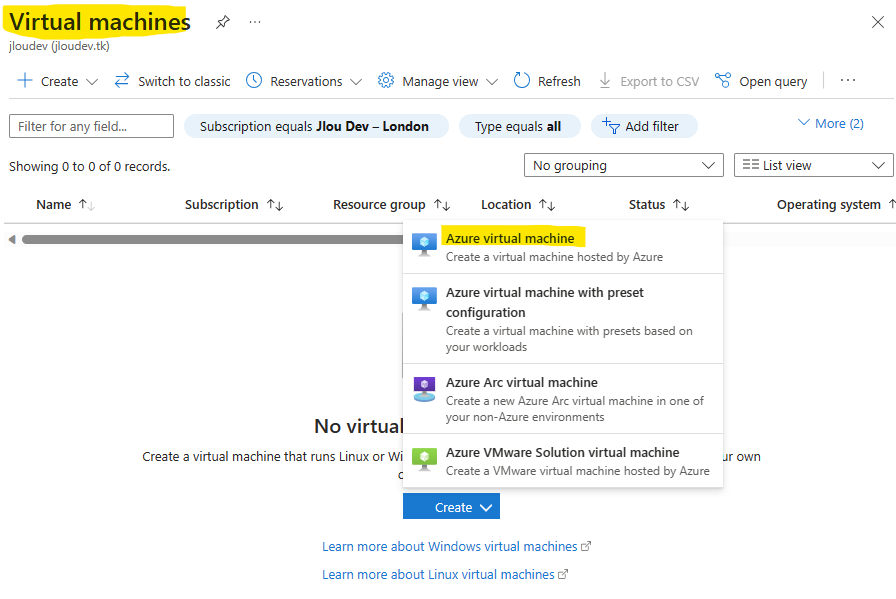

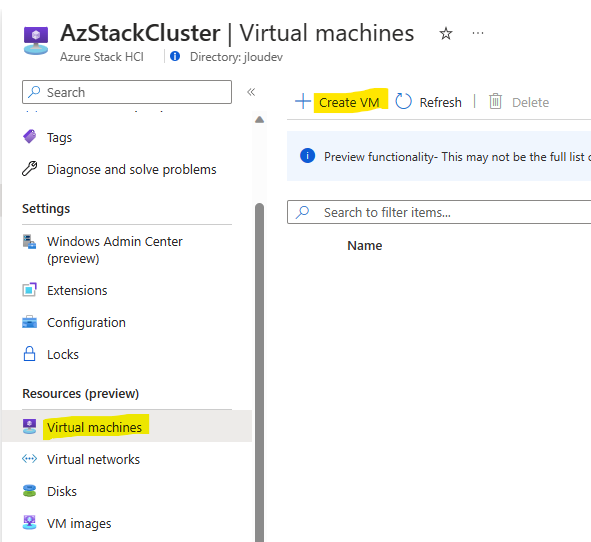

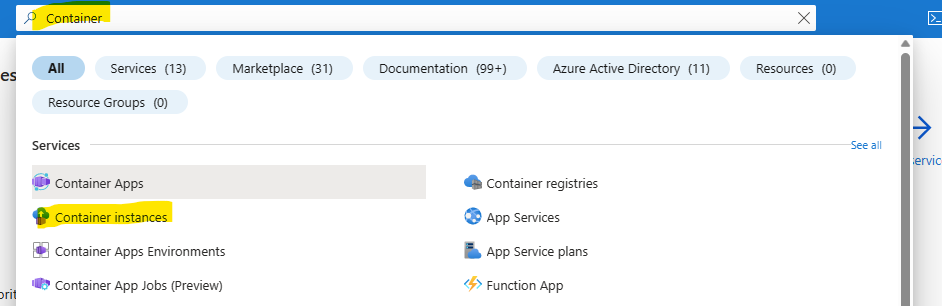

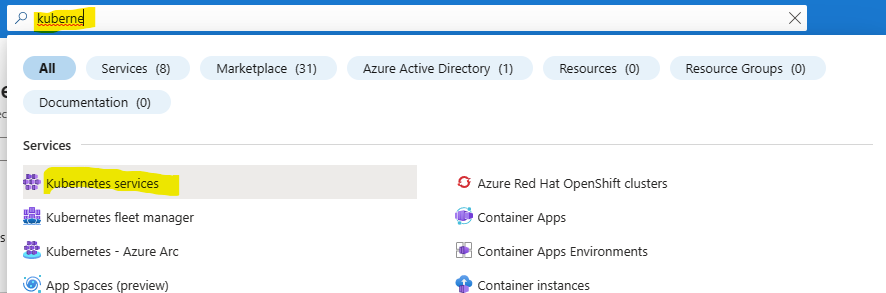

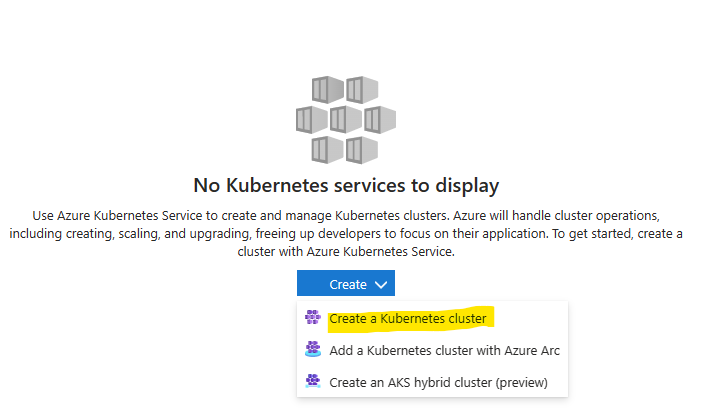

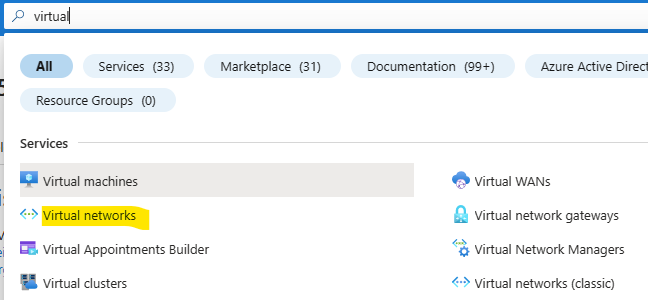

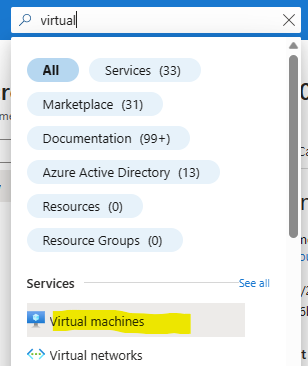

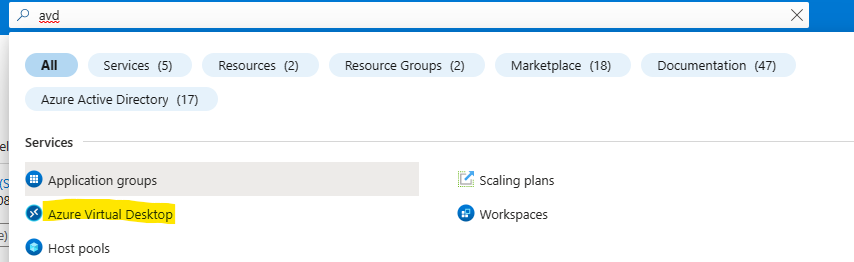

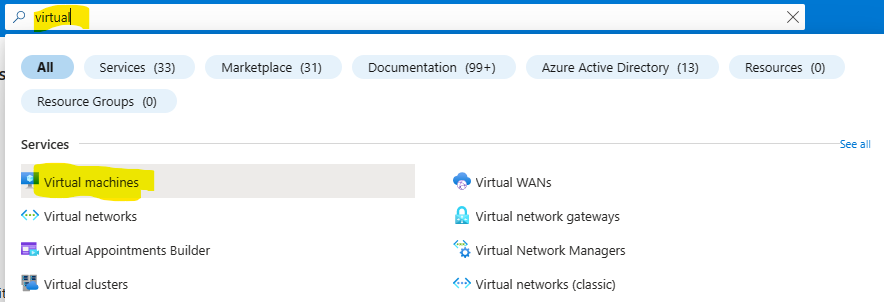

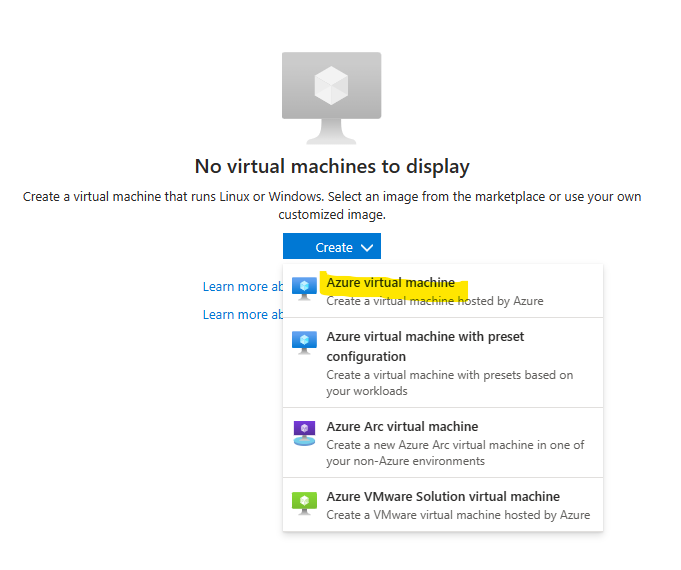

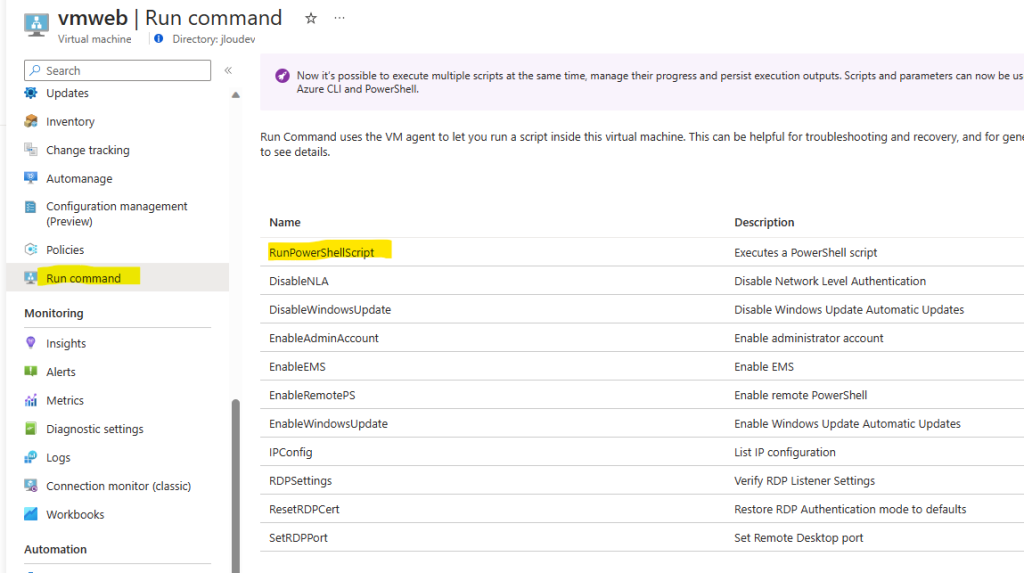

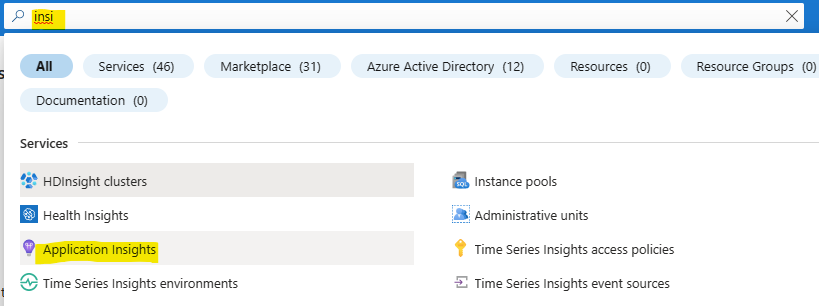

Pour cela, commencez par déployer une machine virtuelle sur Azure. Rendez-vous sur le portail d’Azure et utilisez la barre de recherche :

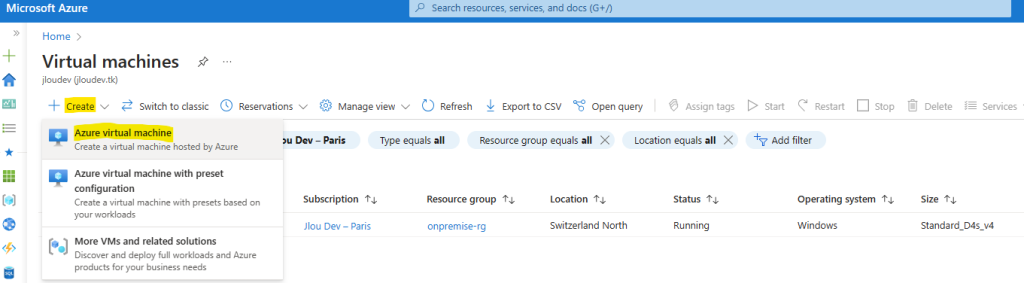

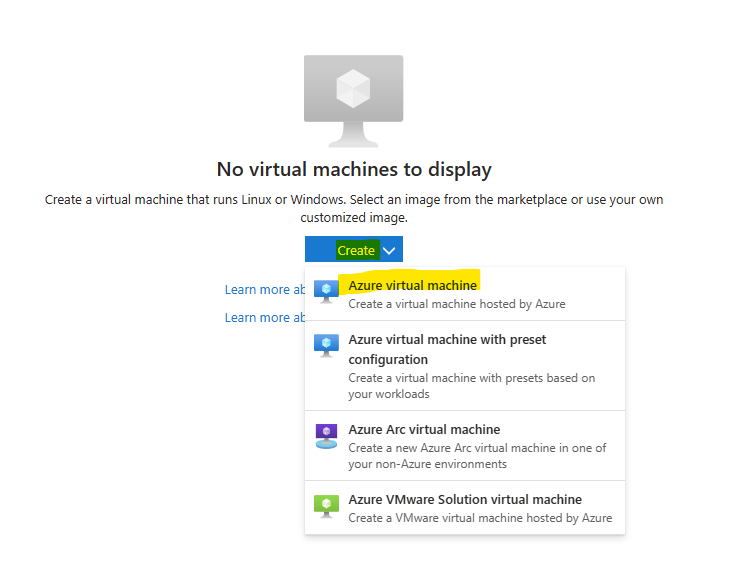

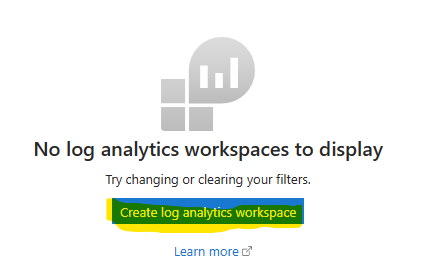

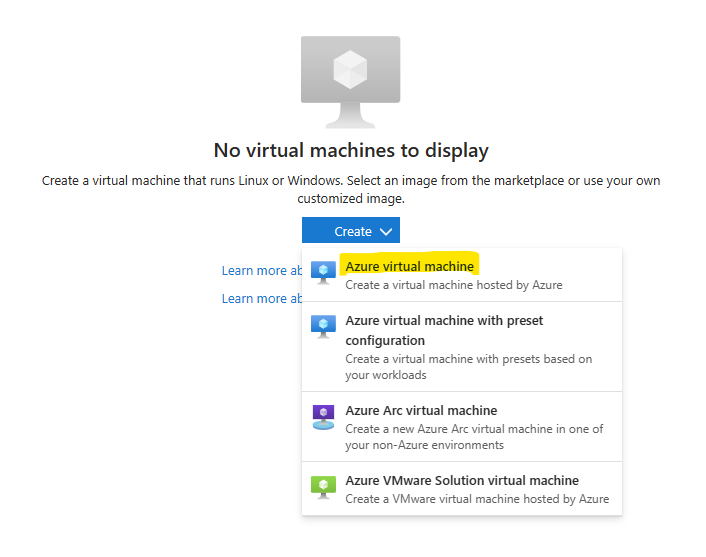

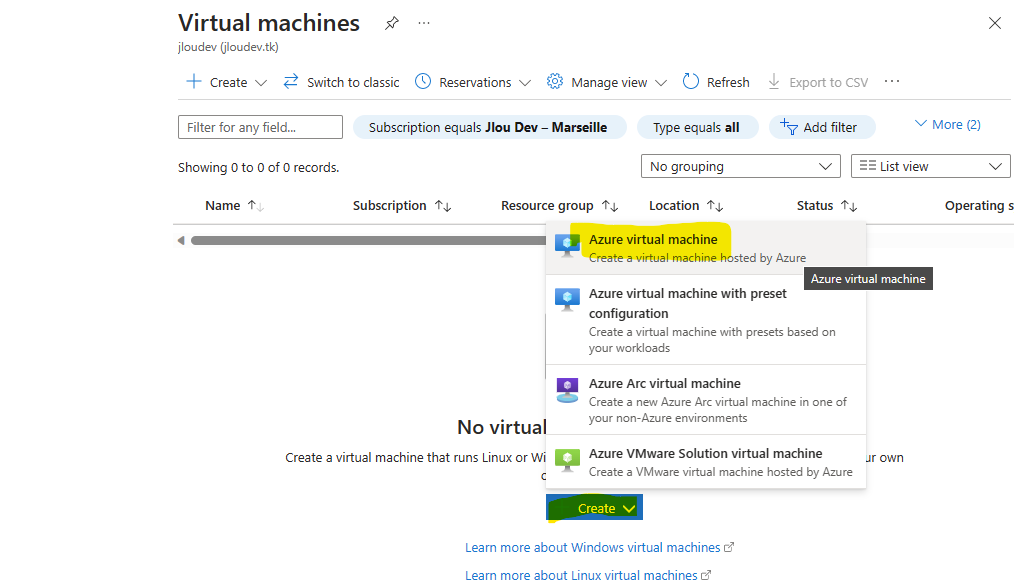

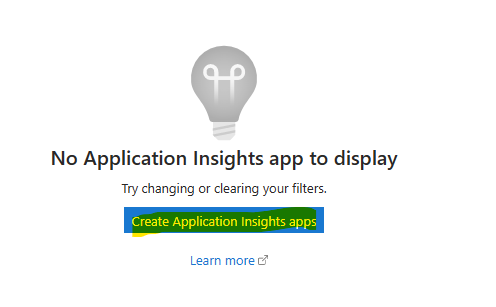

Cliquez-ici pour créer votre première machine virtuelle Azure :

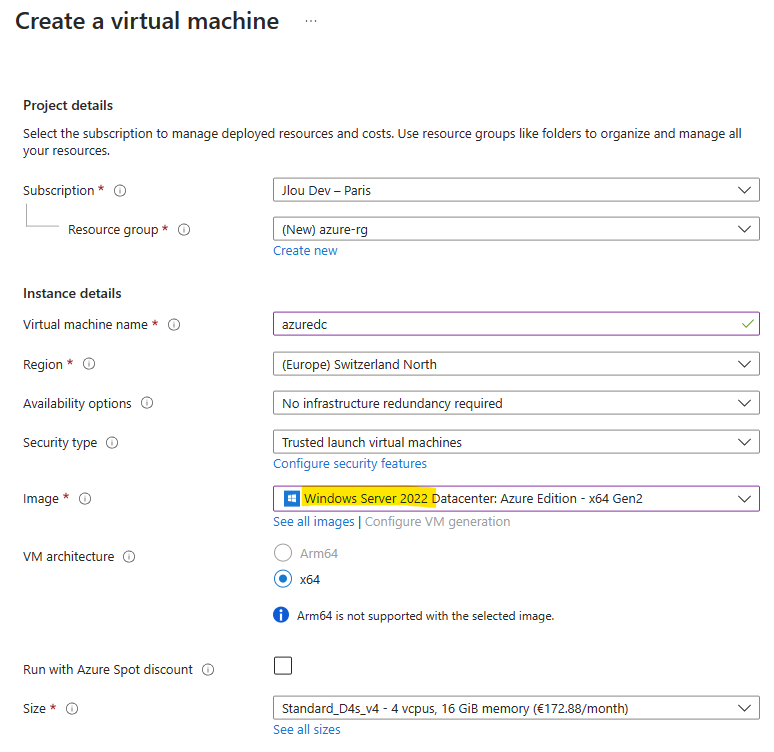

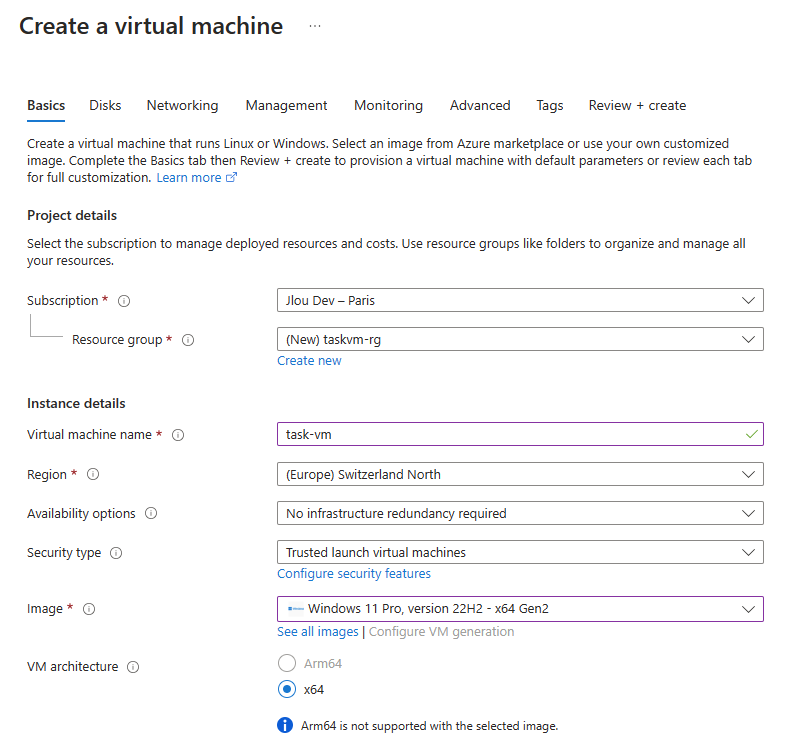

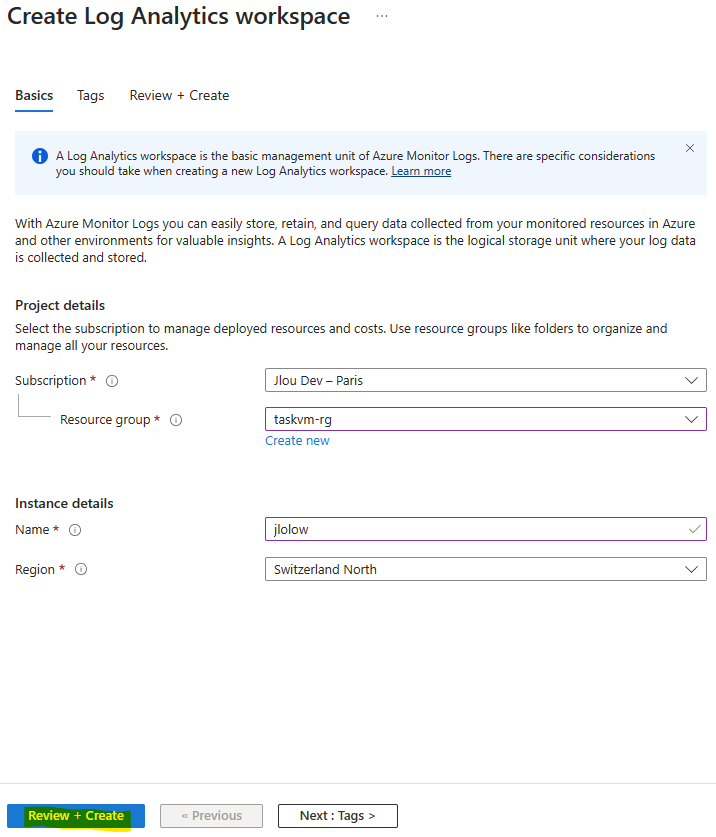

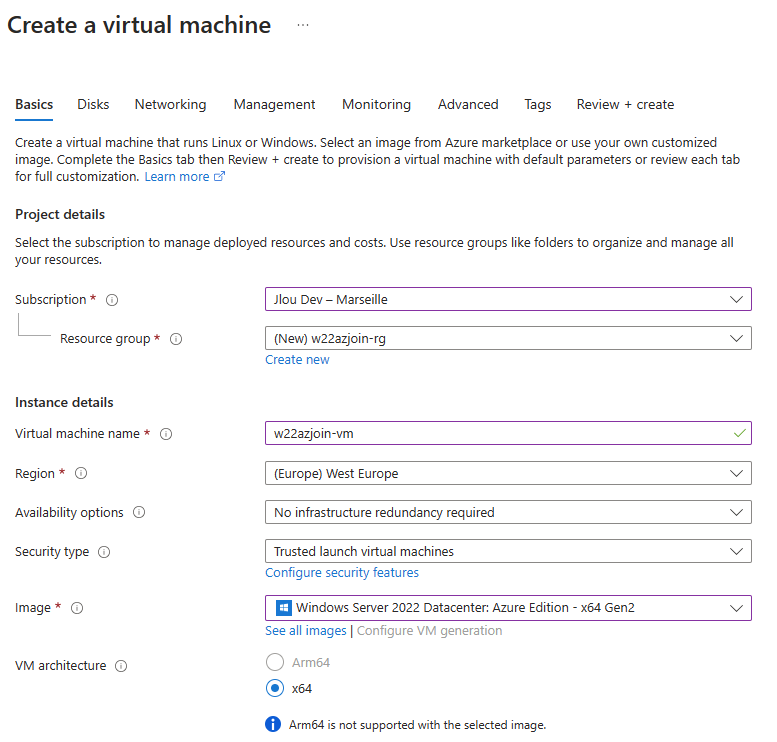

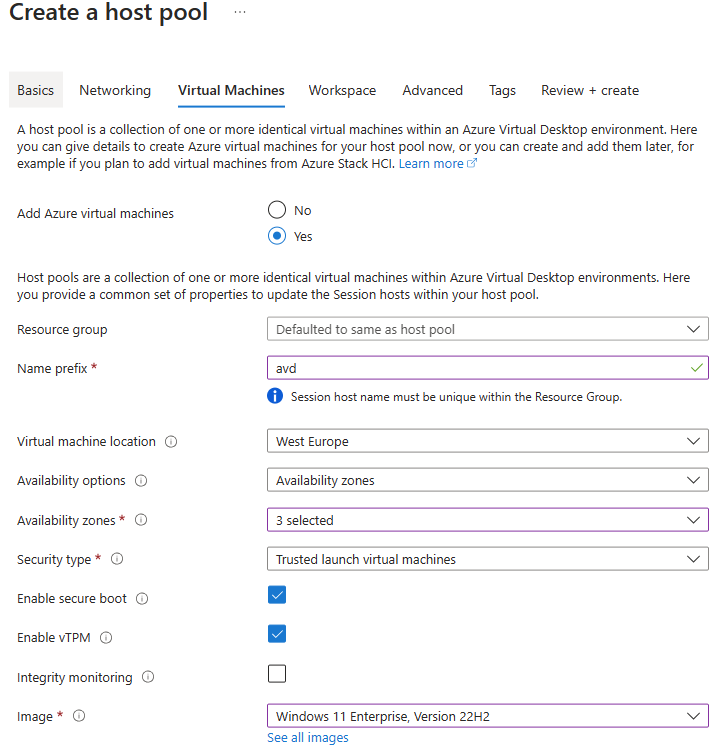

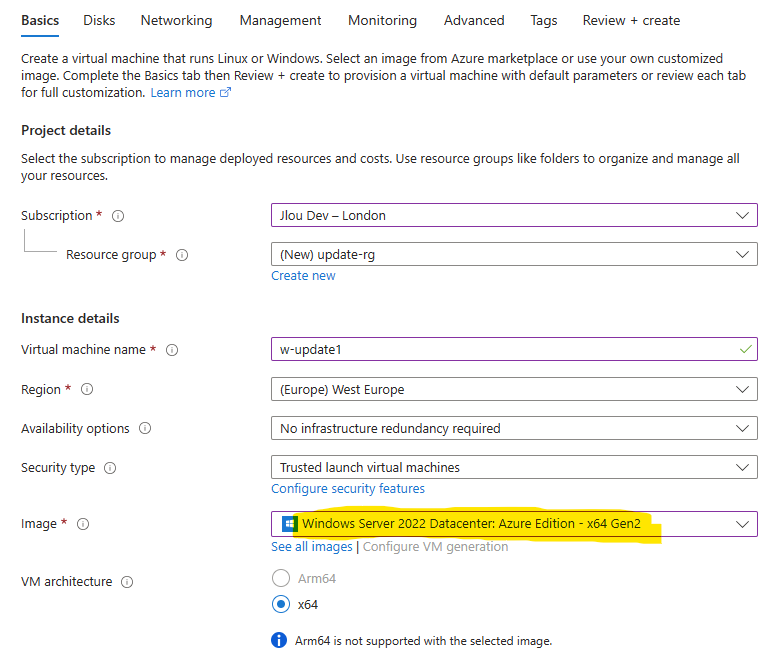

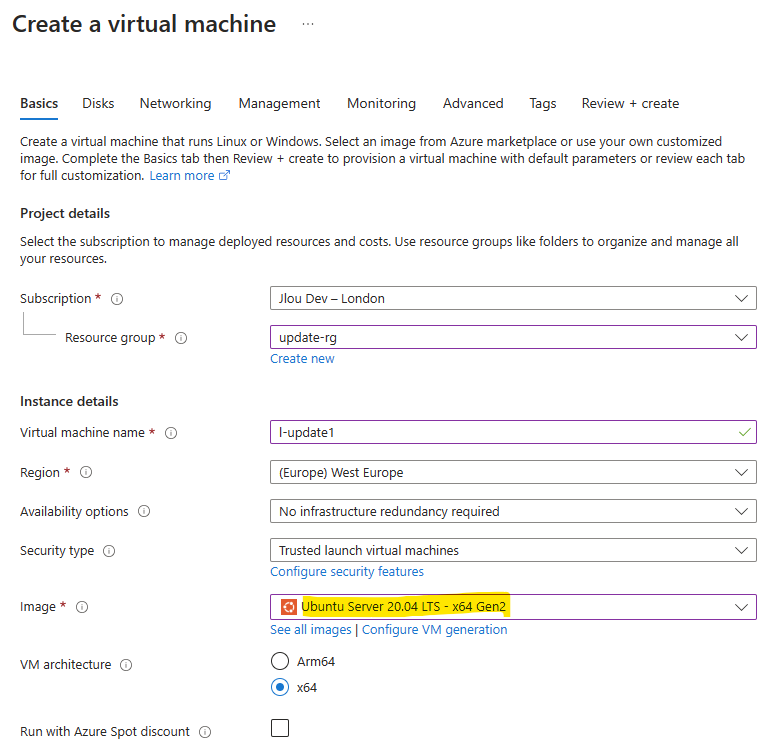

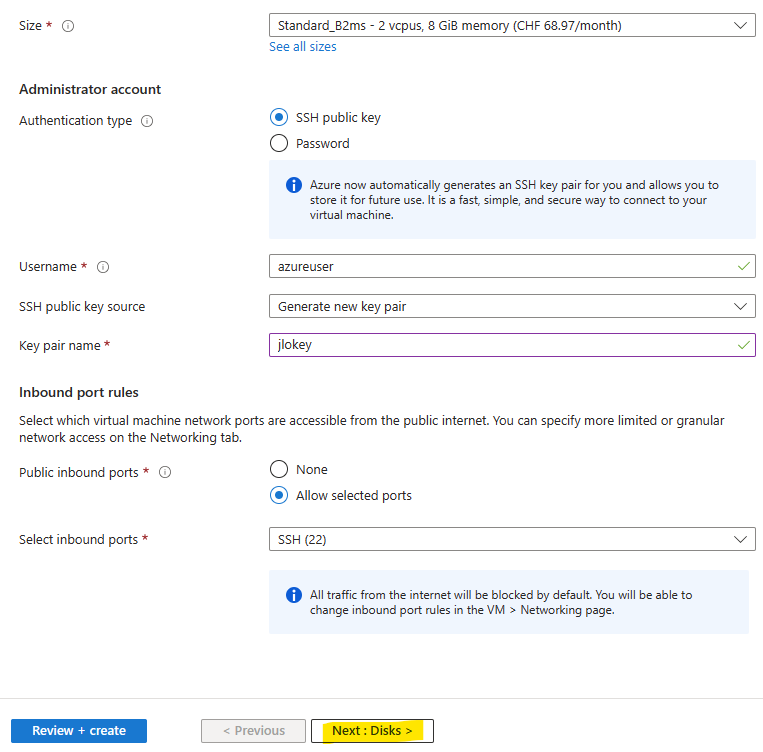

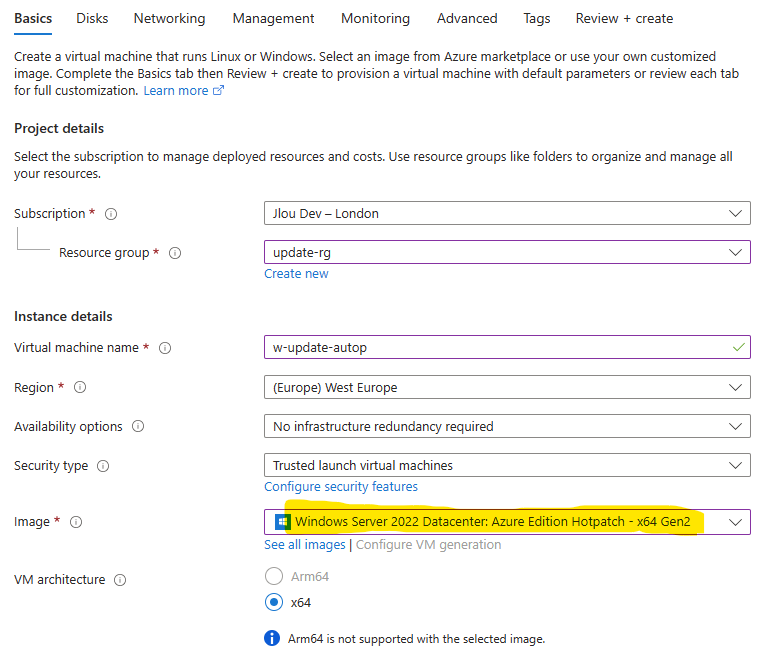

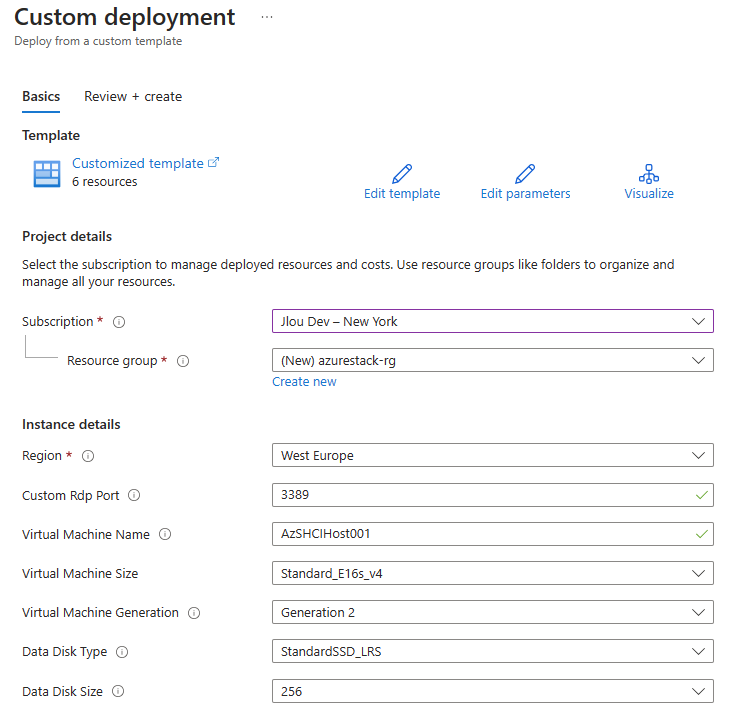

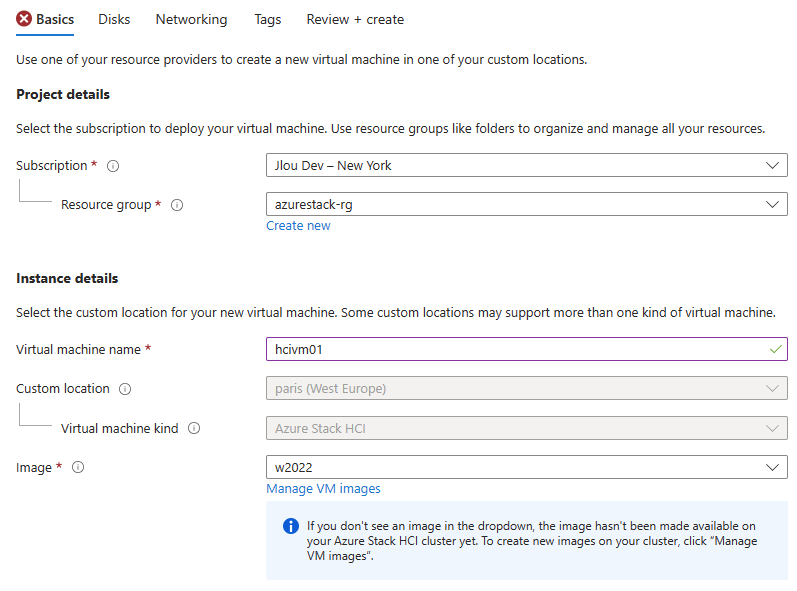

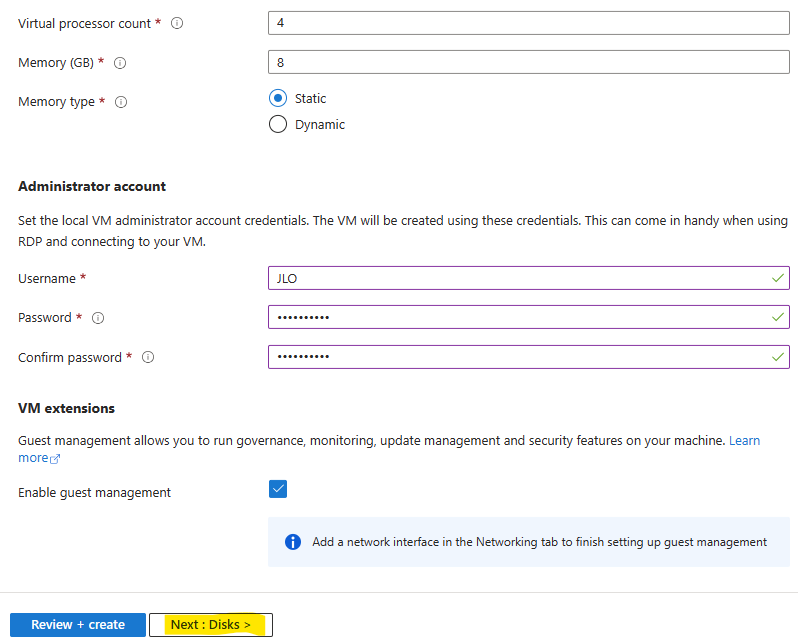

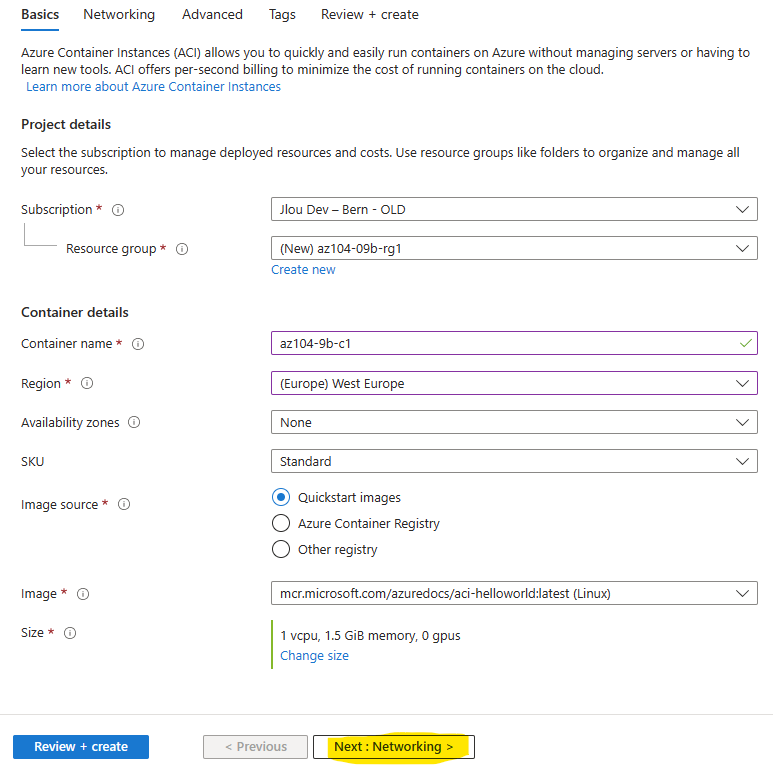

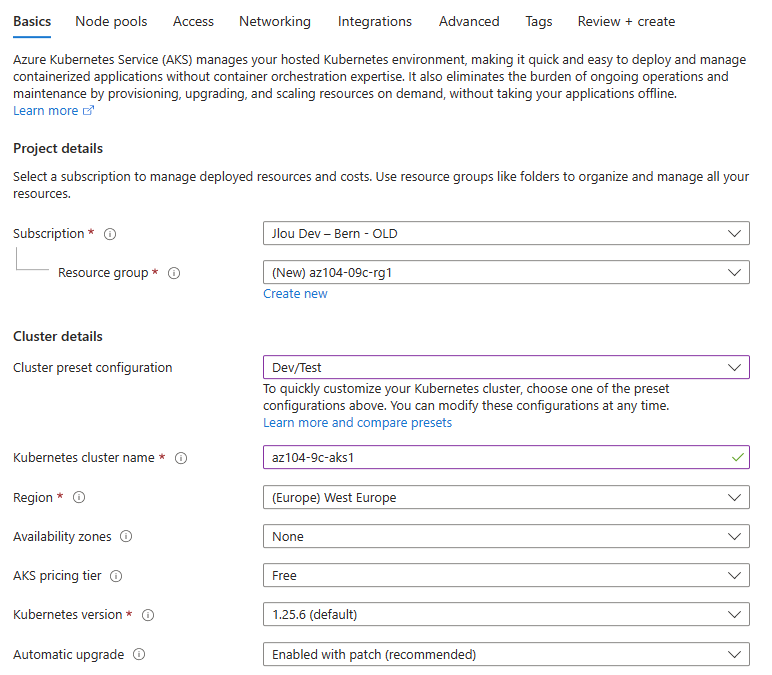

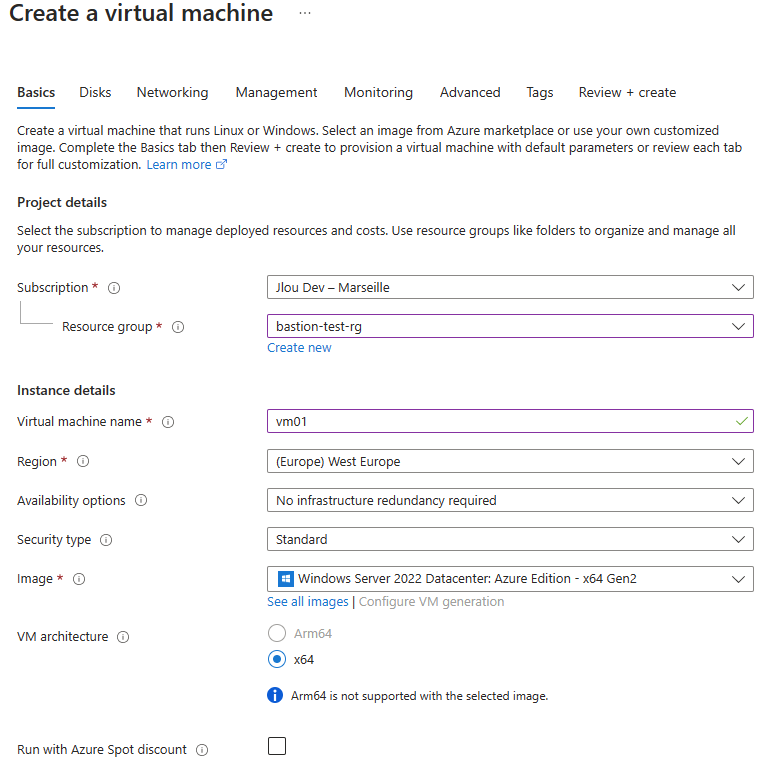

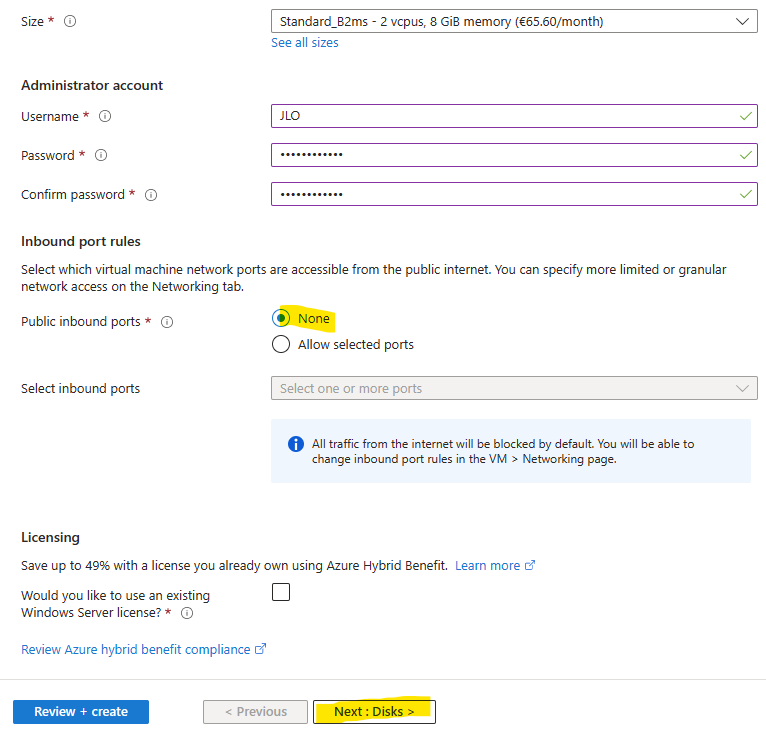

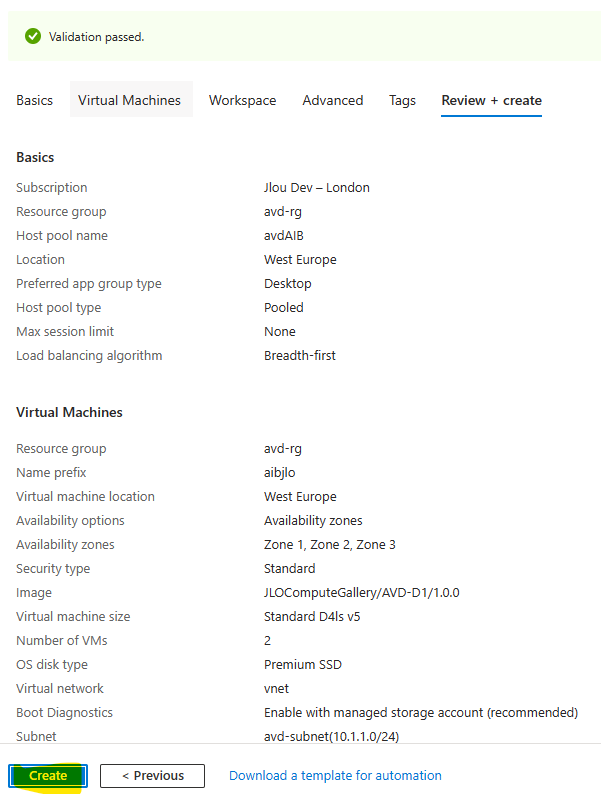

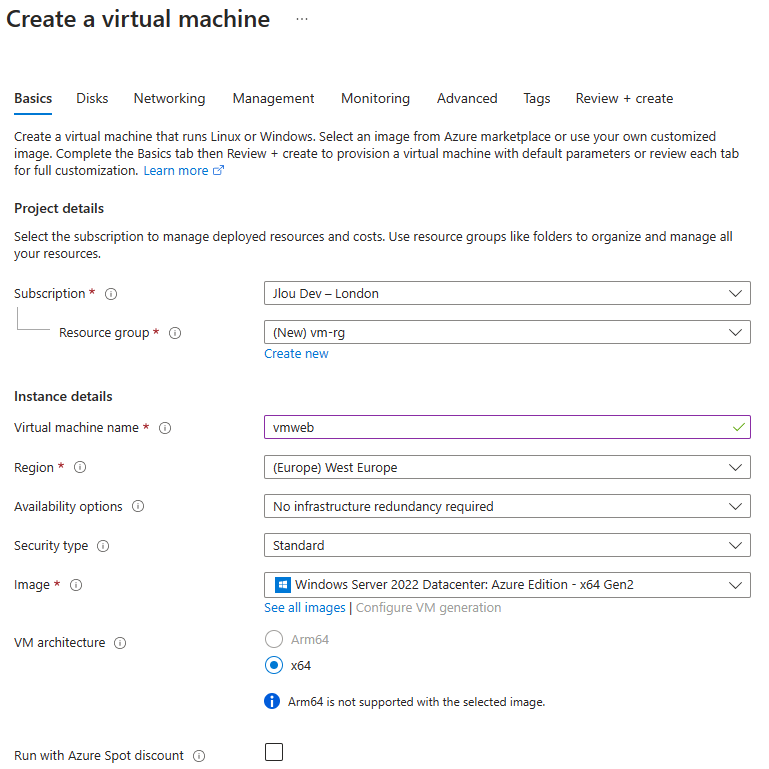

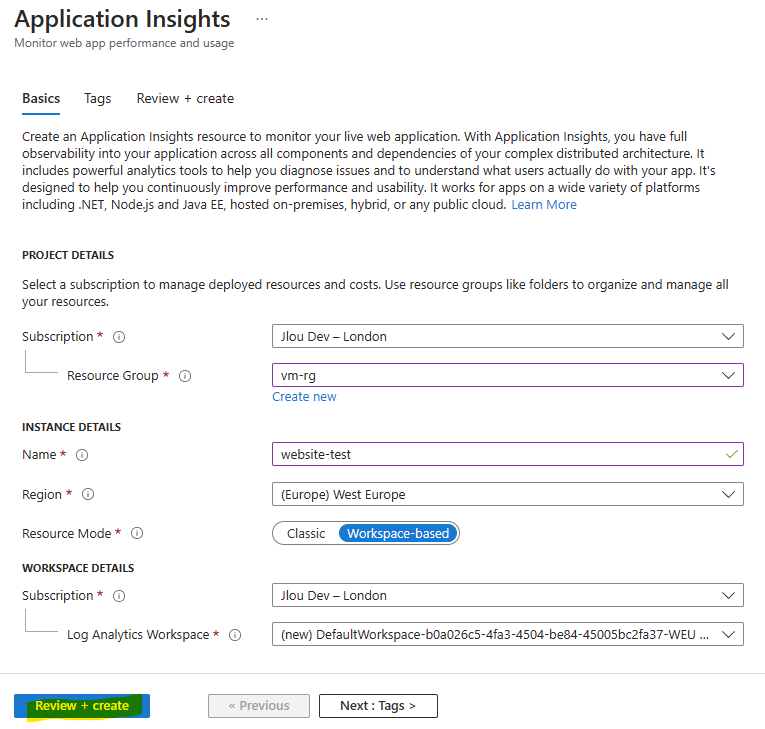

Renseignez les informations de base relatives à votre VM :

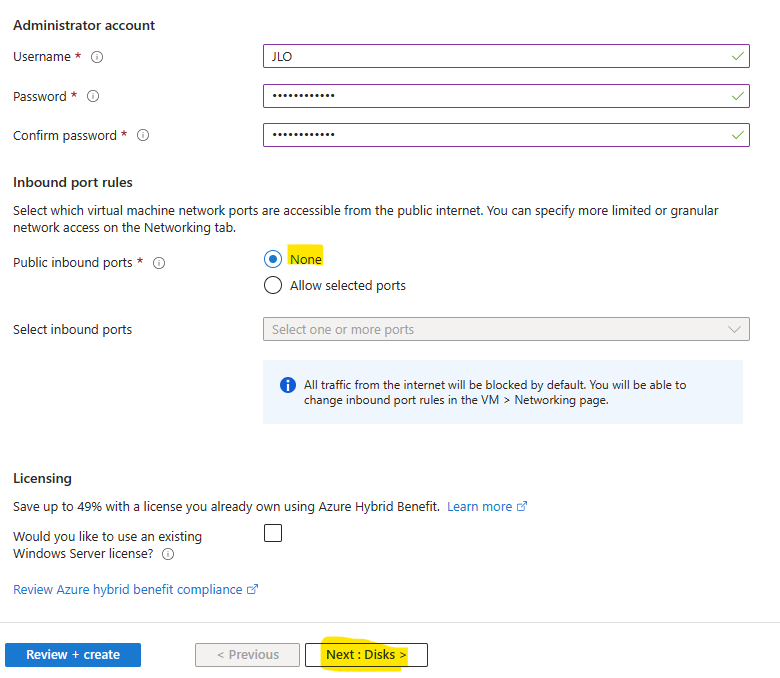

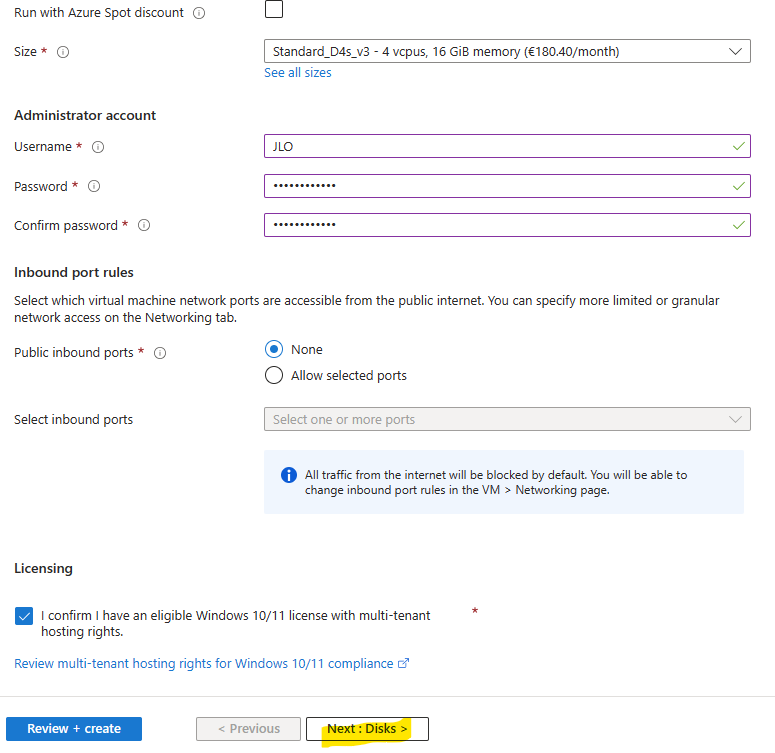

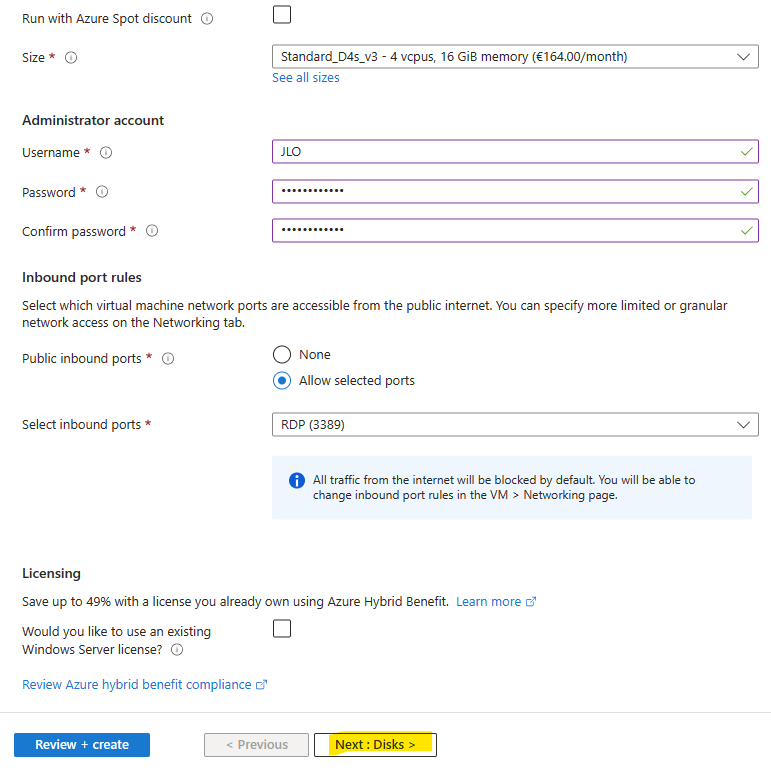

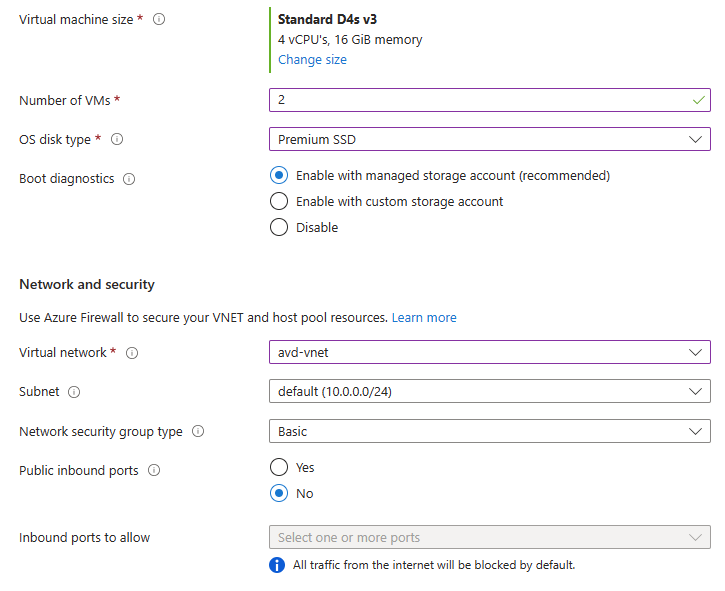

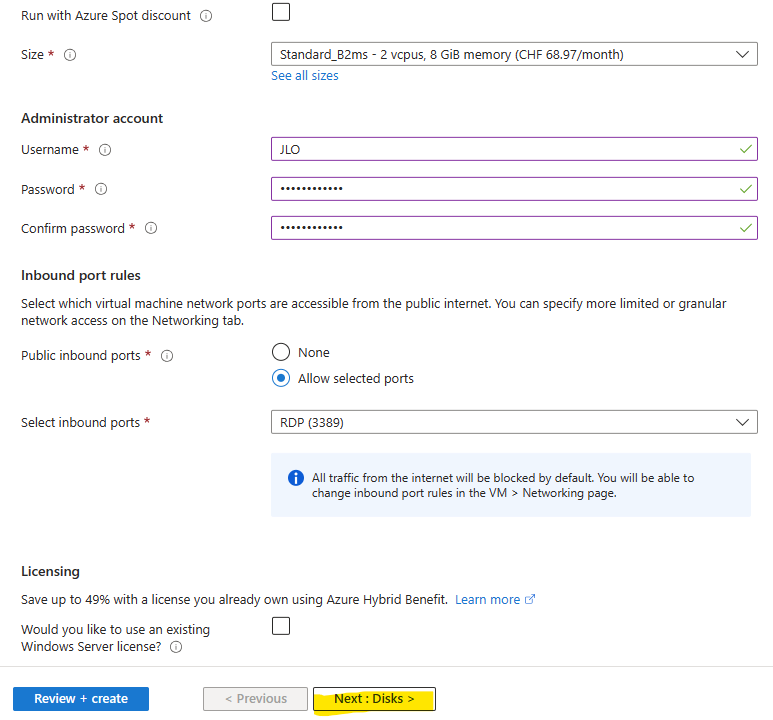

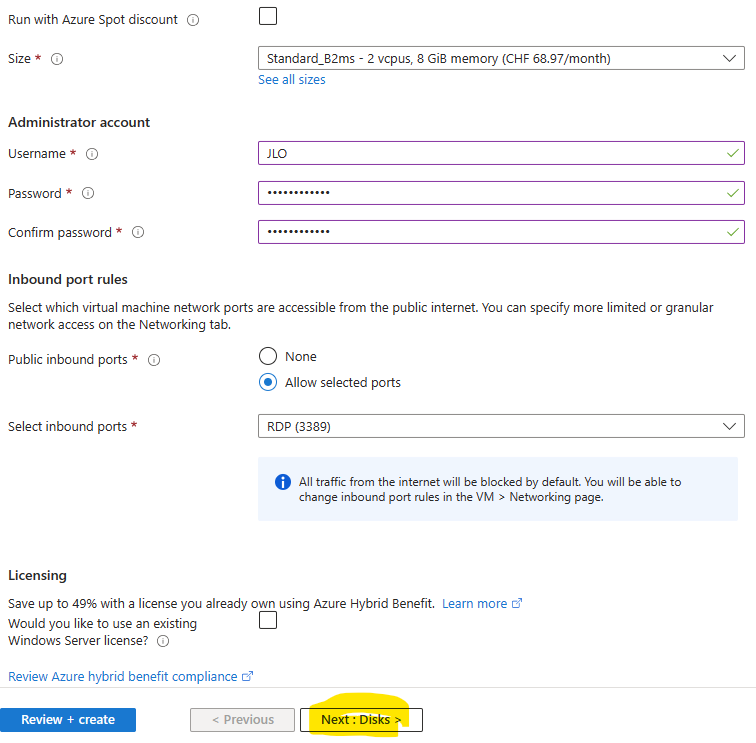

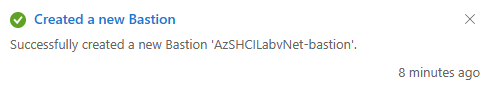

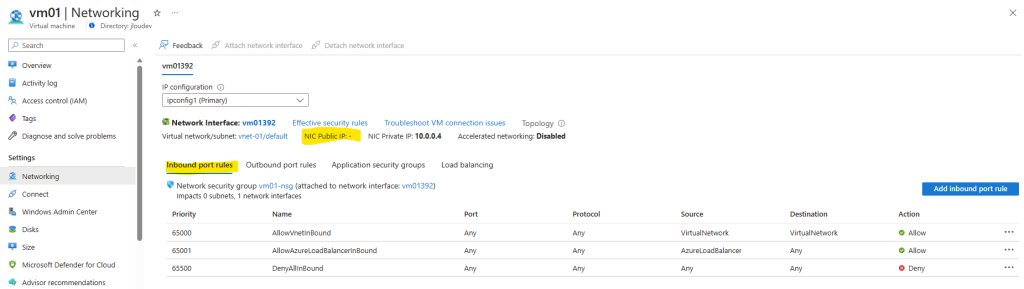

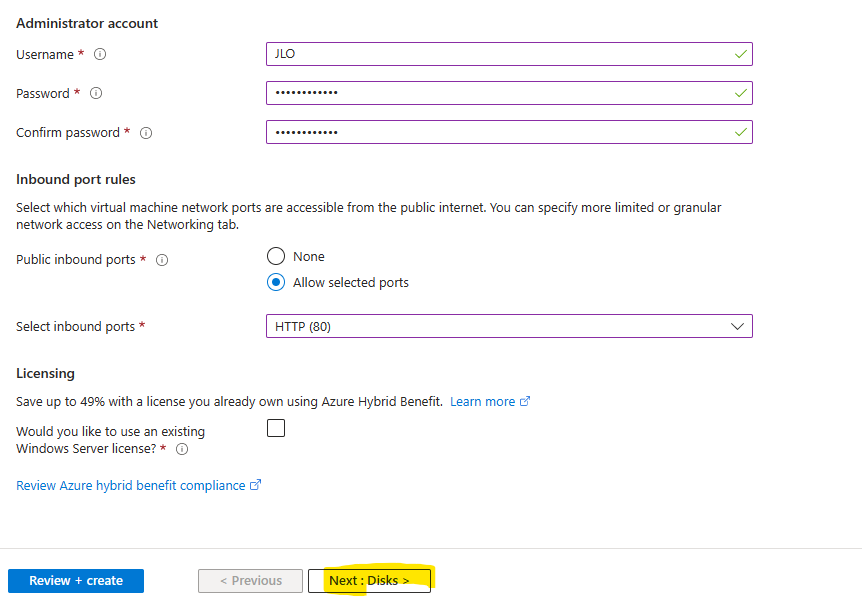

Définissez un compte administrateur local, bloquer les ports entrants (question de sécurité pour un DC), puis cliquez sur Suivant :

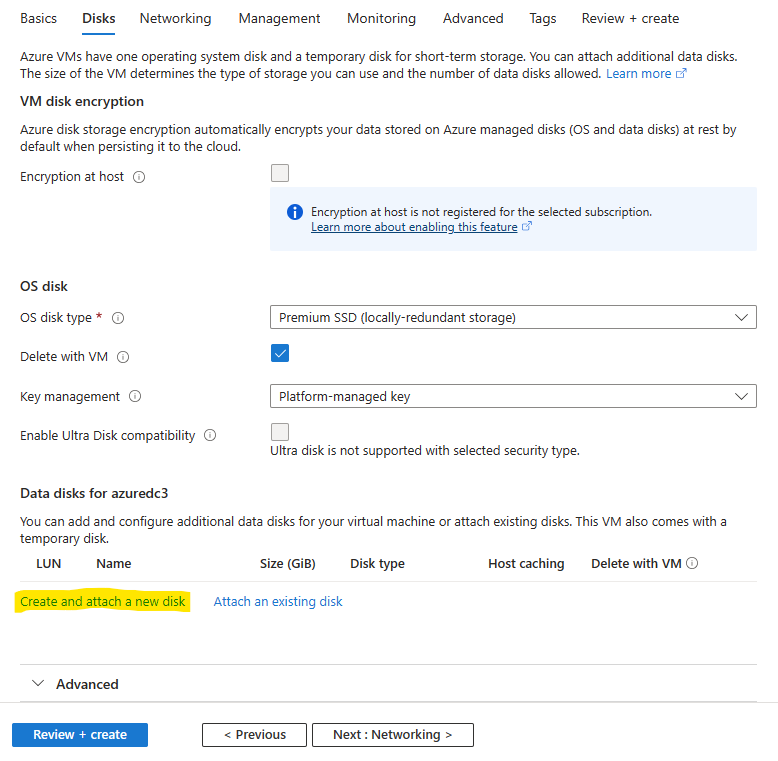

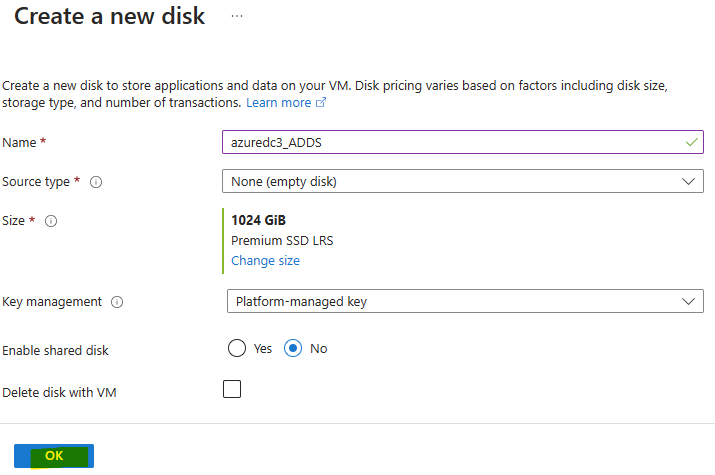

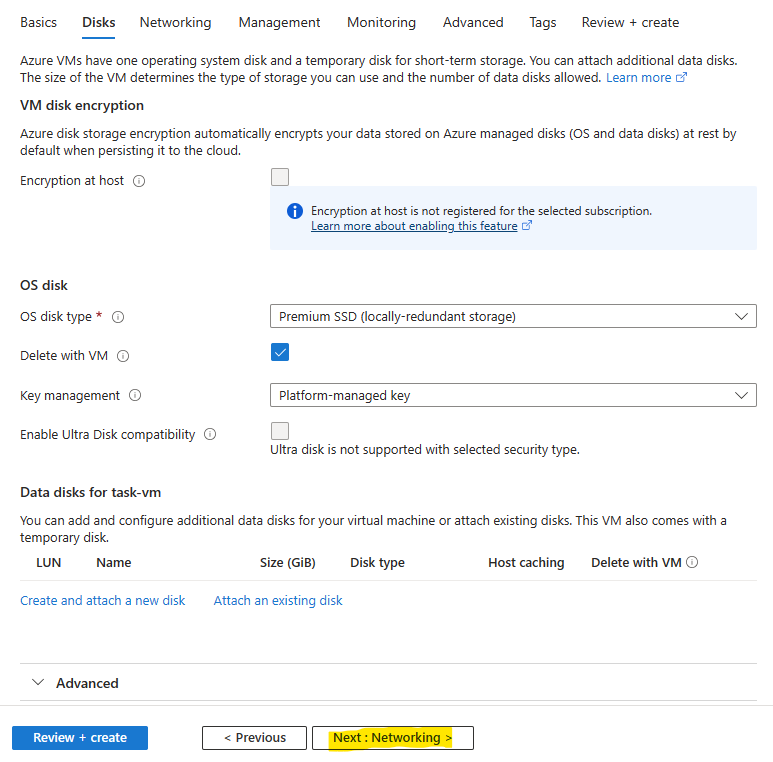

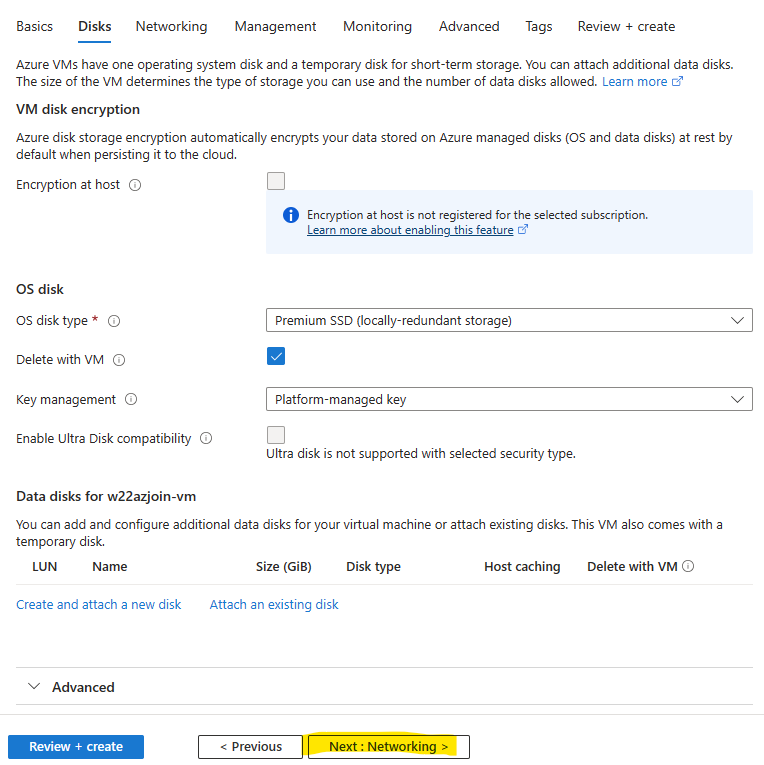

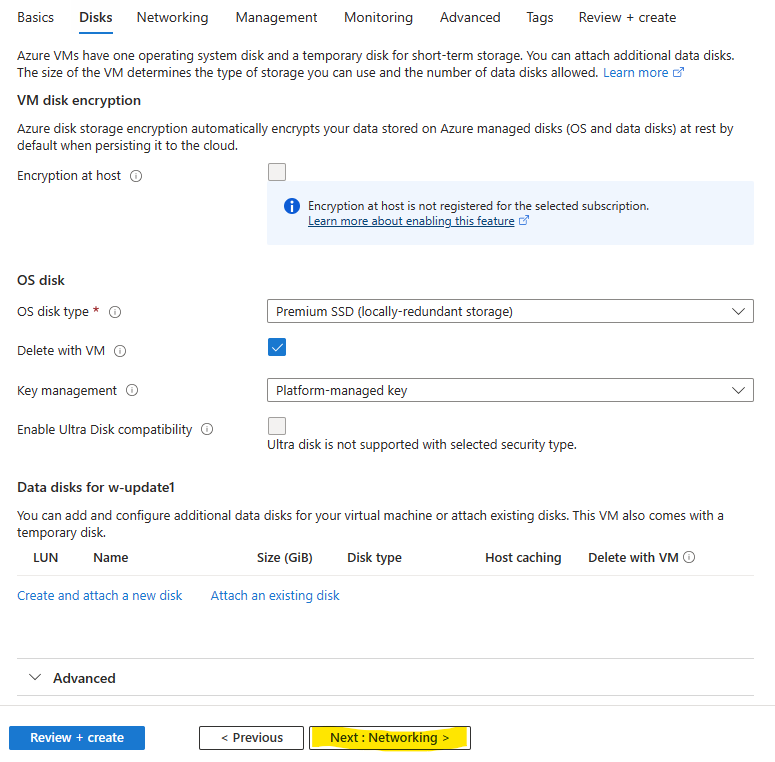

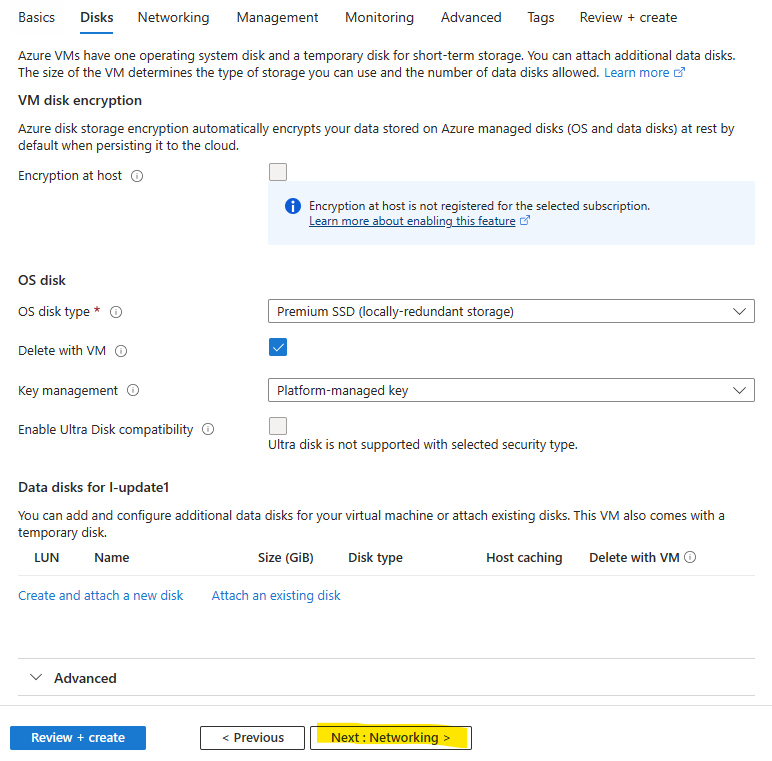

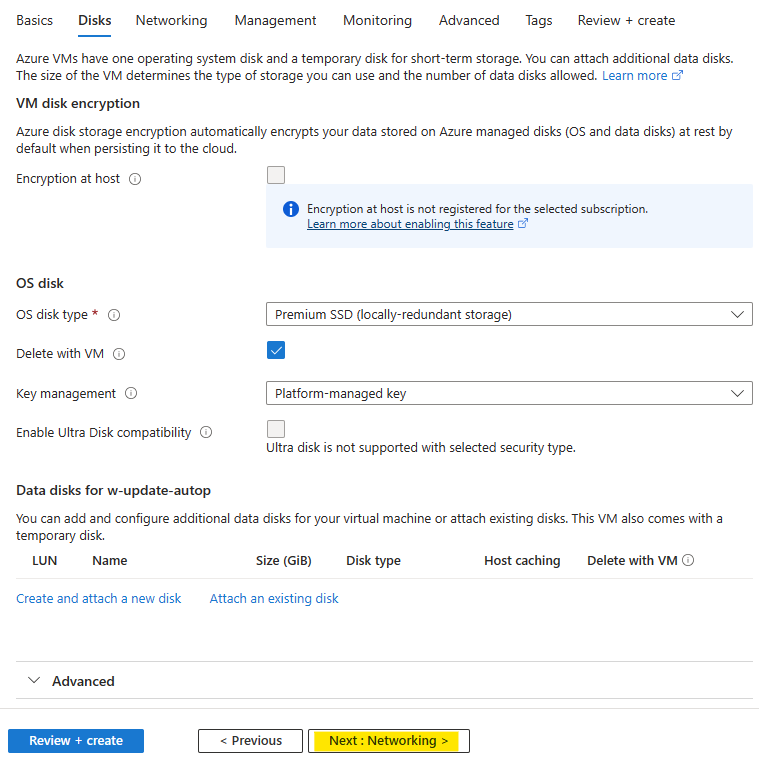

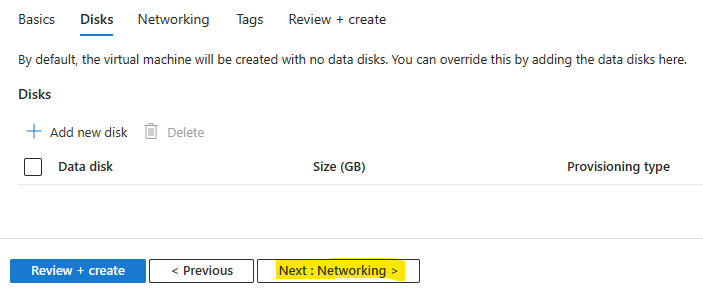

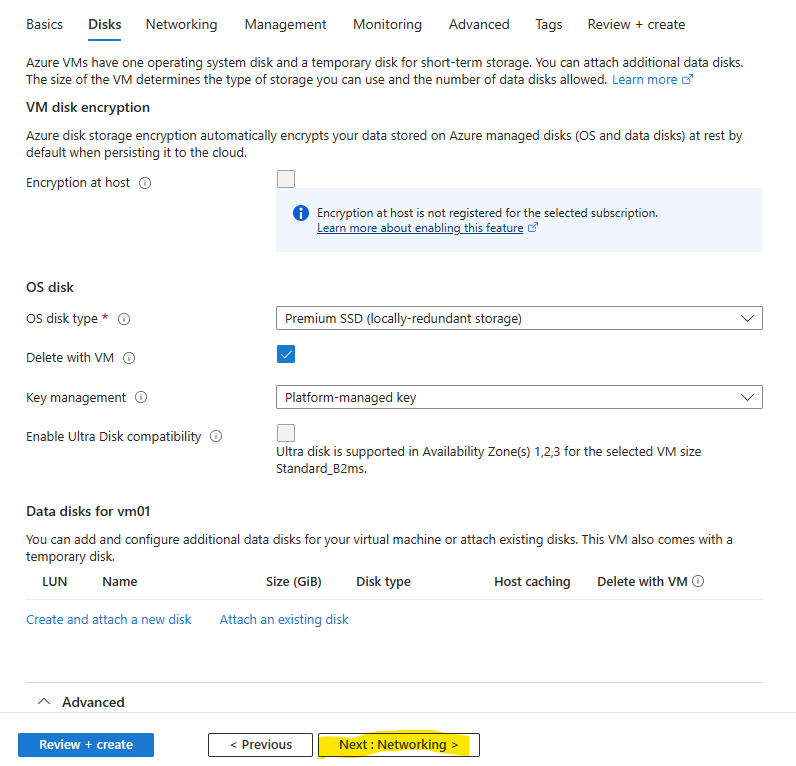

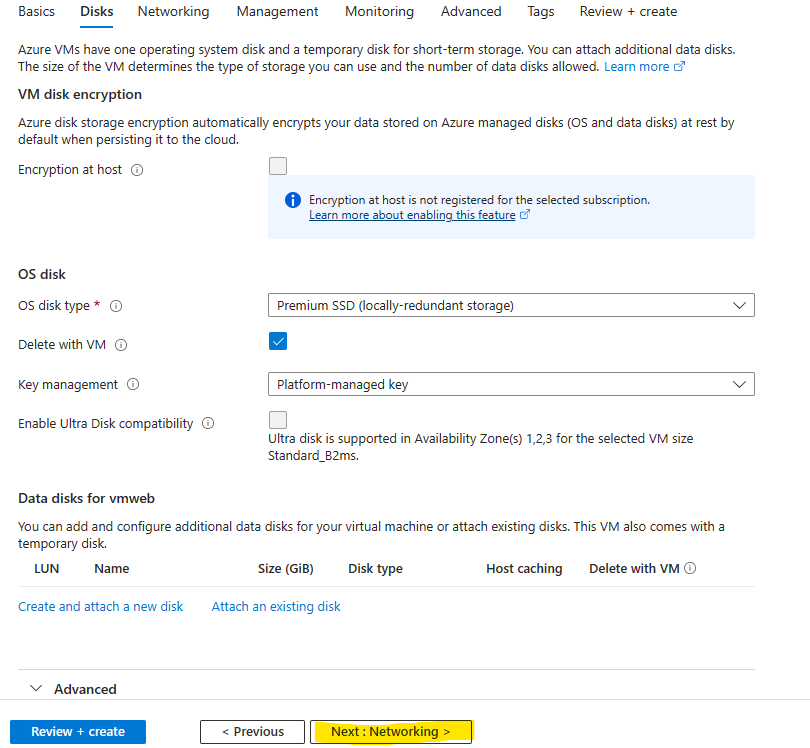

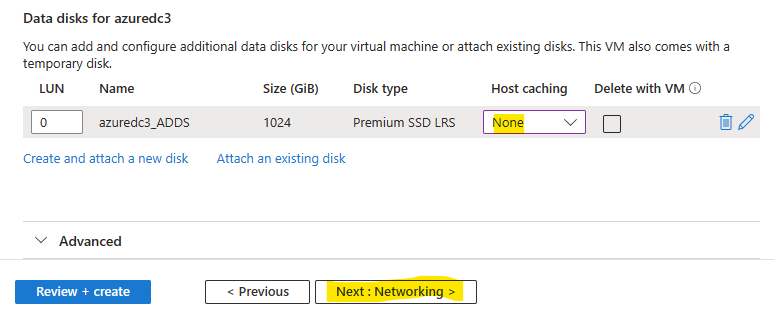

Comme le Microsoft le recommande, il est nécessaire de stocker les informations AD (base de données, les journaux et le dossier sysvol) séparées du disque OS.

Pour cela, rajoutez un second disque en cliquant ici :

Cliquez sur OK :

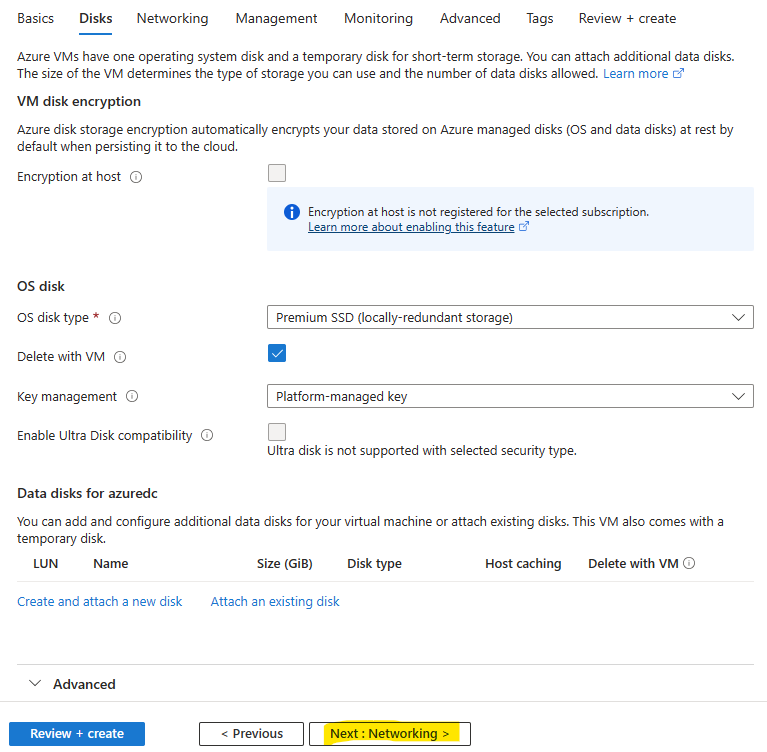

Définissez le paramètre Host Cache sur le disque de données sur None, puis cliquez sur Suivant :

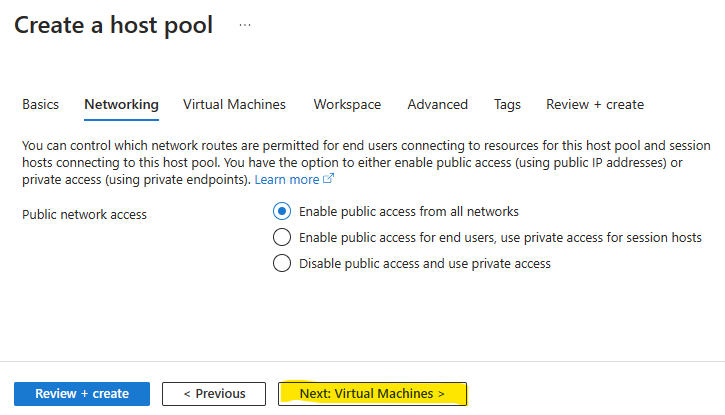

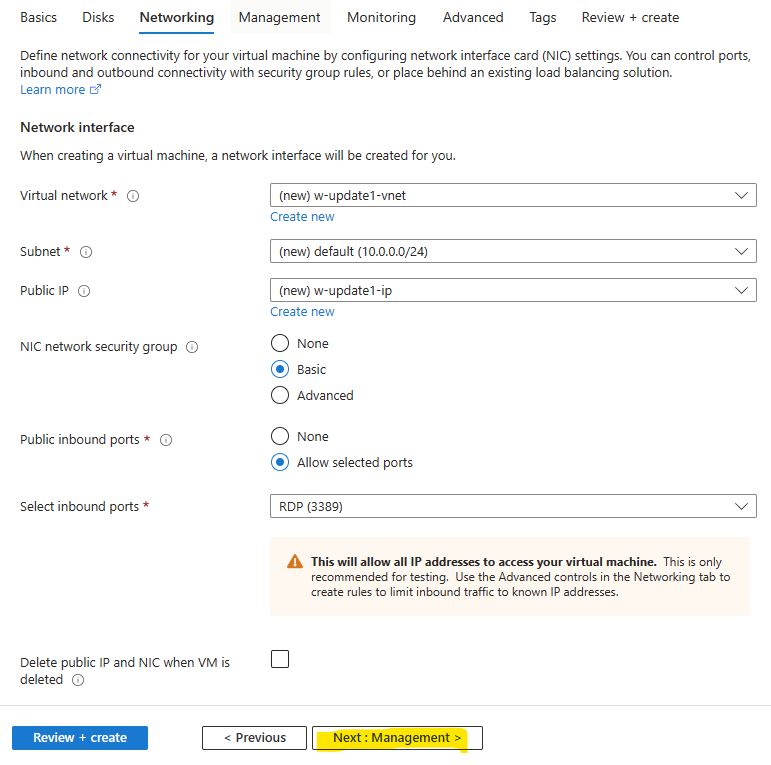

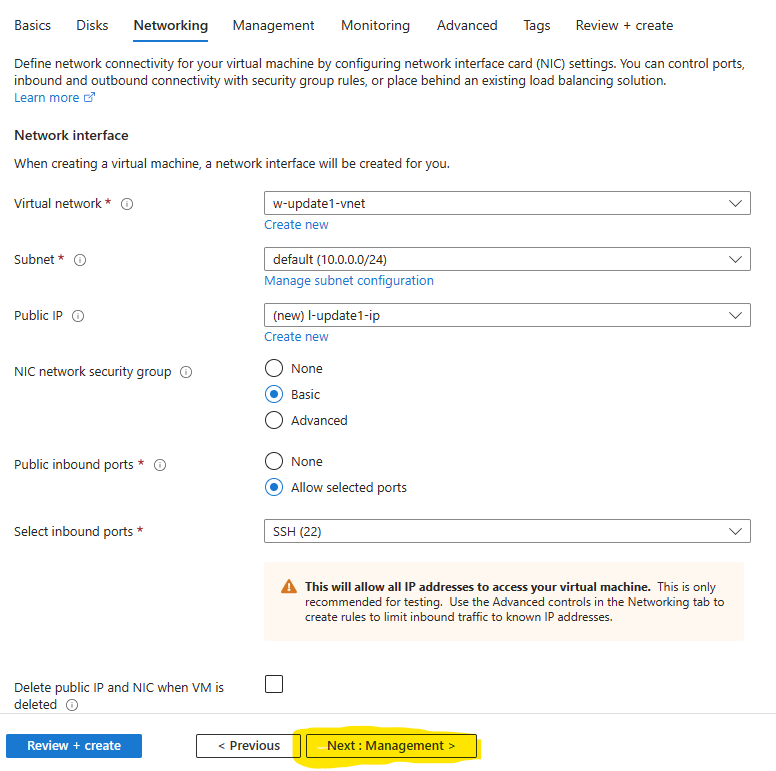

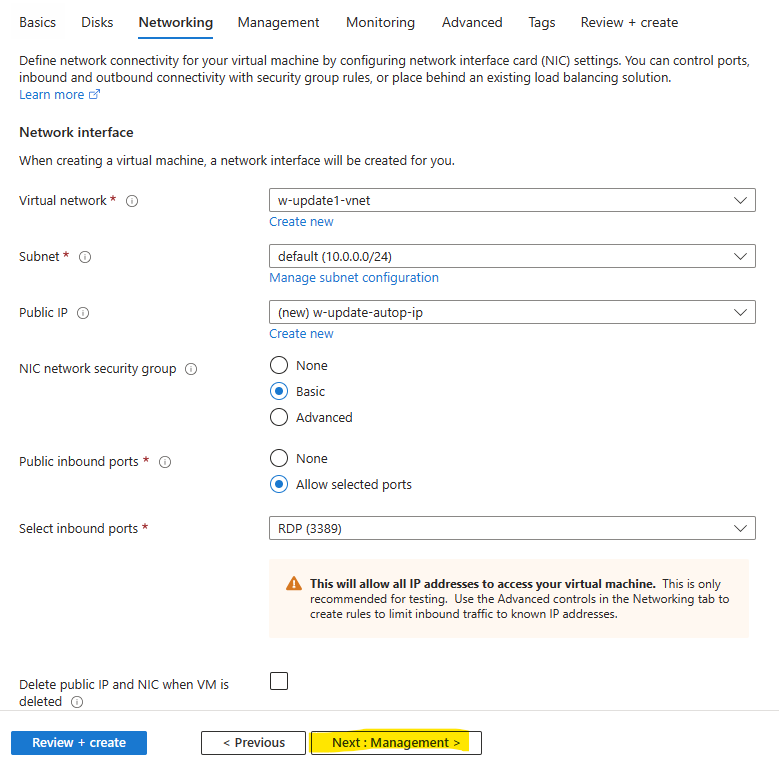

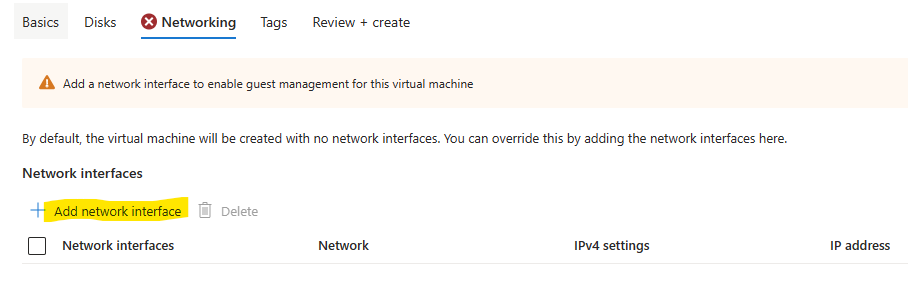

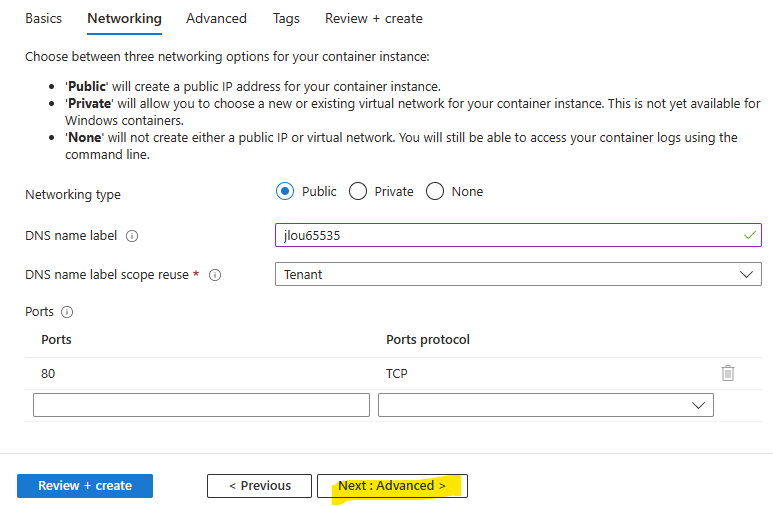

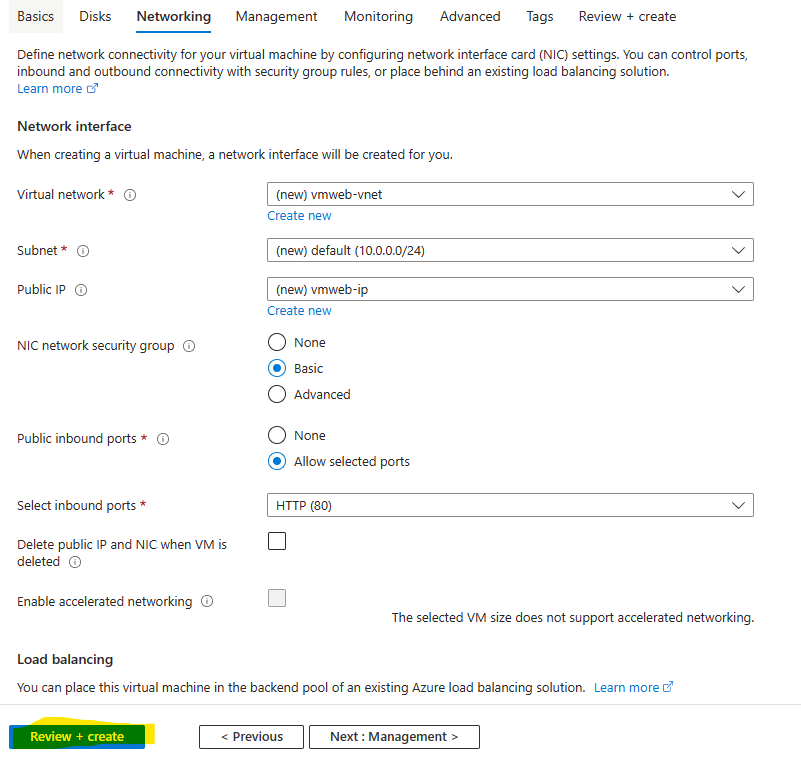

Aucune modification n’est à faire sur cet onglet, cliquez sur Suivant :

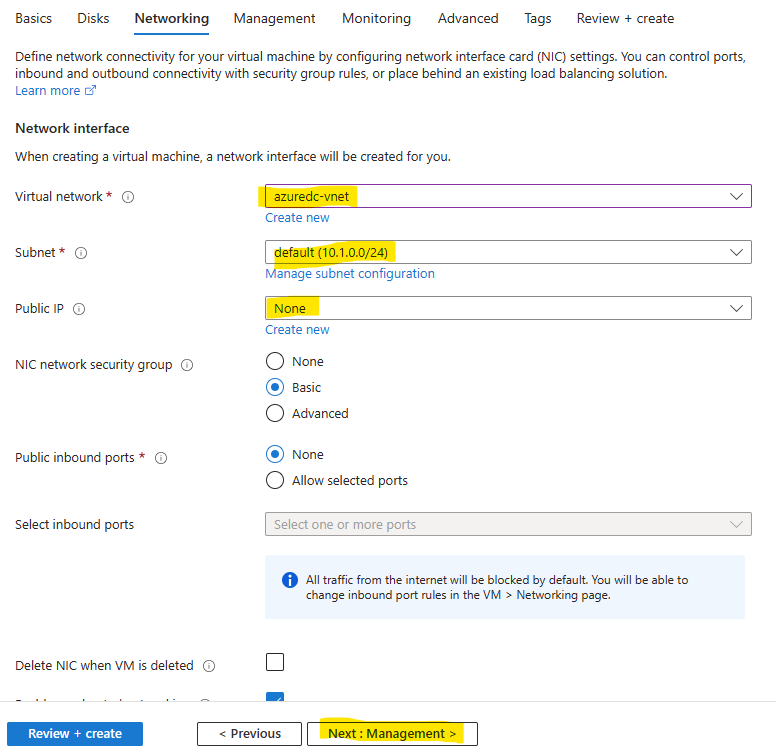

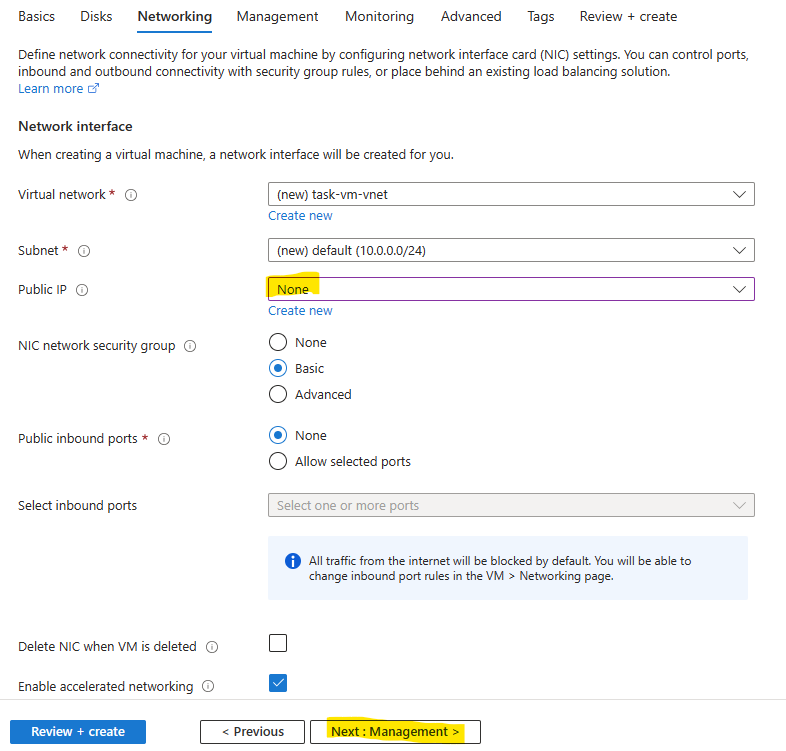

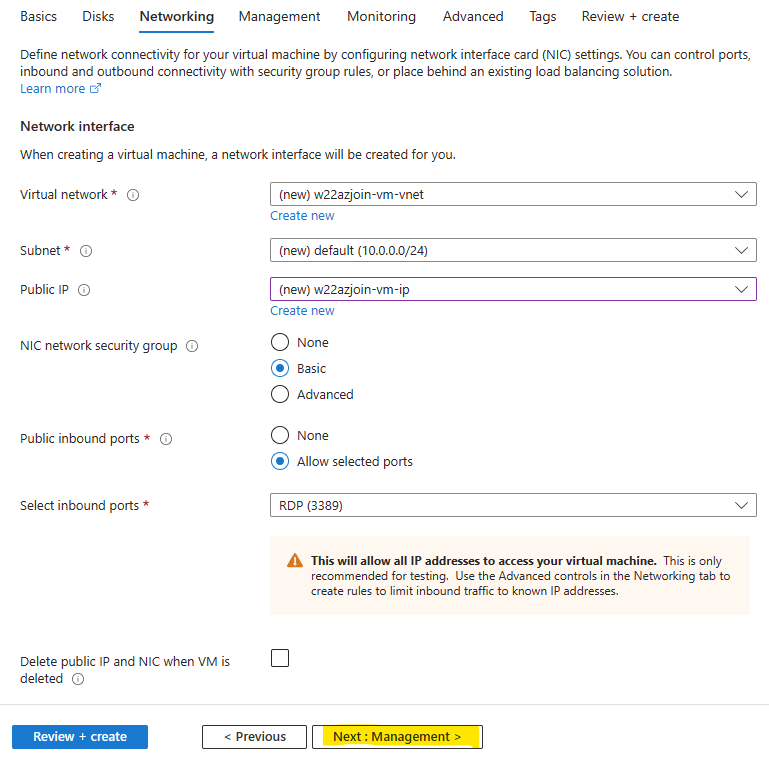

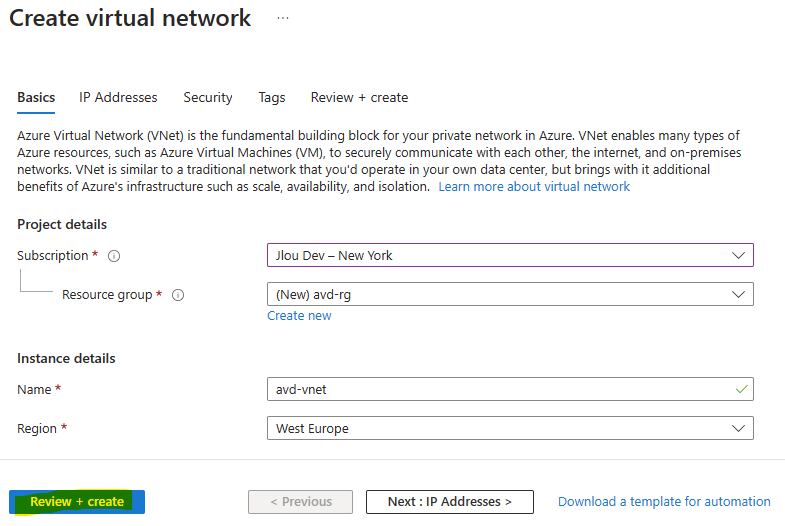

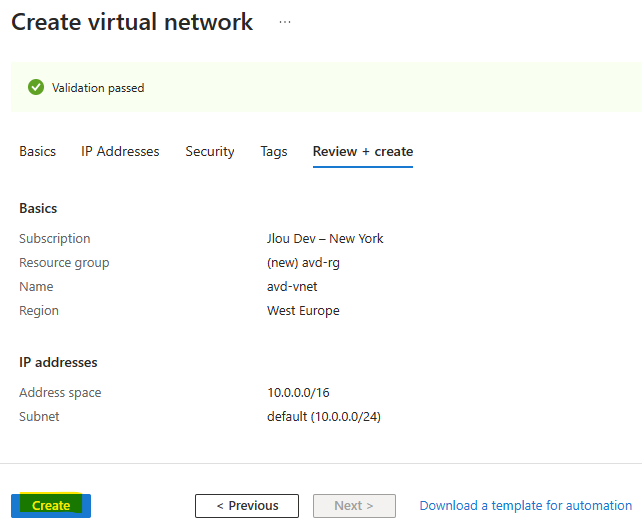

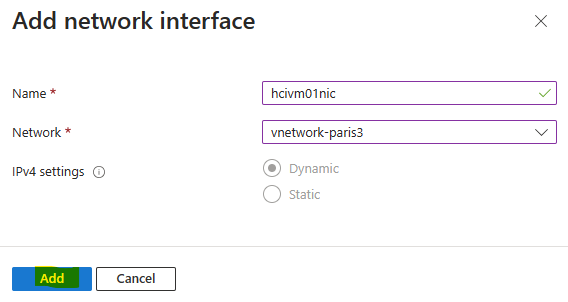

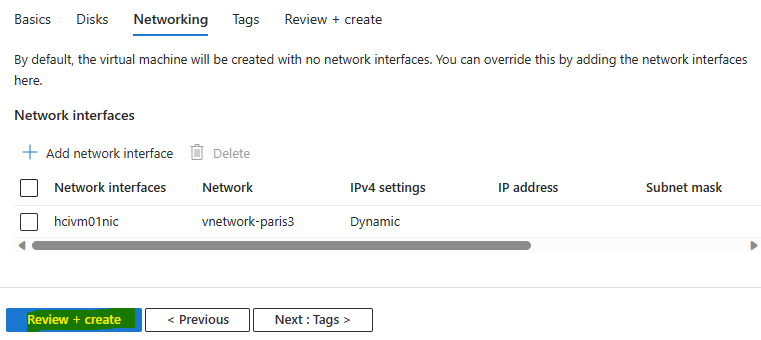

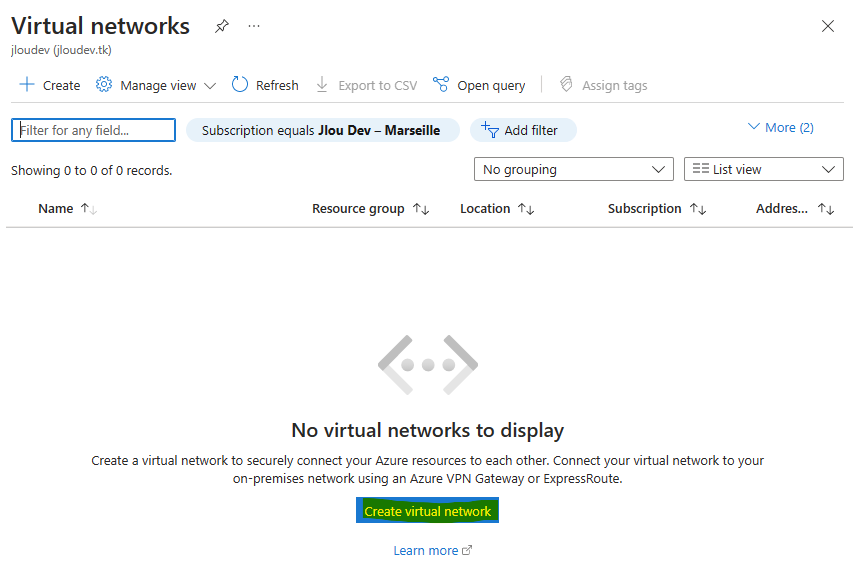

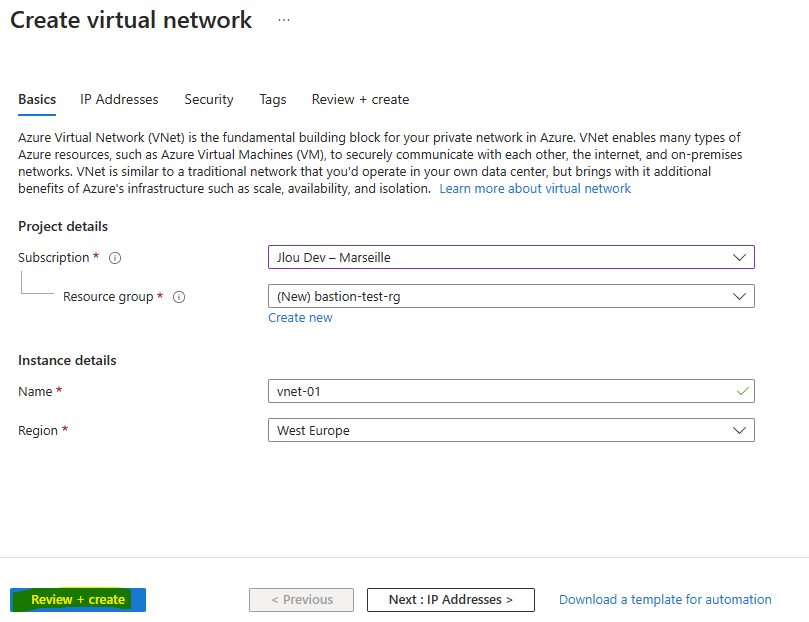

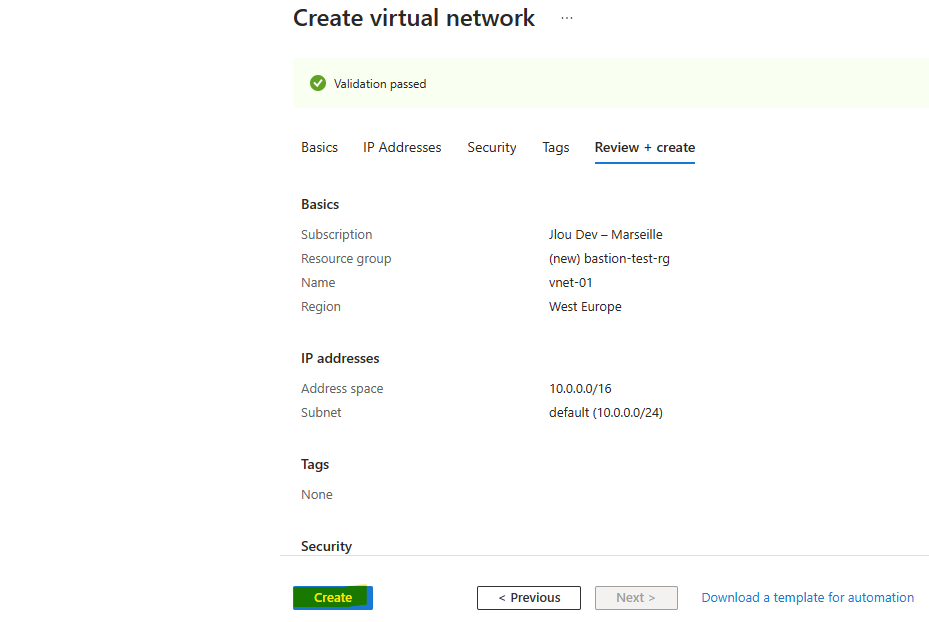

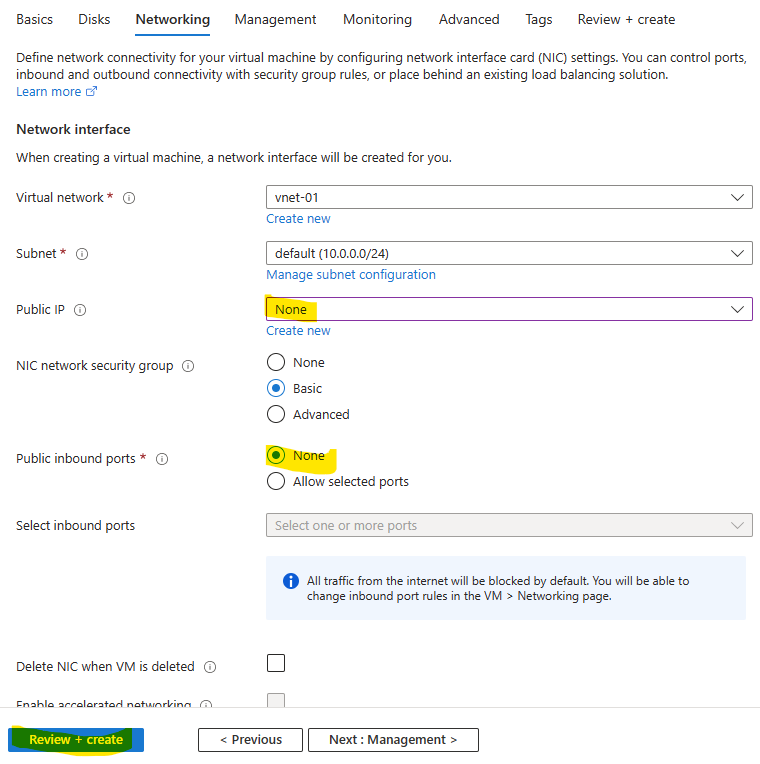

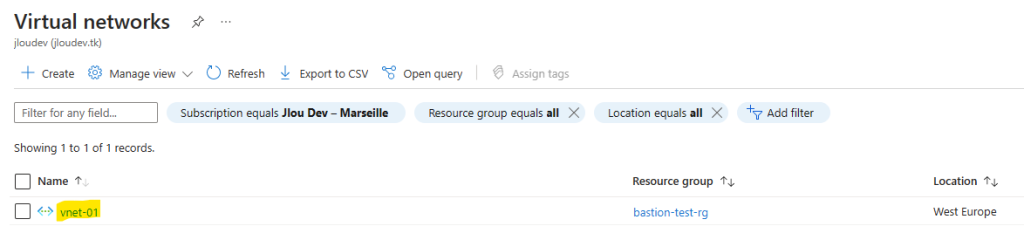

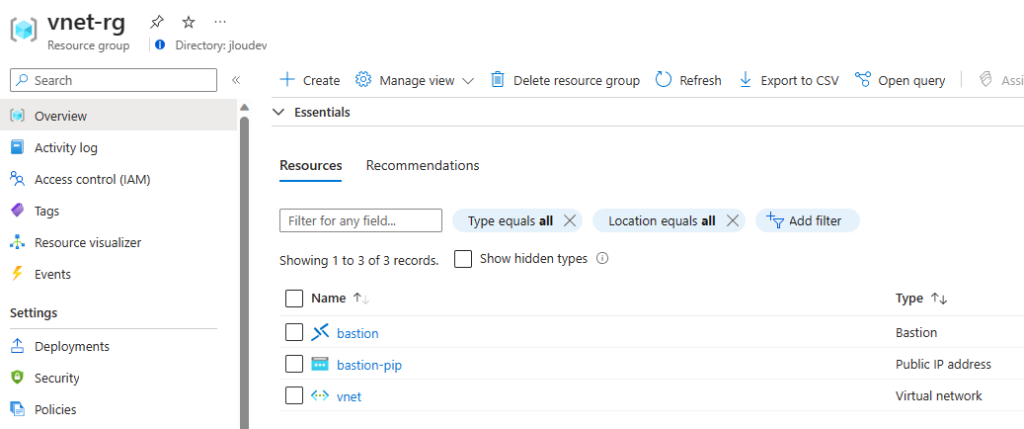

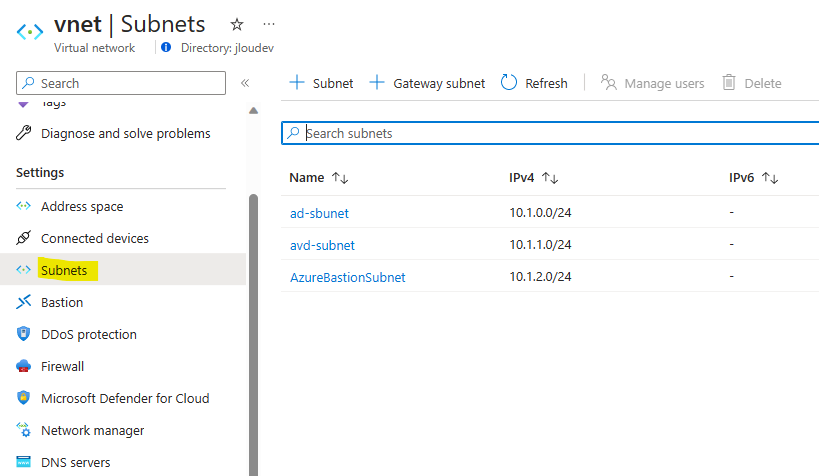

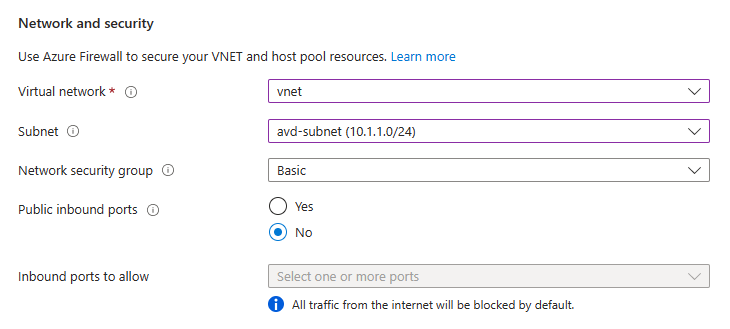

Créez un réseau virtuel (différent de celui utilisé pour simuler le réseau on-premise), retirez l’adresse IP publique, puis cliquez sur Suivant :

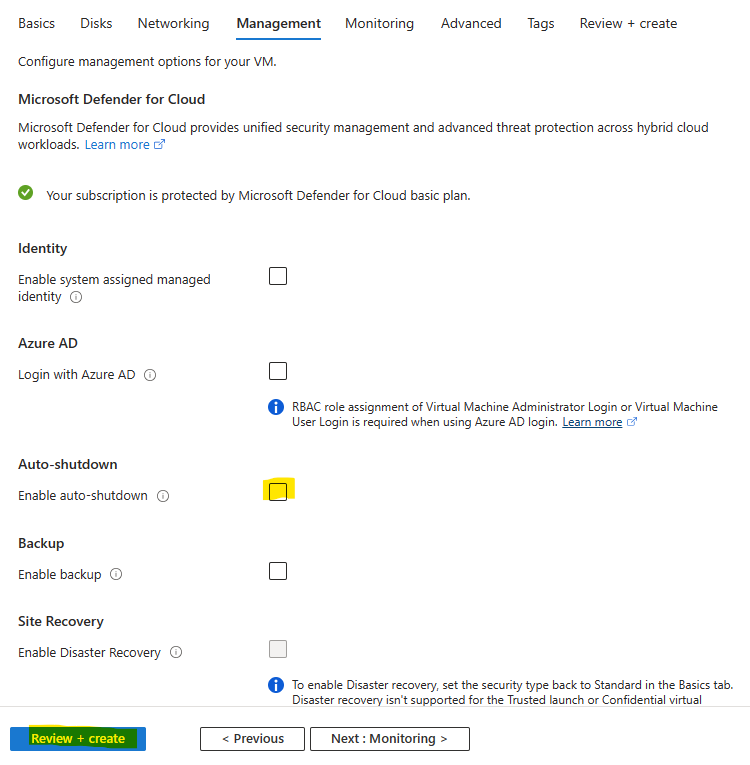

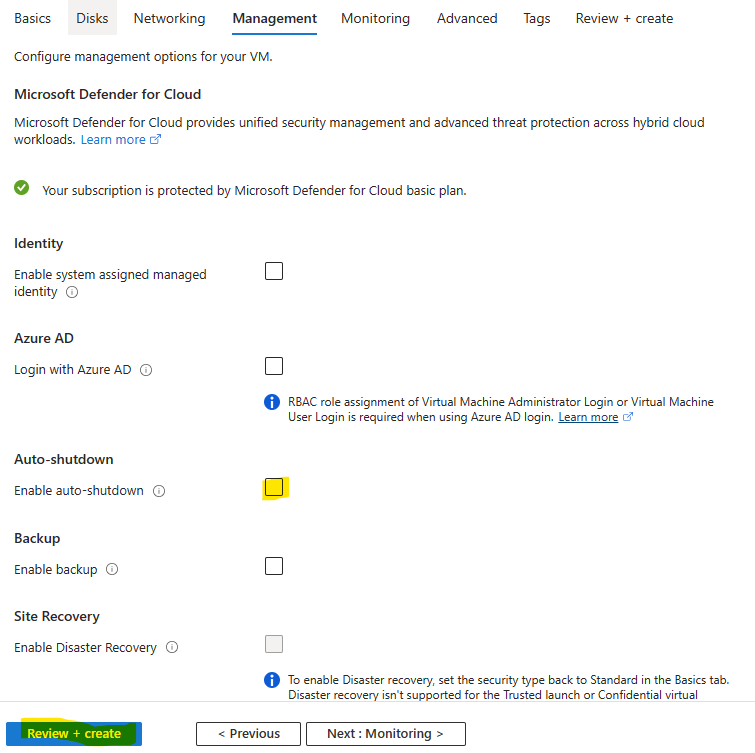

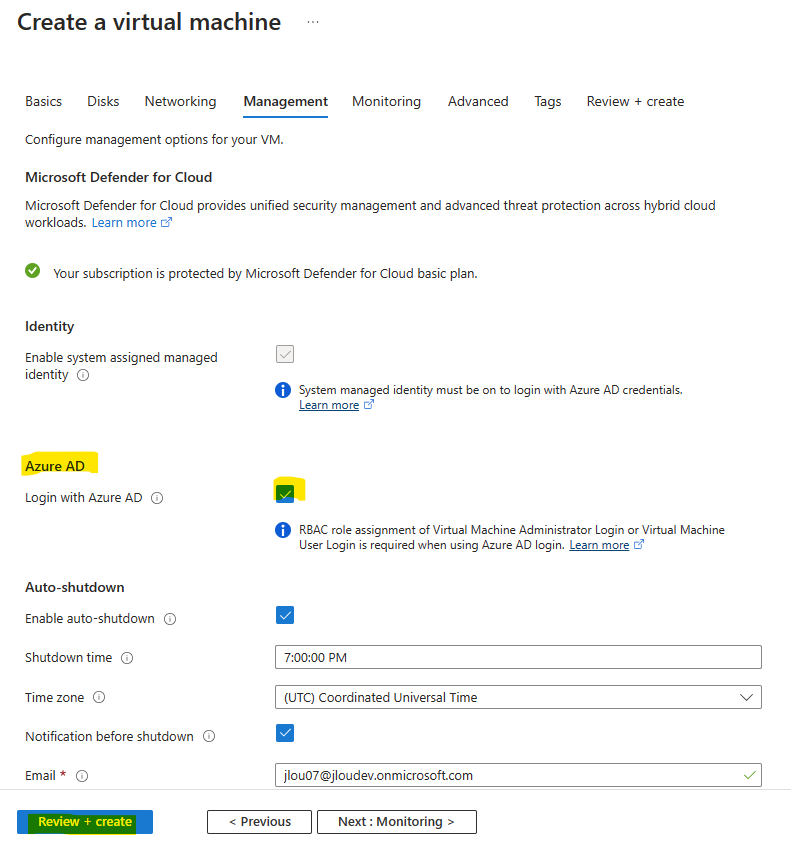

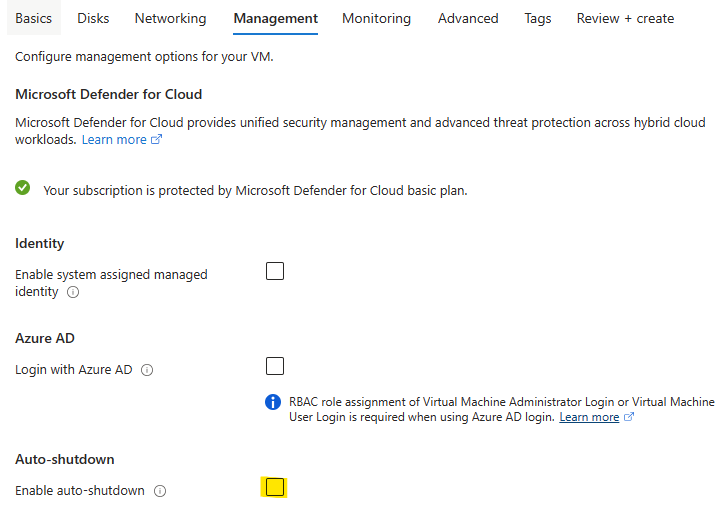

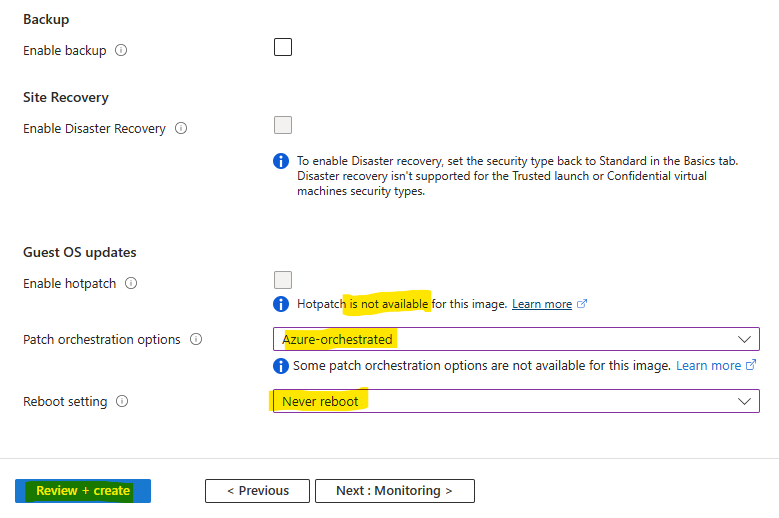

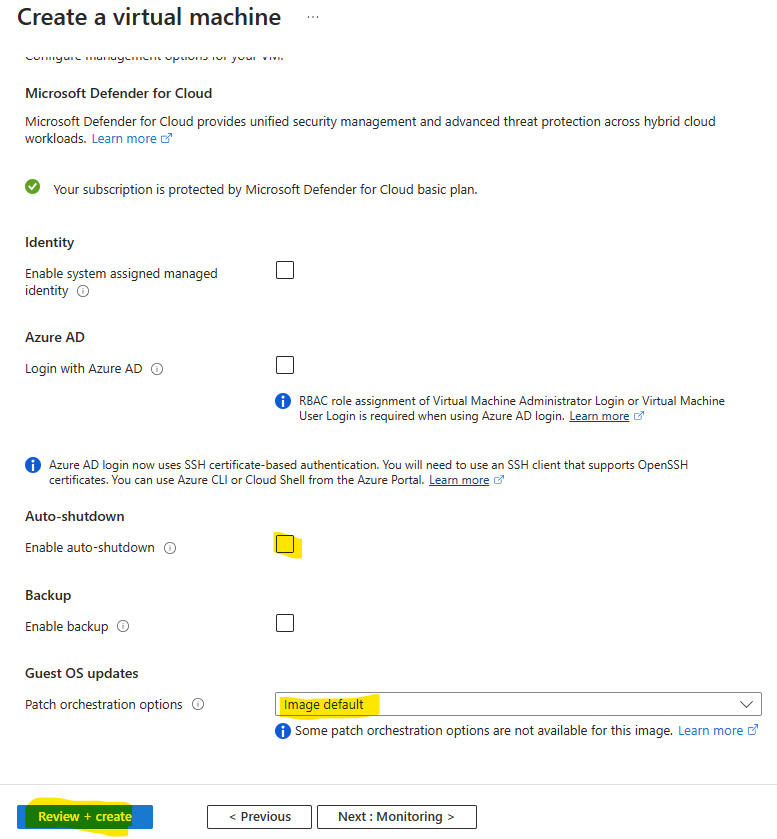

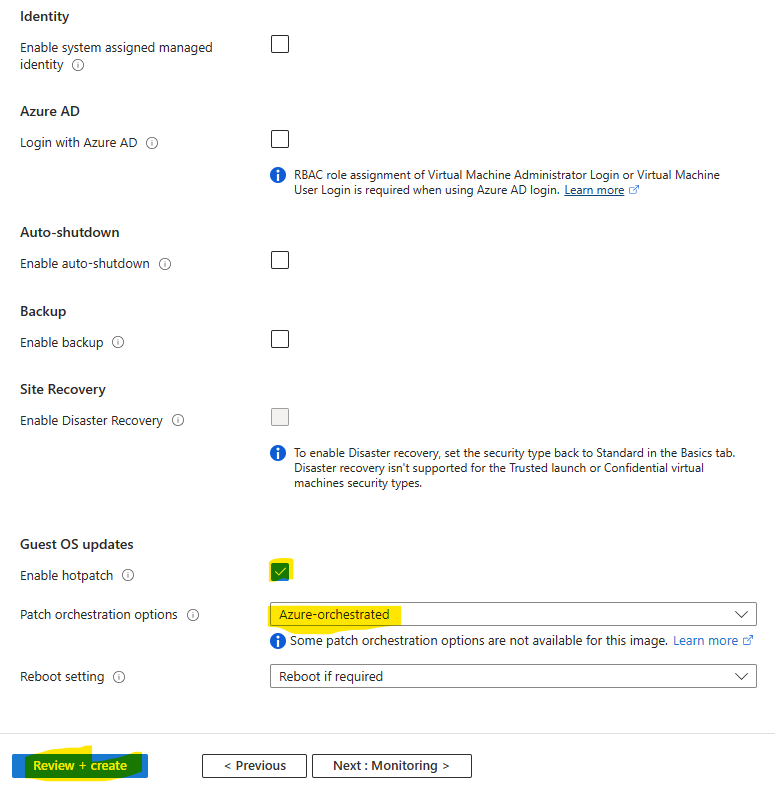

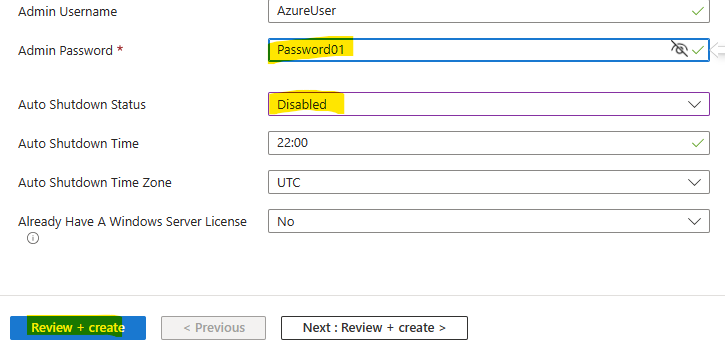

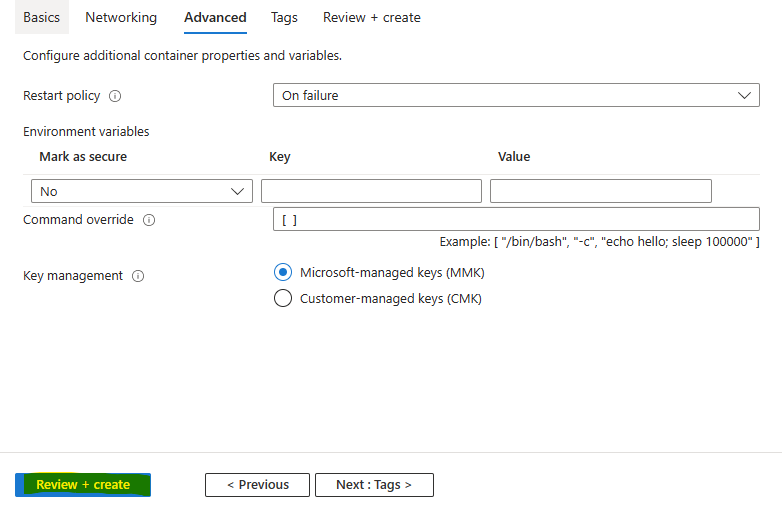

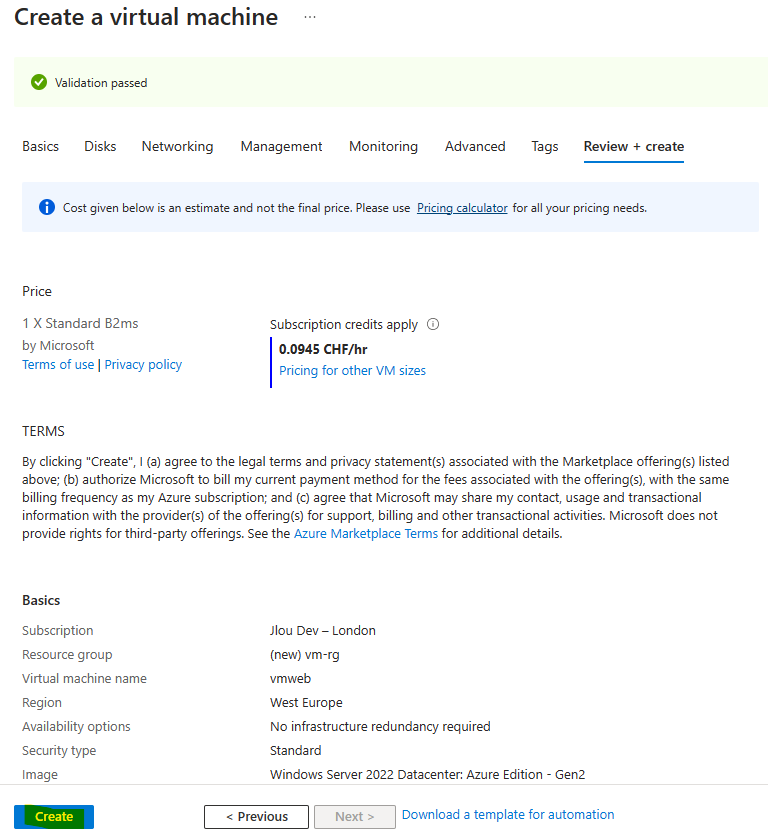

Décochez l’extinction automatique de la machine virtuelle, puis lancez la validation Azure :

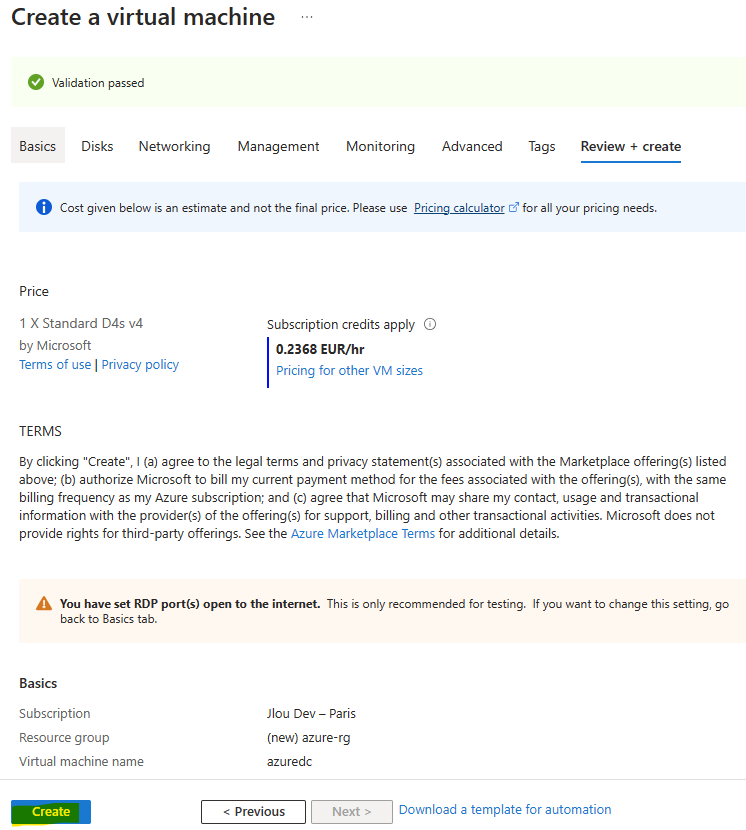

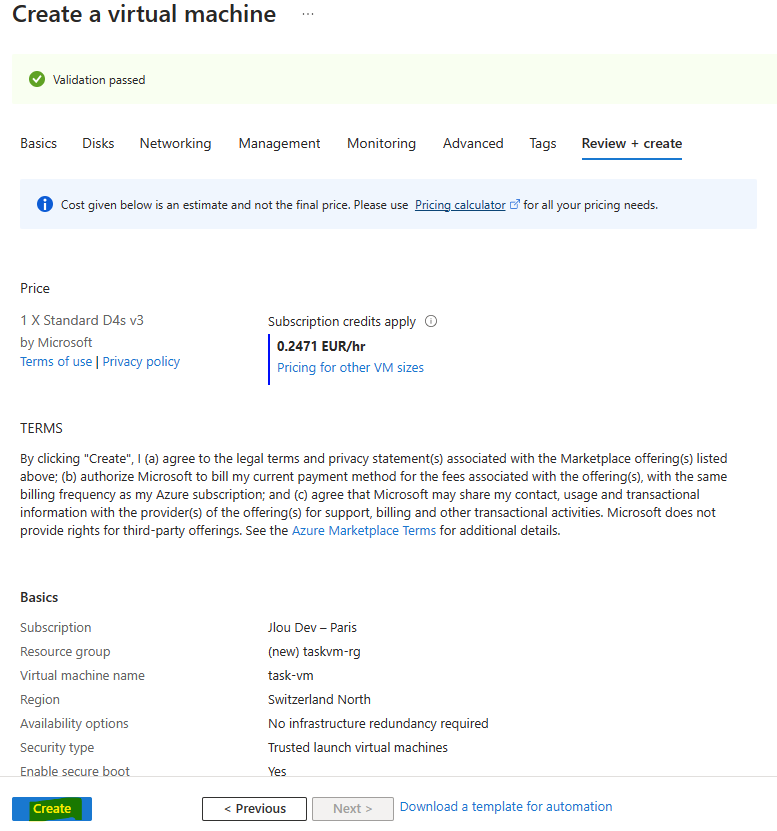

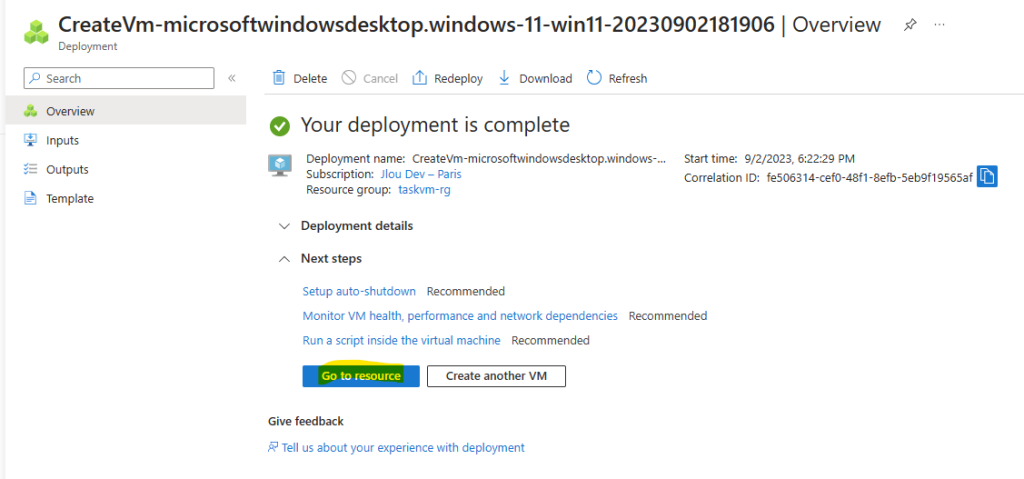

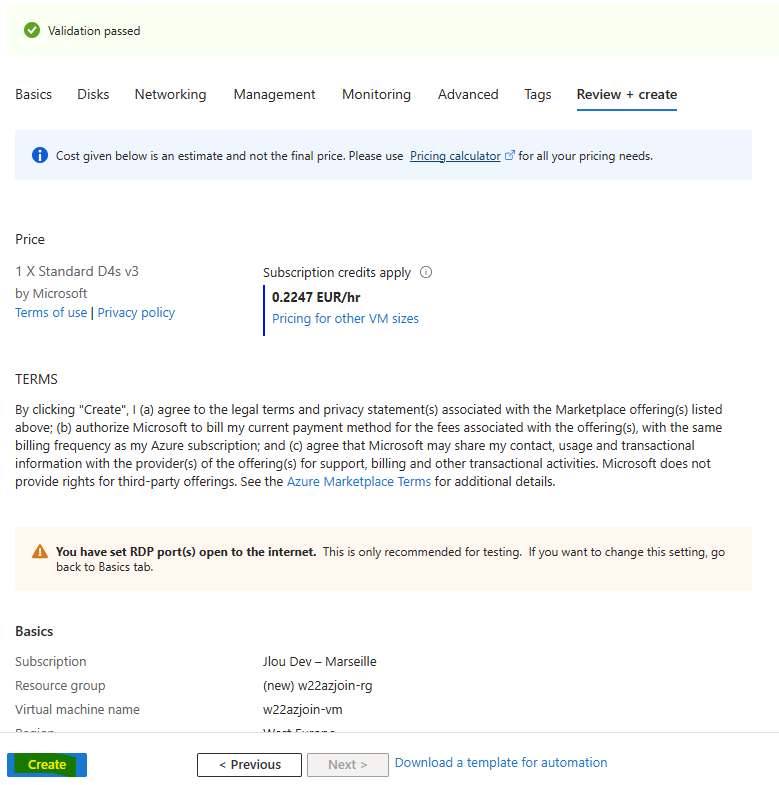

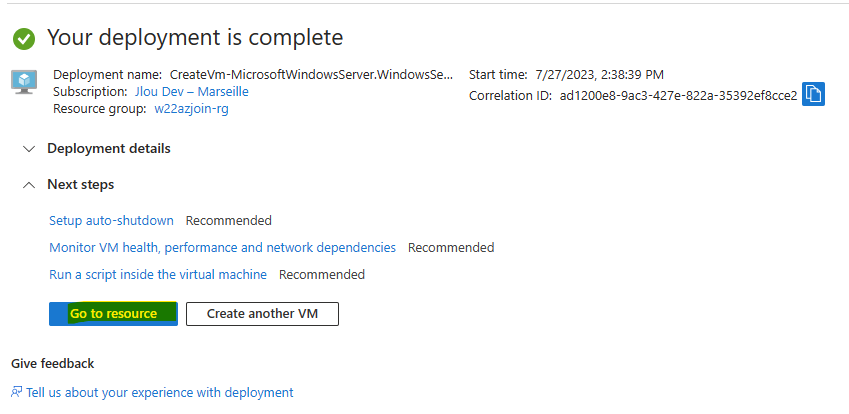

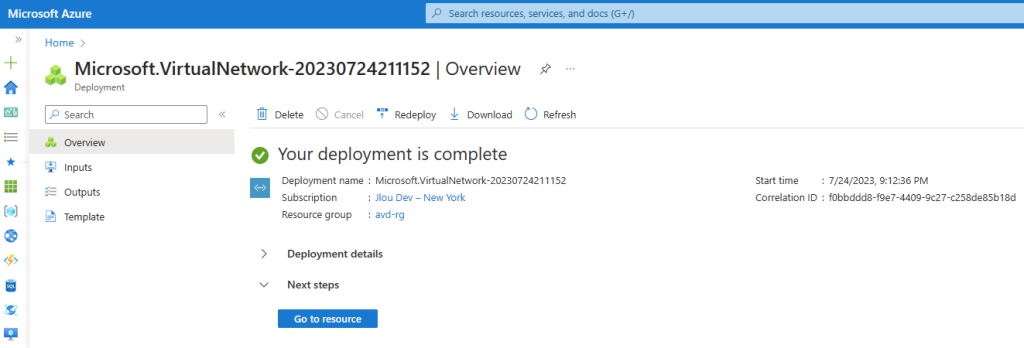

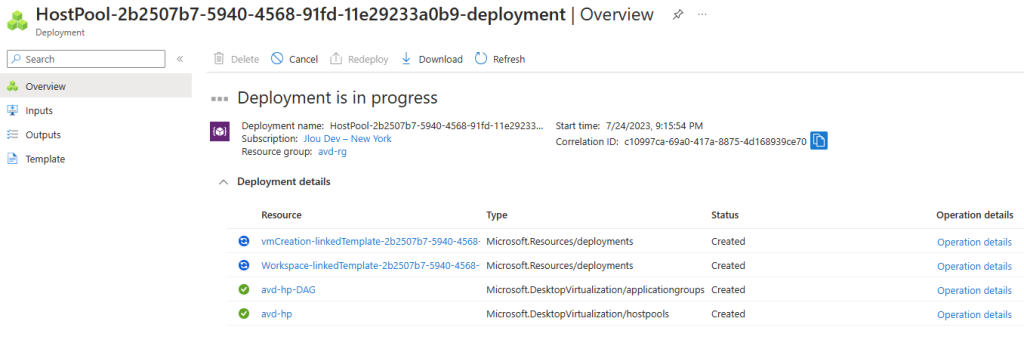

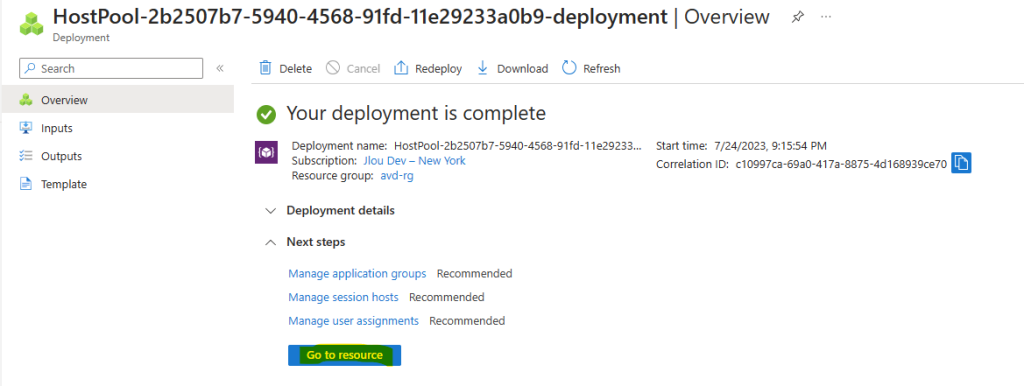

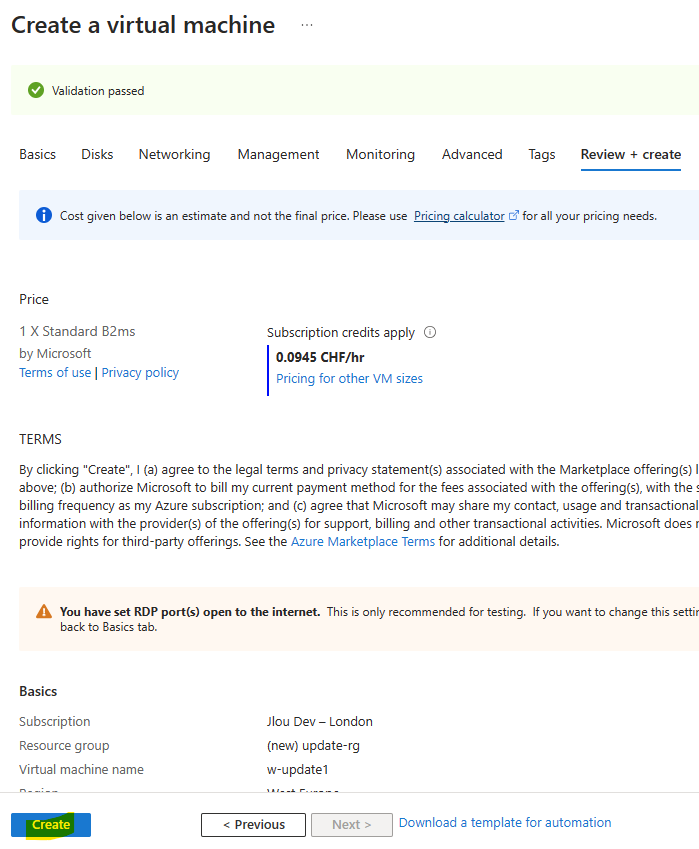

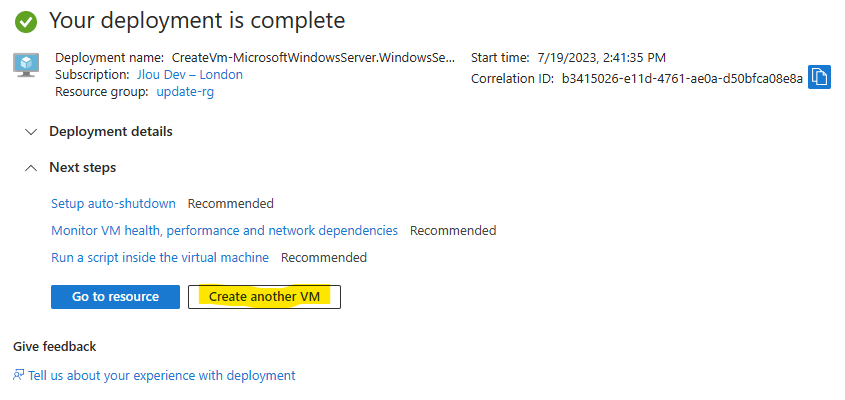

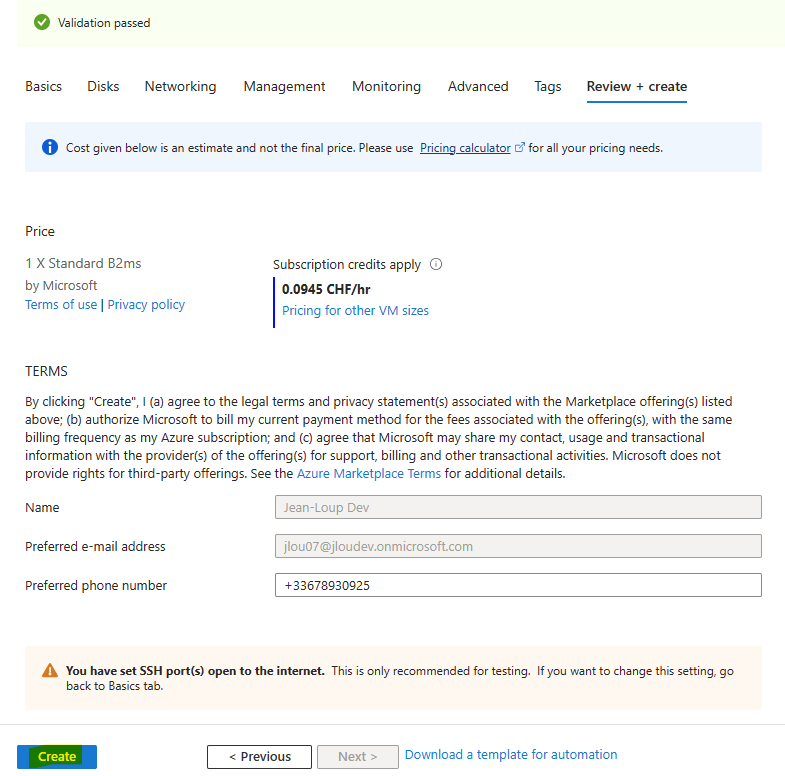

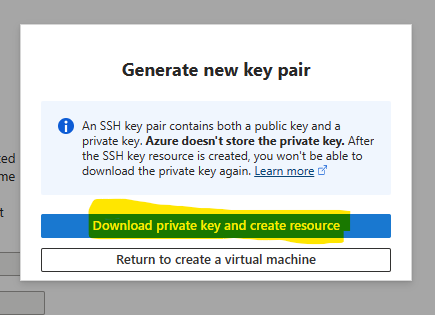

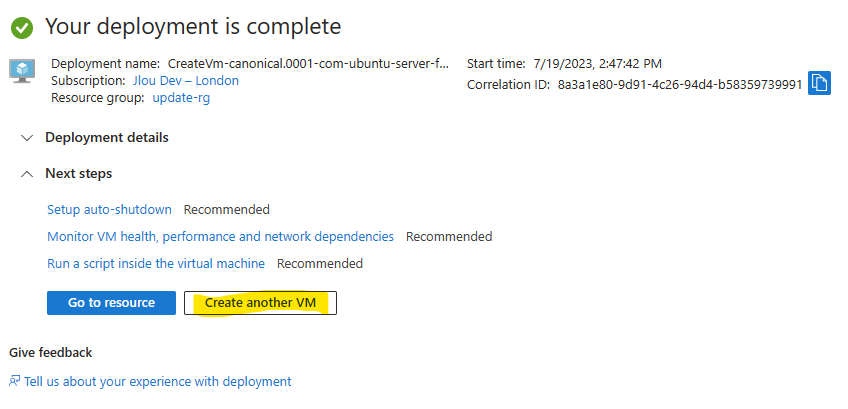

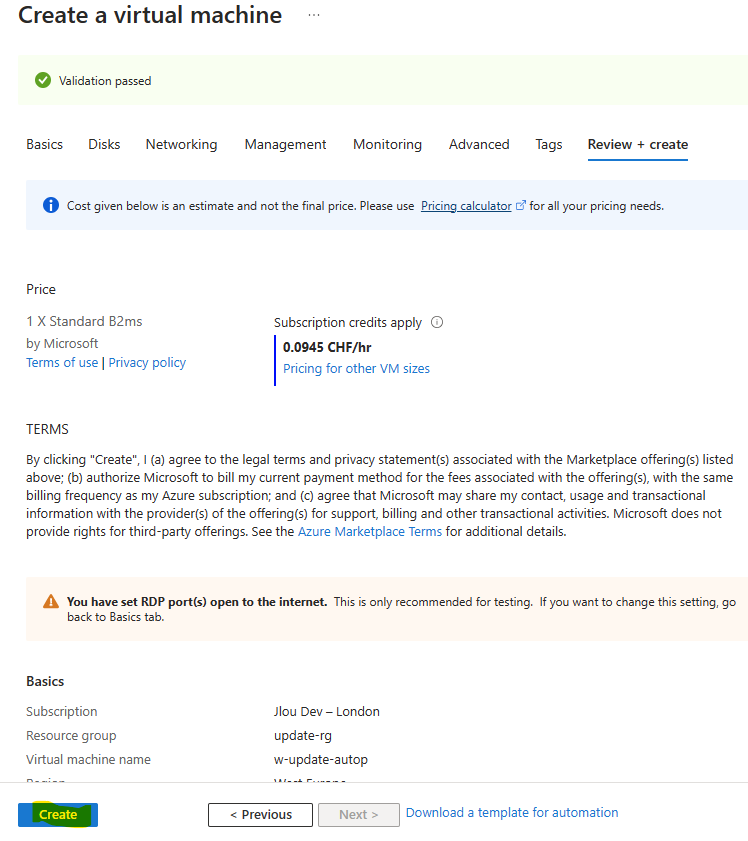

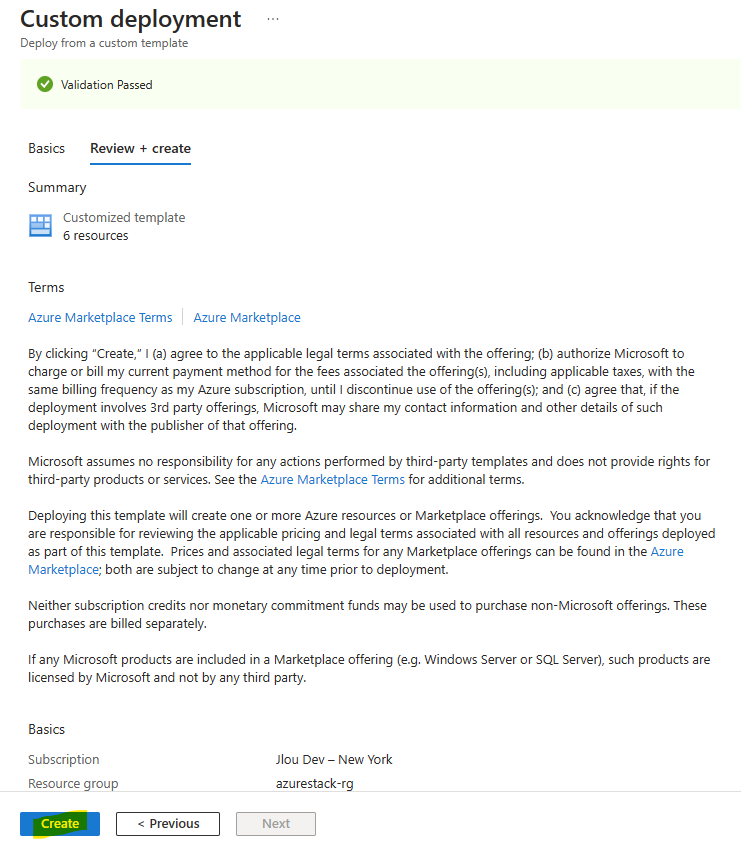

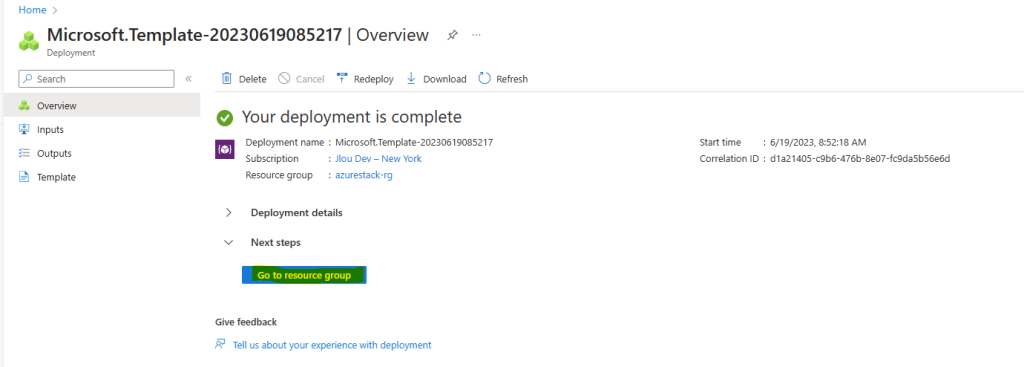

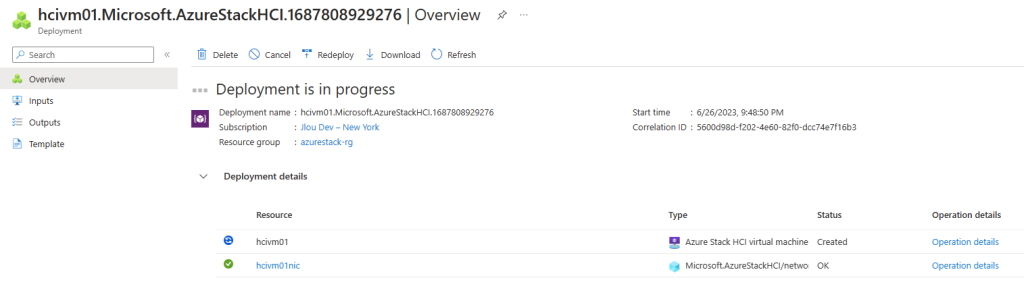

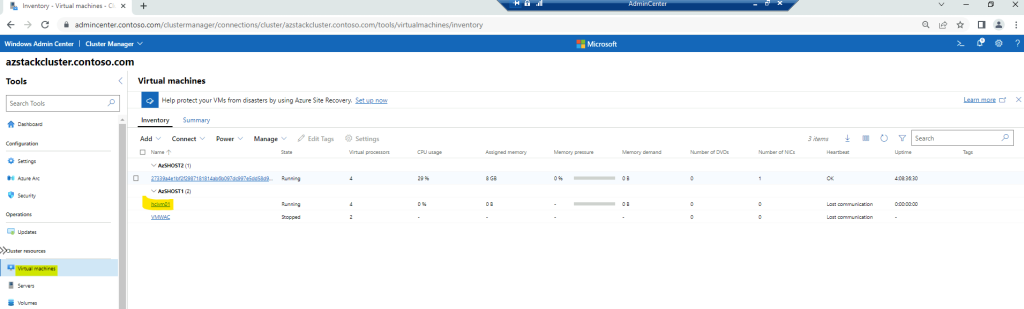

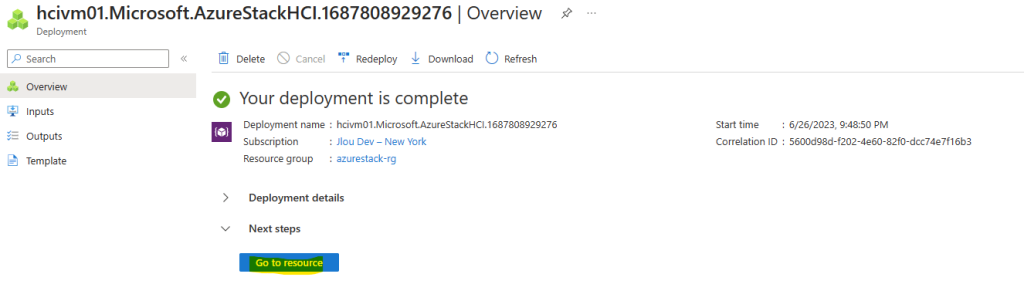

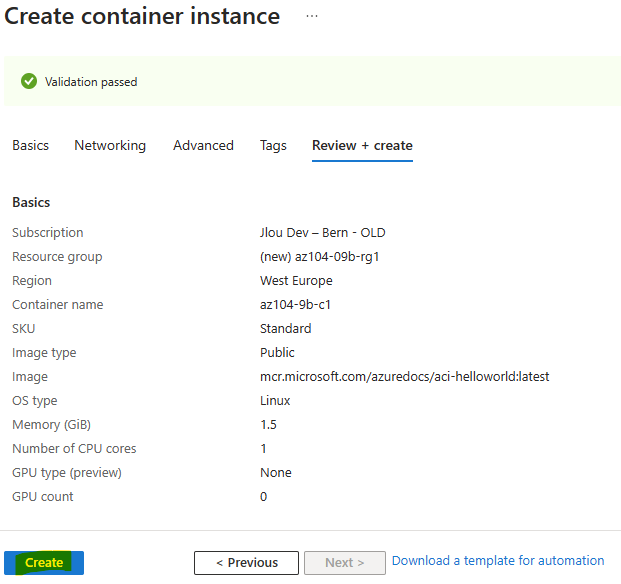

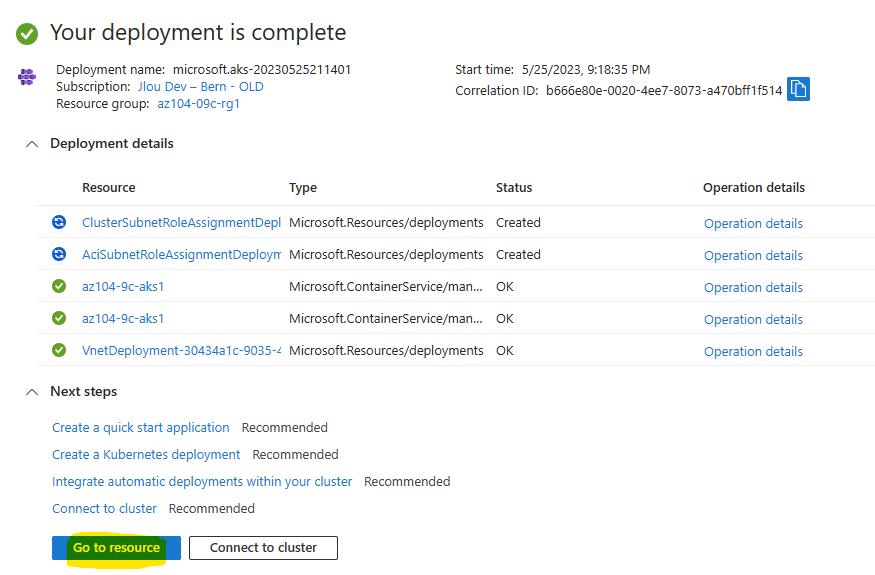

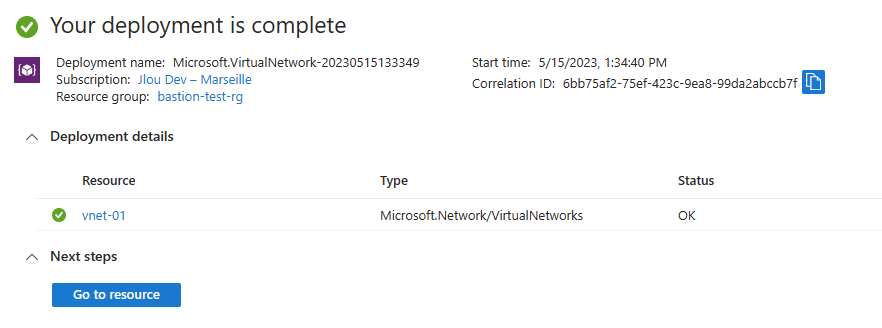

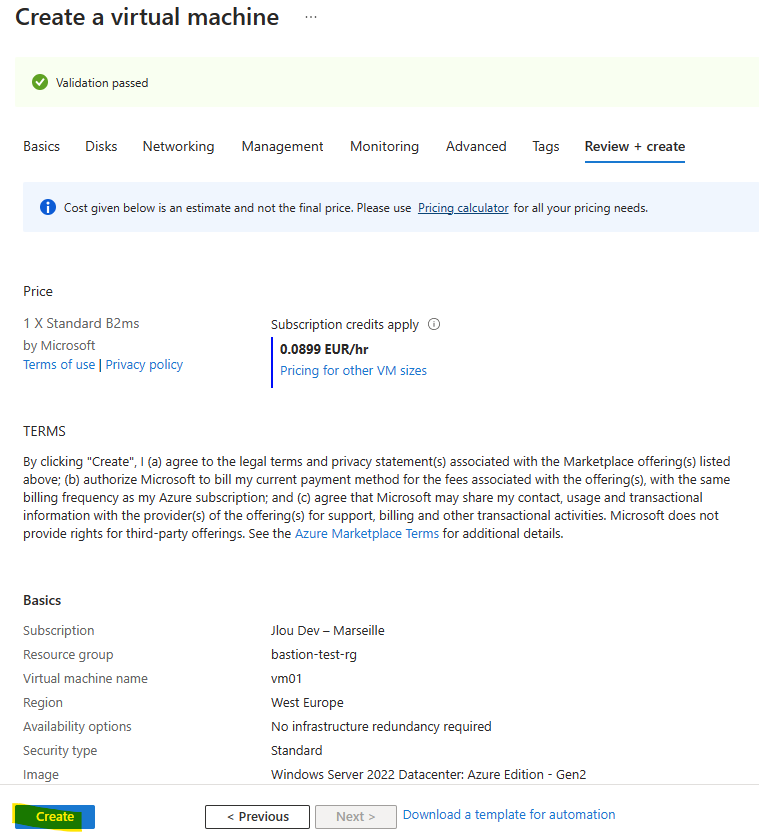

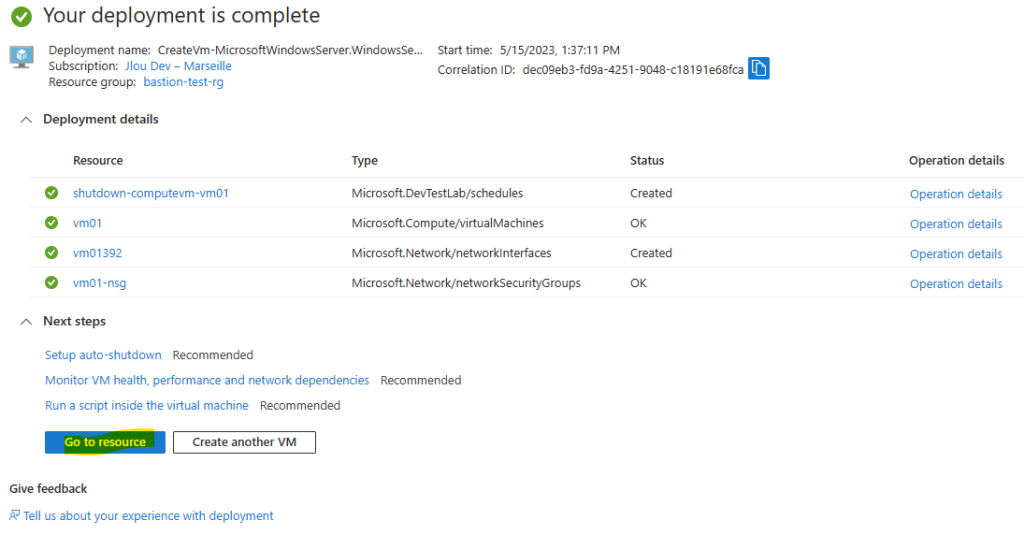

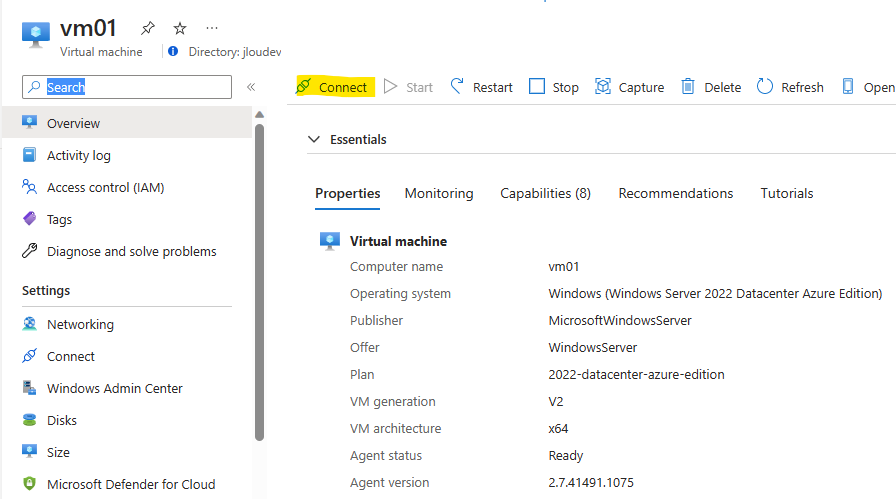

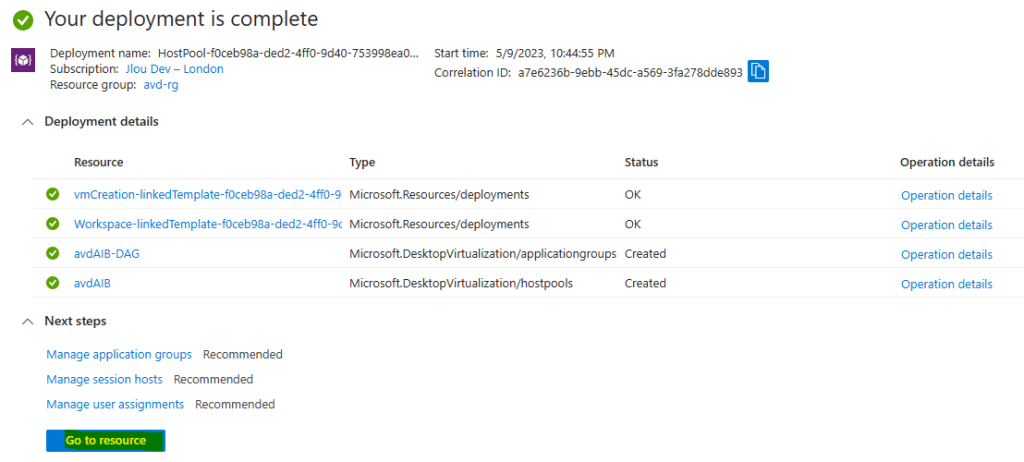

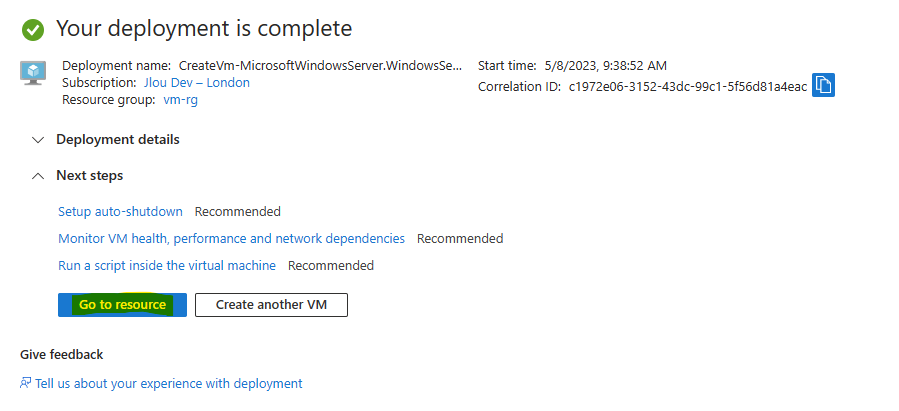

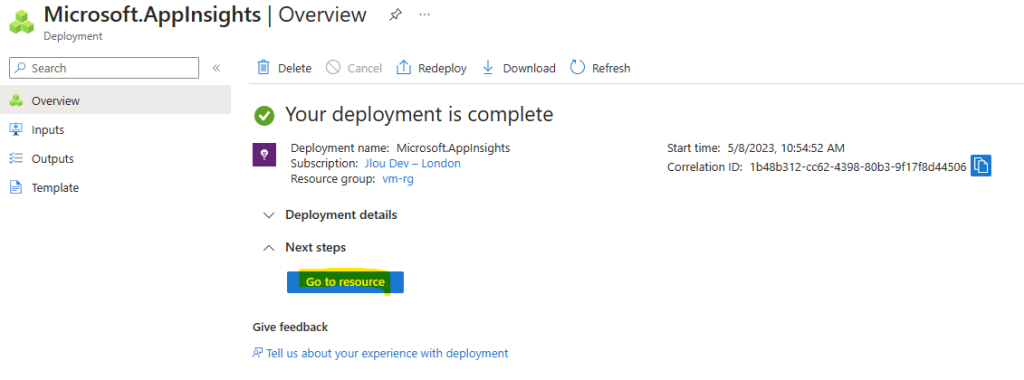

Une fois la validation Azure réussie, lancez la création des ressources de la VM, puis attendez environ 2 minutes :

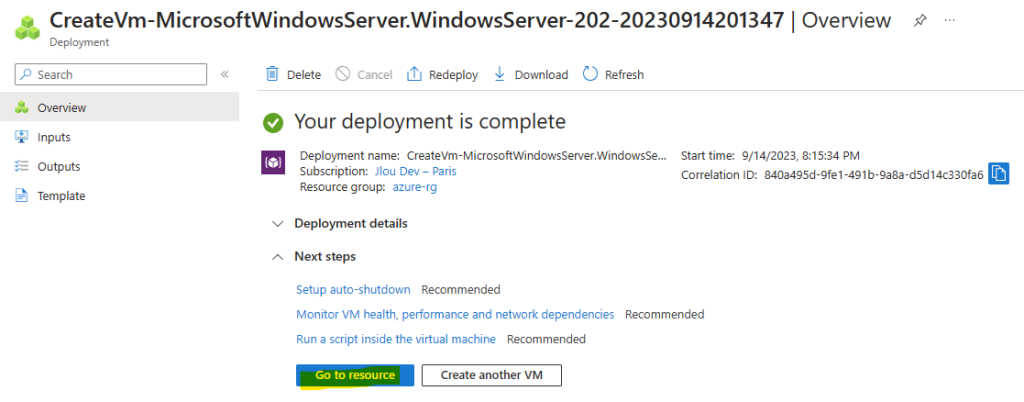

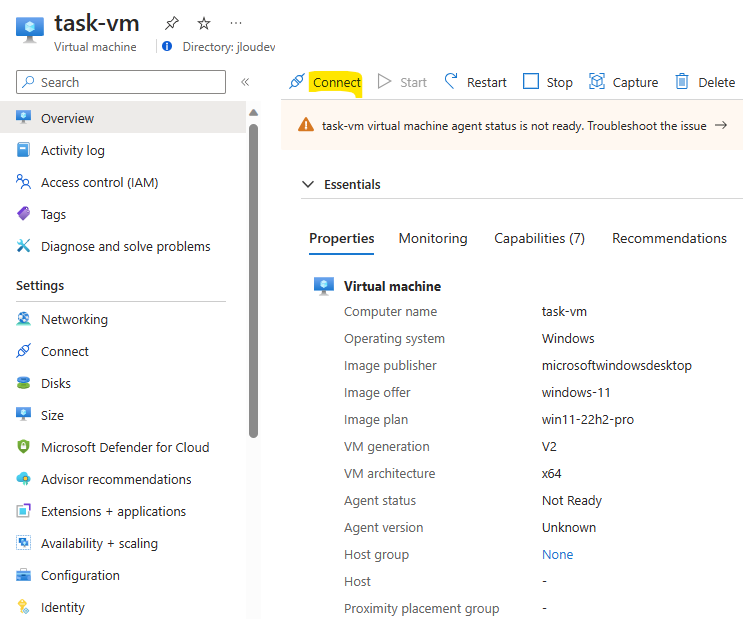

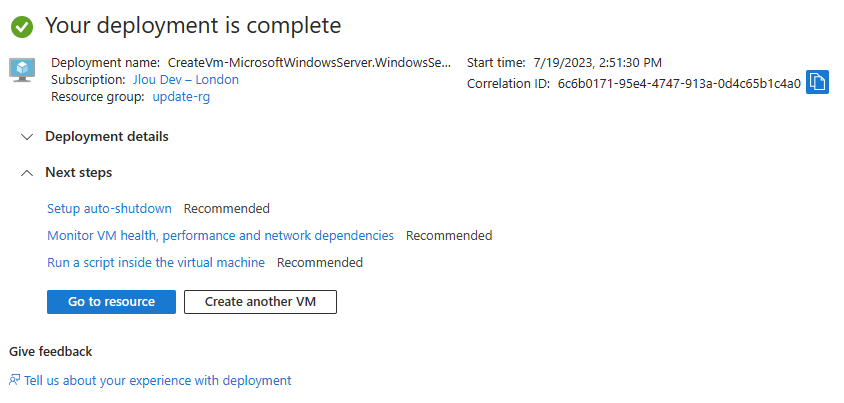

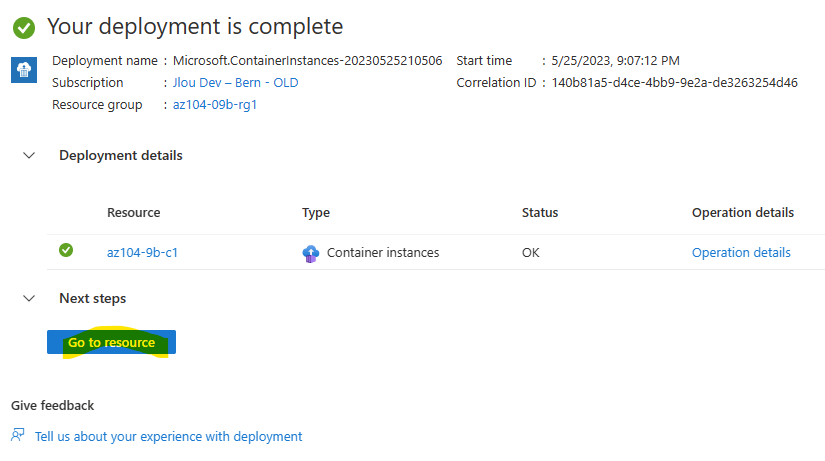

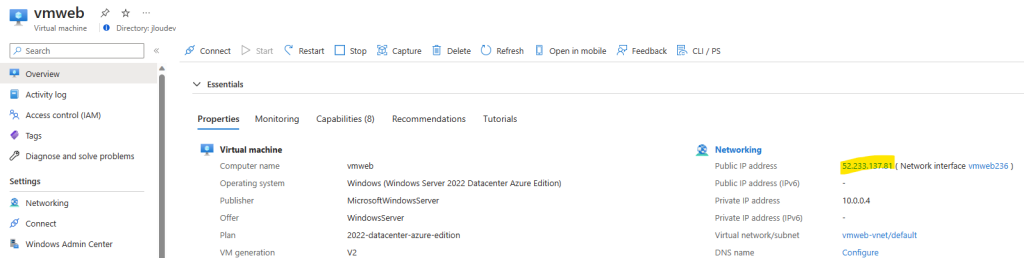

Une fois le déploiement terminé, cliquez-ici pour vous connecter à la VM :

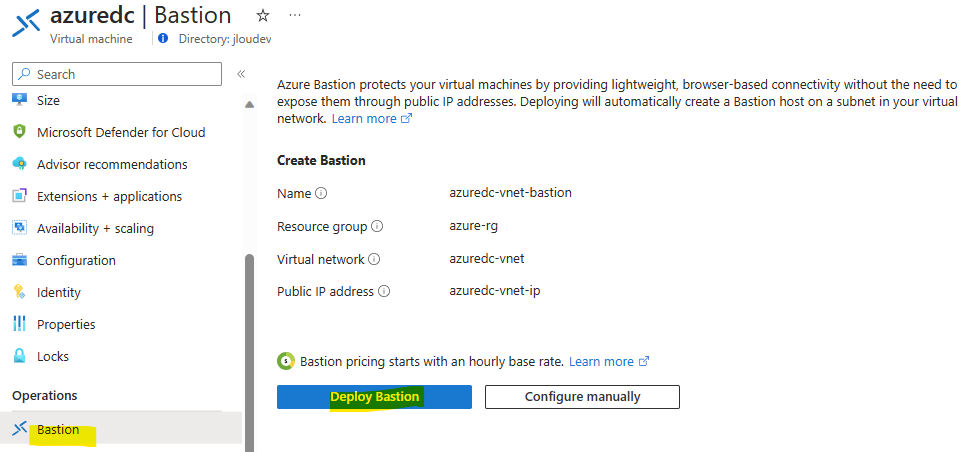

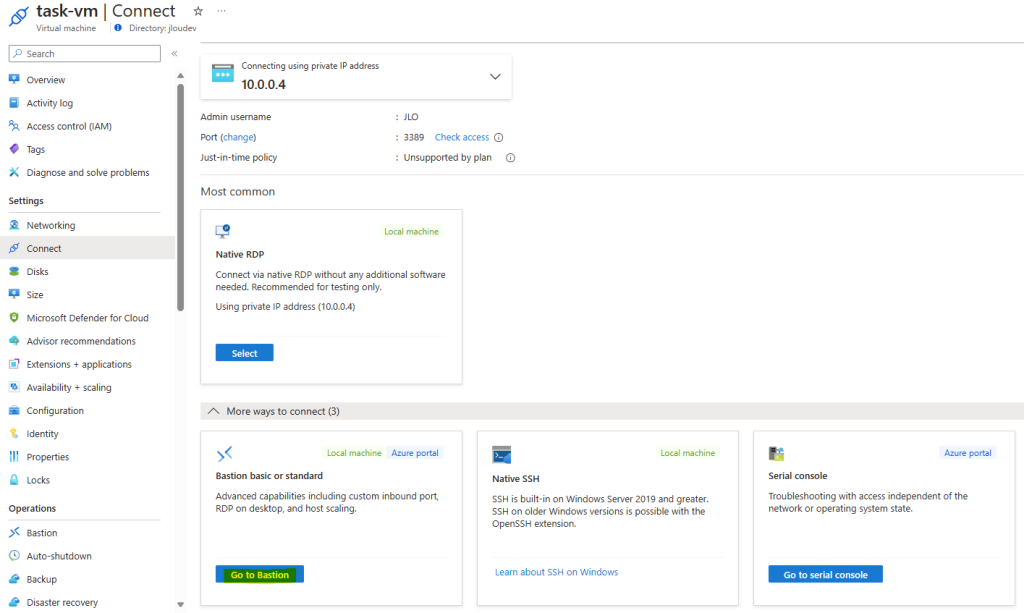

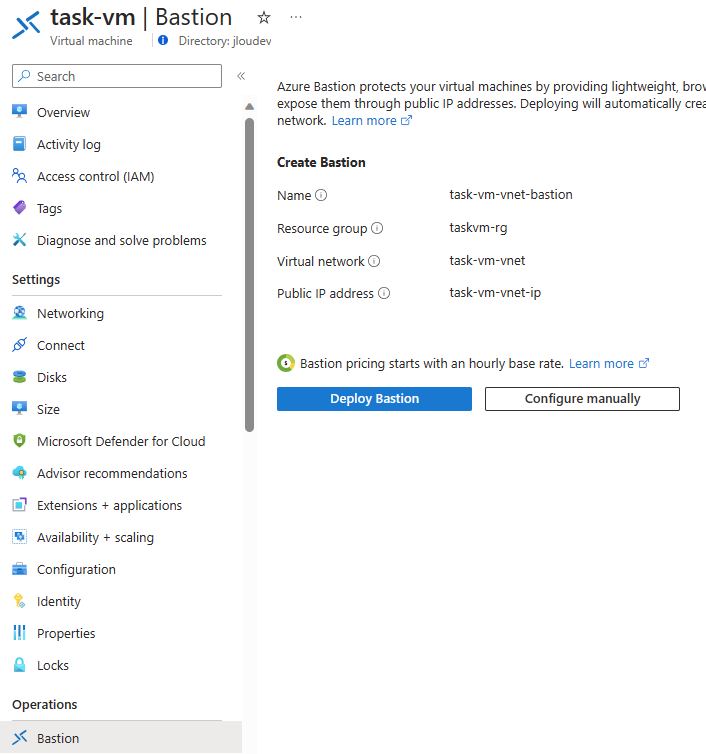

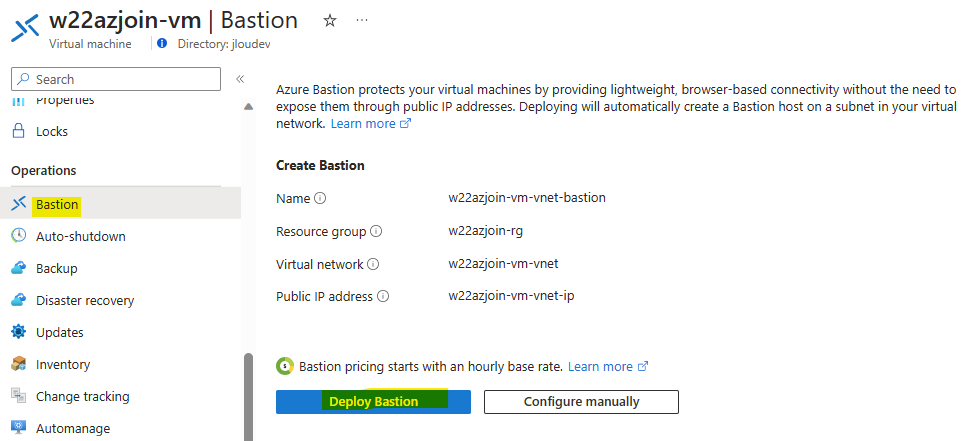

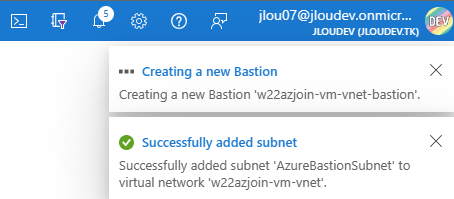

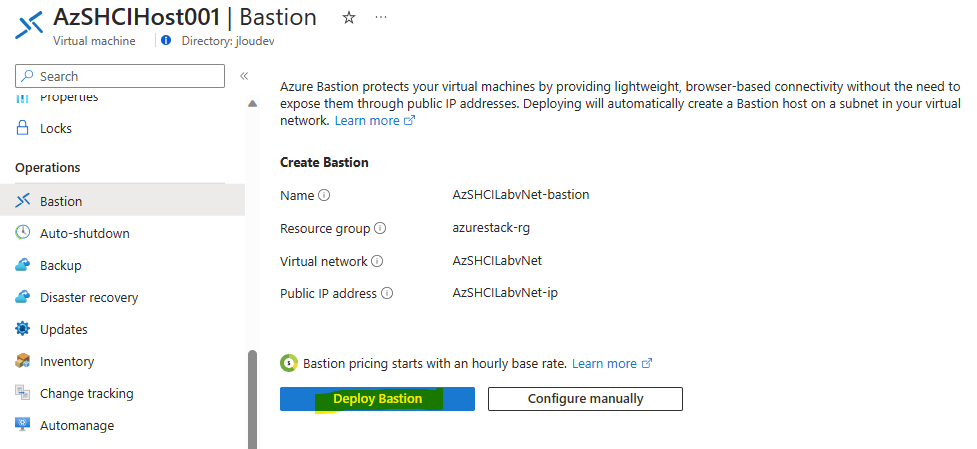

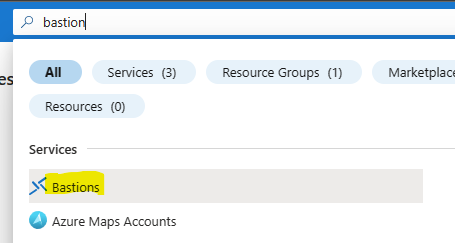

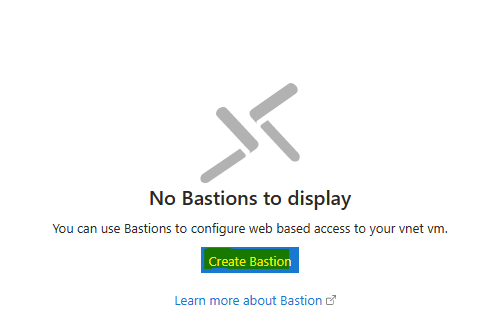

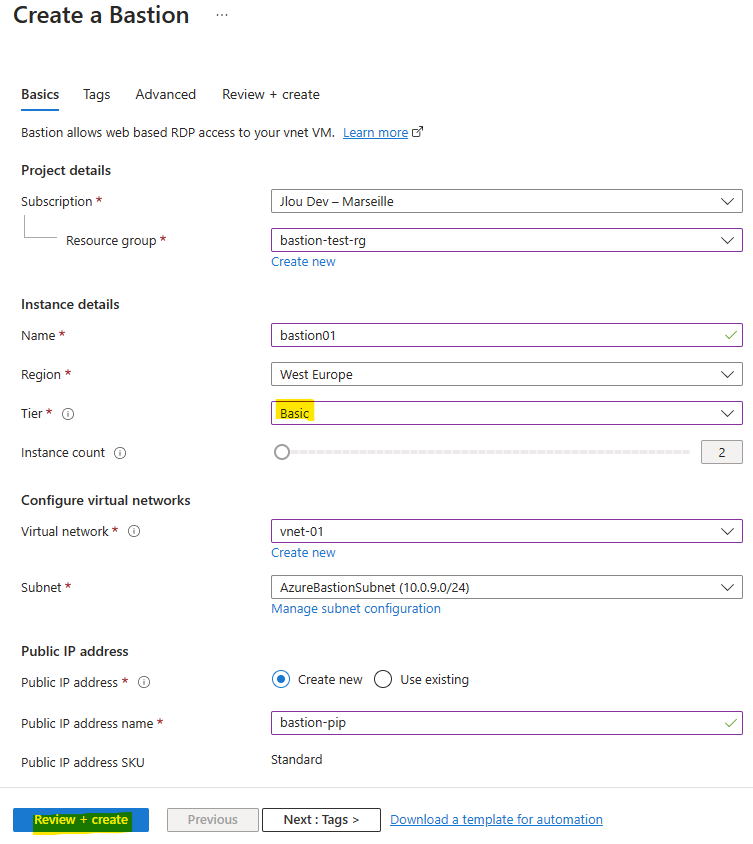

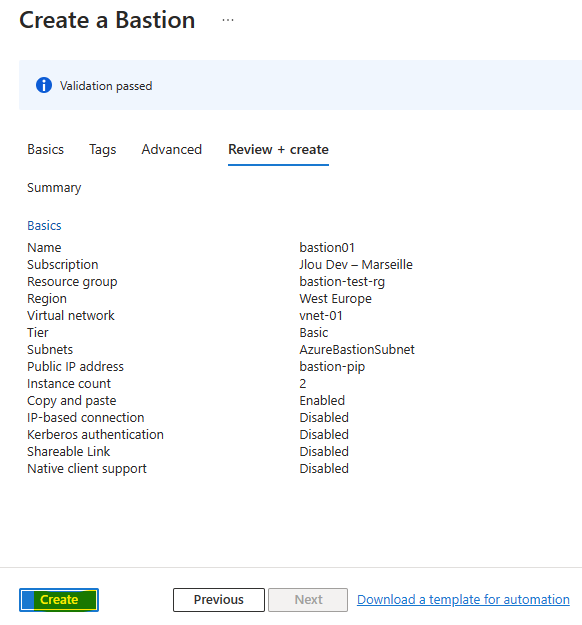

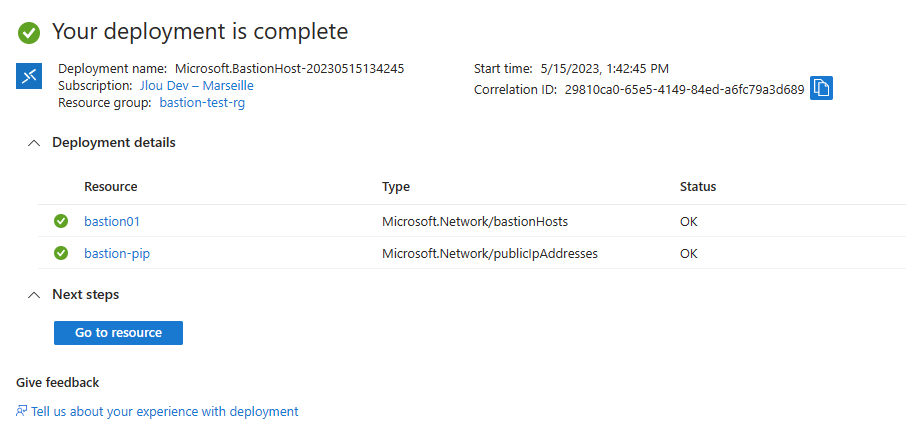

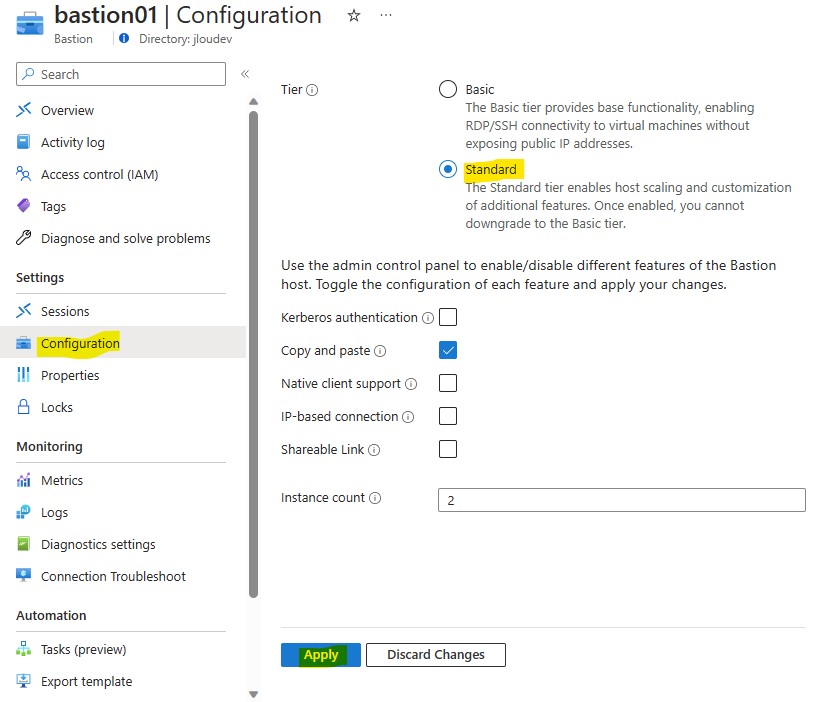

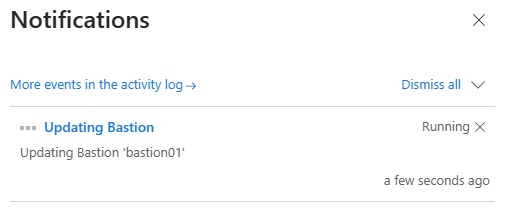

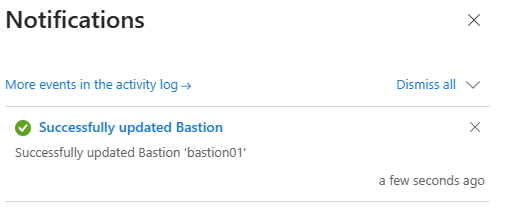

Cliquez sur le bouton suivant pour déployer le service Azure Bastion :

Inutile d’attendre qu’Azure Bastion soit déployé pour continuer cet exercice.

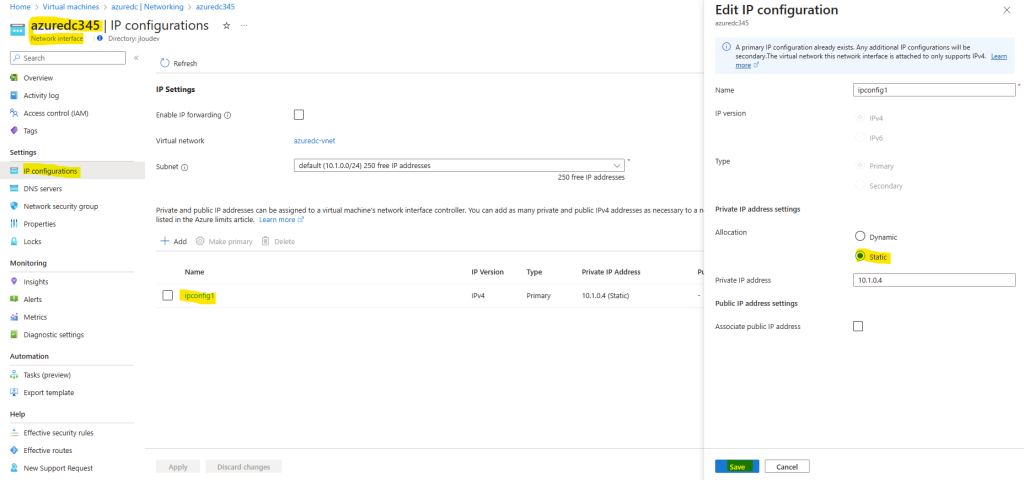

Modifiez l’adresse IP locale de votre machine virtuelle Azure pour la rendre statique :

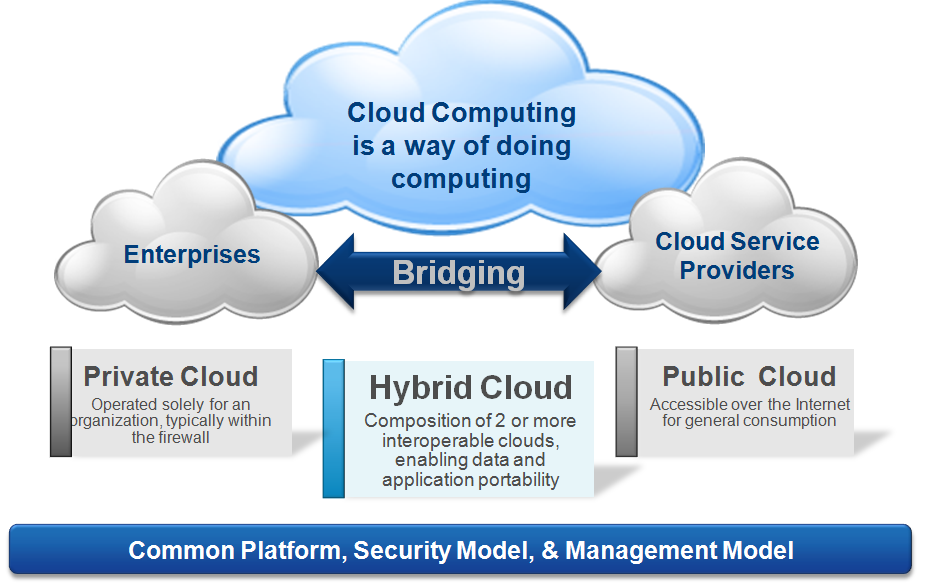

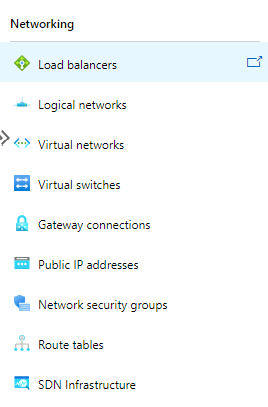

Avant d’aller plus loin, il est nécessaire d’établir une liaison réseau entre les deux environnements Azure <> on-premise (Normalement, notre environnement on-premise ne se trouve pas dans Azure).

Une des options est donc pour nous de construire une liaison VPN en connectant 2 passerelles VPN Azure entre elles.

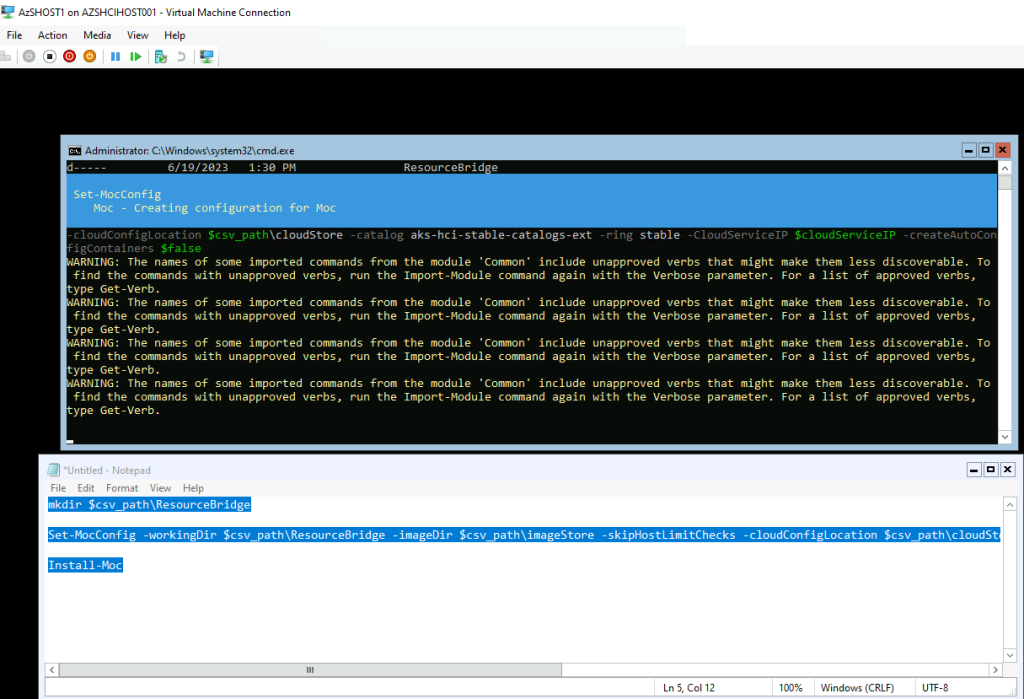

Etape II – Déploiement de la passerelle VPN Azure :

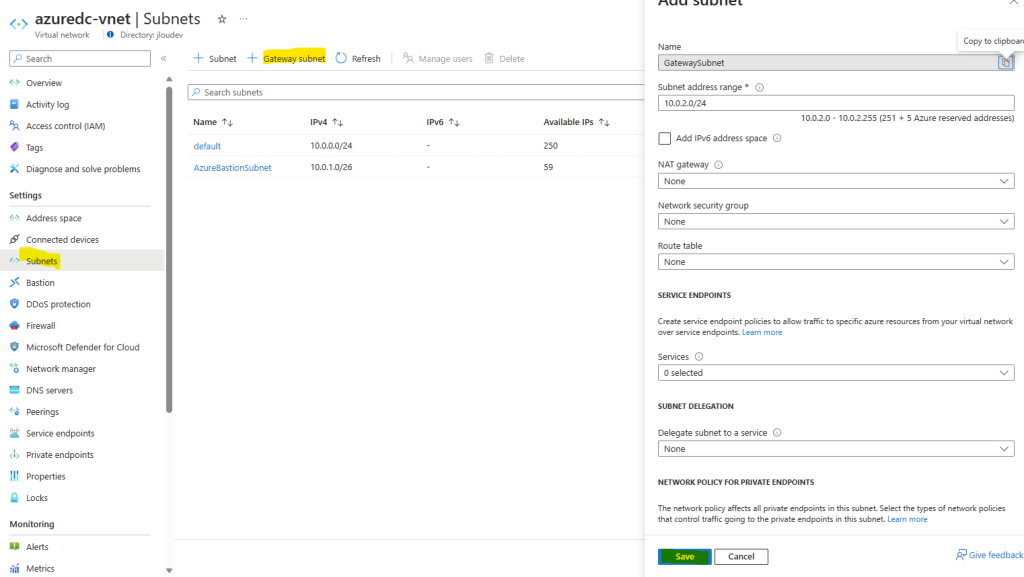

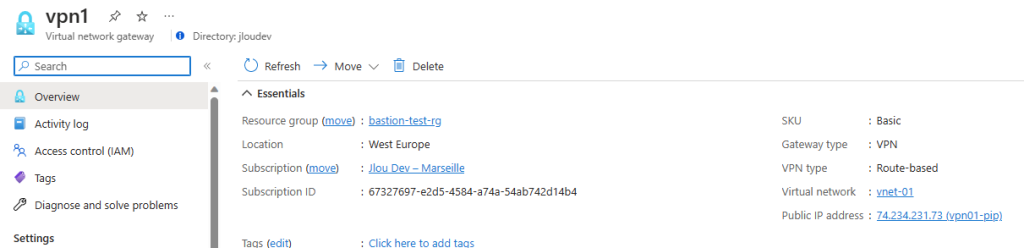

Pour cela, il est nécessaire de commencer par la création d’une nouvelle passerelle VPN dans notre réseau virtuel Azure.

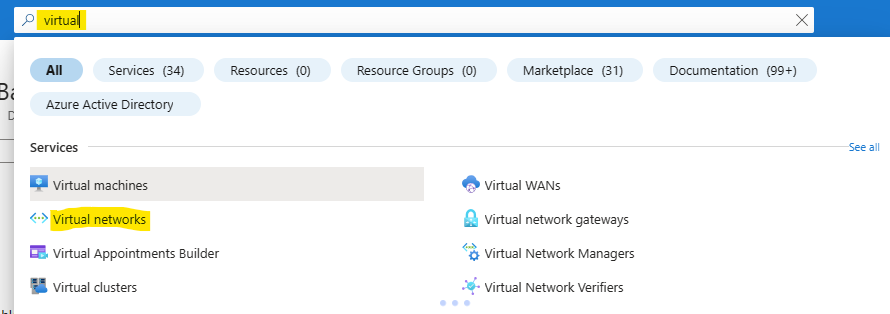

Pour cela, utilisez la barre de recherche :

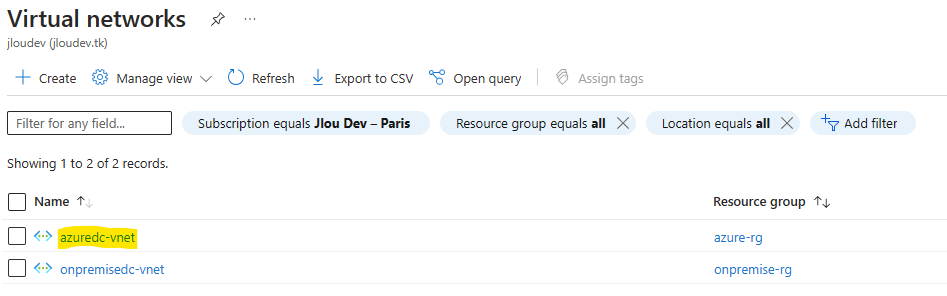

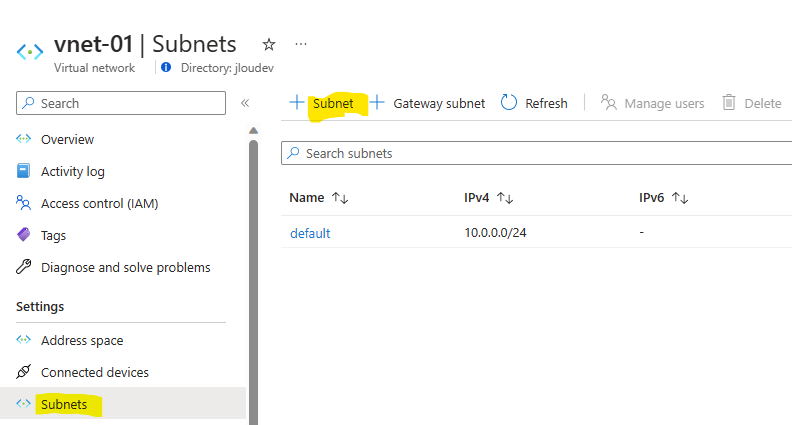

Cliquez sur le réseau virtuel créé lors de la création de la VM DC2022 d’Azure :

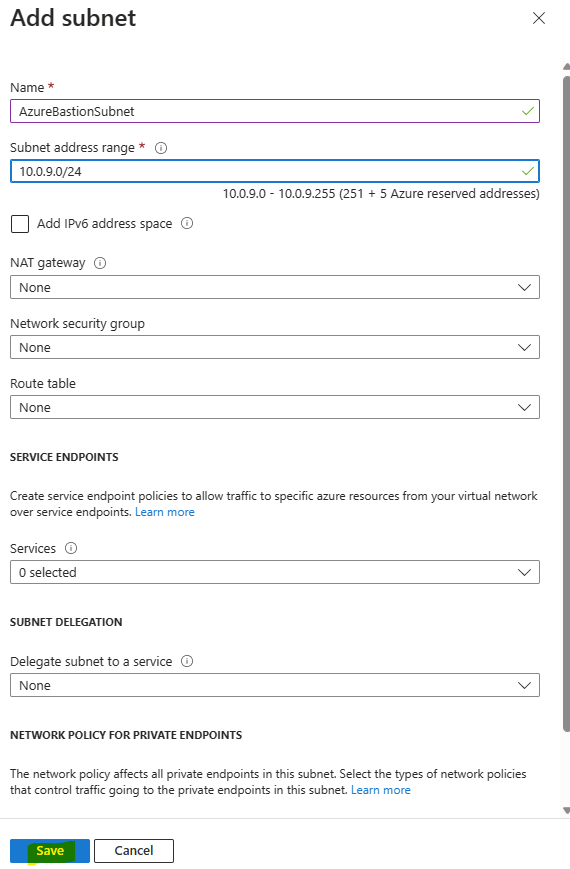

Ajoutez un sous-réseau dédié à la passerelle VPN comme ceci :

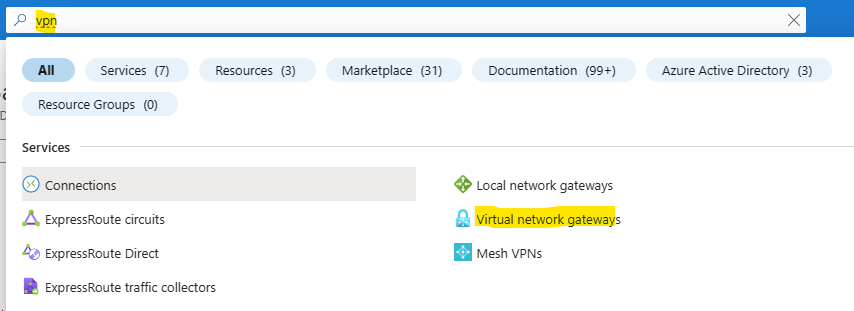

Pour créer une passerelle VPN, utilisez à nouveau la barre de recherche :

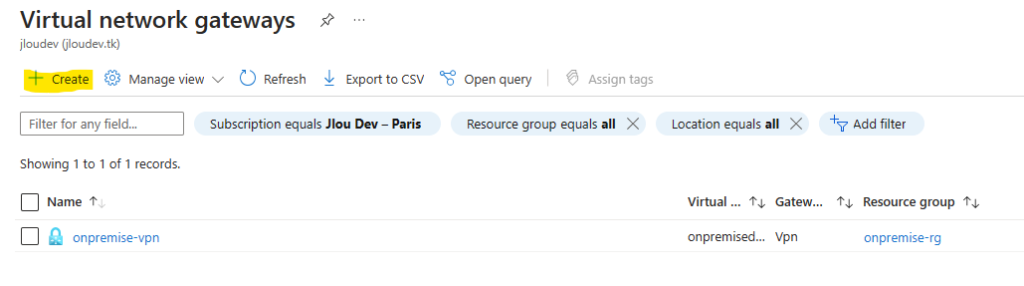

Cliquez ici pour créer la seconde passerelle que nous connecterons par la suite à la première (on-premise) :

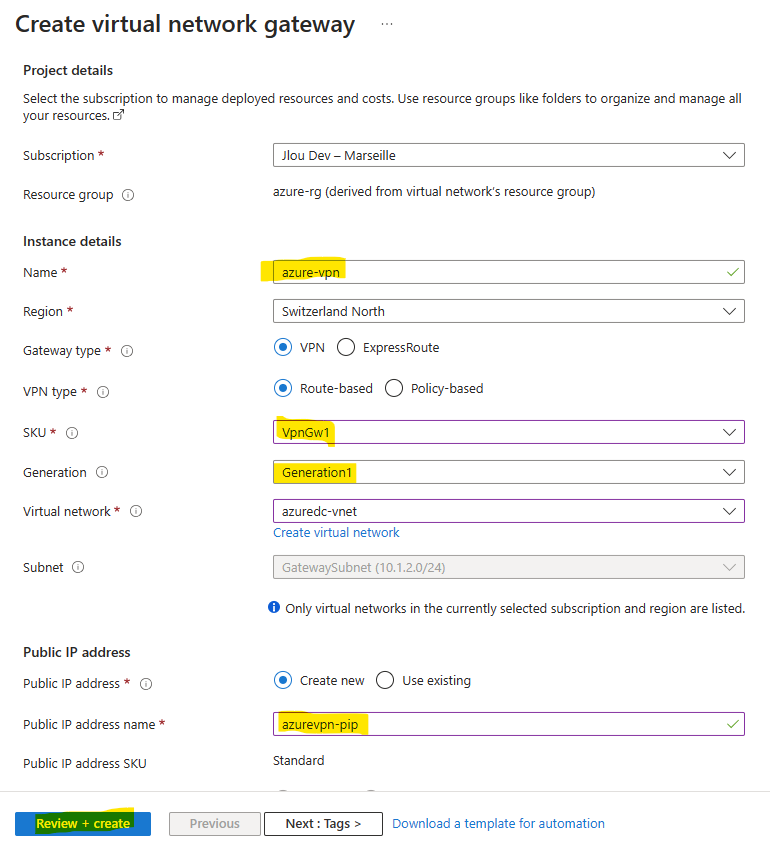

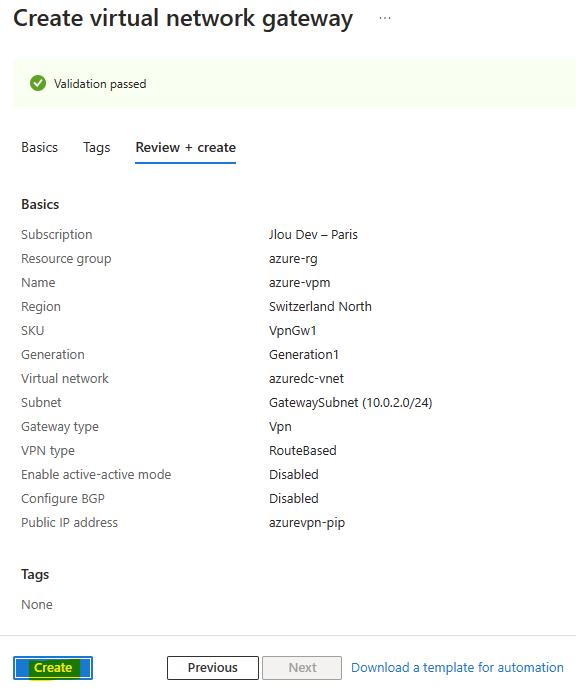

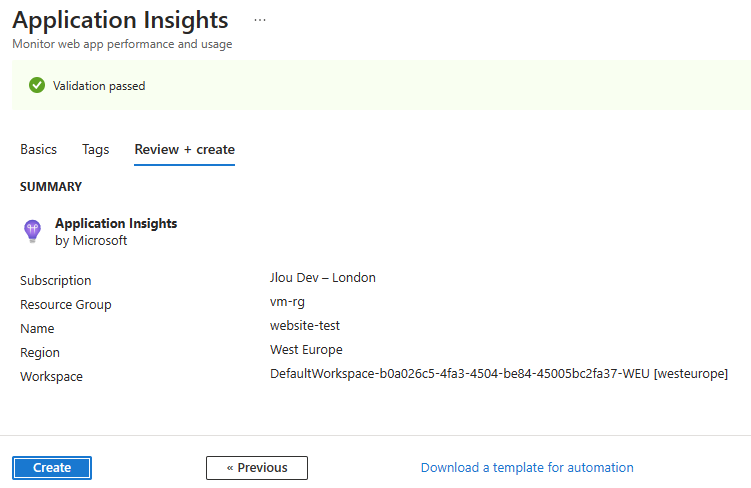

Renseignez les informations de base relatives à votre Passerelle VPN, puis lancez la validation Azure :

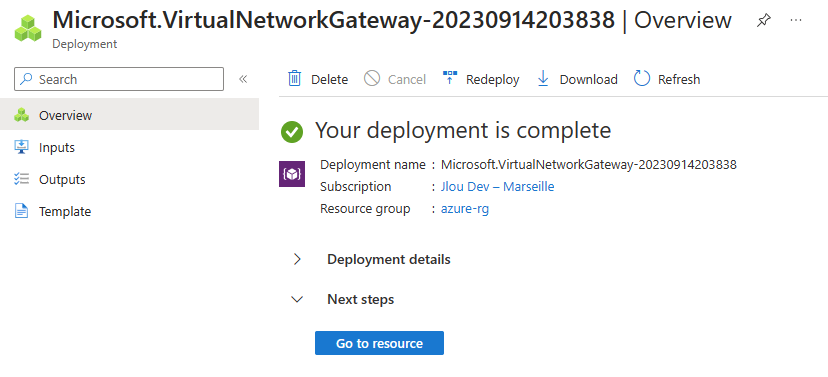

Une fois la validation Azure réussie, lancez la création des ressources :

Attendez environ 15-45 minutes :

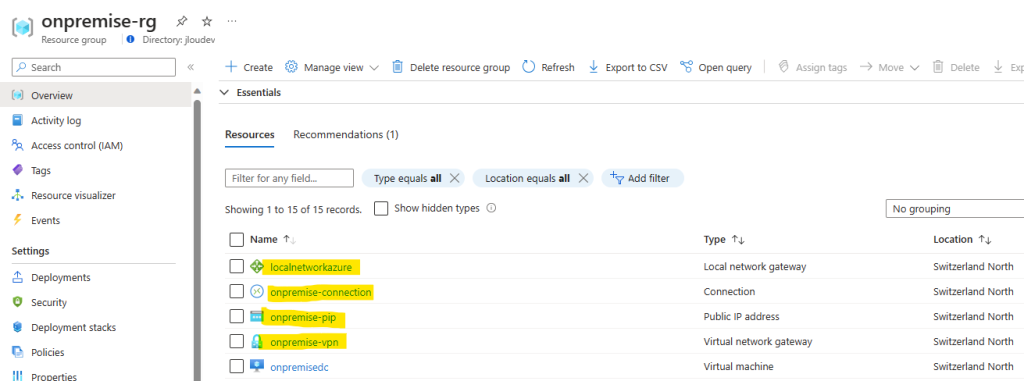

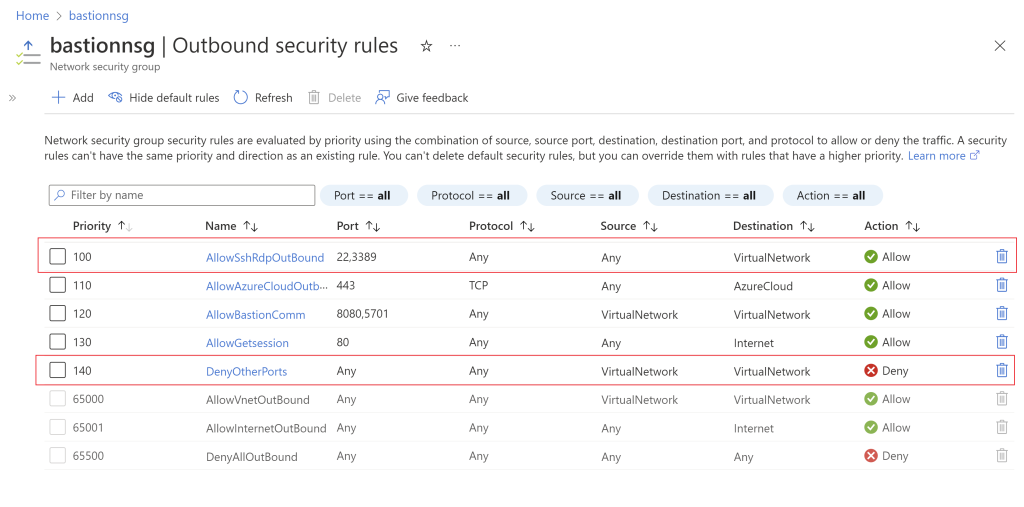

Afin de connecter les deux Passerelles VPNs Azure entre eux, nous avons besoin d’avoir :

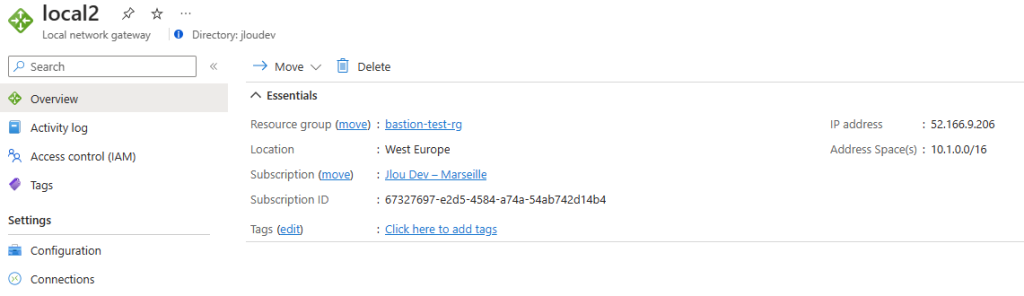

- deux passerelles de réseau local

- deux connexions VPNs

Dans mon cas, la ressources VPNs côté on-premise sont déjà présentes :

Il ne me reste donc qu’à déployer les 2 ressources VPNs suivantes sur mon réseau Azure :

- Passerelle de réseau local

- Connexion VPN

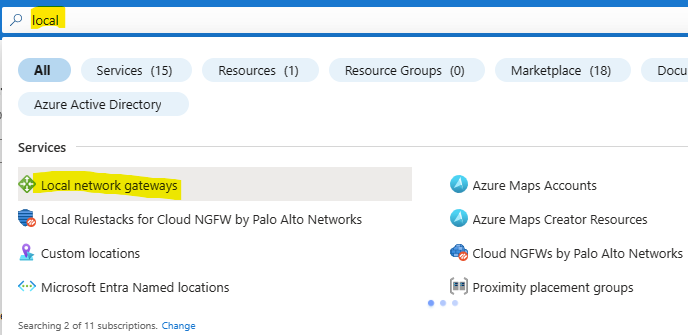

Pour créer cela, utilisez encore une fois la barre de recherche Azure :

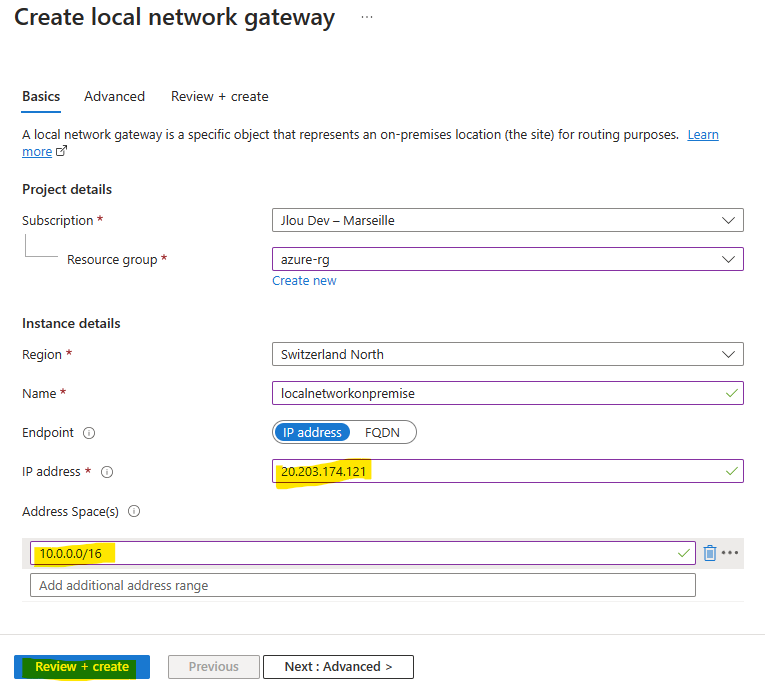

Configurer la passerelle de réseau local dans l’environnement Azure, mais indiquez l’adresse IP publique du VPN on-premise, puis lancez la validation :

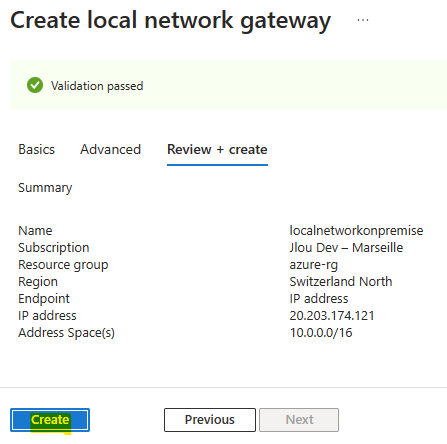

Une fois la validation Azure réussie, lancez la création de la ressource :

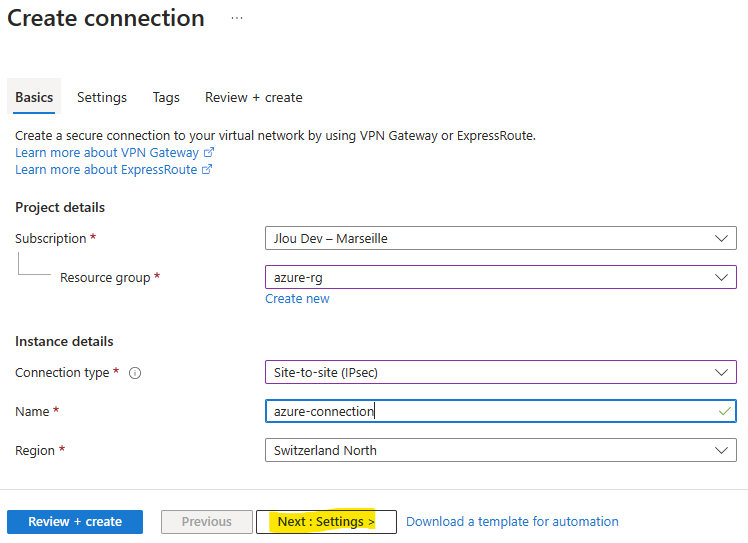

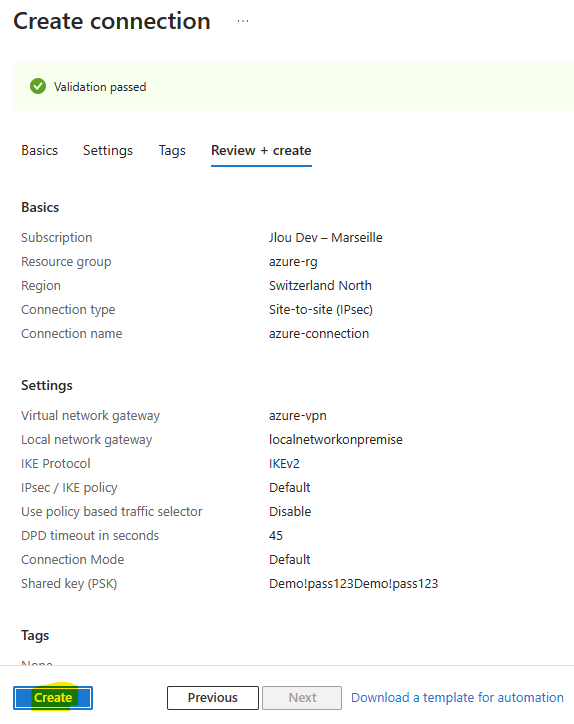

Continuez en créant la connection entre le VPN Azure et la passerelle de réseau local on-premise, puis cliquez sur Suivant :

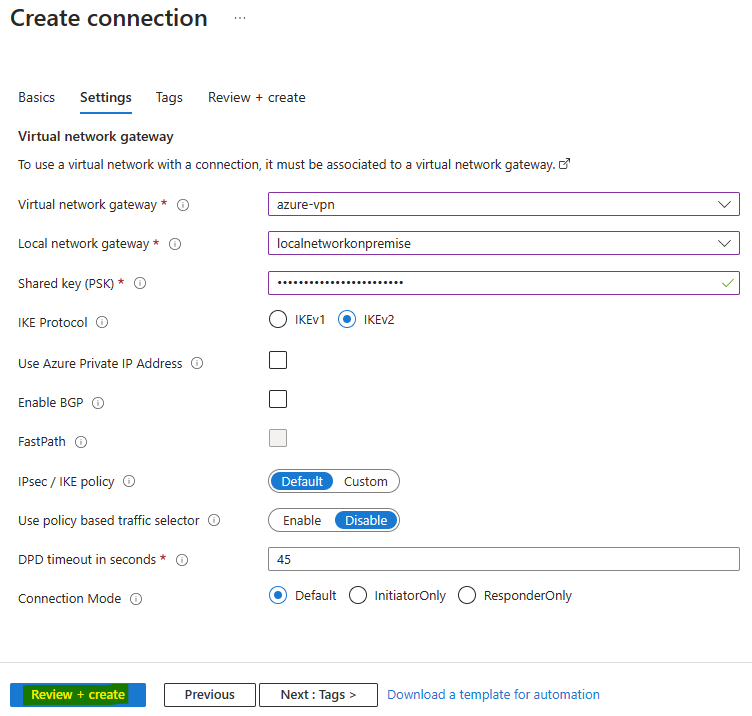

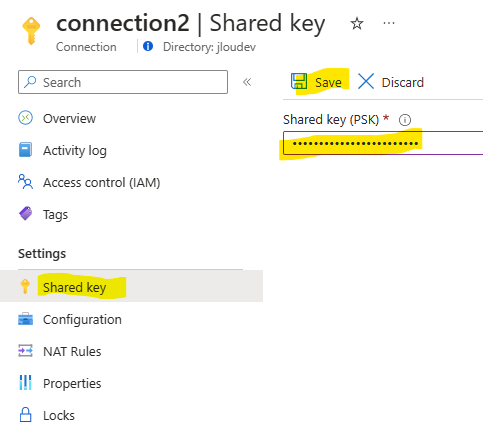

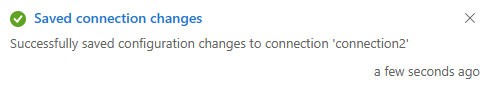

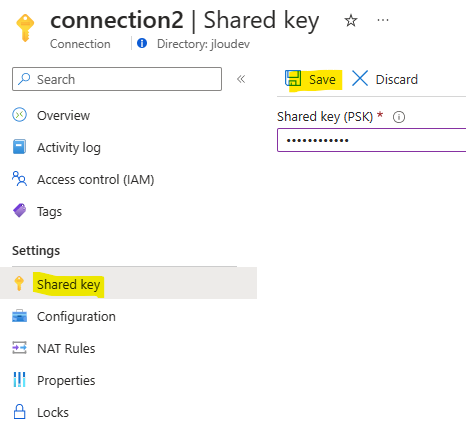

Définissez une clef partagée, puis lancez la validation Azure :

Une fois la validation Azure réussie, lancez la création de la ressource :

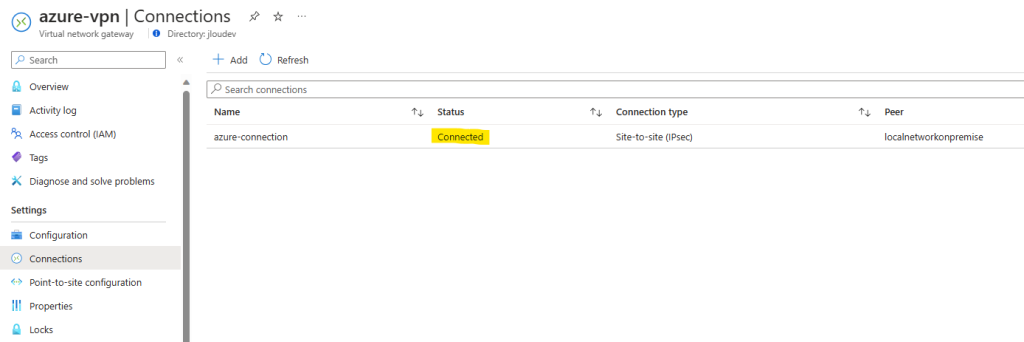

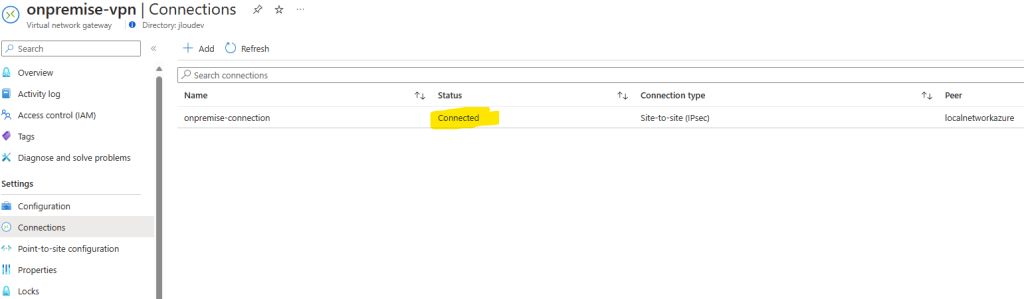

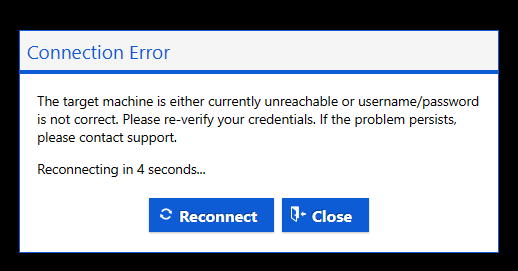

Attendez environ 5 minutes afin de constater un changement dans le statut de la connexion VPN.

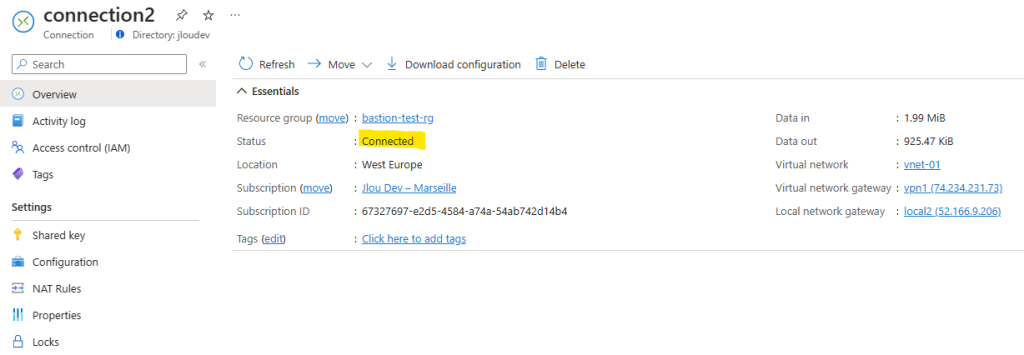

Le statut de la connexion change bien sur le passerelle VPN Azure :

Le statut de la connexion change également sur le passerelle VPN on-premise :

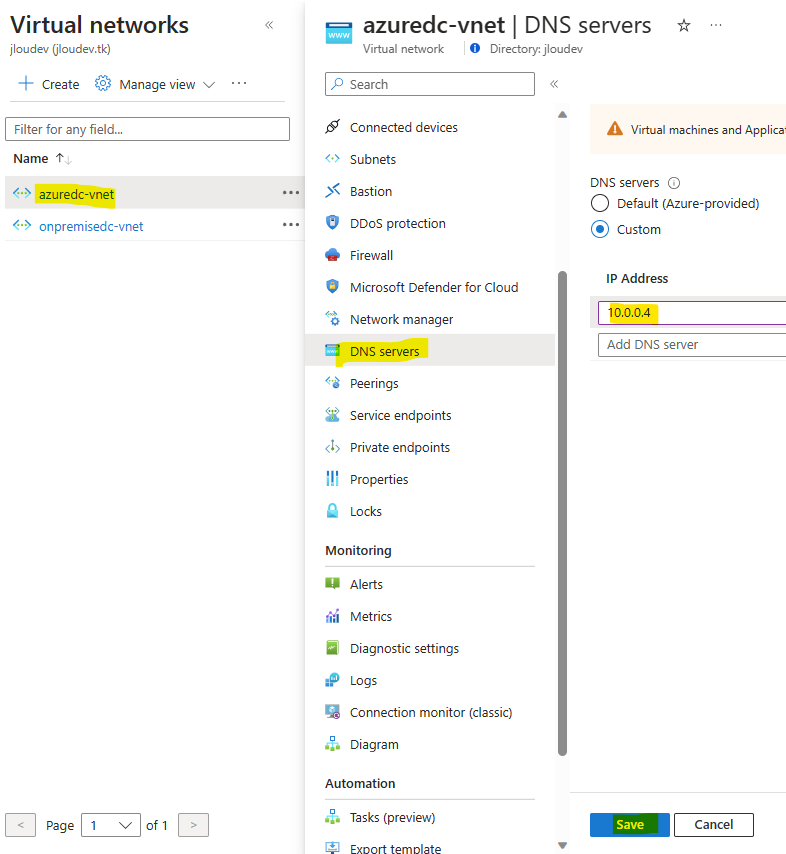

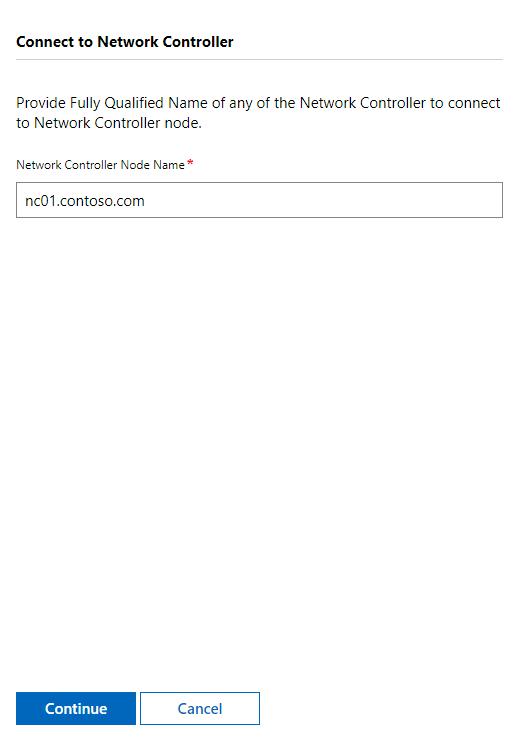

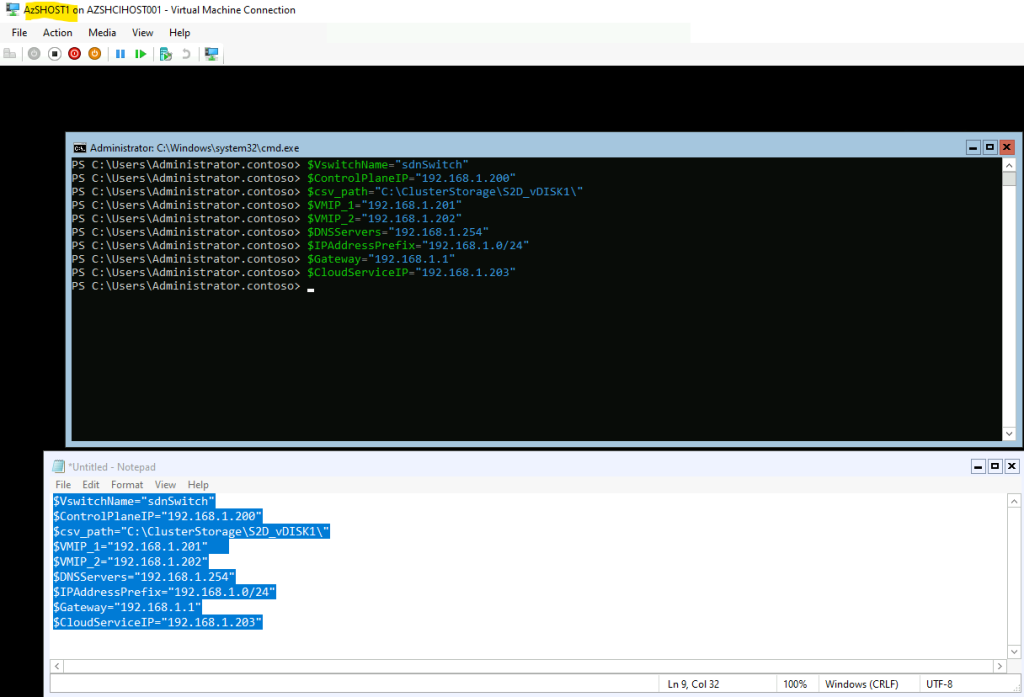

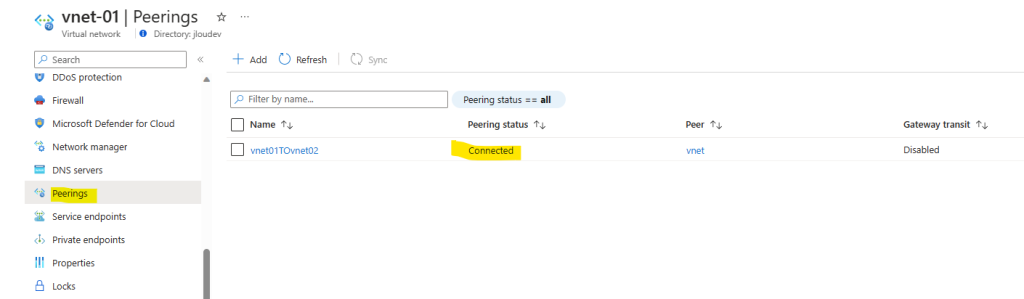

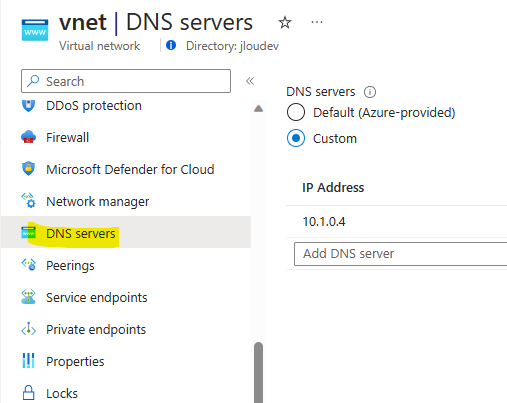

Afin que la nouvelle machine virtuelle DC2012 d’Azure se connecte à l’Active Directory on-premise DC2012R2, configurez le DNS de votre réseau Azure pour qu’il pointe sur l’adresse IP de votre AD on-premise, puis cliquer sur Sauvegarder :

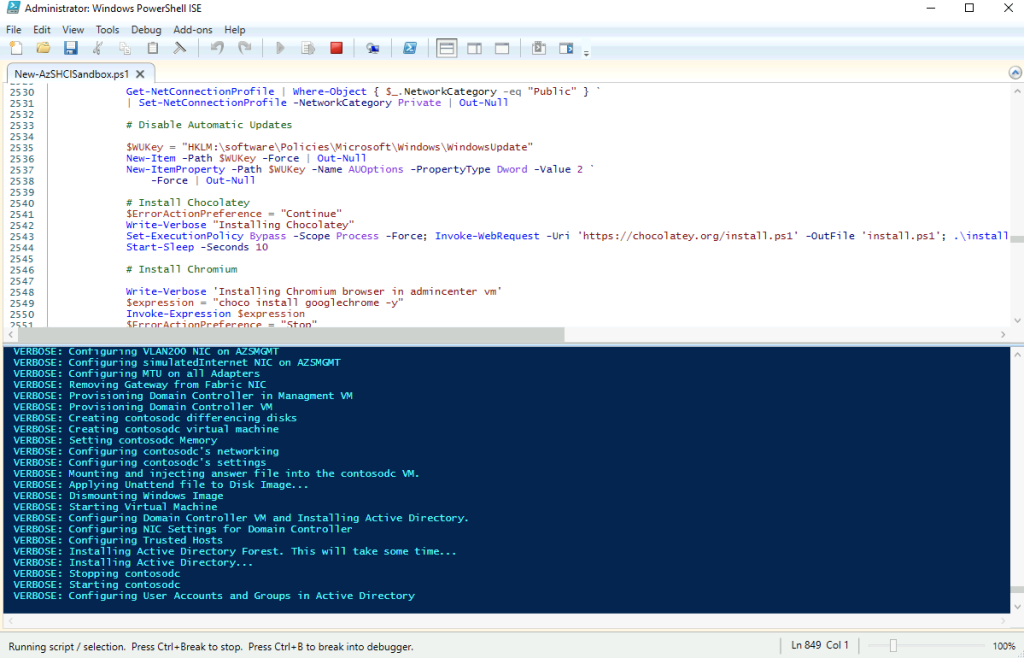

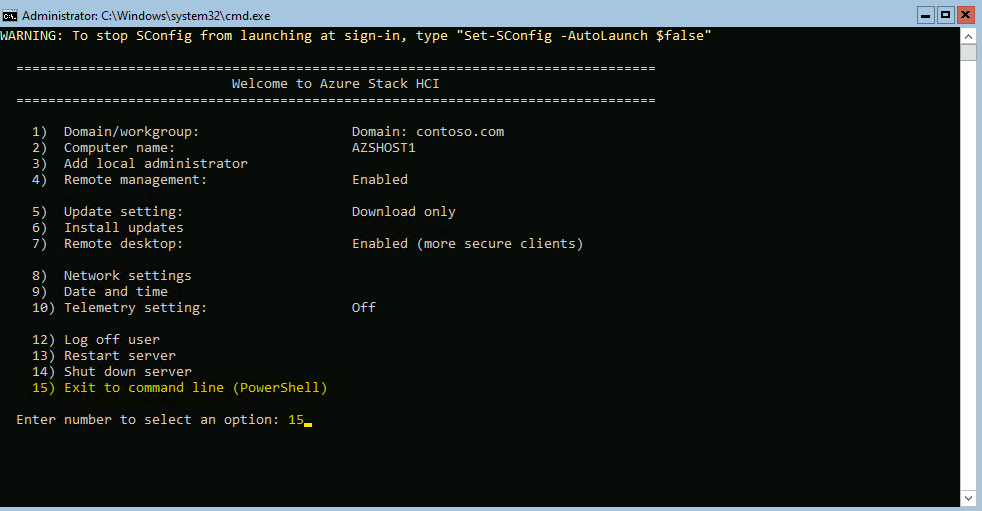

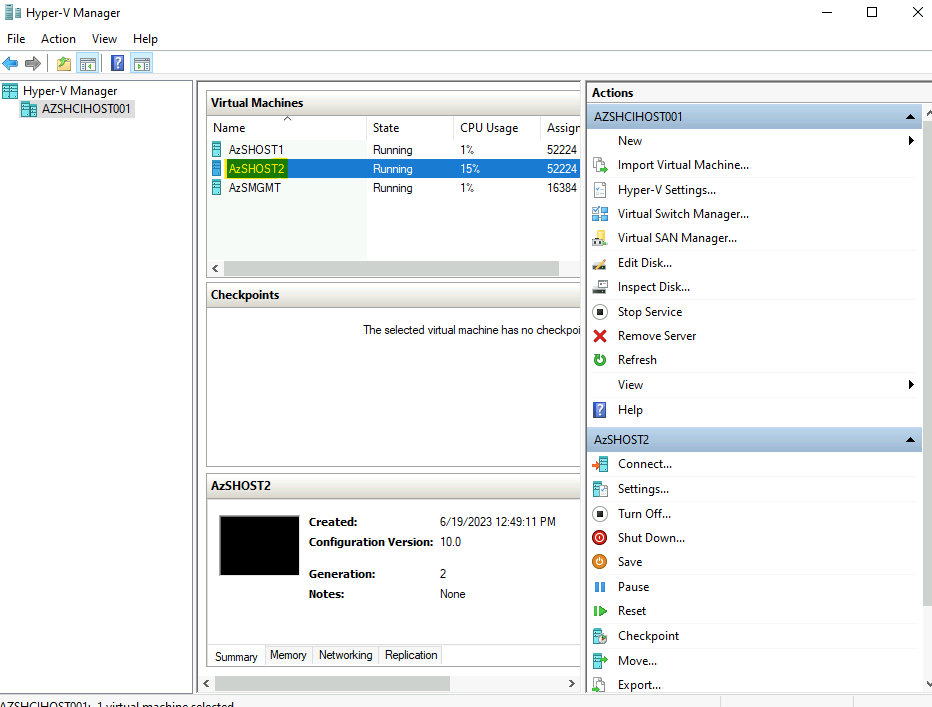

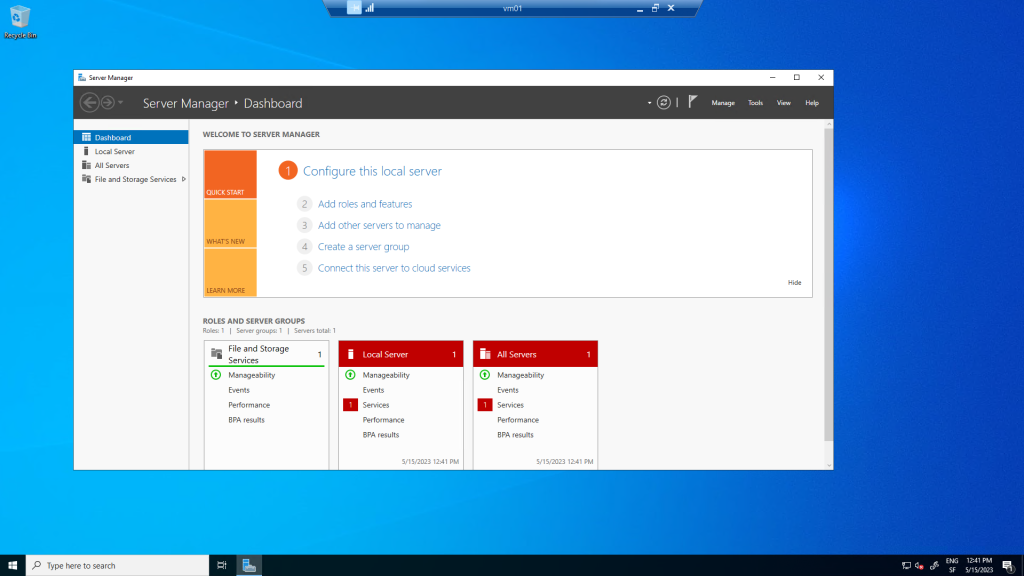

Notre environnement Azure est maintenant prêt pour configurer l’Active Directory. Pour cela, nous devons d’abord joindre votre machine virtuelle DC2022 au domaine on-premise, puis la promouvoir en tant que contrôleur de domaine.

Etape III – Ajout du second contrôleur de domaine Azure :

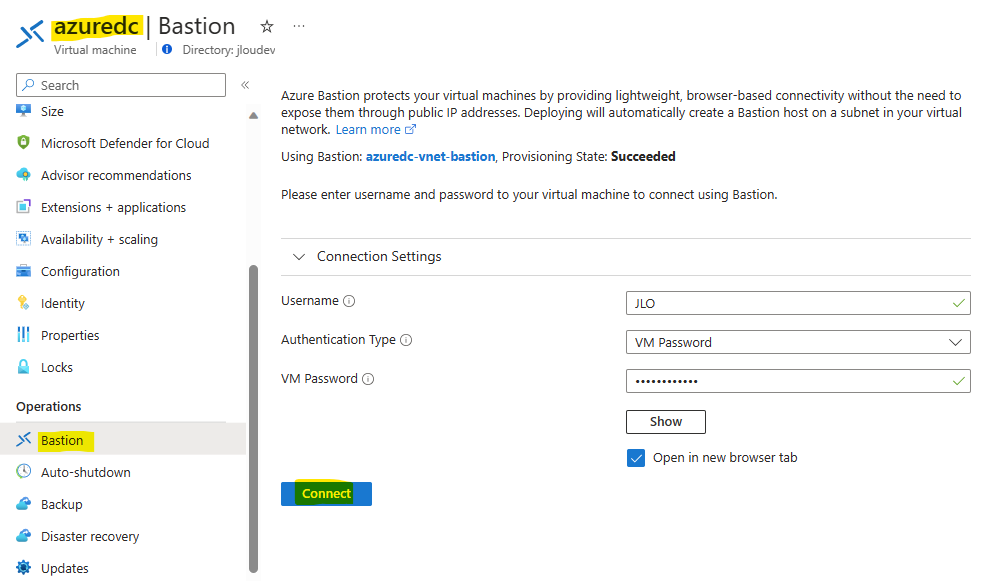

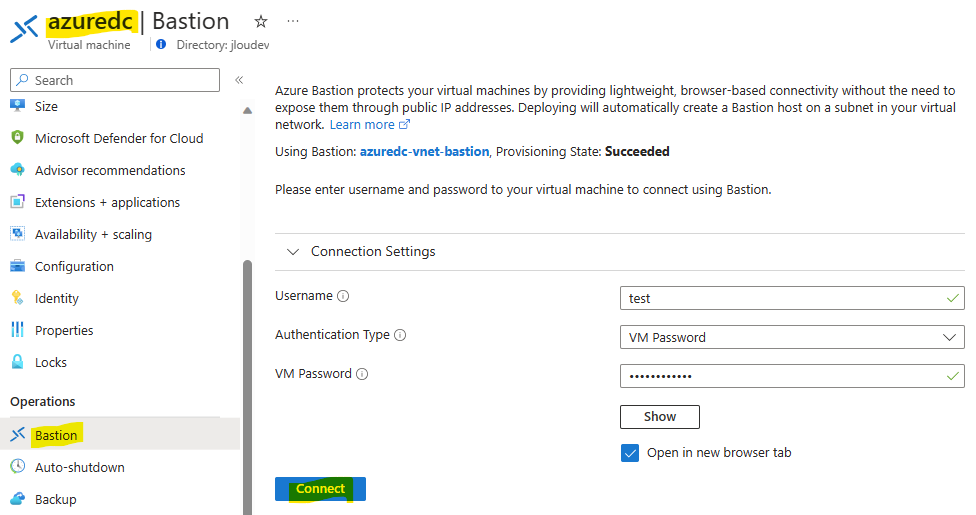

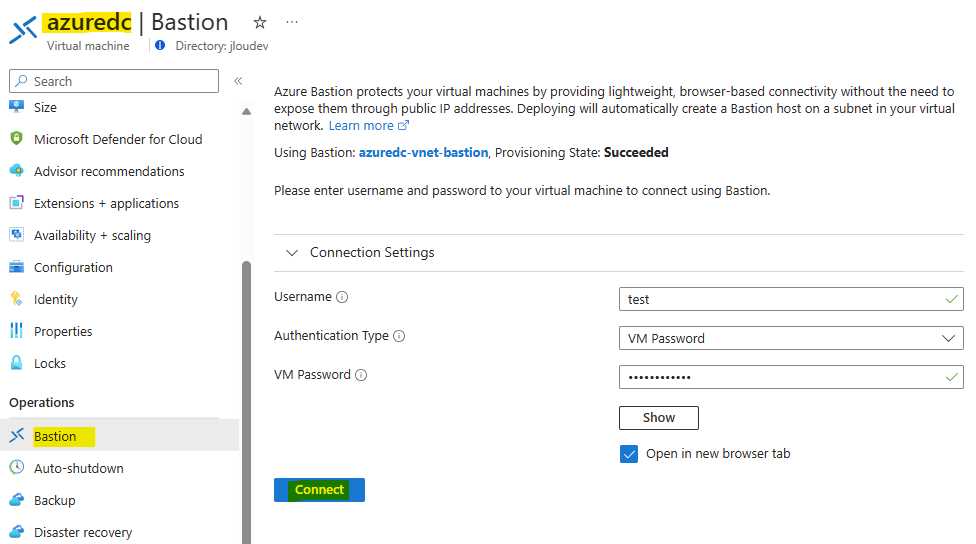

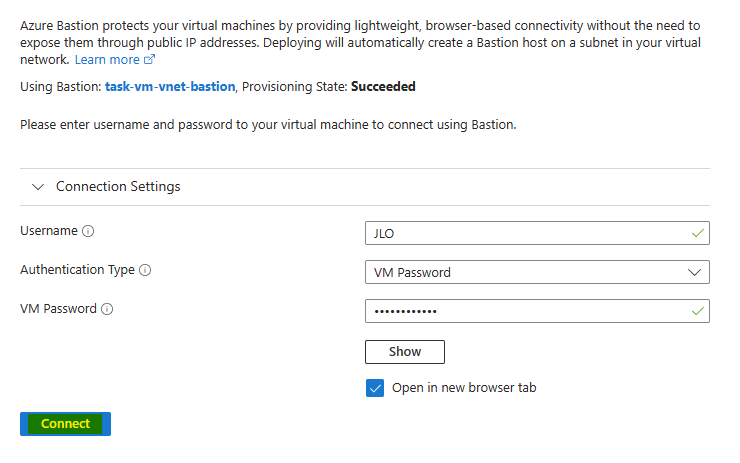

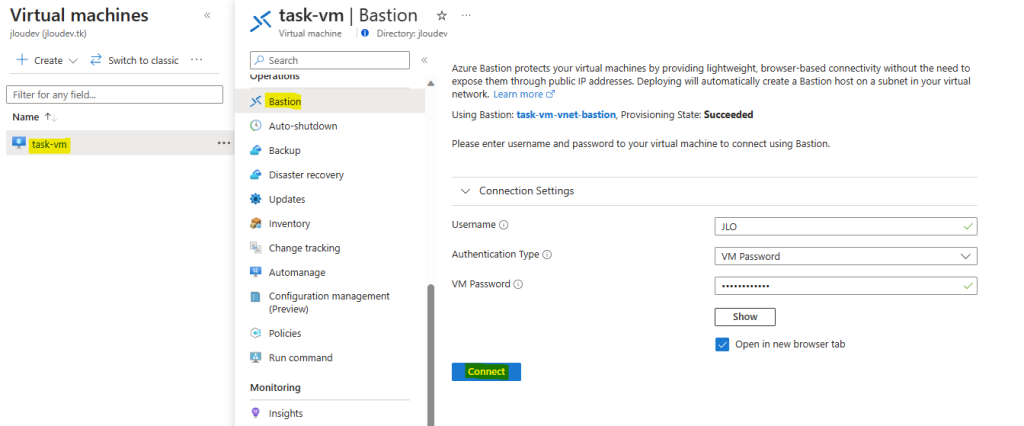

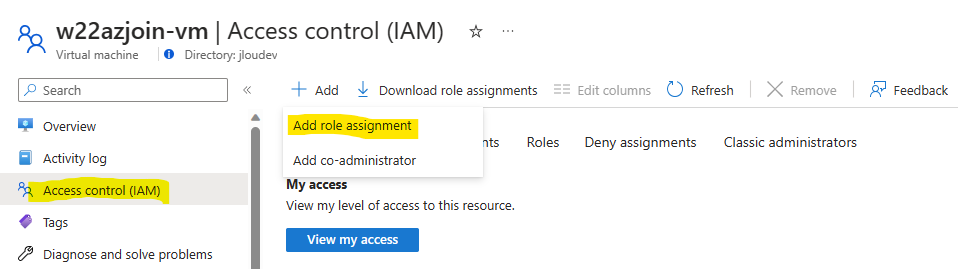

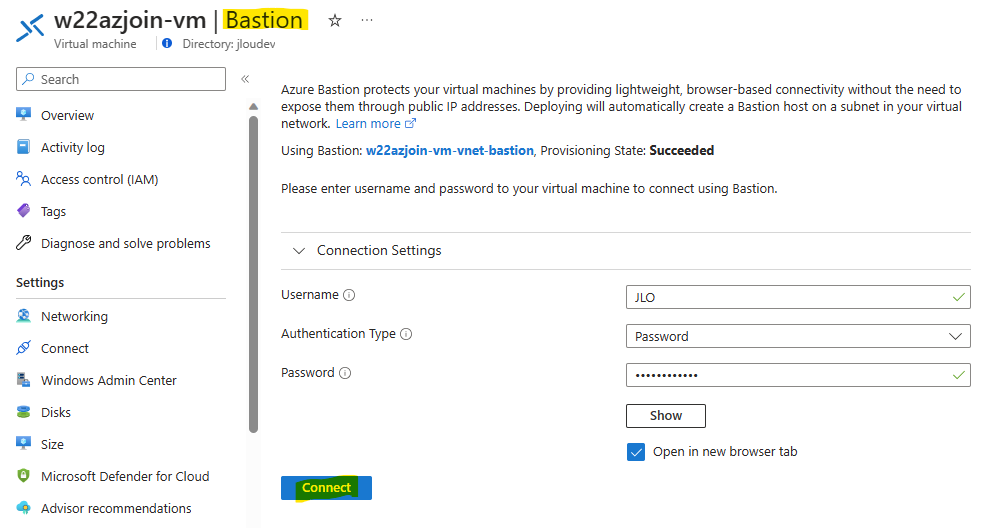

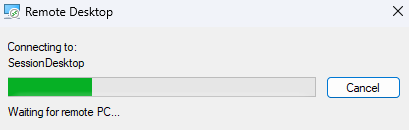

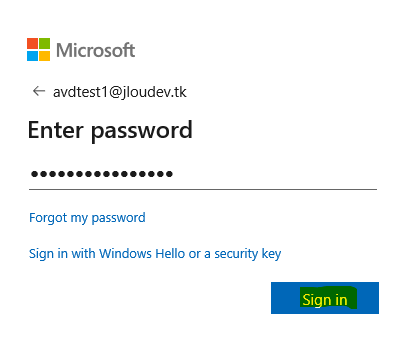

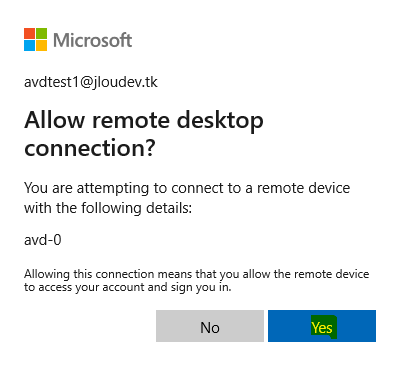

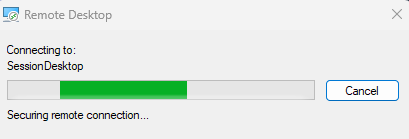

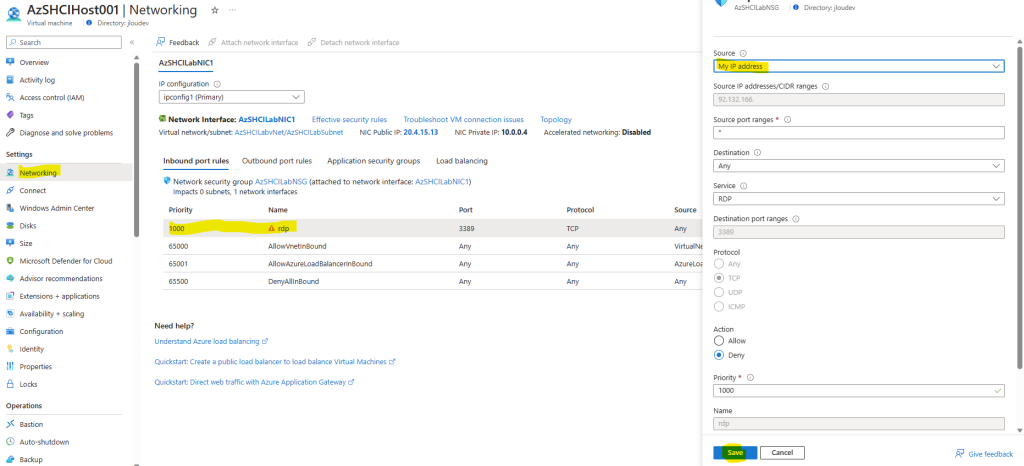

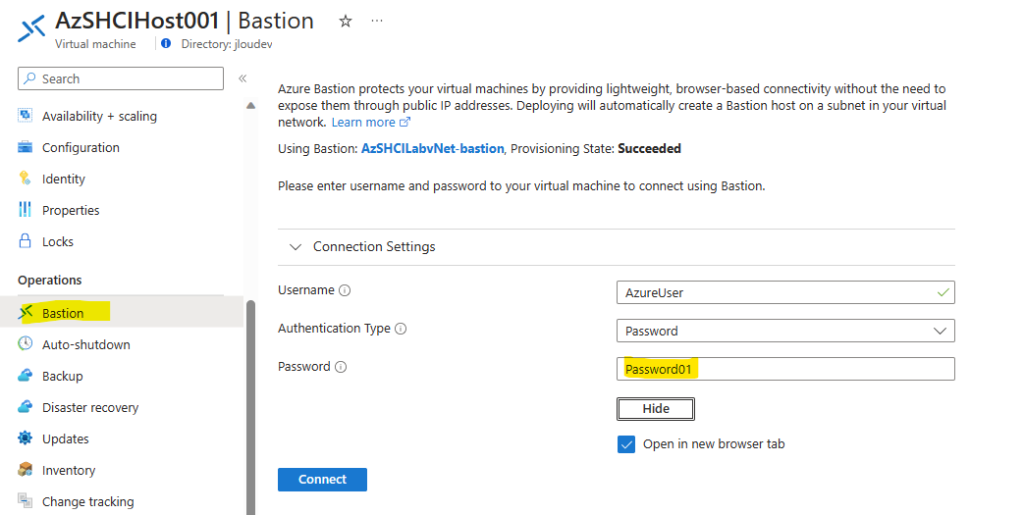

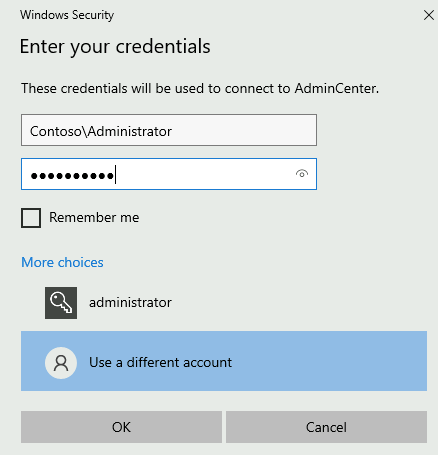

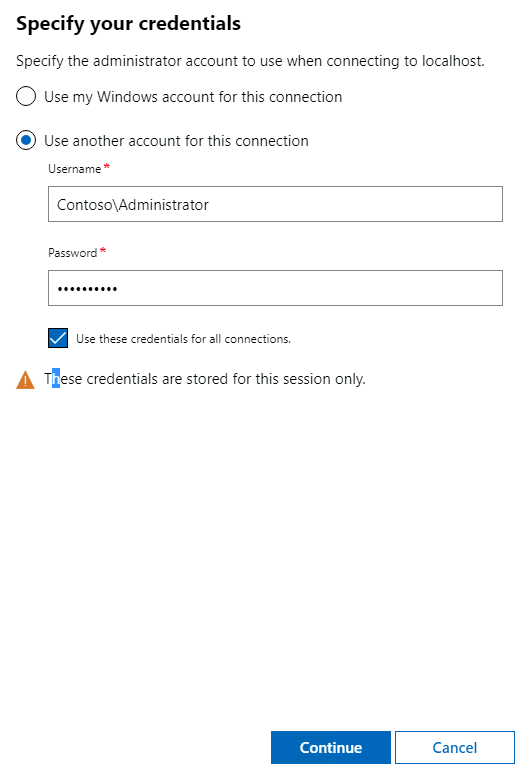

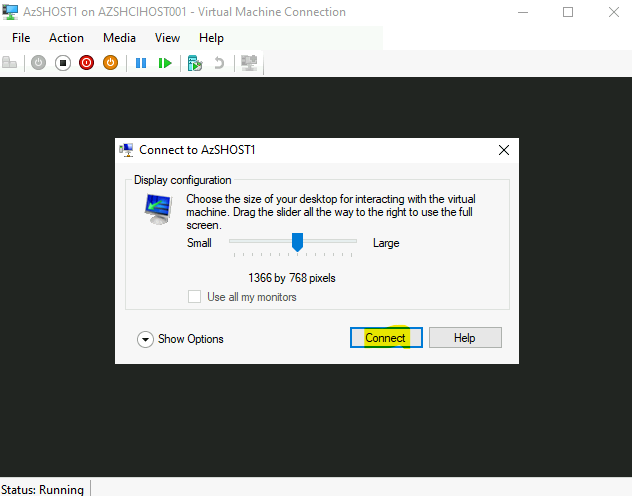

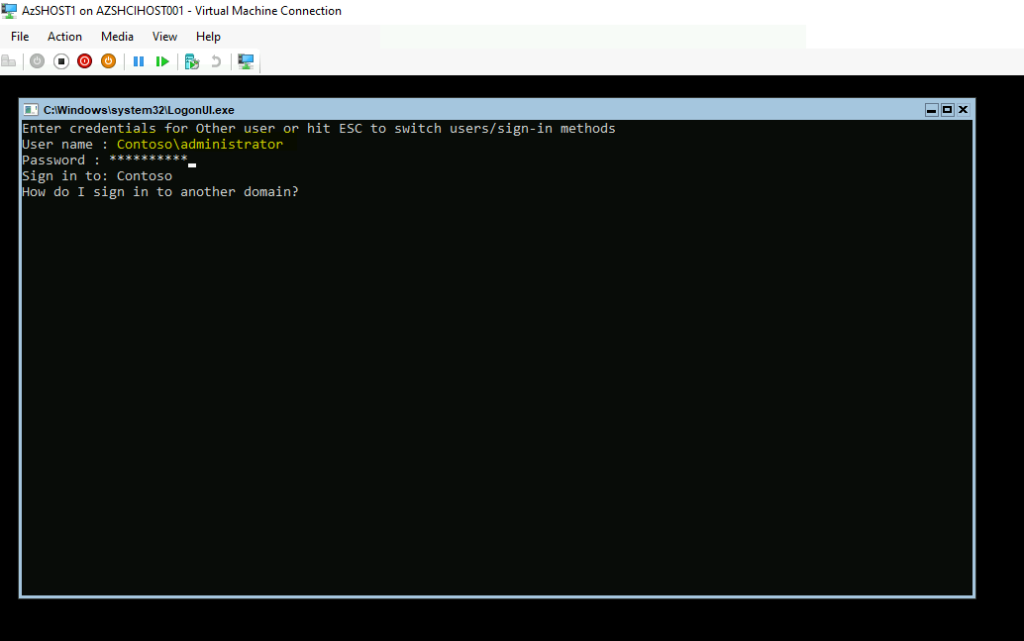

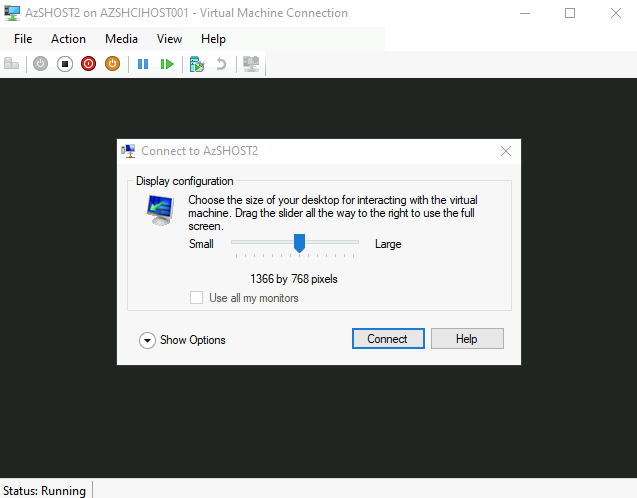

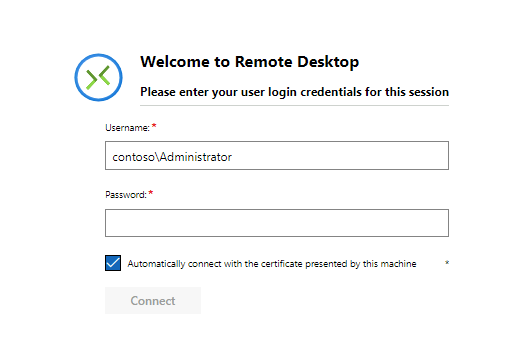

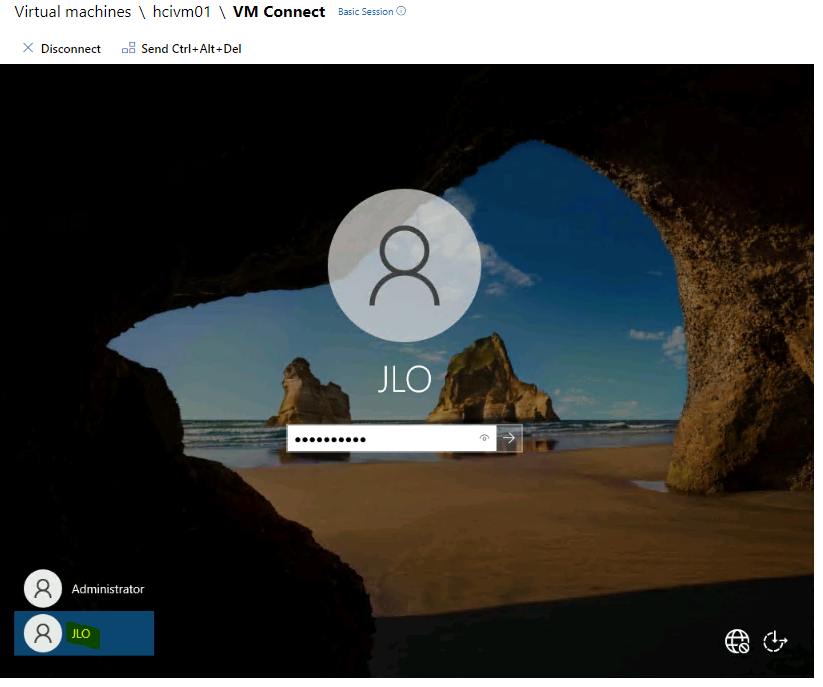

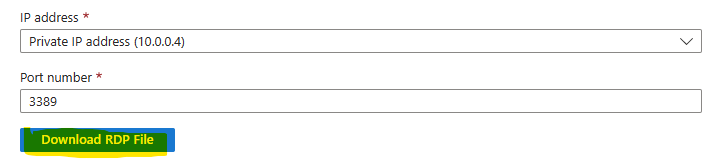

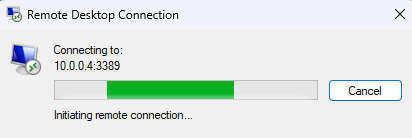

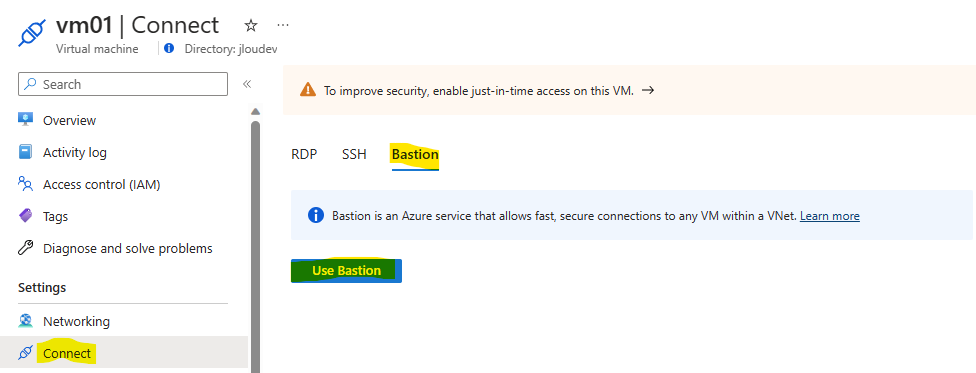

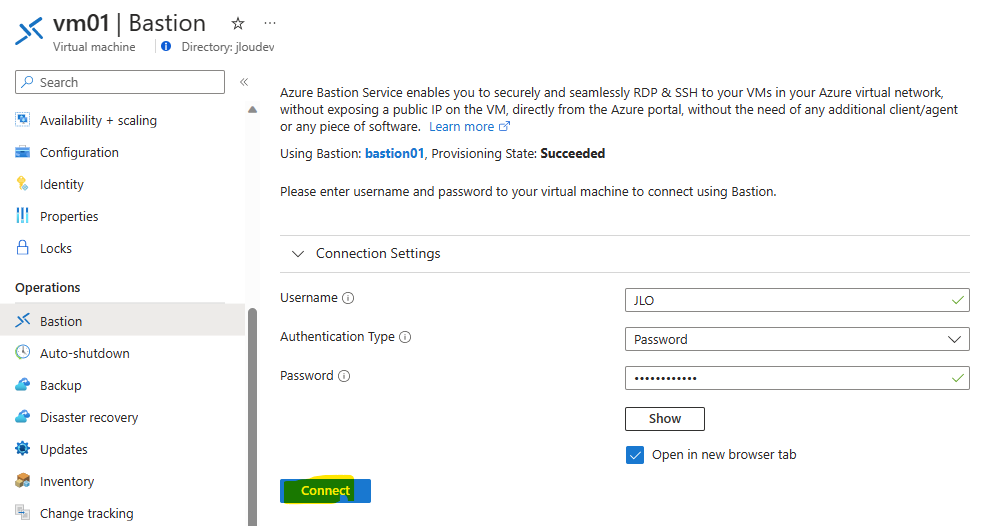

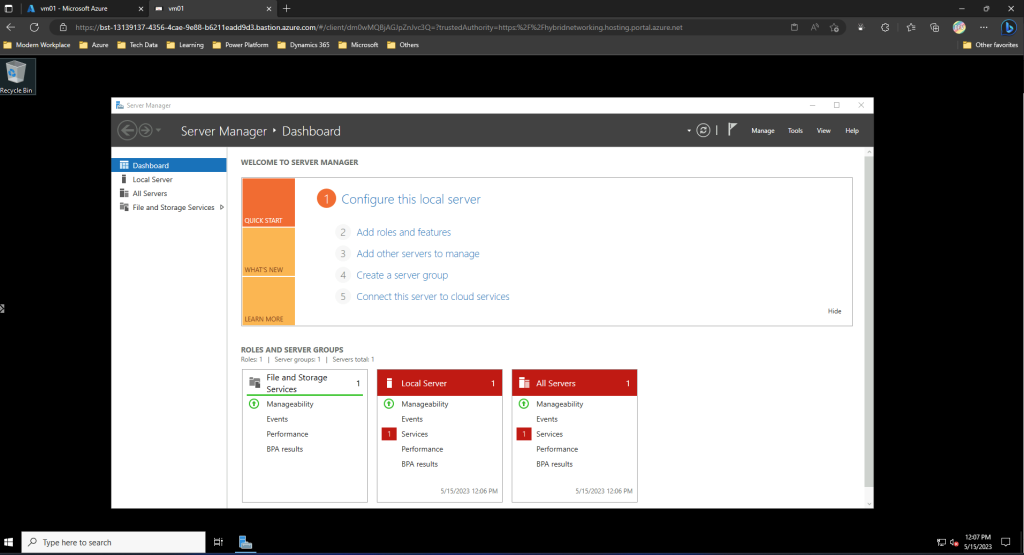

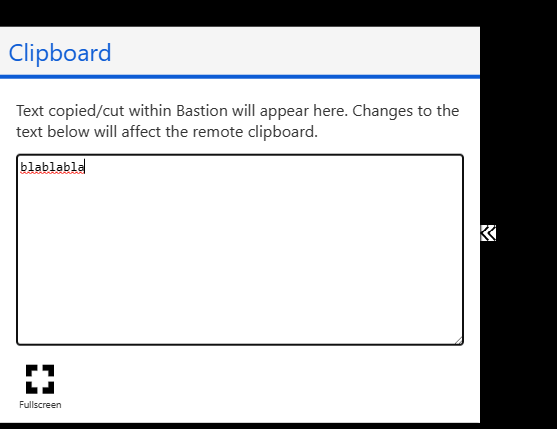

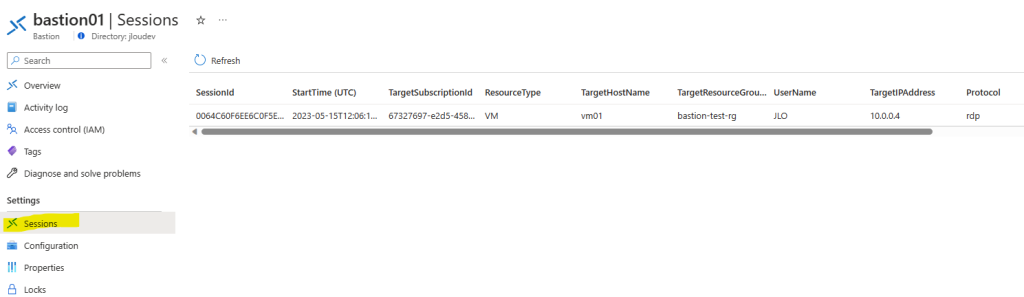

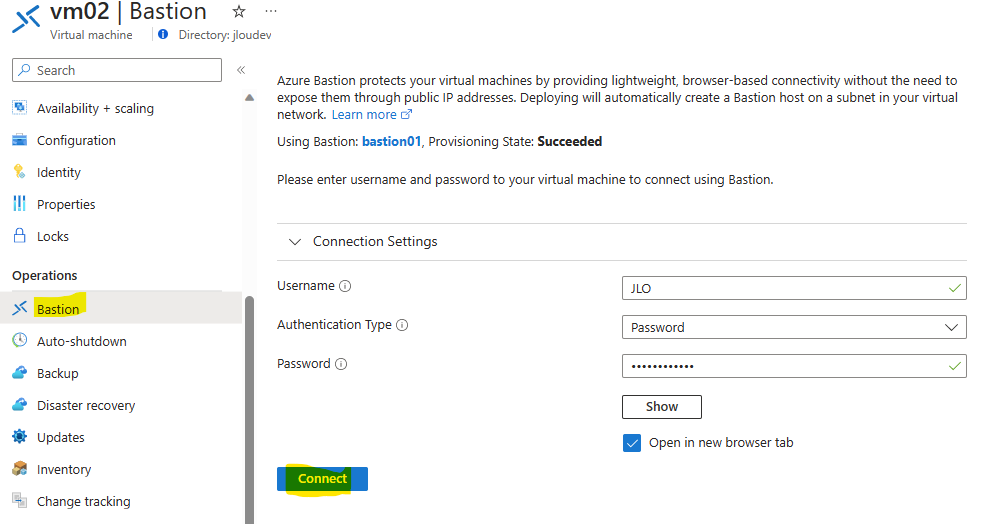

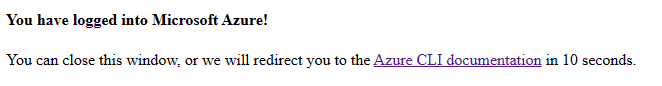

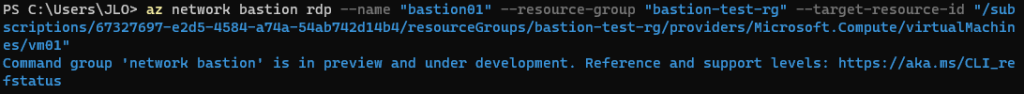

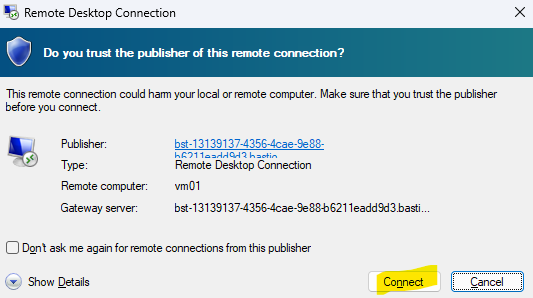

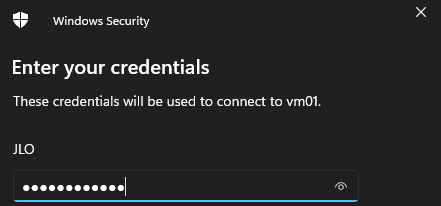

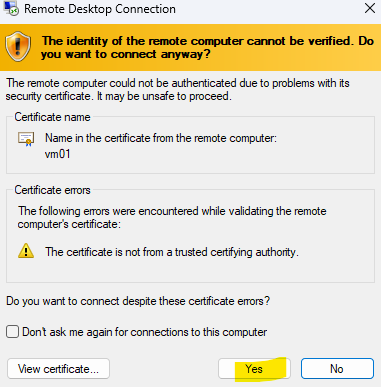

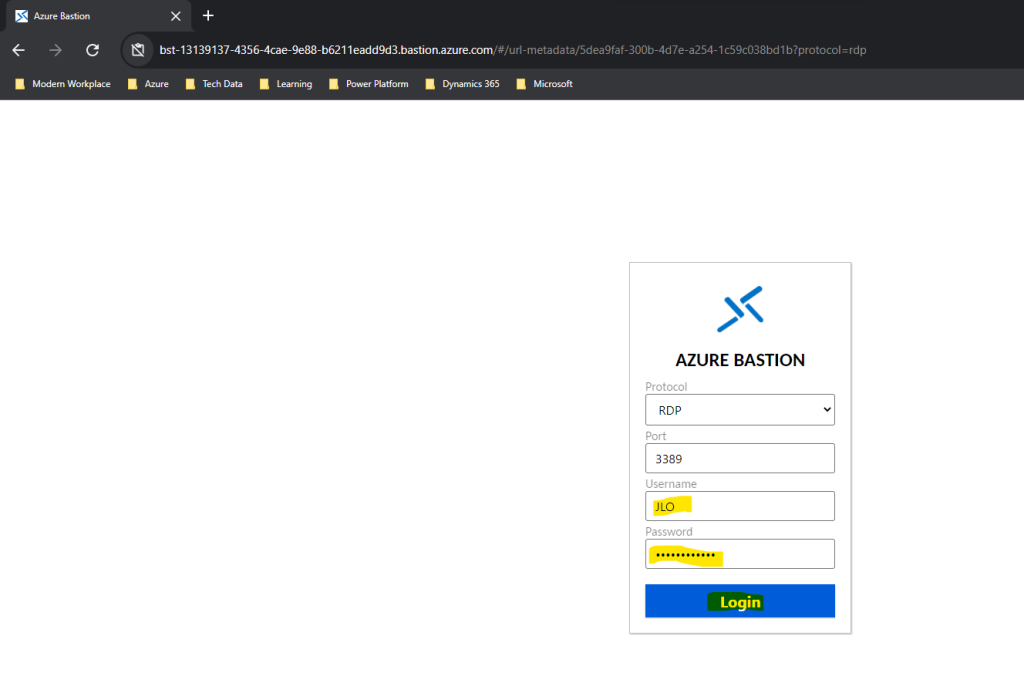

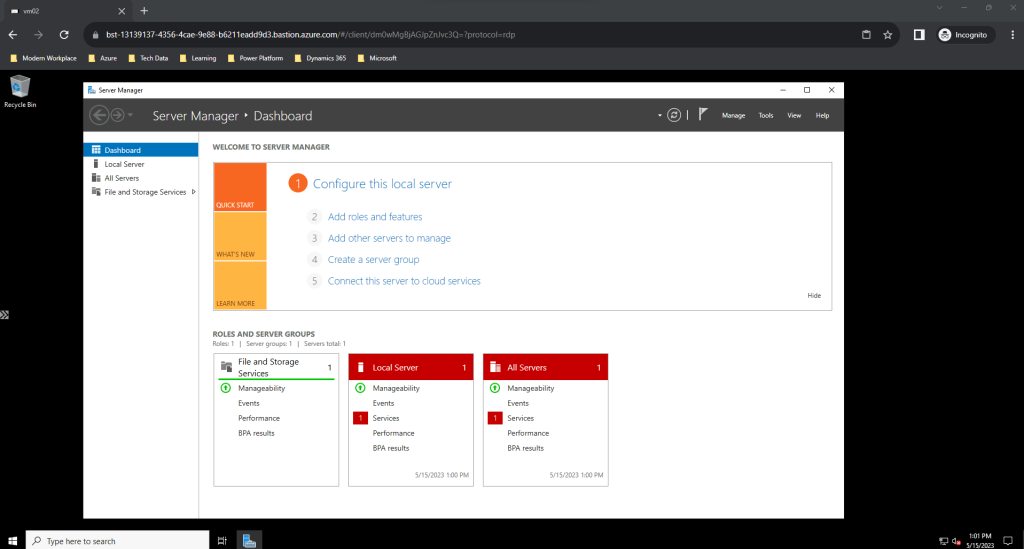

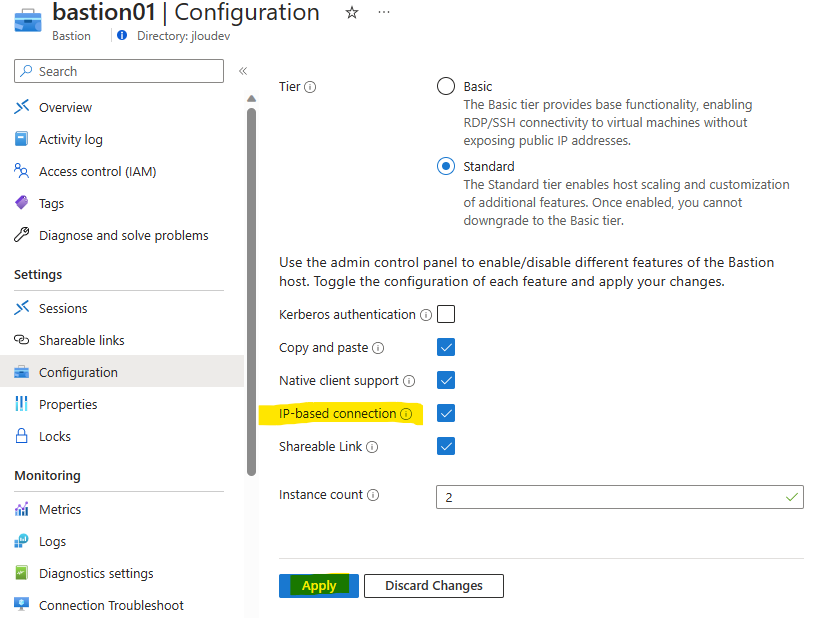

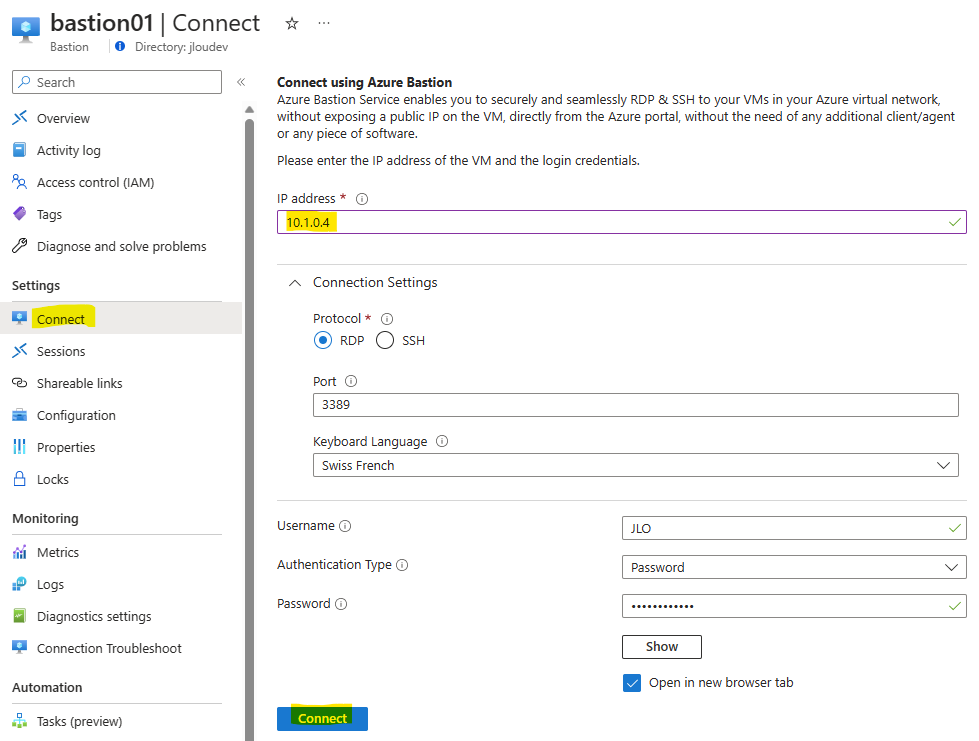

Pour cela, ouvrez une session à distance via le service Azure Bastion en utilisant le compte administrateur local renseigné lors de la création de la VM DC2022 :

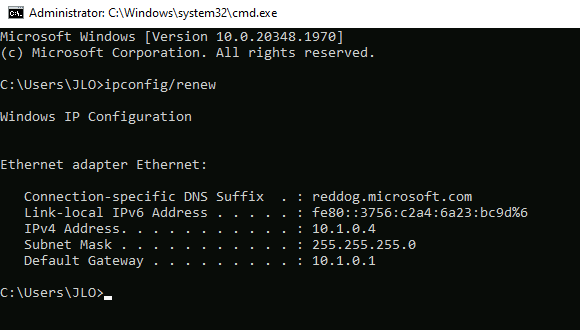

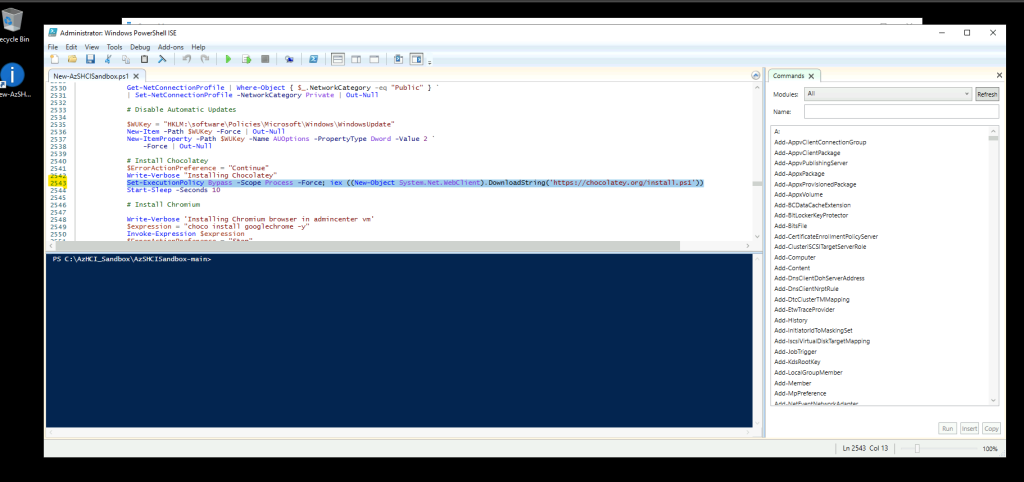

Saisissez la commande suivante afin renouveler les informations DNS de votre VM DC2022 d’Azure afin qu’elle puisse rejoindre votre domaine on-premise :

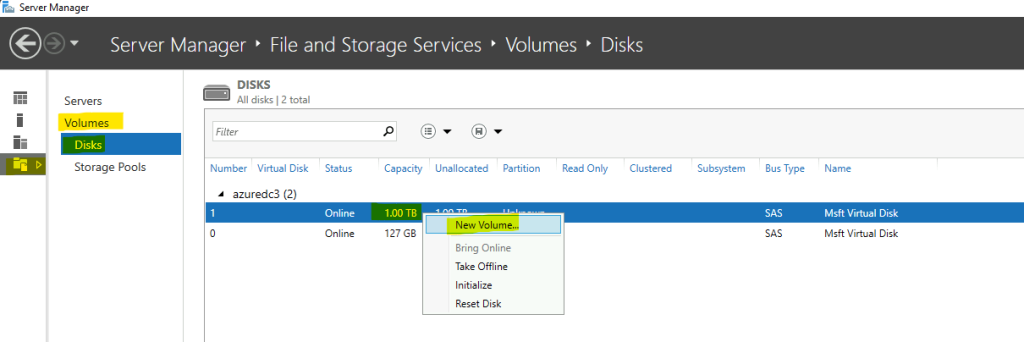

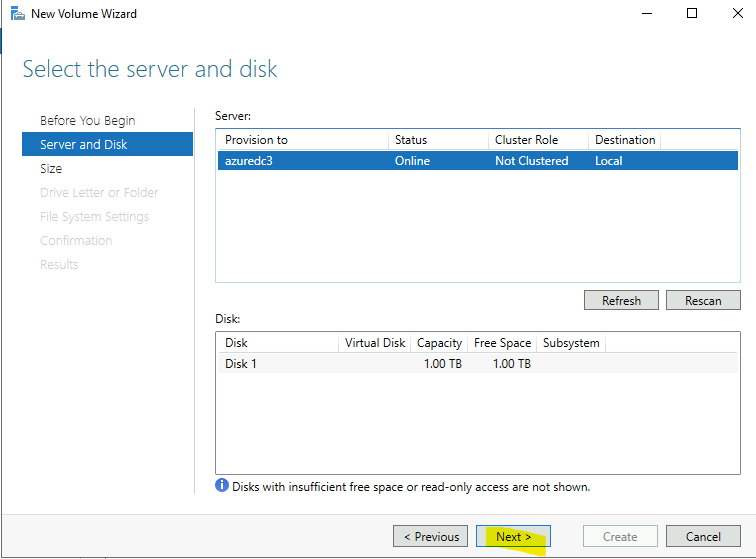

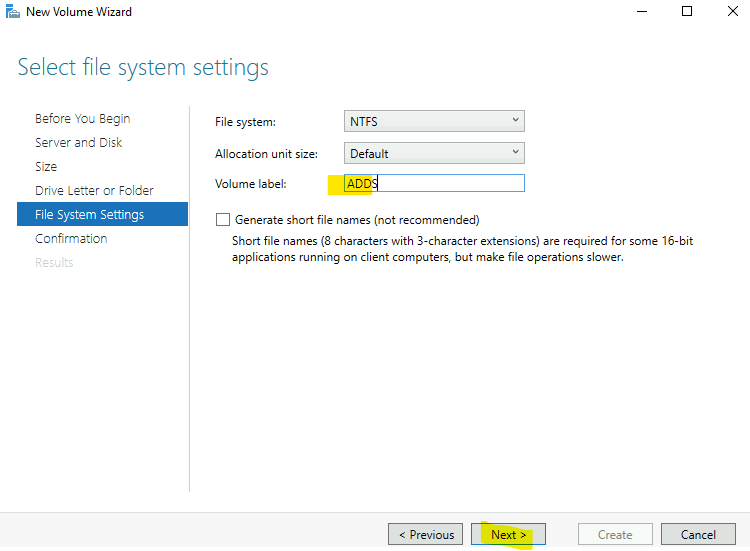

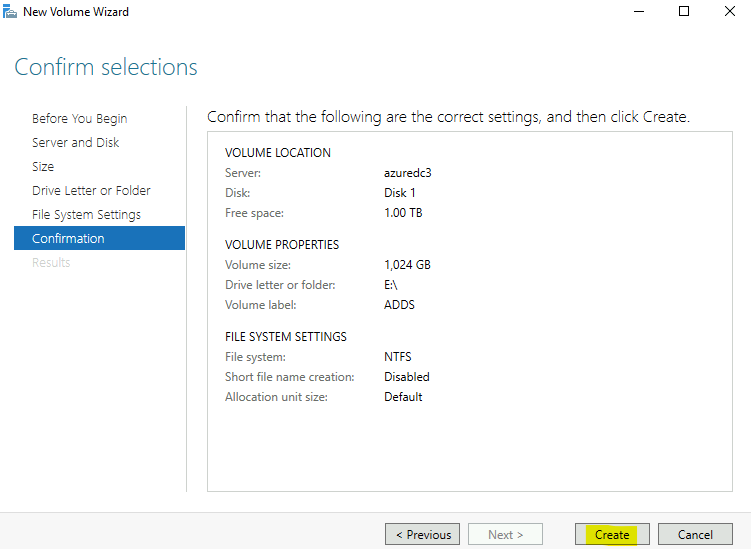

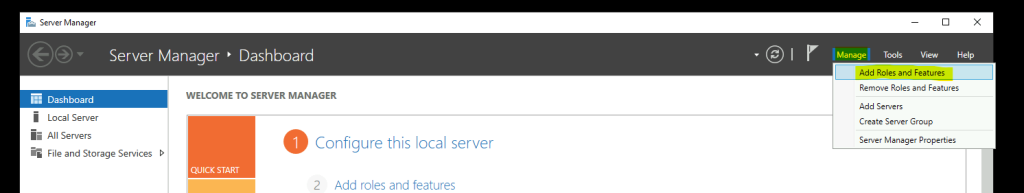

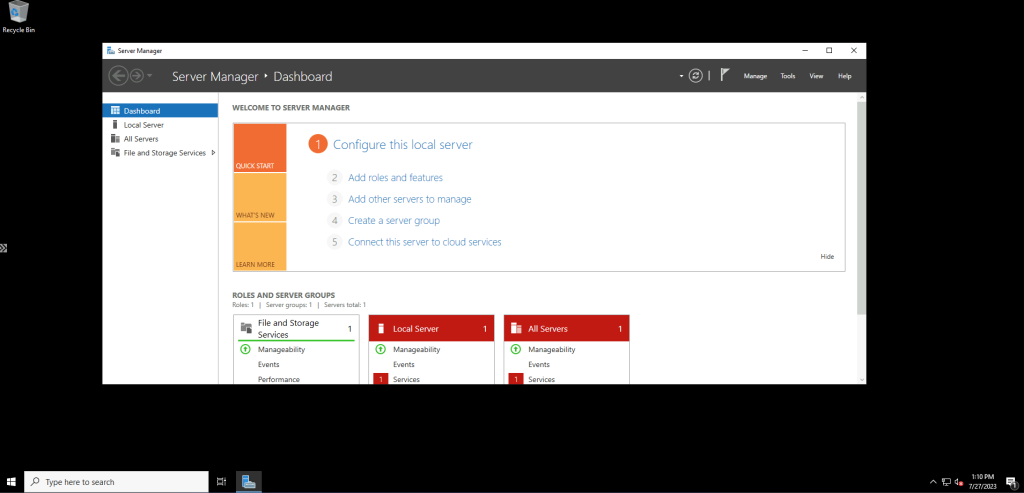

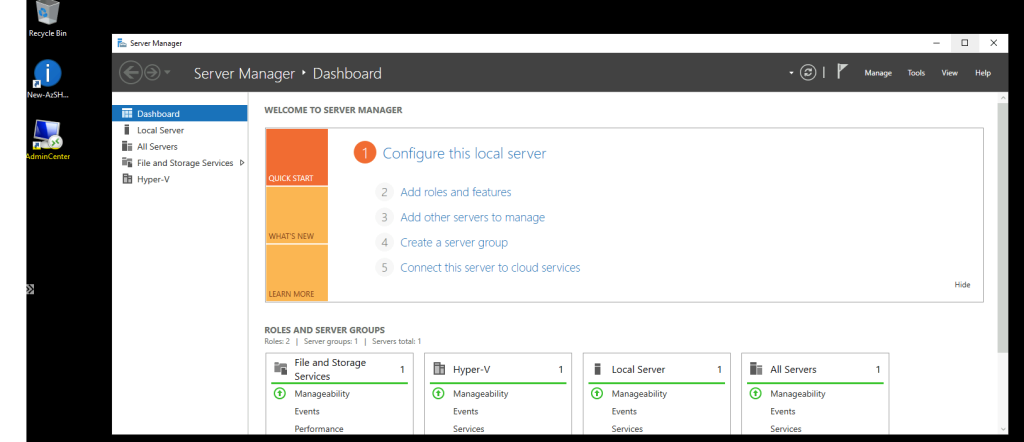

ipconfig/renewSur la console Server Manager, utilisez le menu suivant pour créer une nouvelle partition liées aux données AD DS :

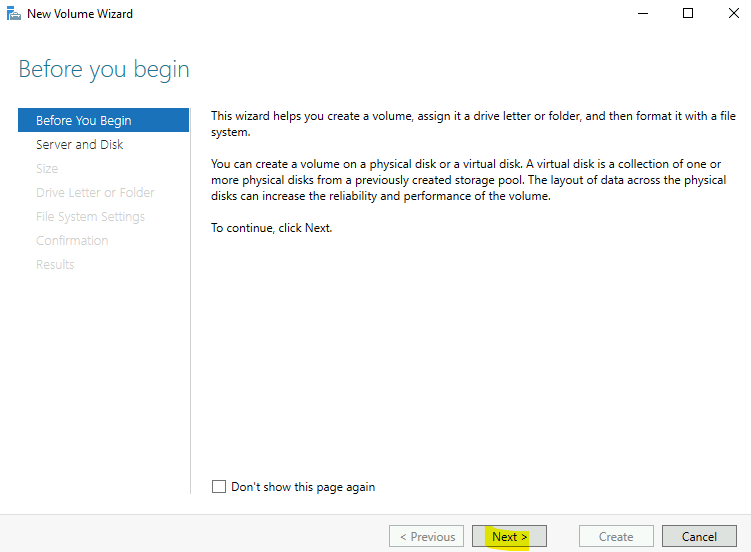

Cliquez sur Suivant :

Cliquez sur Suivant :

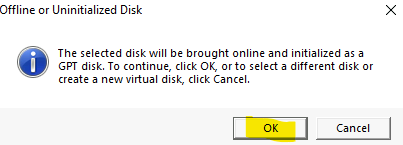

Cliquez sur OK:

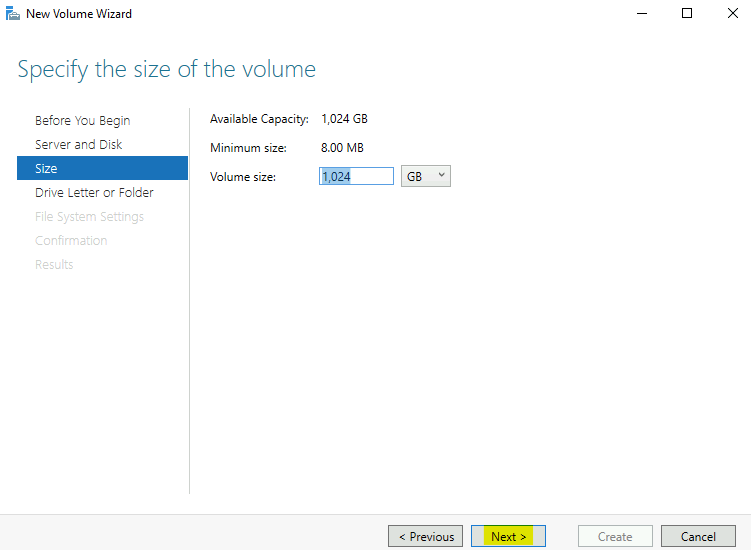

Cliquez sur Suivant :

Cliquez sur Suivant :

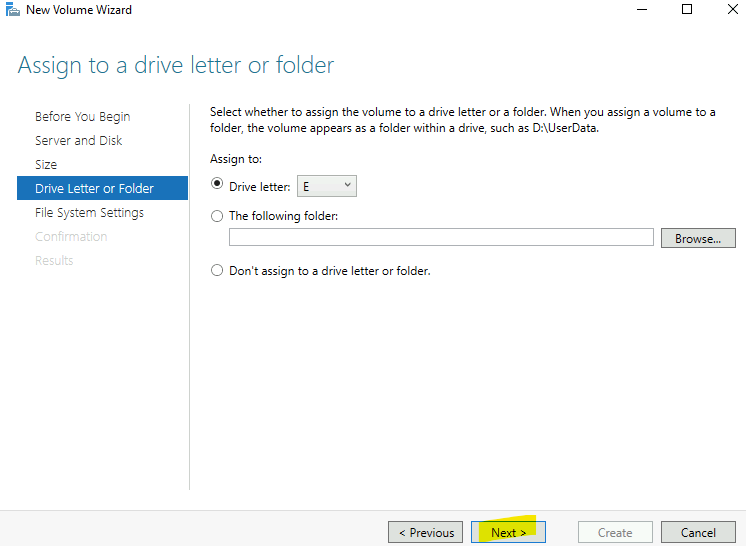

Cliquez sur Suivant :

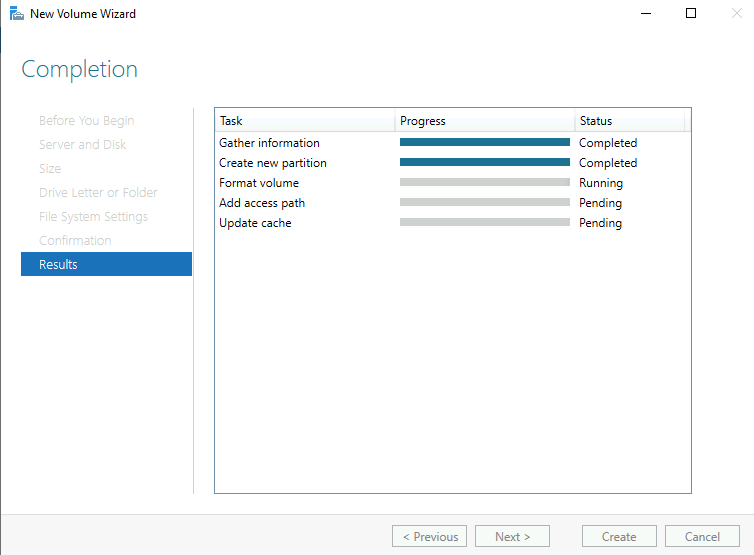

Cliquez sur Créer :

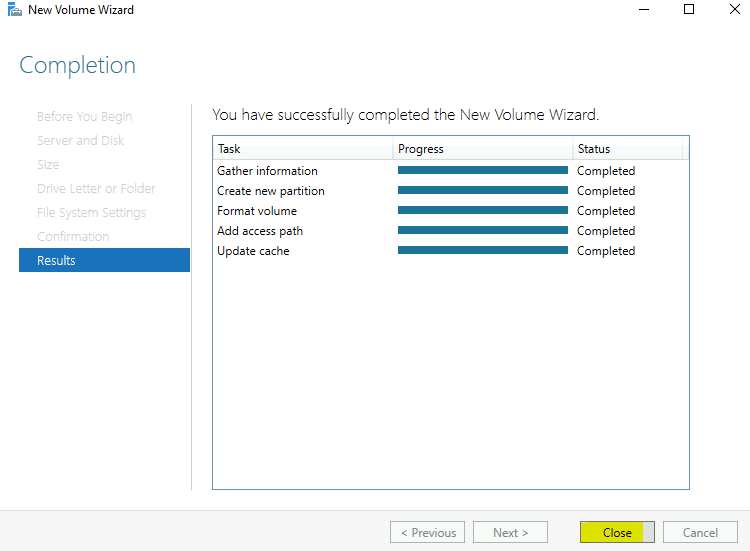

Attendez que le traitement se termine :

Cliquez sur Fermer :

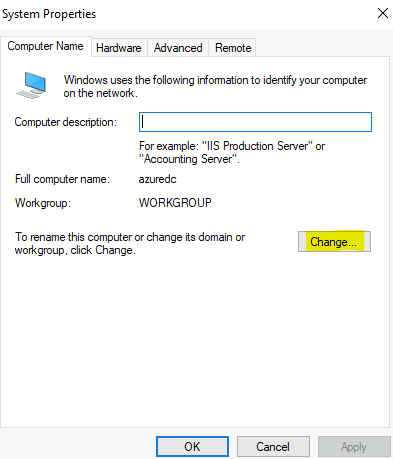

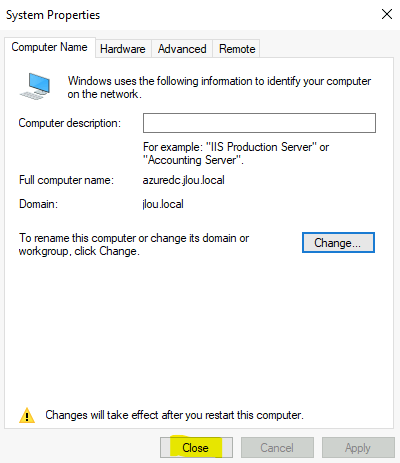

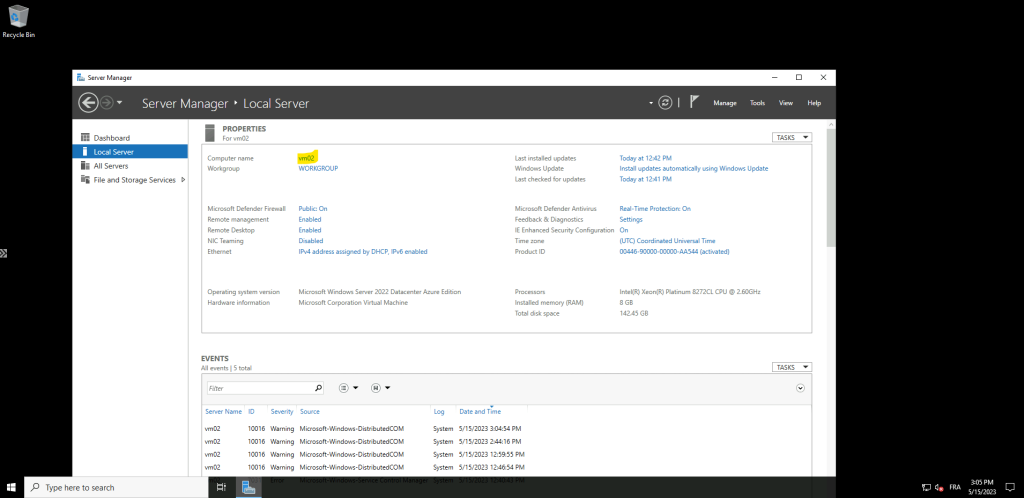

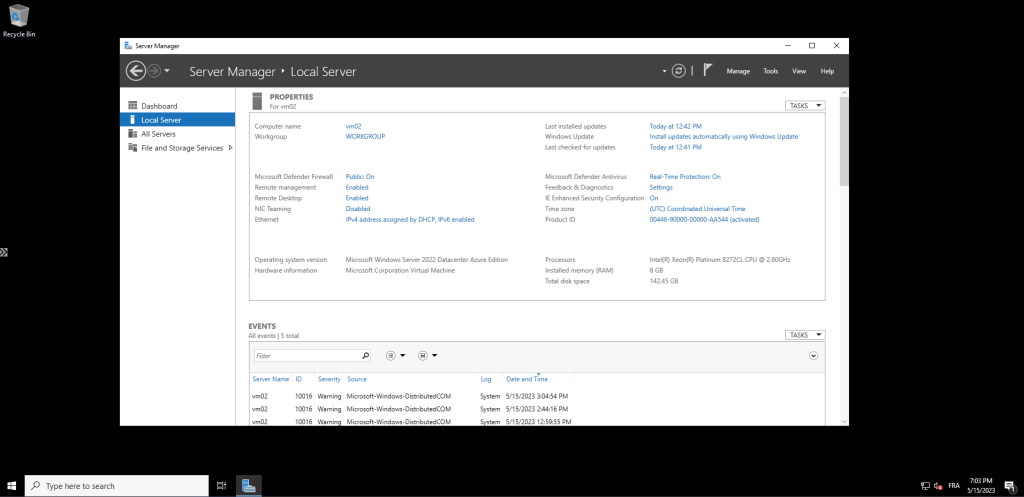

Toujours sur Server Manager, cliquez sur WORKGROUP afin de joindre votre domaine on-premise :

Cliquez sur le bouton ci-dessous :

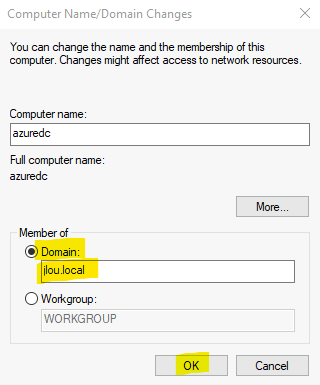

Renseignez le nom de votre domaine on-premise, puis cliquez sur OK :

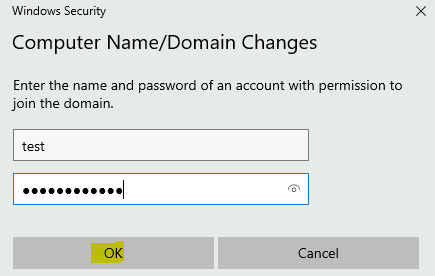

Renseignez les identifiants d’un compte présent sur le domaine on-premise, puis cliquez sur OK :

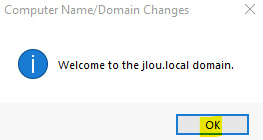

Attendez quelques secondes pour voir apparaître le message suivant, puis cliquez sur OK :

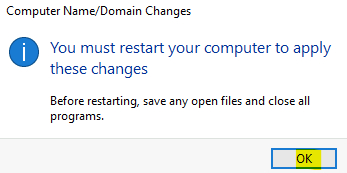

Cliquez sur OK :

Cliquez sur Fermer :

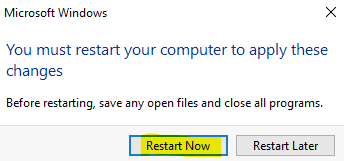

Cliquez-ici pour lancer un redémarrage immédiat de la VM DC2022 d’Azure :

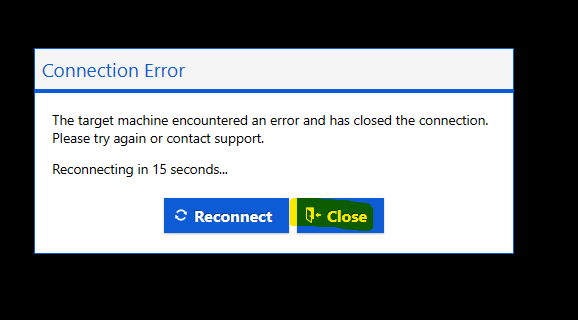

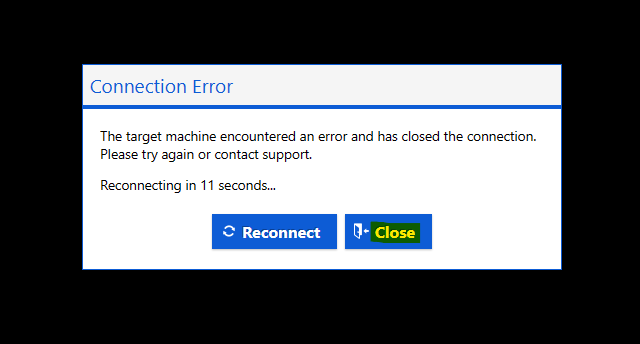

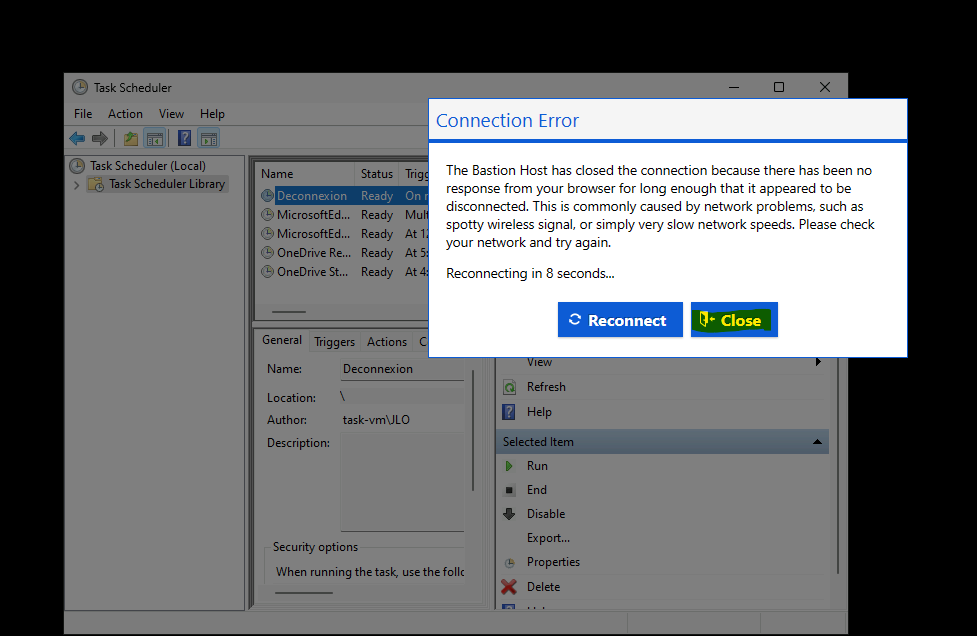

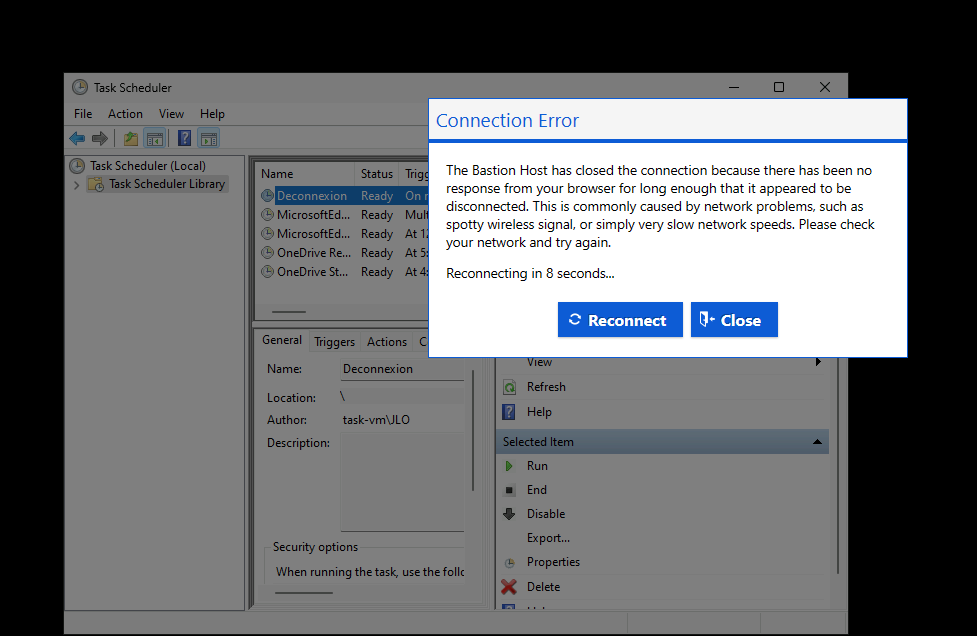

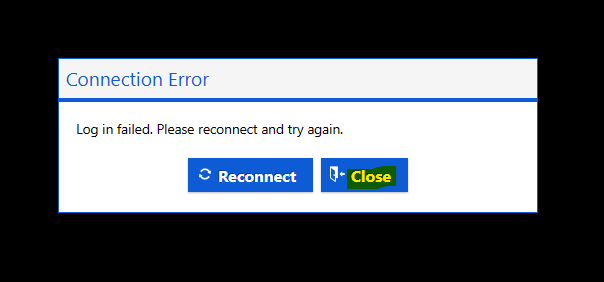

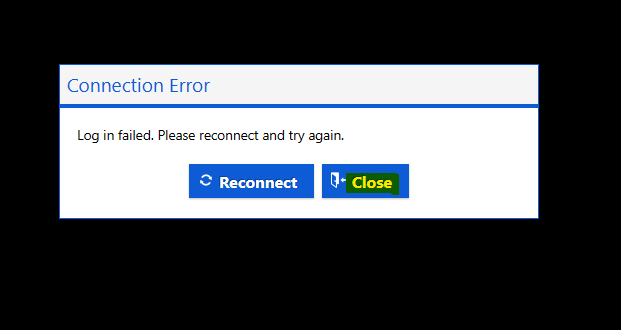

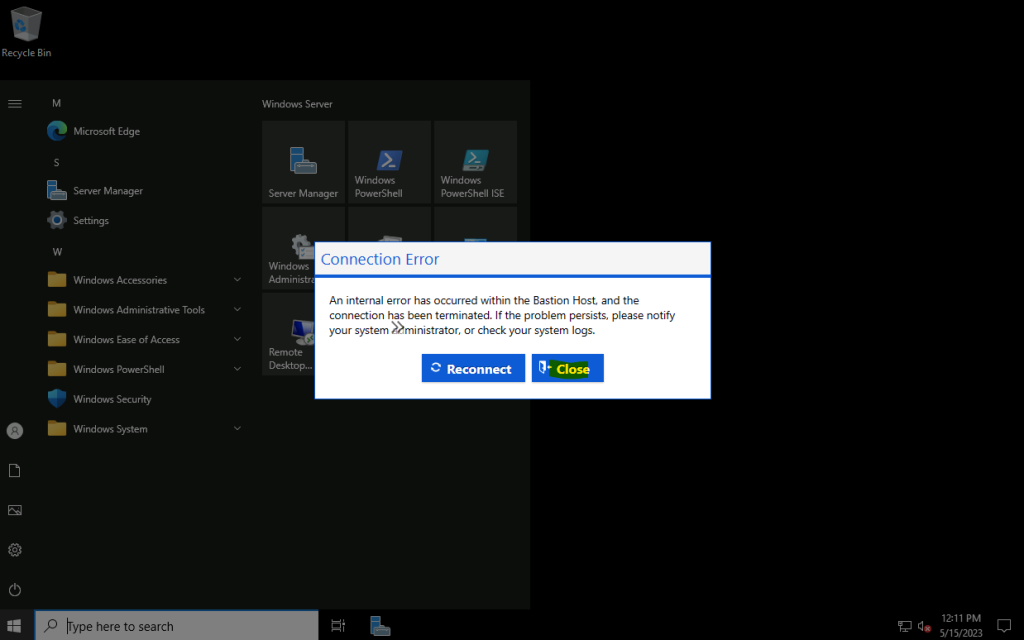

Azure Bastion vous informe que la connexion RDP a été perdue. Cliquez sur Fermer :

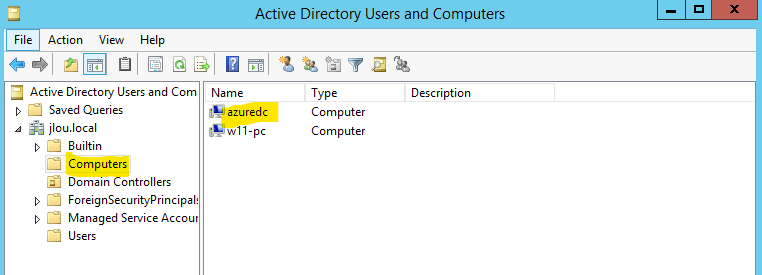

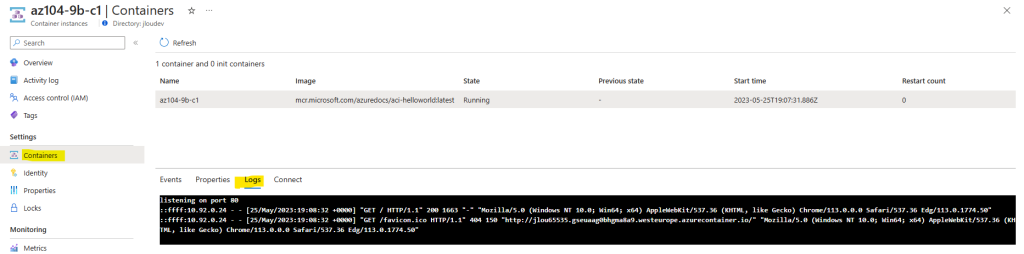

Retournez sur votre DC2012R2 afin de constater la bonne apparition de notre VM DC2022 d’Azure dans la liste des ordinateurs du domaine Active Directory.

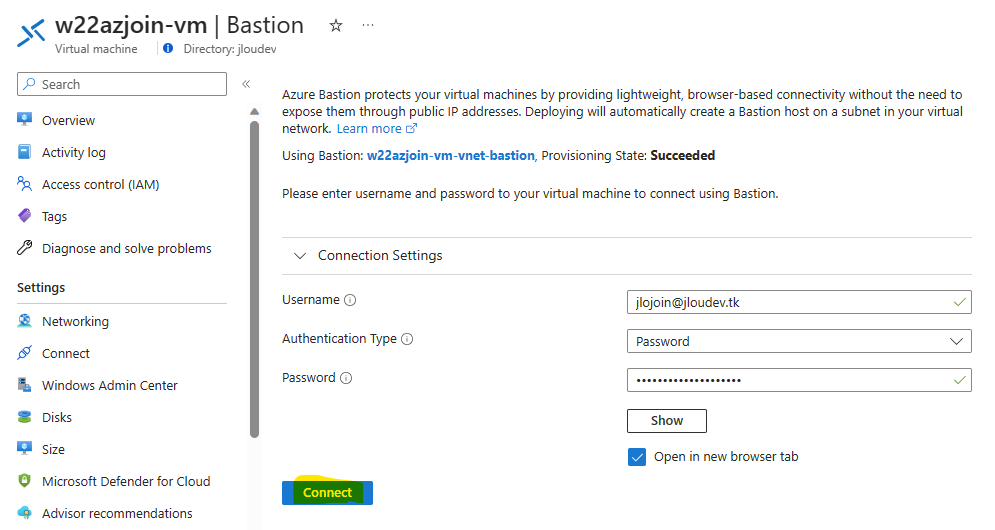

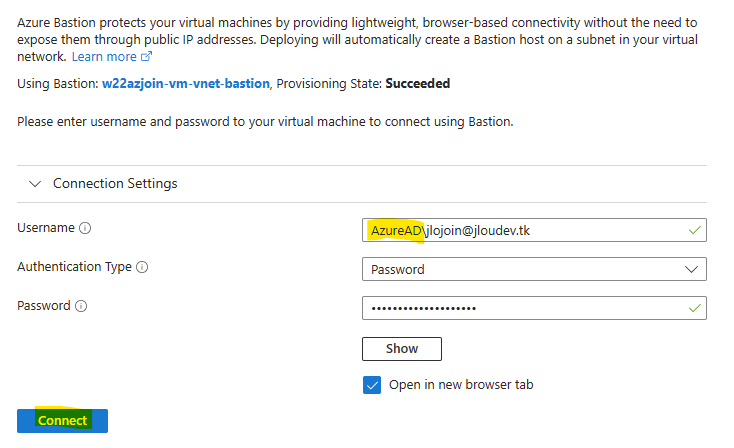

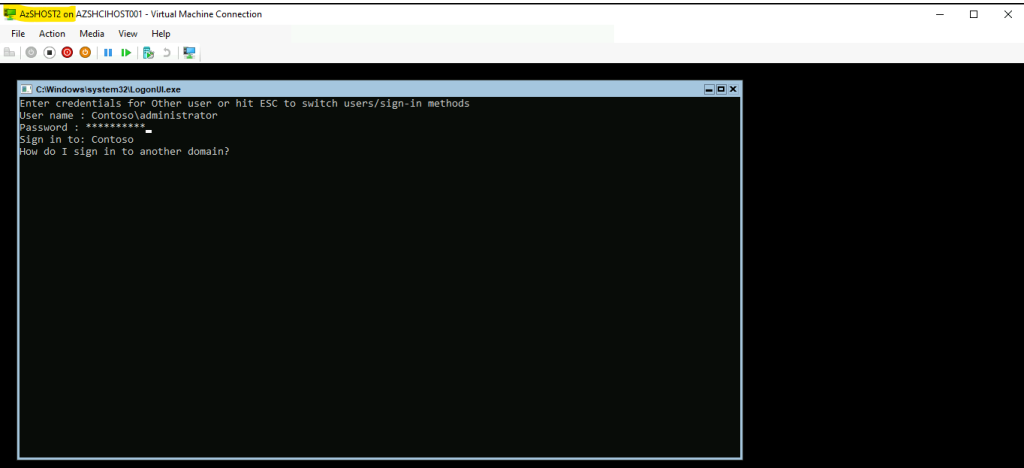

Rouvrez à nouveau une session à distance via le service Azure Bastion en utilisant un compte de domaine sur votre DC2022 :

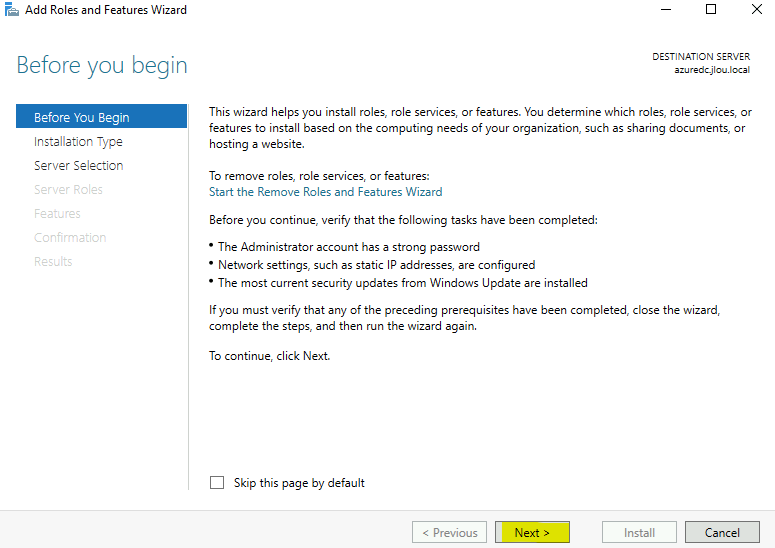

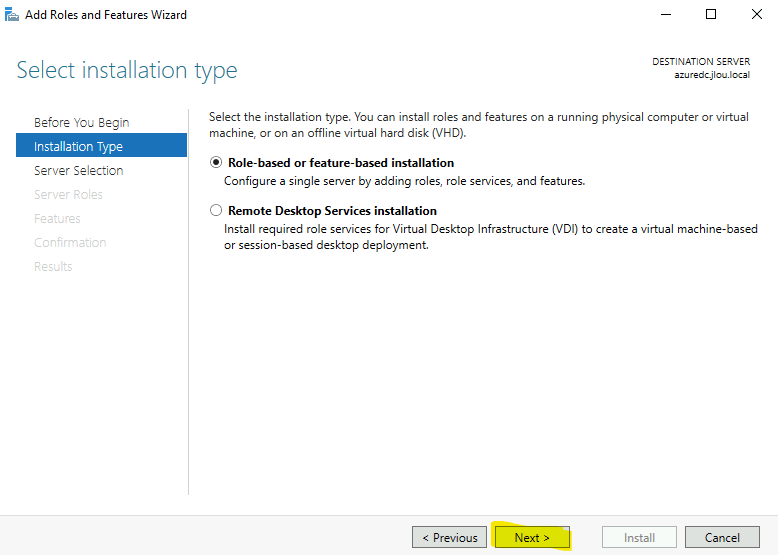

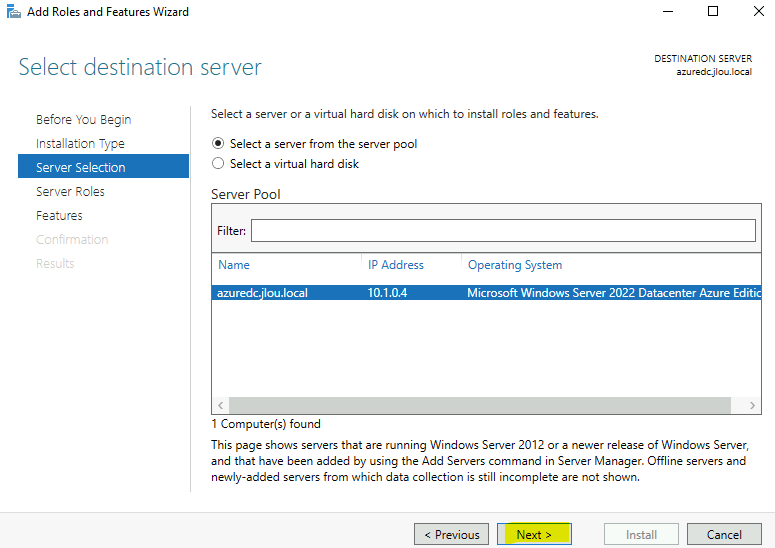

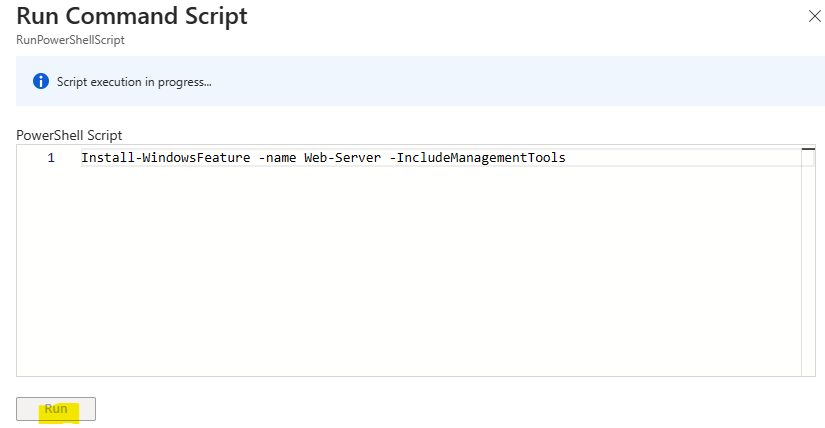

Cliquez-ici pour installer les rôles AD DS et DNS sur votre VM DC2022 d’Azure :

Cliquez sur Suivant :

Cliquez sur Suivant :

Cliquez sur Suivant :

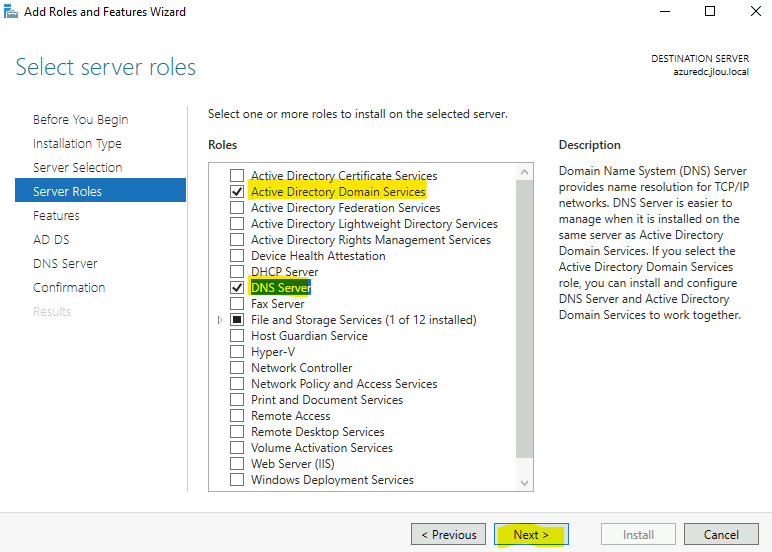

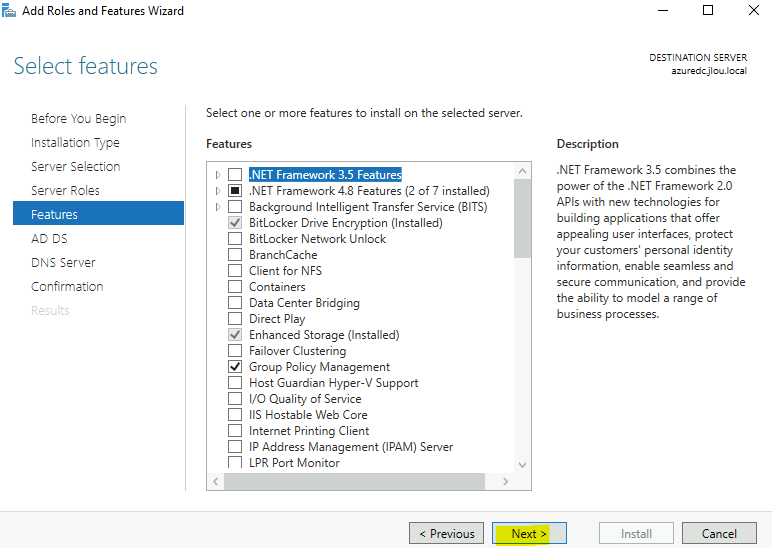

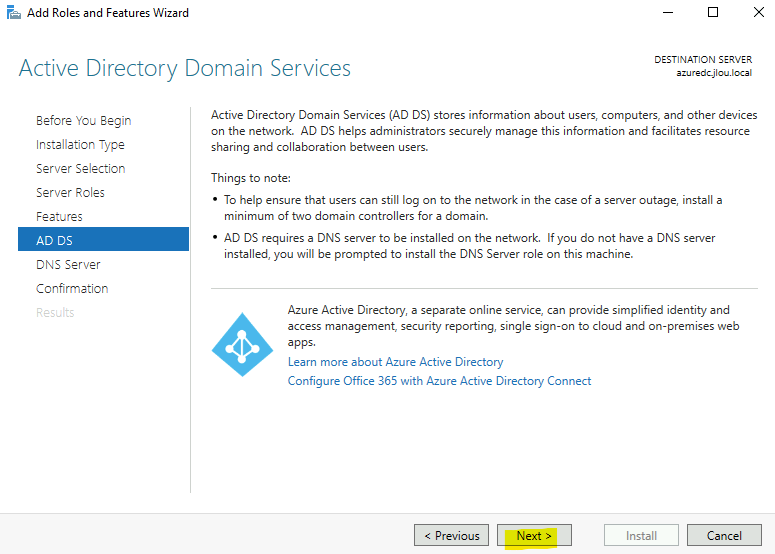

Cochez les deux rôles AD DS et DNS, puis cliquez sur Suivant :

Cliquez sur Suivant :

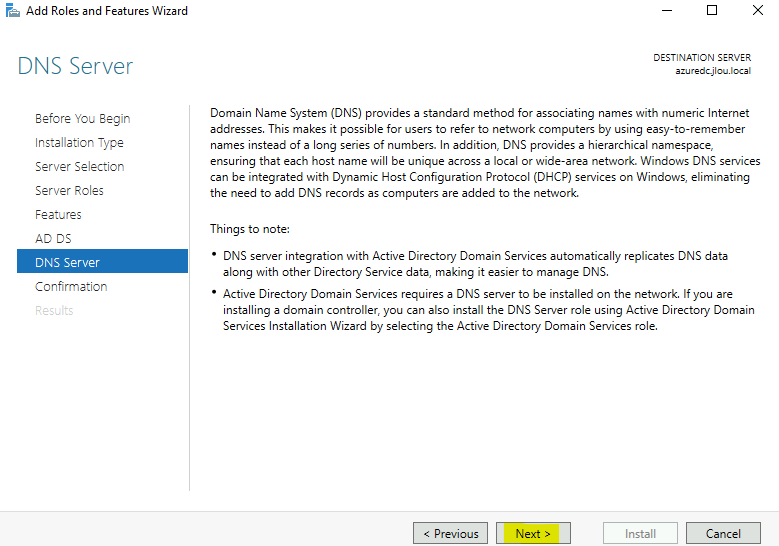

Cliquez sur Suivant :

Cliquez sur Suivant :

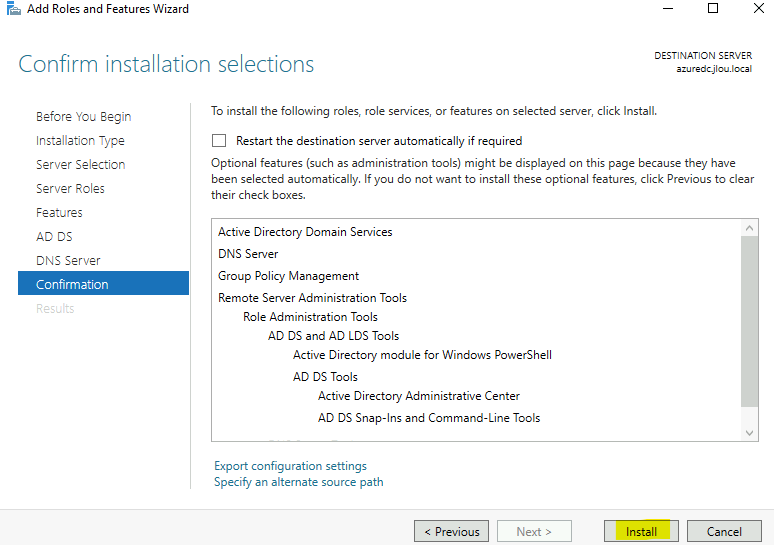

Cliquez sur Installer :

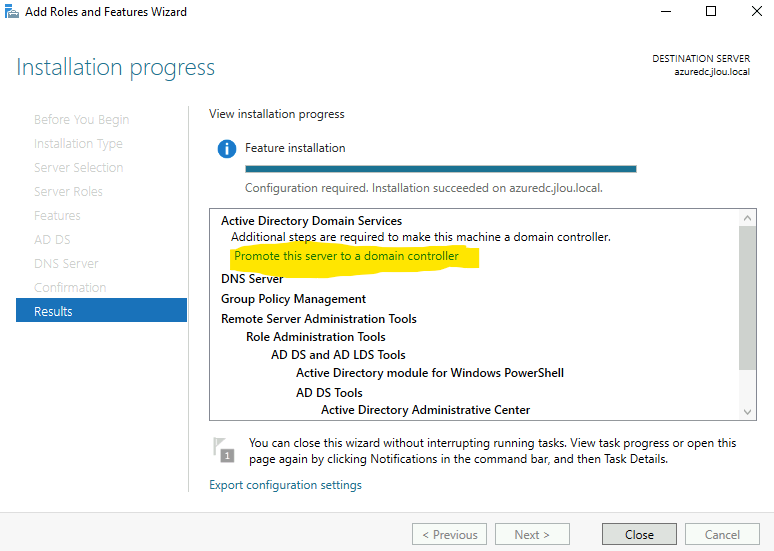

Attendez quelques minutes, puis cliquez ici pour promouvoir votre VM DC2022 comme un second serveur AD DS de votre domaine on-premise :

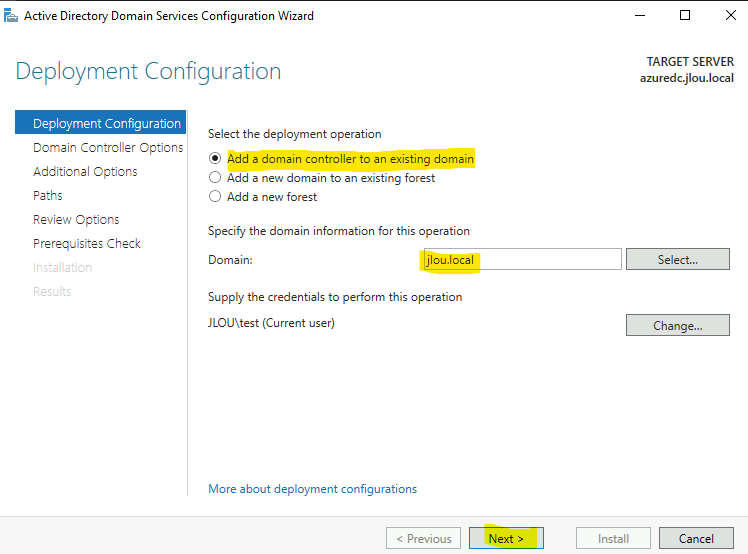

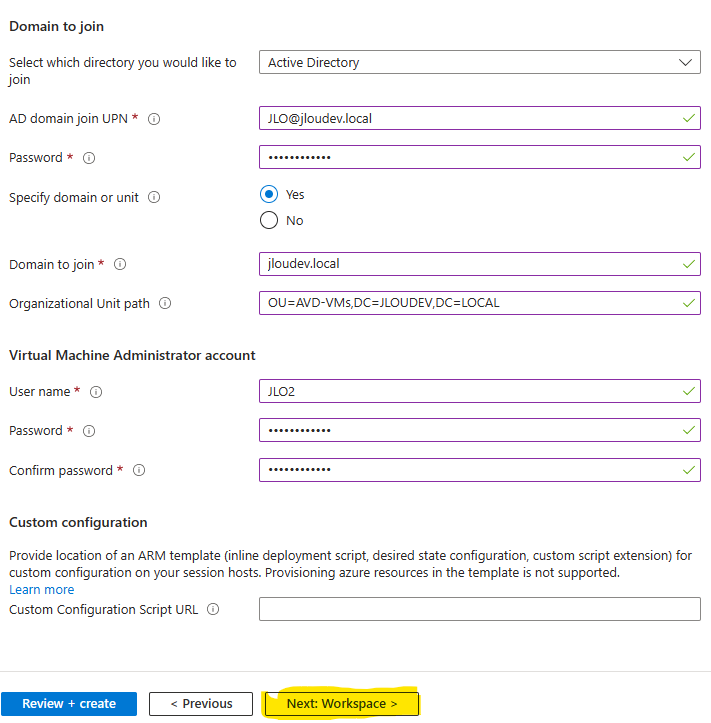

Conservez le premier choix ainsi que le domaine précédemment joint, puis cliquez sur Suivant :

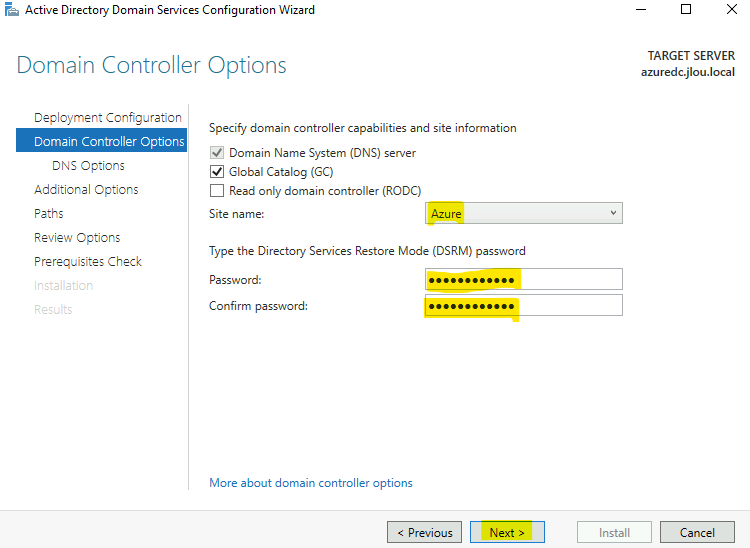

Choisissez si besoin un site différent du premier, renseignez le mot de passe DSRM, puis cliquez sur Suivant :

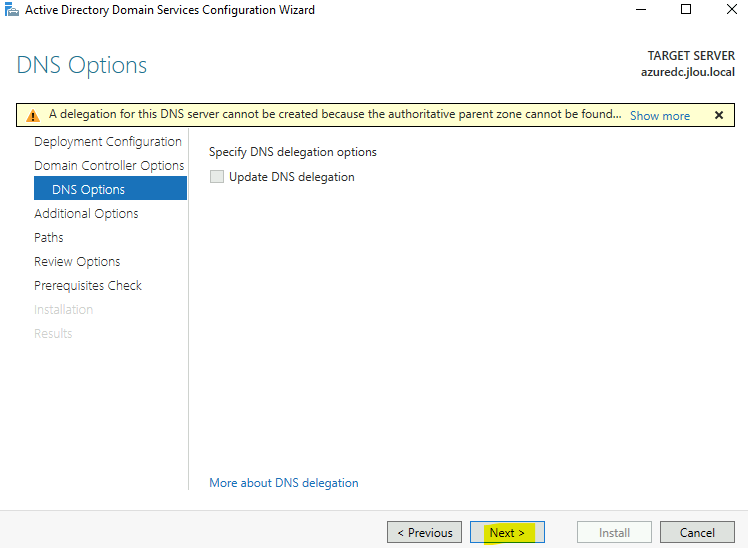

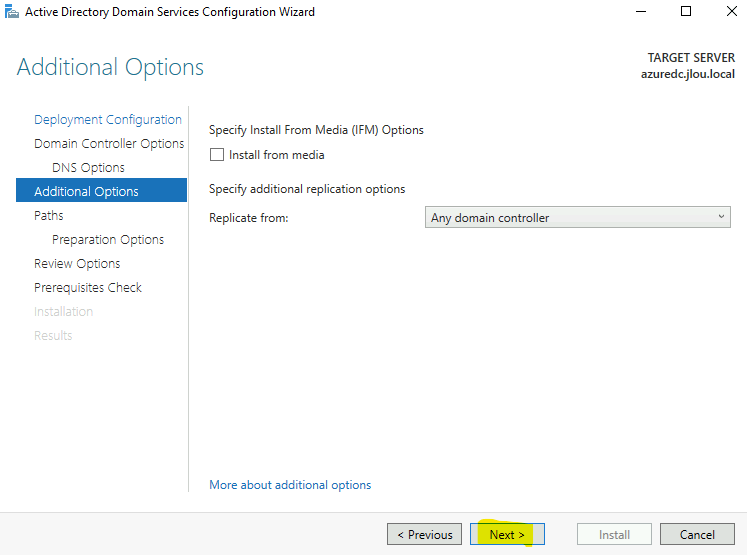

Cliquez sur Suivant :

Cliquez sur Suivant :

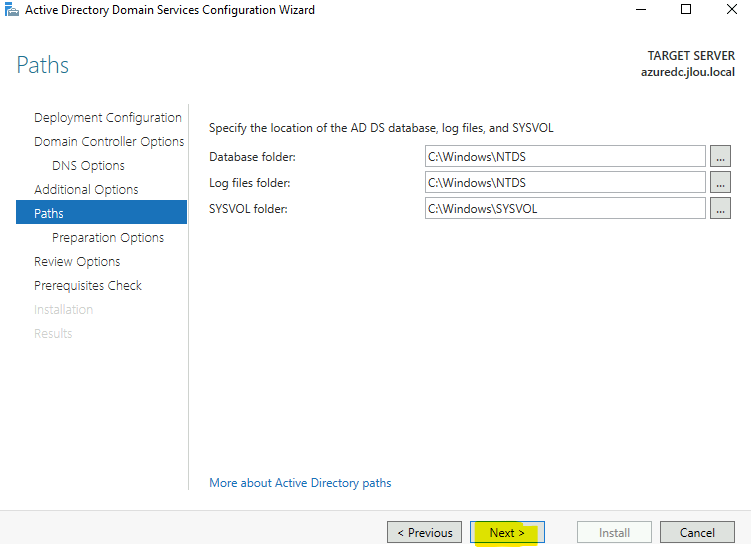

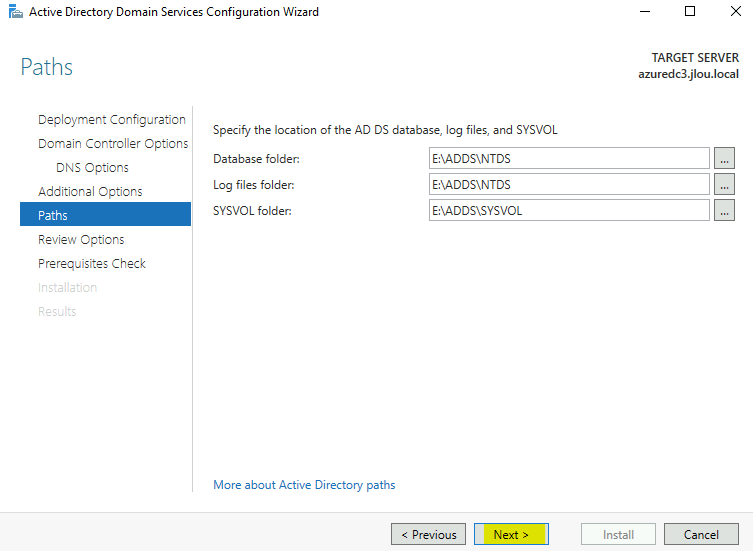

Modifiez les chemins AD DS pour utiliser le nouveau disque, puis cliquez sur Suivant :

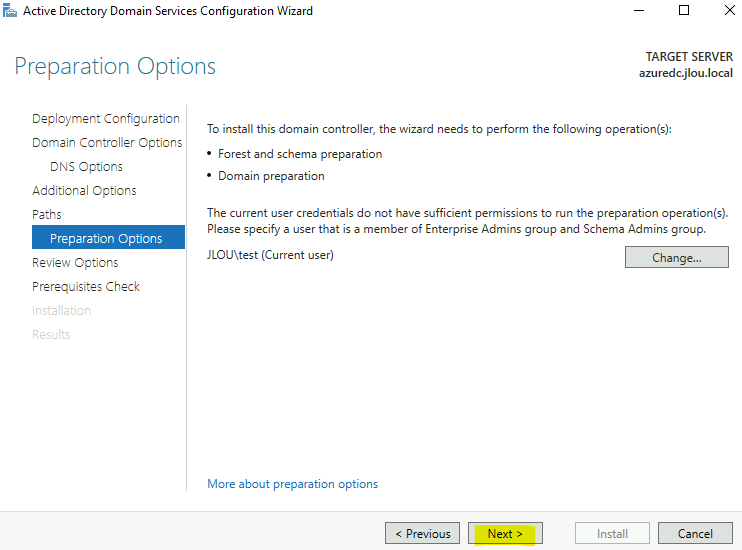

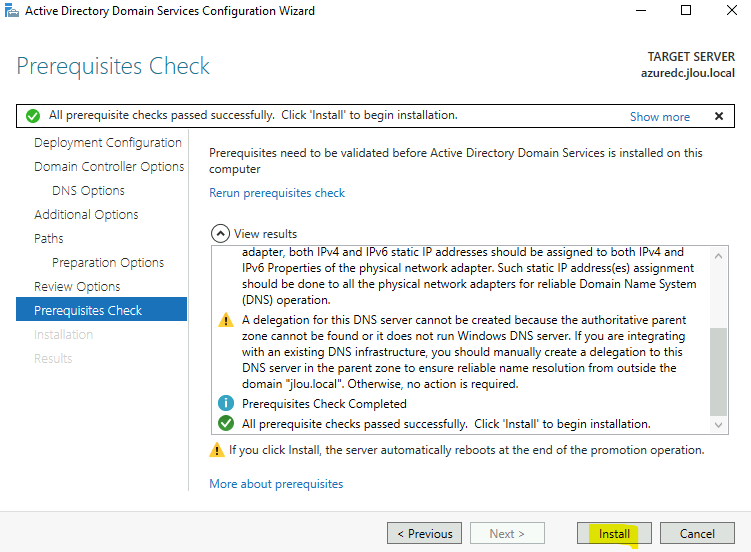

Cliquez sur Suivant :

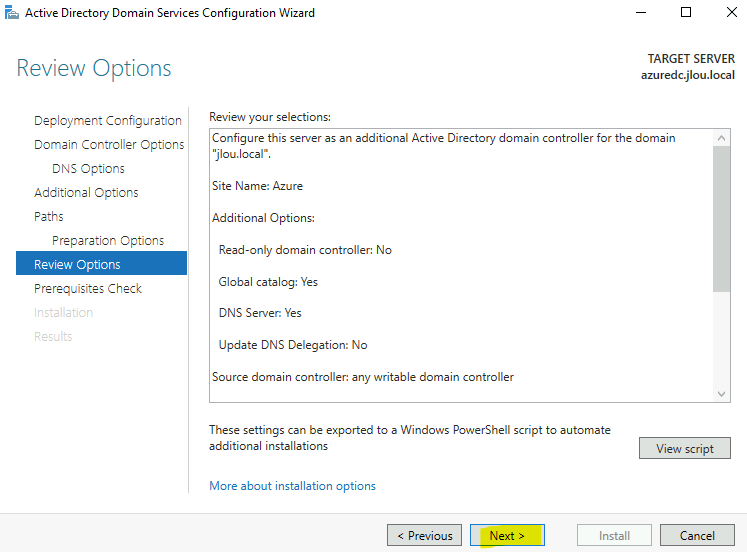

Cliquez sur Suivant :

Cliquez sur Installer :

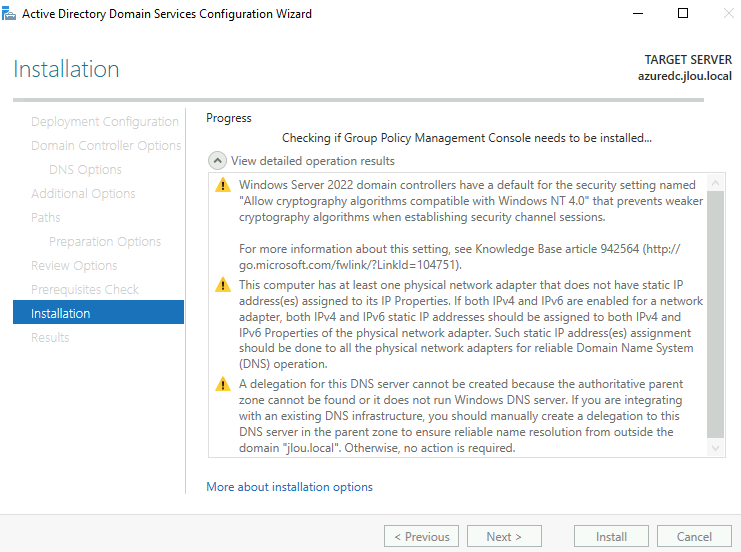

Attendez environ 5 minutes que l’installation se termine :

Comme la VM doit redémarrer au niveau OS, Azure Bastion vous informe que la connexion RDP a été perdue. Cliquez sur Fermer :

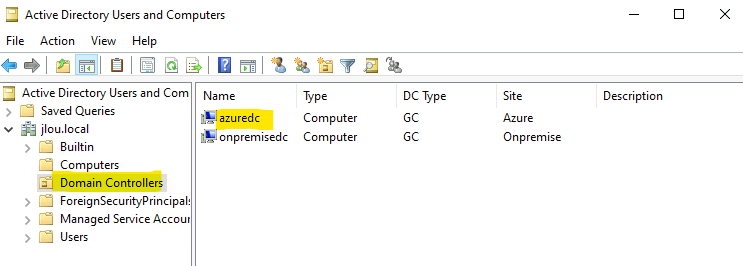

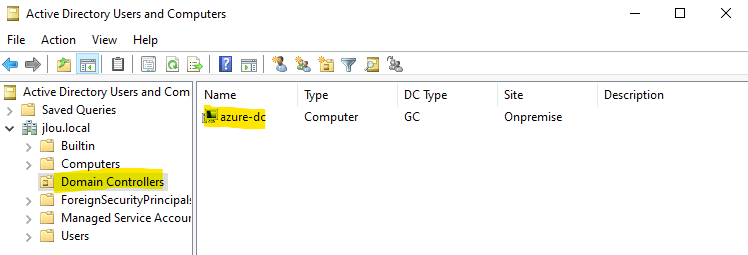

Retournez sur votre DC2012R2 afin de constater la bonne apparition de notre VM DC2022 d’Azure dans la liste des contrôleurs de domaine.

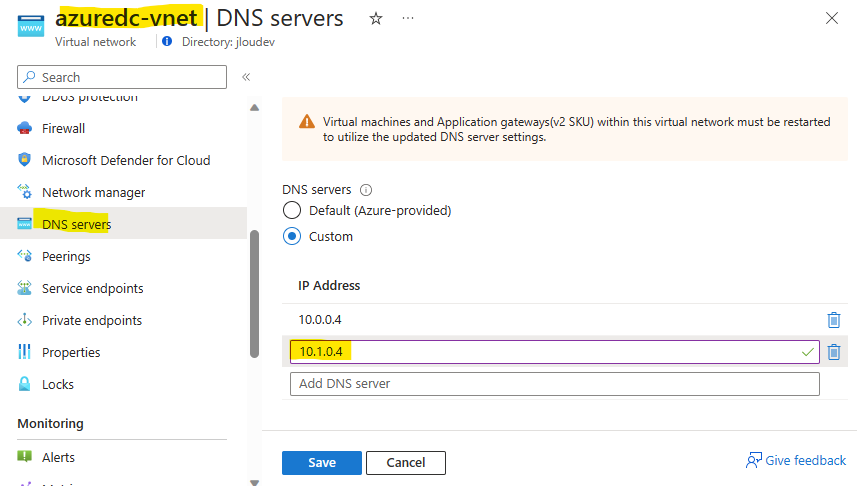

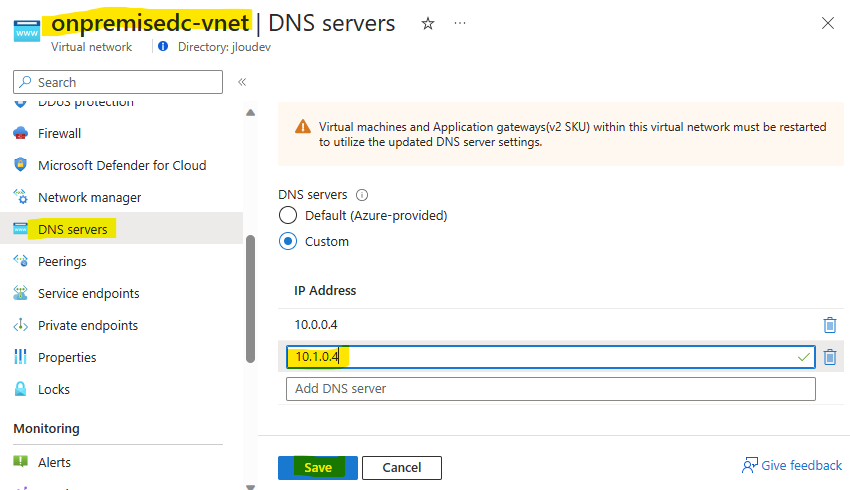

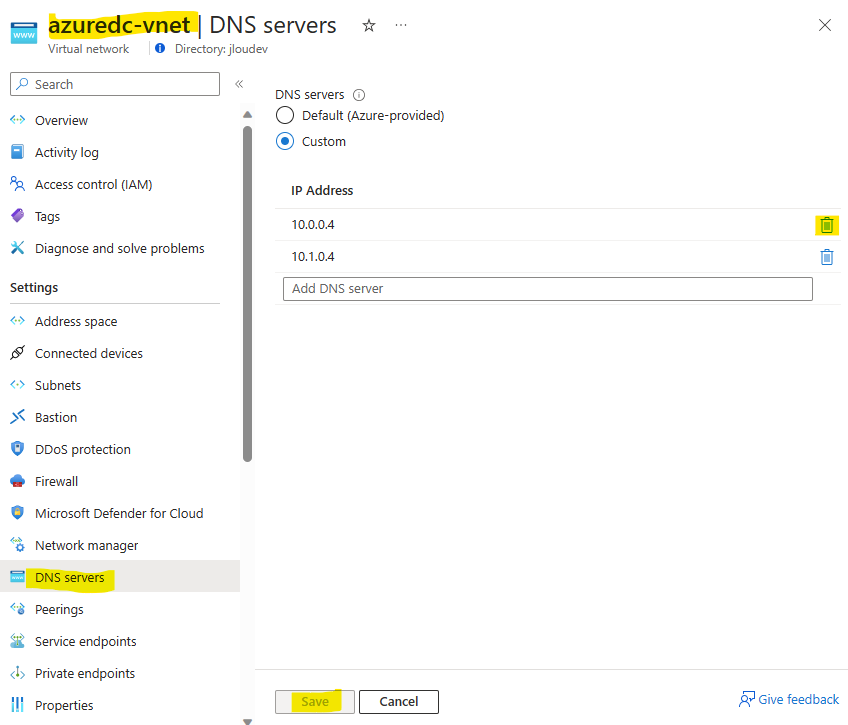

Afin que la nouvelle machine virtuelle DC2022 Azure puisse résoudre des requêtes DNS du domaine on-premise, configurez le DNS de votre réseau Azure pour qu’il pointe sur l’adresse IP de votre VM DC2022, puis cliquer sur Sauvegarder :

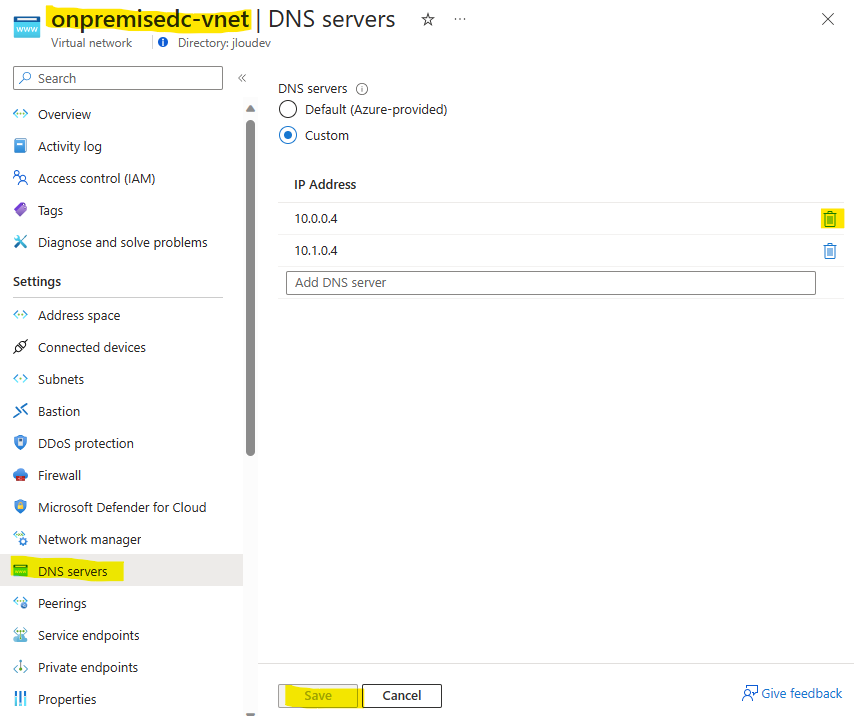

Effectuez la même opération sur le DNS du réseau on-premise :

Notre machine virtuelle est maintenant contrôleur de domaine, nous allons pouvoir préparer le décommissionnement du DC2012R2 sur le réseau on-premise.

Avant cela, nous devons nous occuper des rôles FSMO.

Etape IV – Transfert des 5 rôles FSMO :

Nous allons déplacer les 5 roles FSMO présents sur Active Directory :

- Schema master FSMO role

- Domain naming master FSMO role

- RID master FSMO role

- PDC emulator FSMO role

- Infrastructure master FSMO role

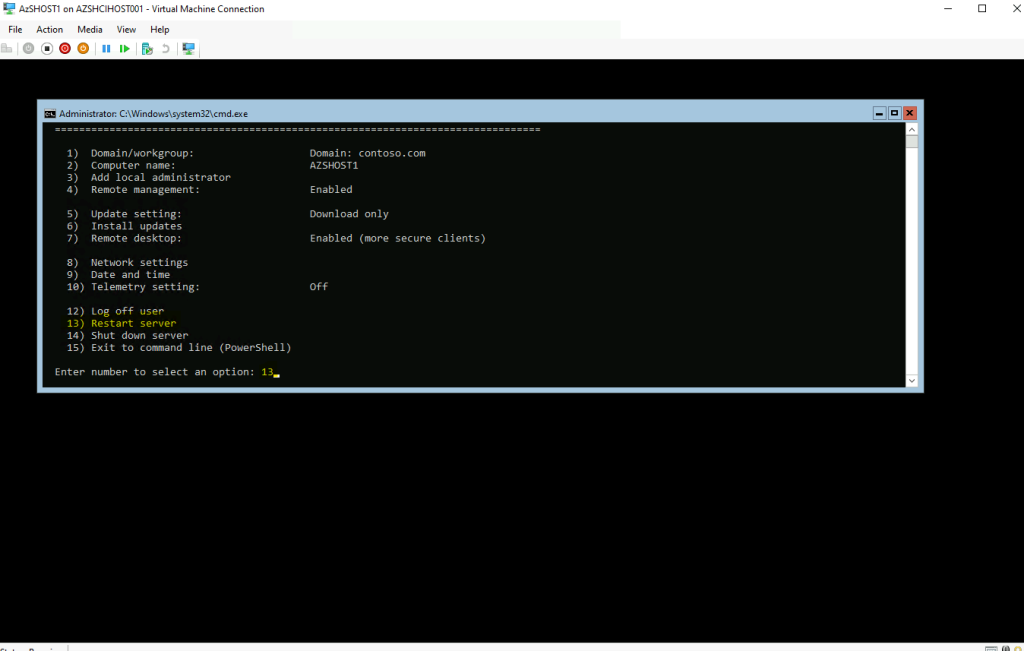

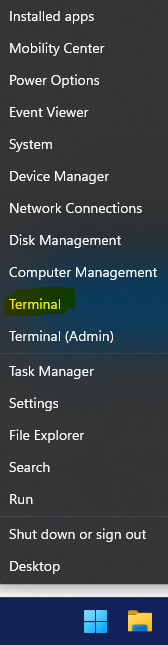

Pour cela, ouvrez une session à distance sur votre VM 2012R2 via le service Azure Bastion en utilisant un compte admin de domaine :

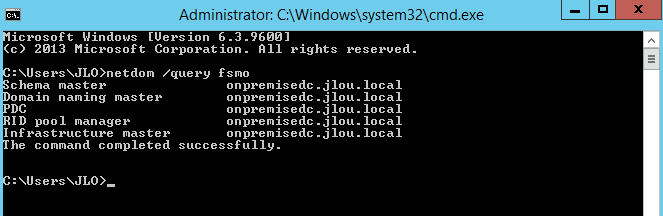

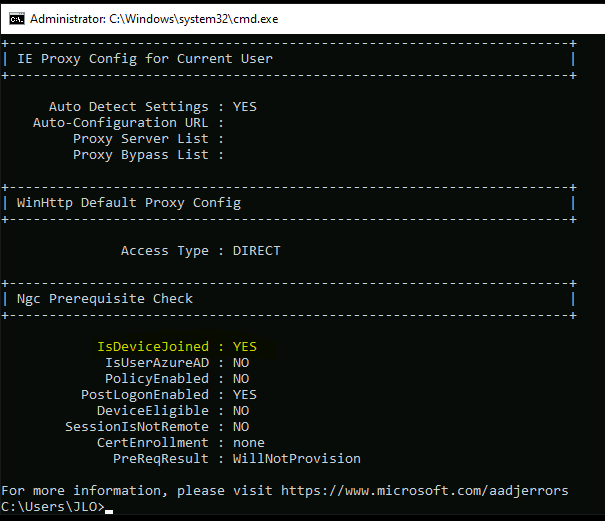

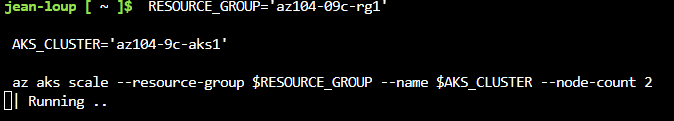

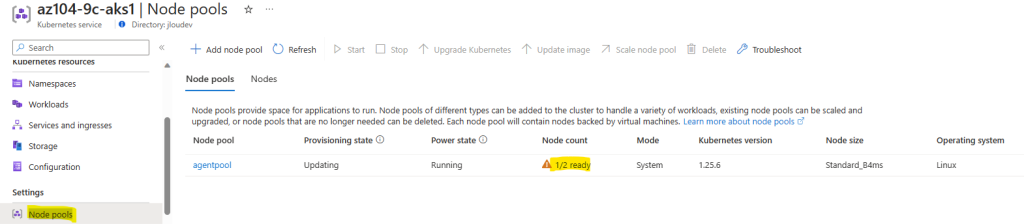

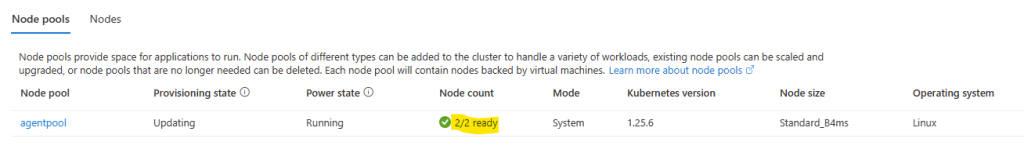

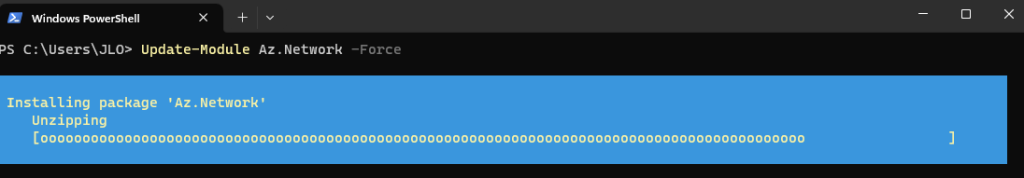

Lancez la commande suivante afin de vérifier sur quel contrôleur de domaine se trouve actuellement les 5 rôles FSMO :

netdom /query fsmoComme attendu, les 5 rôles sont actuellement gérés par le contrôleur de domaine DC2012R2 :

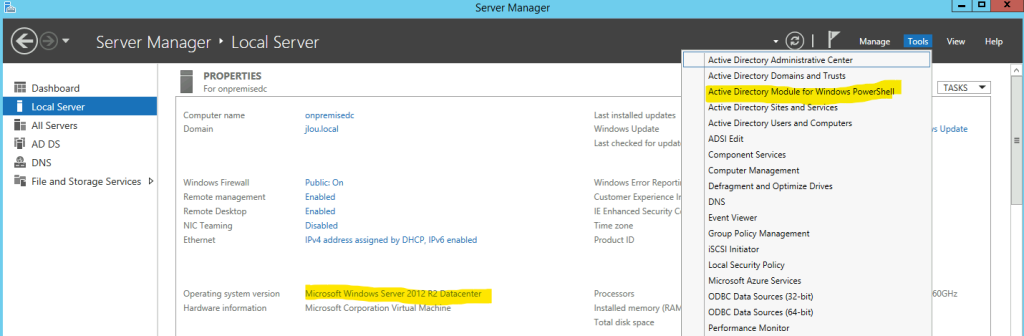

Depuis la console Server Manager du serveur DC2012R2, ouvrez Windows PowerShell avec le module AD :

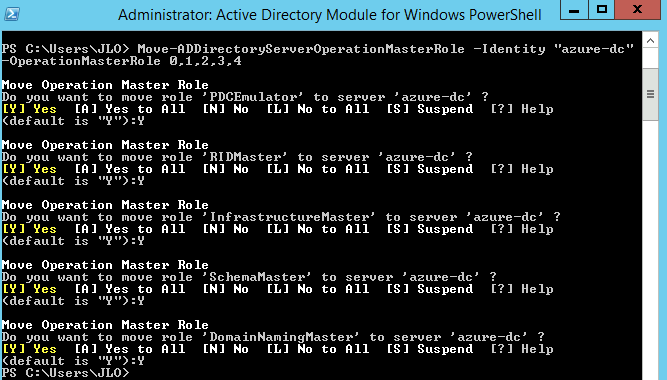

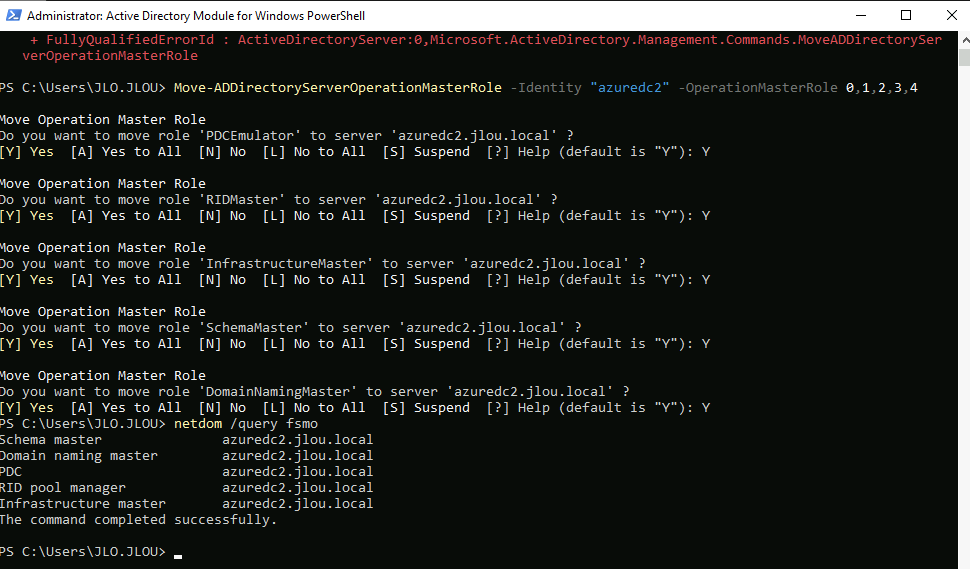

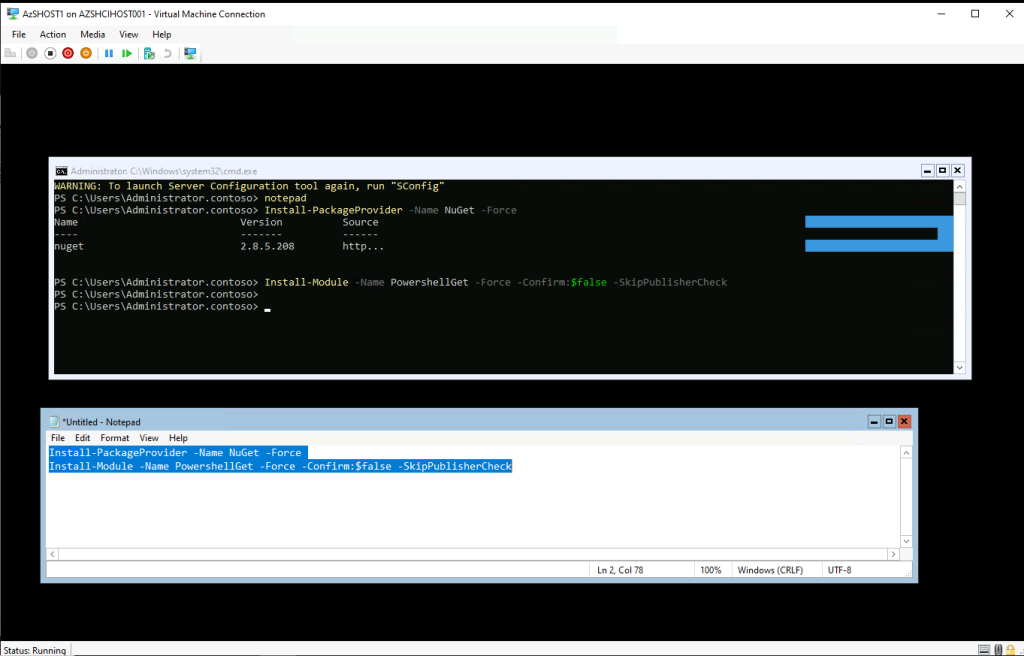

Saisissez la commande suivante pour transférer d’un coup les 5 rôles depuis DC2012R2 vers DC2022, en prenant le soin de modifier le nom en gras par le nom de votre VM :

Move-ADDirectoryServerOperationMasterRole -Identity "azure-dc" -OperationMasterRole 0,1,2,3,4Validez alors chacune des demandes de transfert de rôle :

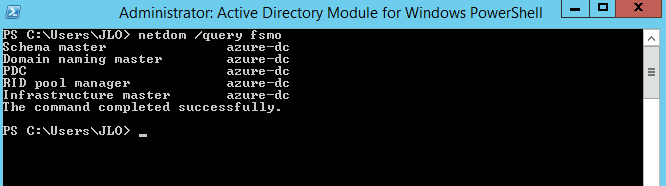

Relancez la commande suivante afin de vérifier le changement de contrôleur de domaine pour les 5 rôles FSMO :

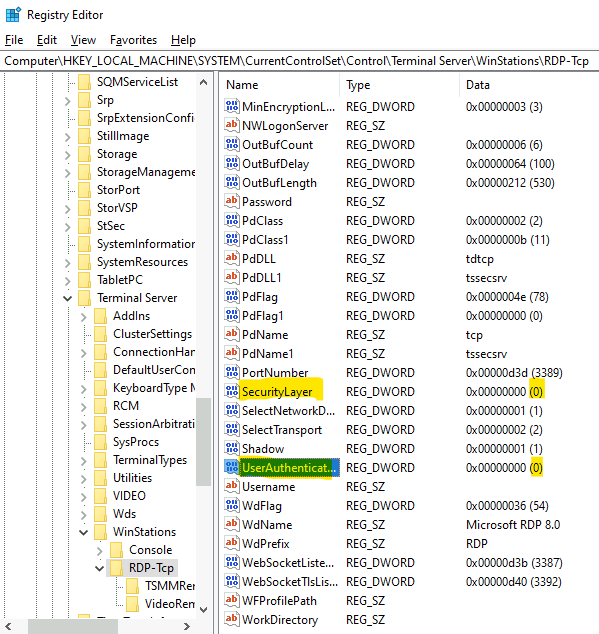

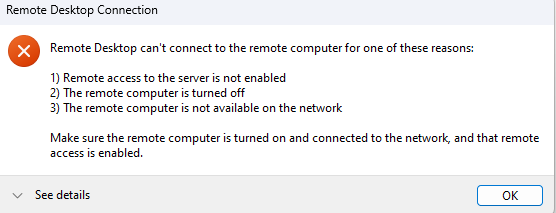

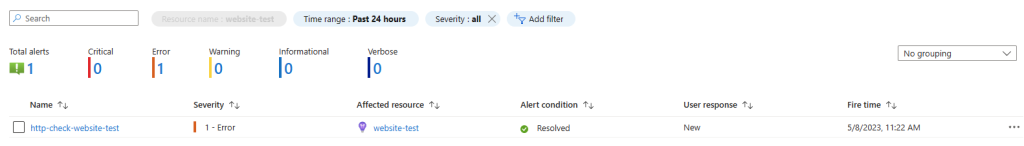

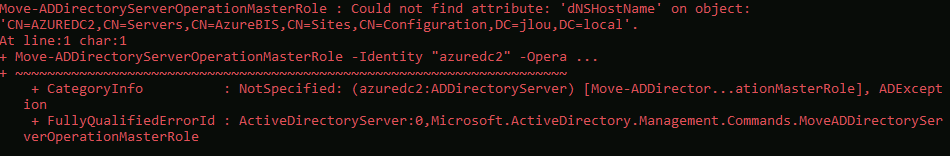

netdom /query fsmoSi vous rencontrez le message d’erreur suivant :

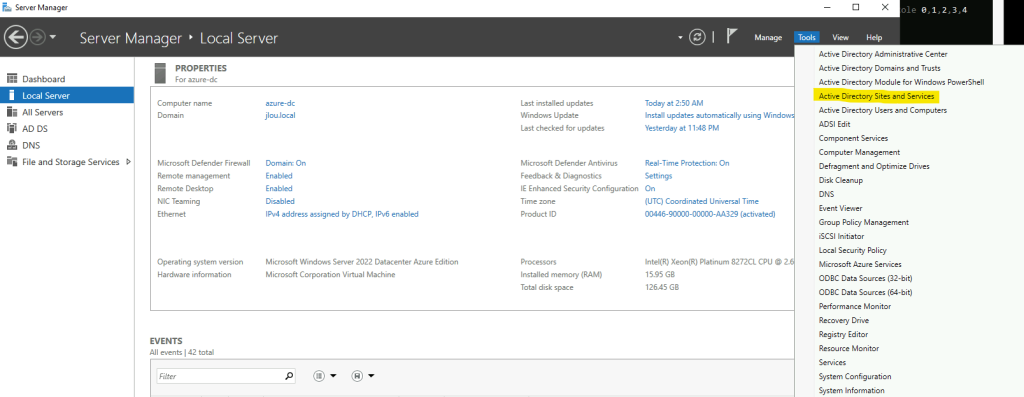

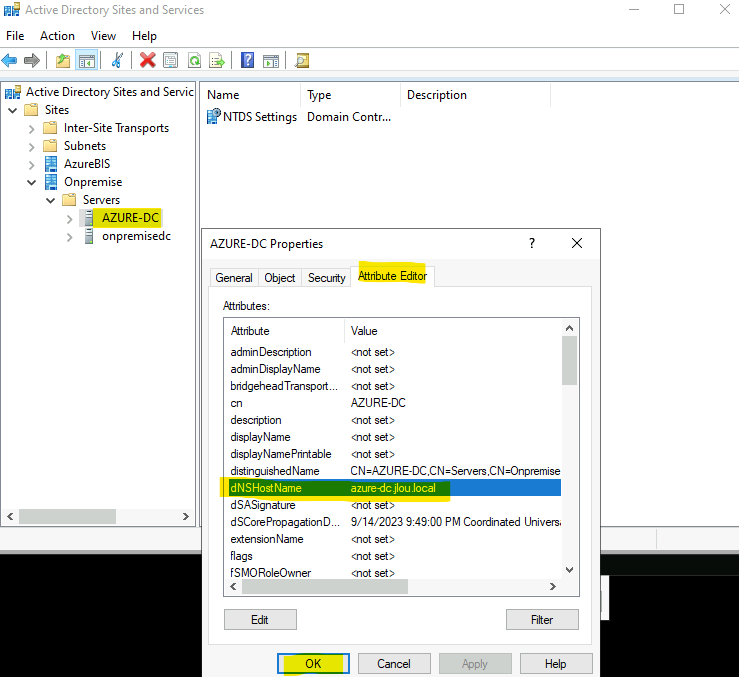

Depuis la console Server Manager, ouvrez Active Directory Sites et Services :

Corriger la valeur à vide de l’attribut dNSHostName :

Puis relancez la commande suivante :

Move-ADDirectoryServerOperationMasterRole -Identity "azure-dc" -OperationMasterRole 0,1,2,3,4Vous pouvez maintenant décommissionnnez votre serveur DC2012R2.

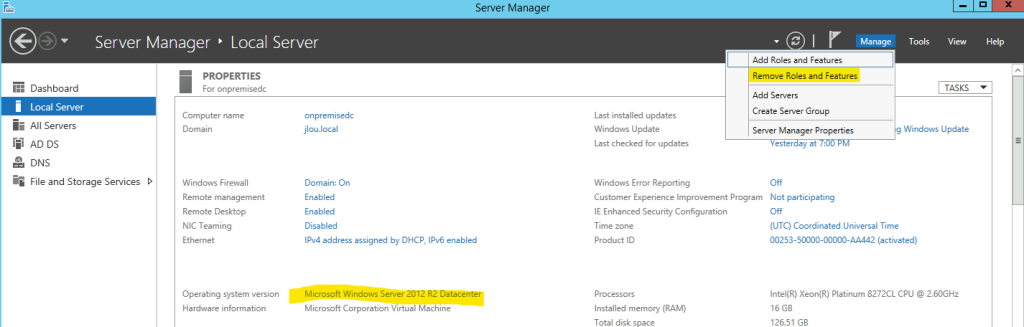

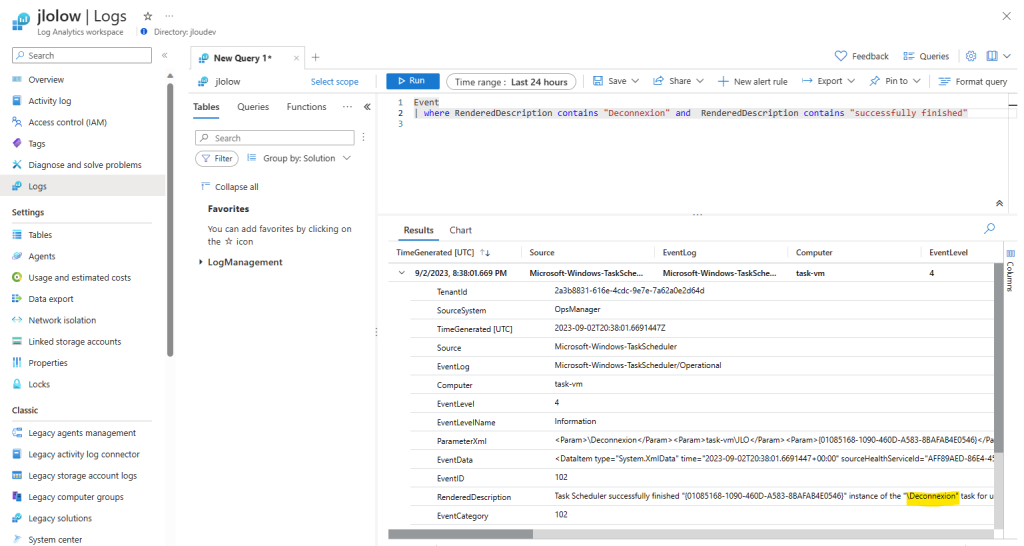

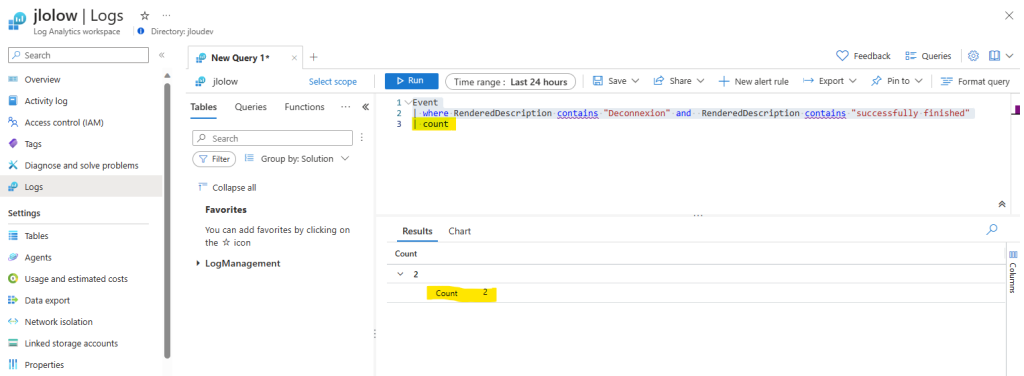

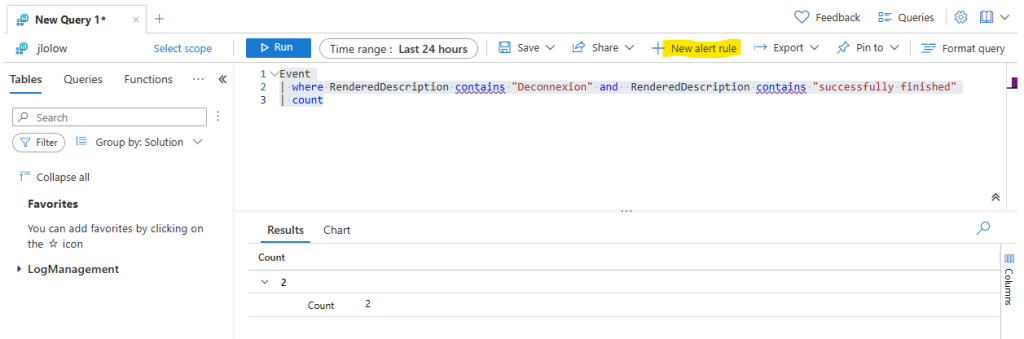

Etape V – Décommissionnement l’Active Directory DC2012R2 :

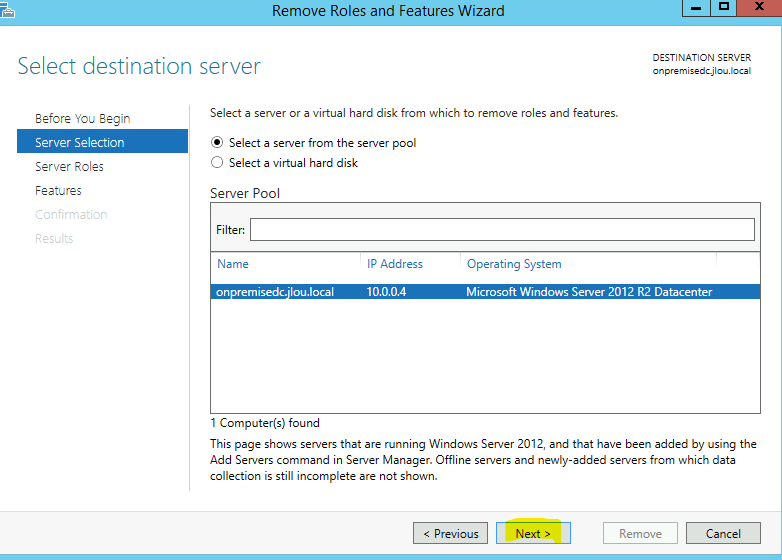

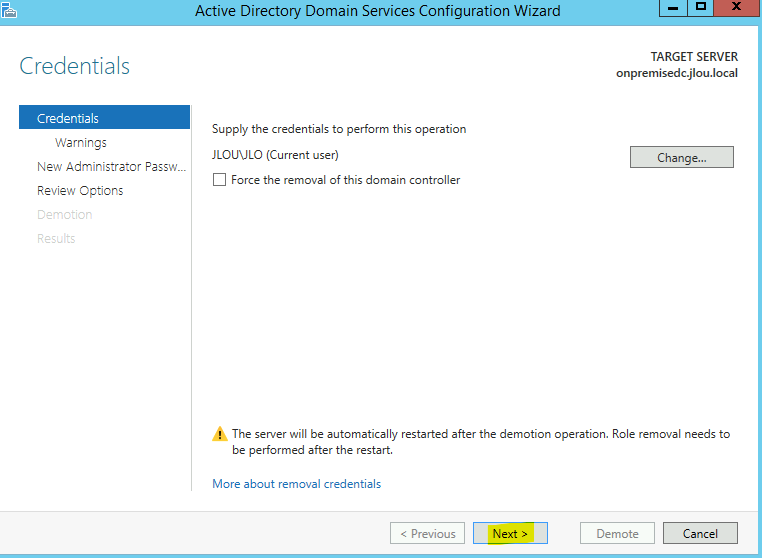

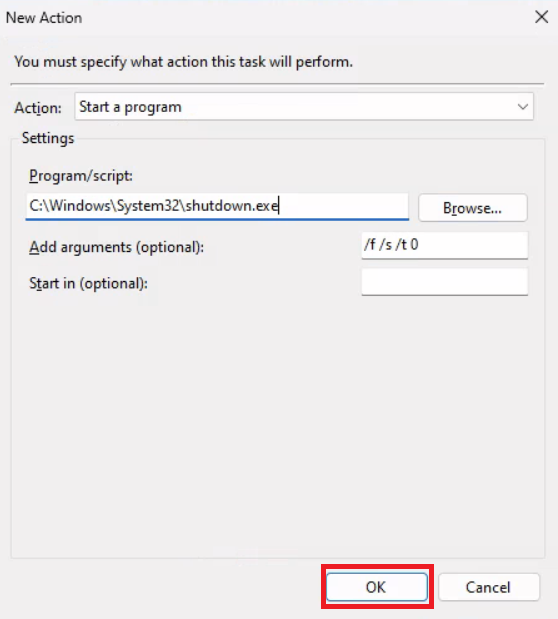

Pour faire les choses dans l’ordre, cliquez sur la fonction de désinstallation présente dans la console Server Manager se trouvant sur votre serveur DC2012R2 :

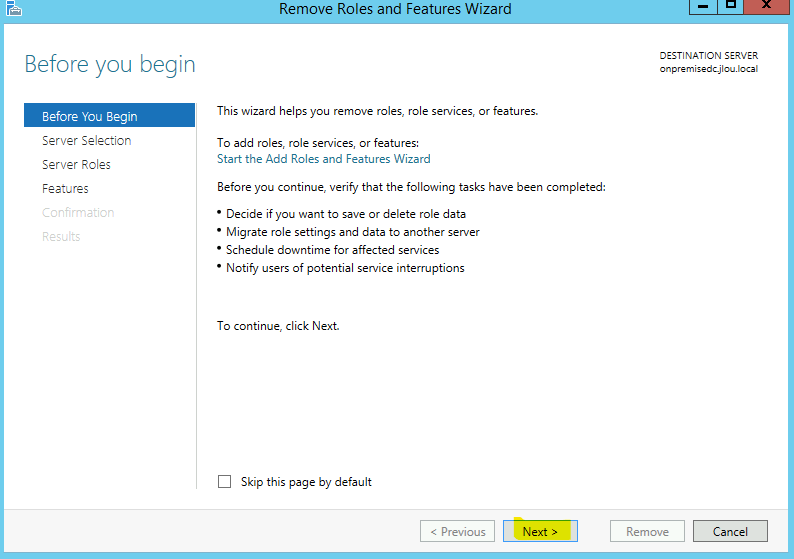

Cliquez sur Suivant :

Cliquez sur Suivant :

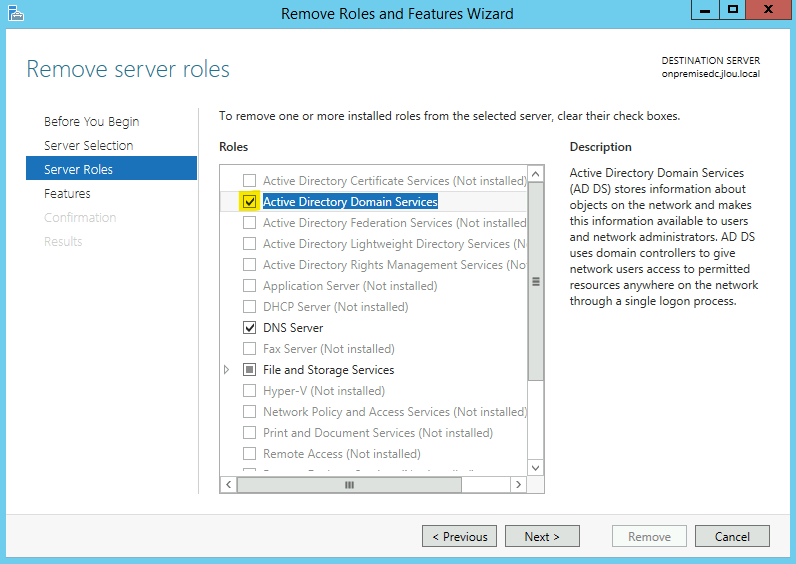

Décochez les deux rôles AD DS et DNS, puis cliquez sur Suivant :

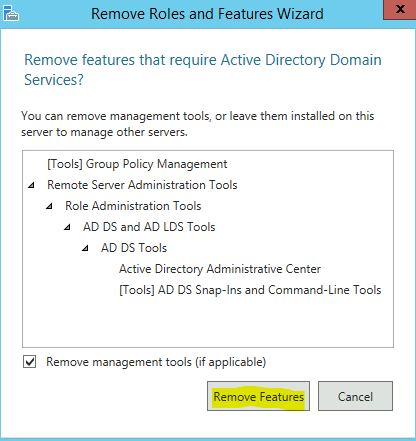

Cliquez-ici pour confirmer votre choix :

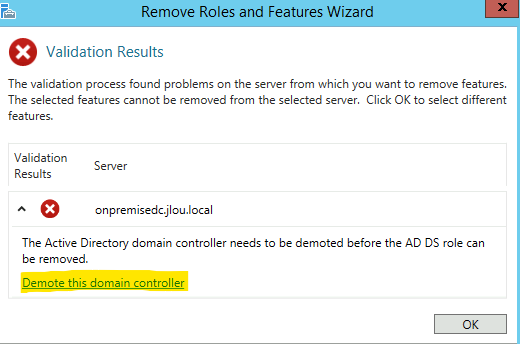

Le message d’erreur suivi est attendu, la d’installation de rôles en activité ne peut que se faire qu’après un premier décommissionnement au niveau du domaine.

Cliquez-ici pour commencer l’opération :

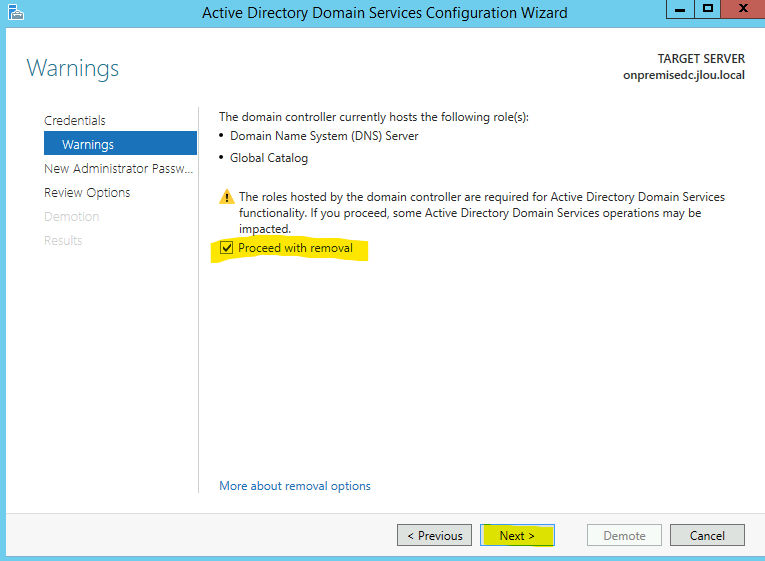

Cliquez sur Suivant :

Cochez la case suivante pour également procéder pour la partie DNS, puis cliquez sur Suivant :

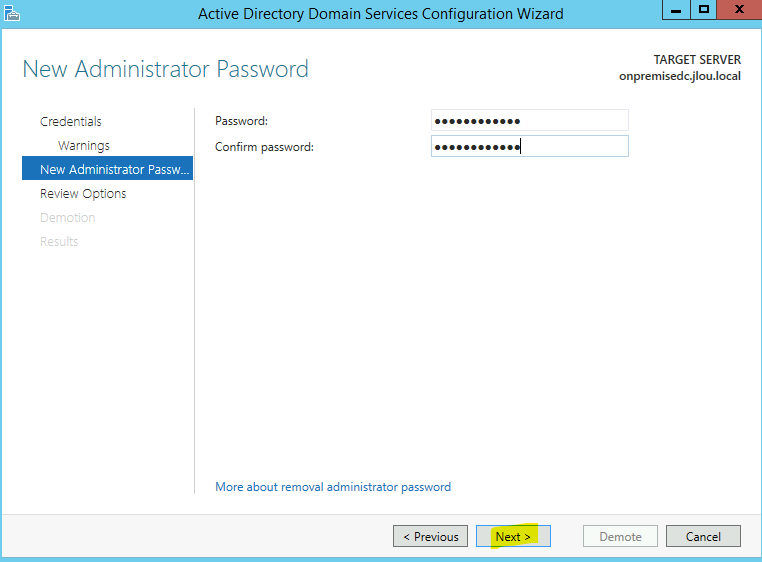

Définissez un nouveau mot de passe pour le compte d’administrateur local Windows :

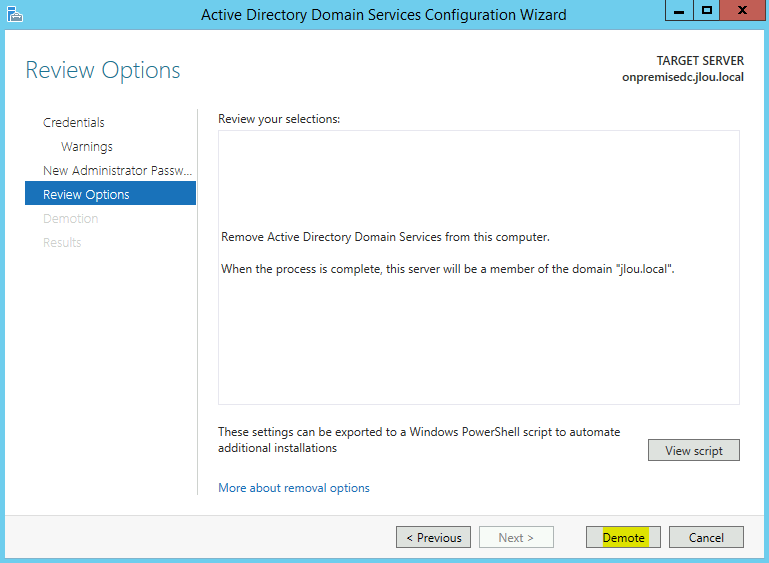

Cliquez sur Rétrograder :

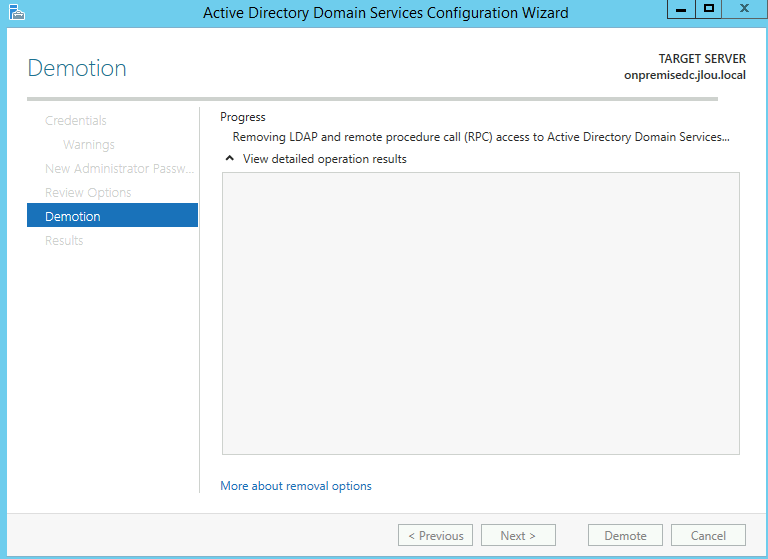

Attendez quelques minutes que le traitement se termine :

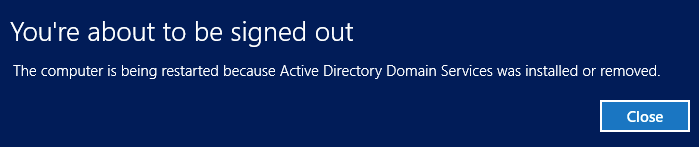

Le serveur DC2012R2 a besoin d’effectuer un redémarrage OS pour terminer la rétrogradation :

Azure Bastion vous informe alors que la connexion RDP a été perdue. Cliquez sur Fermer :

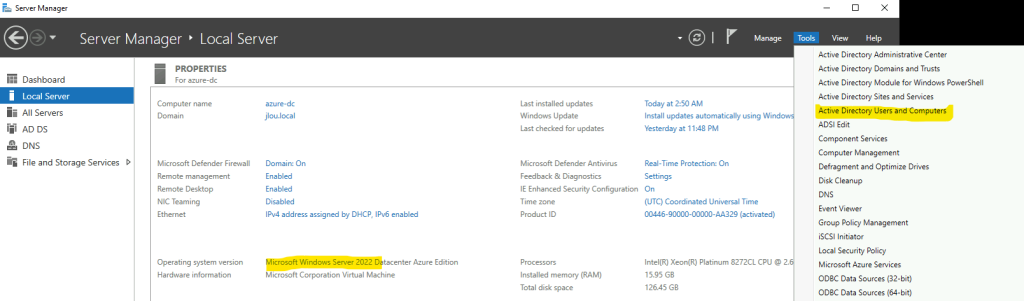

Retournez sur Server Manager de votre DC2022 d’Azure pour ouvrir Active Directory Utilisateurs et Ordinateurs :

Comme attendu, il ne reste que le DC2022 hébergé sous Azure :

Configurez le DNS de votre réseau Azure pour qu’il pointe plus que sur l’adresse IP de votre DC2022, puis cliquez sur Sauvegarder :

Effectuez la même opération sur le DNS du réseau on-premise, puis cliquez sur Sauvegarder :

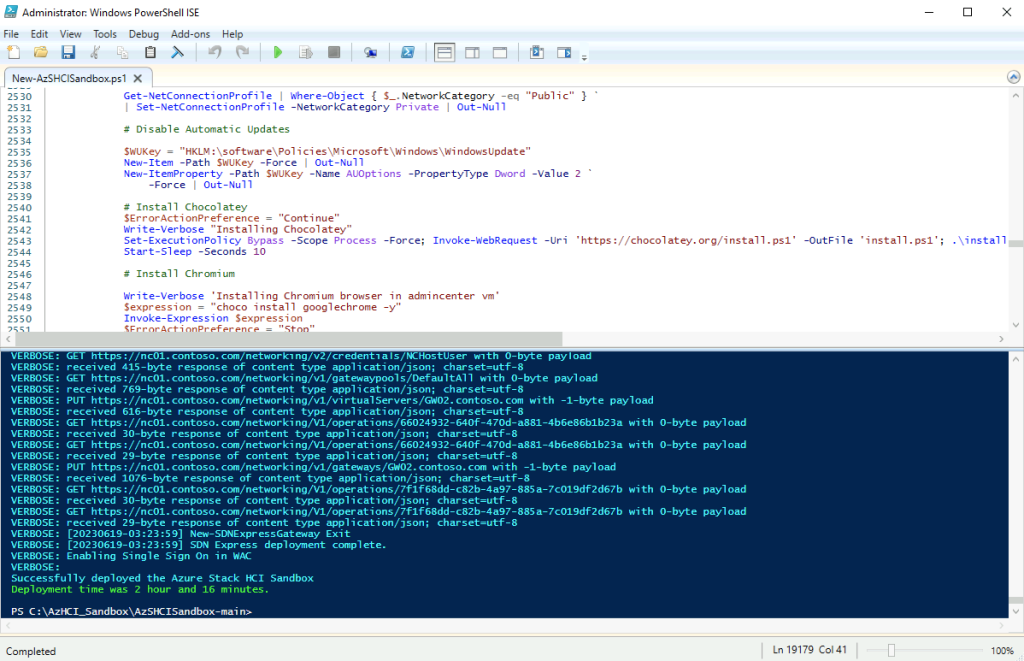

Nous environnement Active Directory est maintenant 100% Cloud. Nous allons pouvoir mettre à jour le niveau domaine fonctionnel vers une version plus récente.

Etape VI – Mise à niveau du domaine Active Directory :

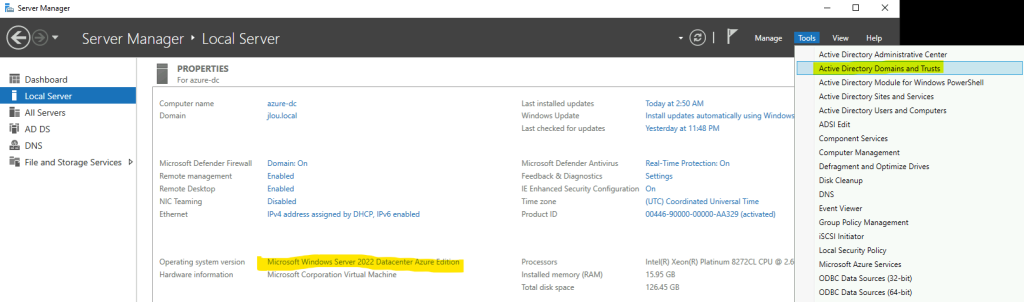

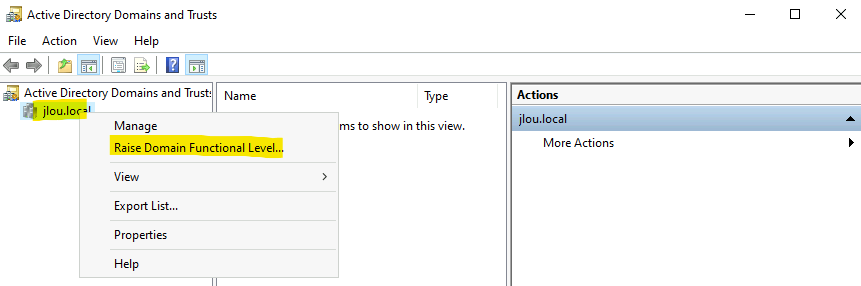

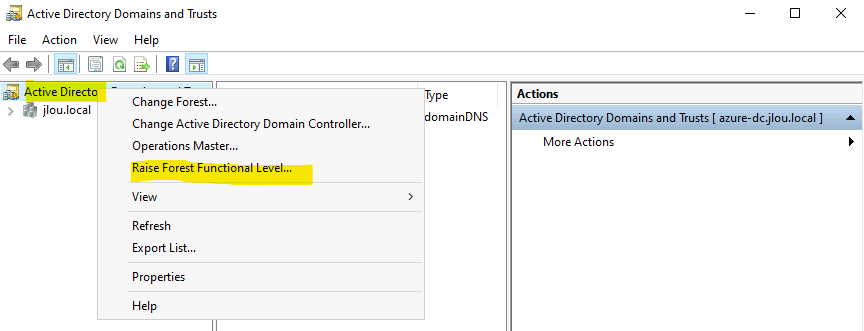

Pour cela, retournez sur la console Server Manager de votre DC2022 d’Azure, puis ouvrez Active Directory Domains and Trusts :

Commencez par élever le niveau fonctionnel du domaine sur chaque domaine de votre forêt :

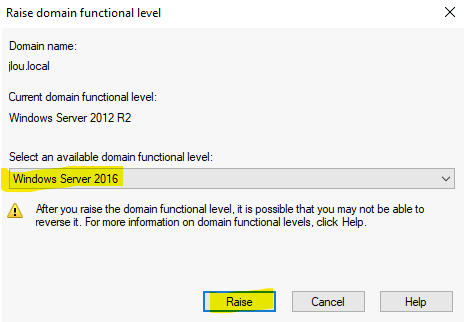

Choisissez la version la plus récente possible, puis cliquez sur Elever :

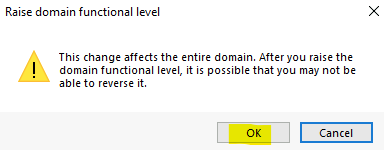

Cliquez sur OK :

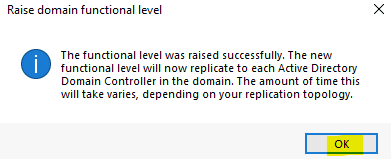

Cliquez sur OK :

Une fois tous les domaines modifiés, effectuez la même opération au niveau de la forêt AD :

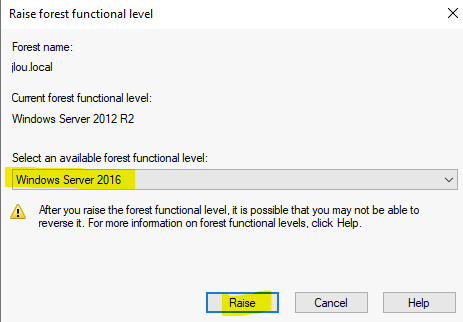

Là encore, choisissez la version la plus récente possible, puis cliquez sur Elever :

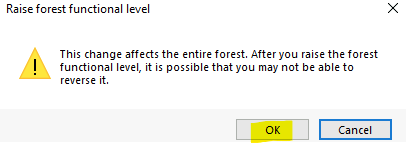

Cliquez sur OK :

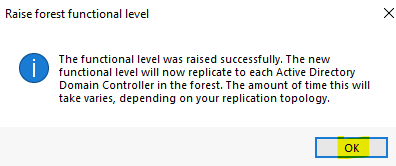

Cliquez sur OK :

Toutes les opérations de transfert ou de mise à jour sont maintenant terminées. Il ne nous reste plus qu’à tester le bon fonctionnement de notre Active Directory dans Azure.

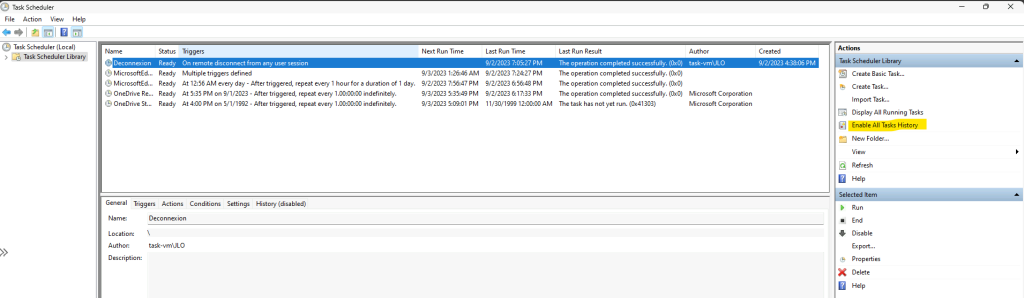

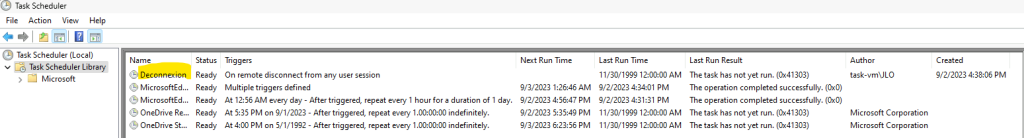

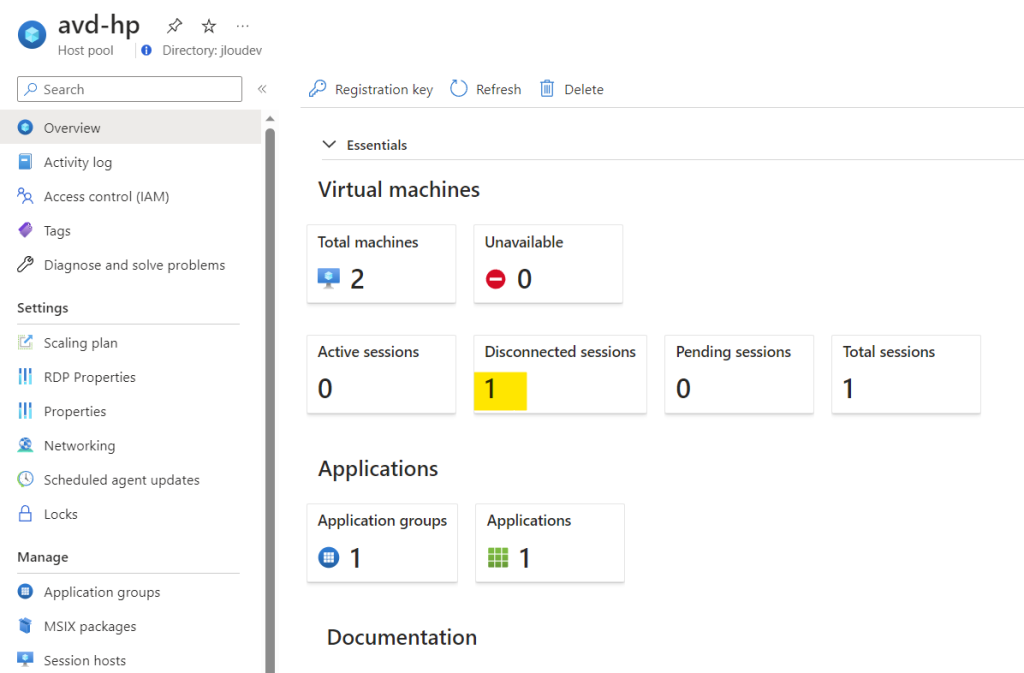

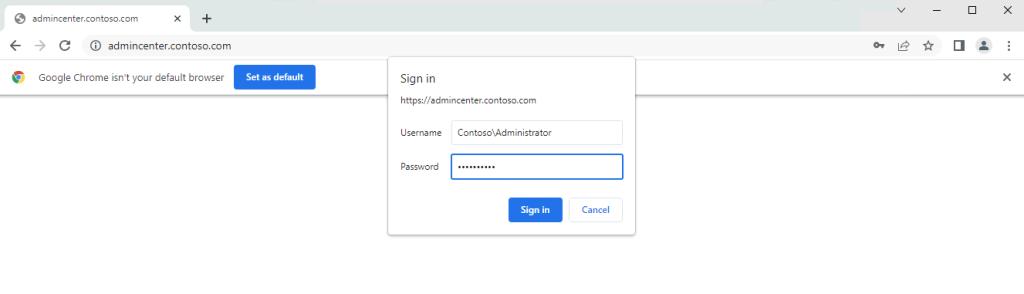

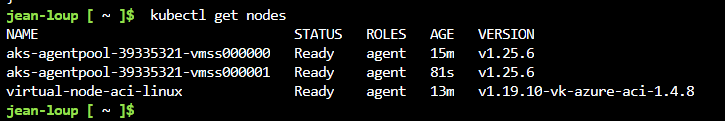

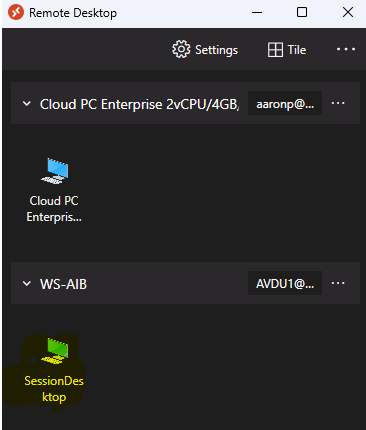

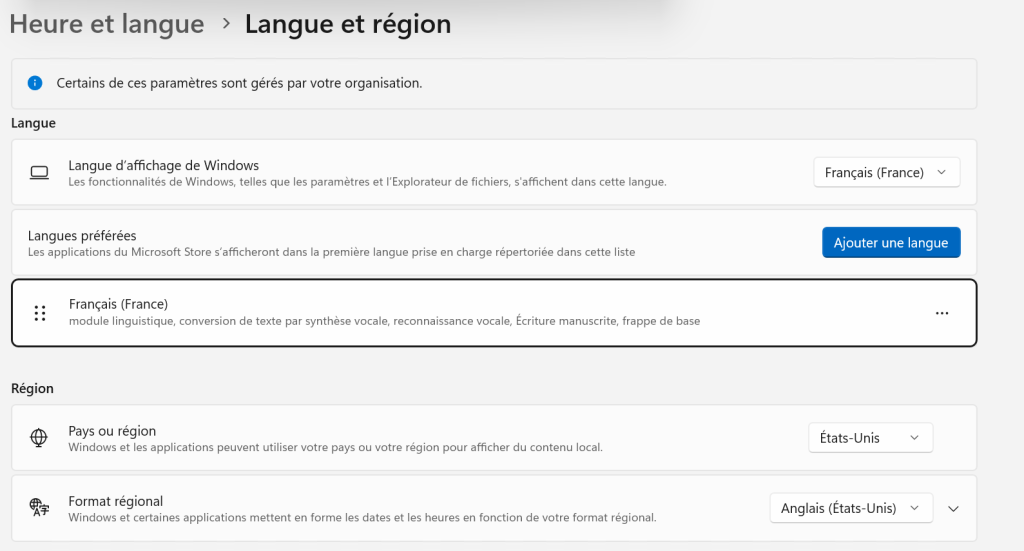

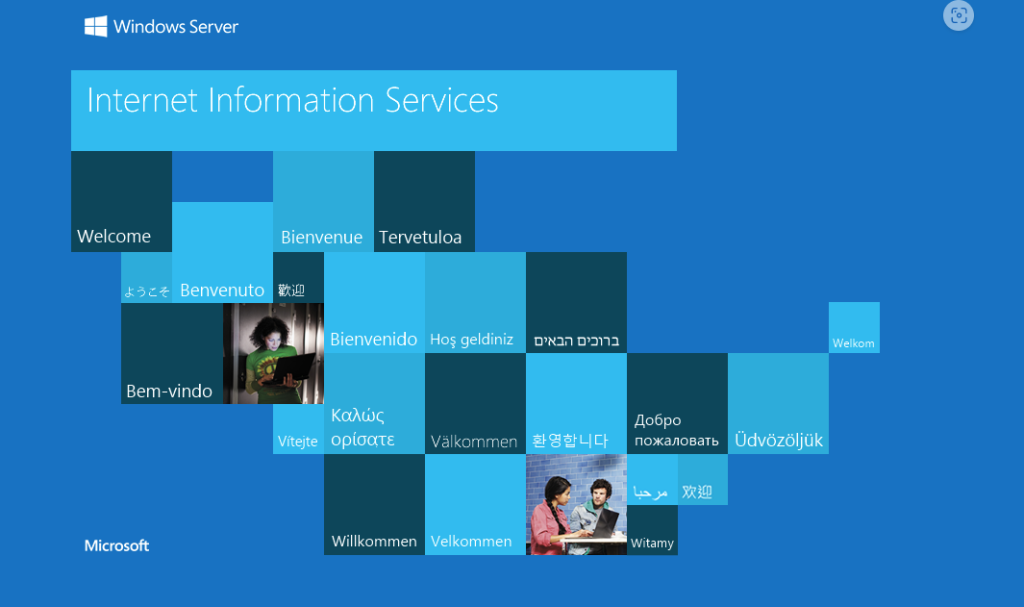

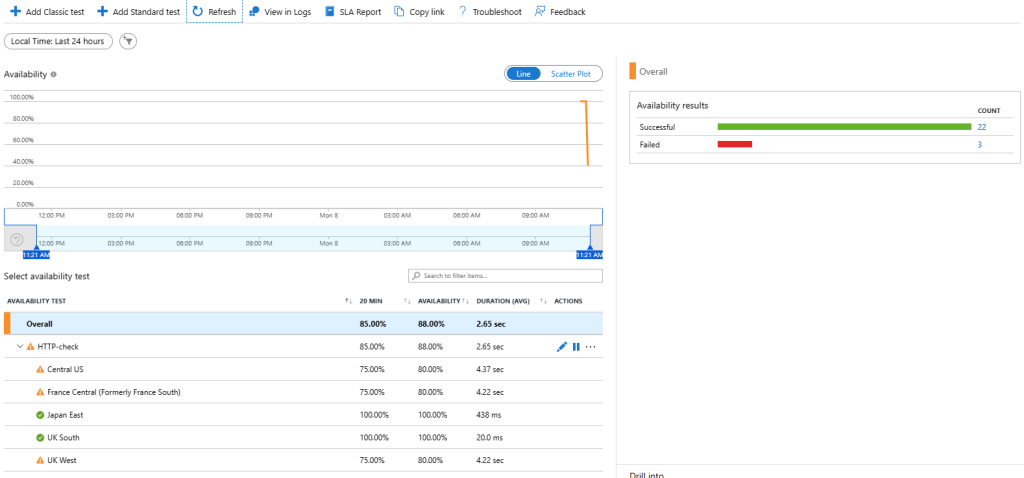

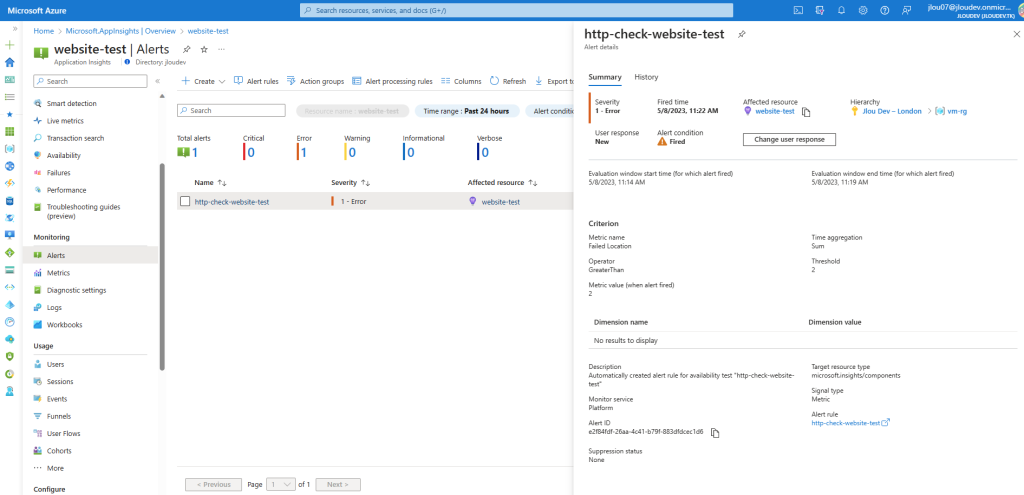

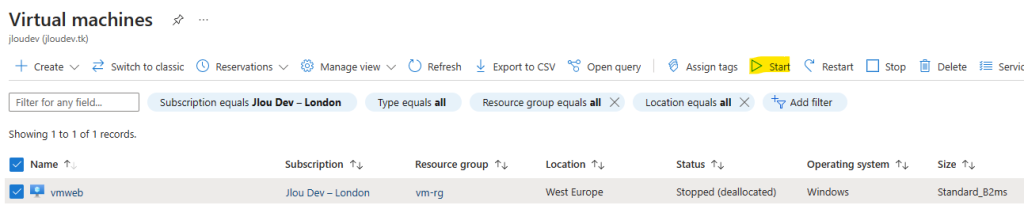

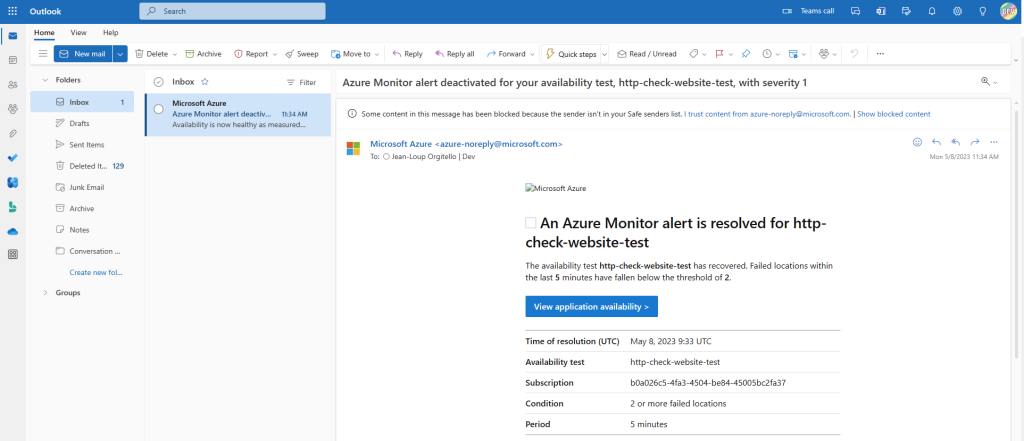

Etape VII – Test de connexion depuis le réseau on-premise :

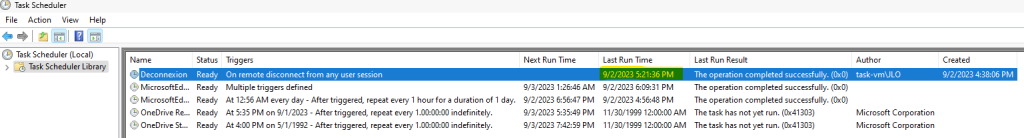

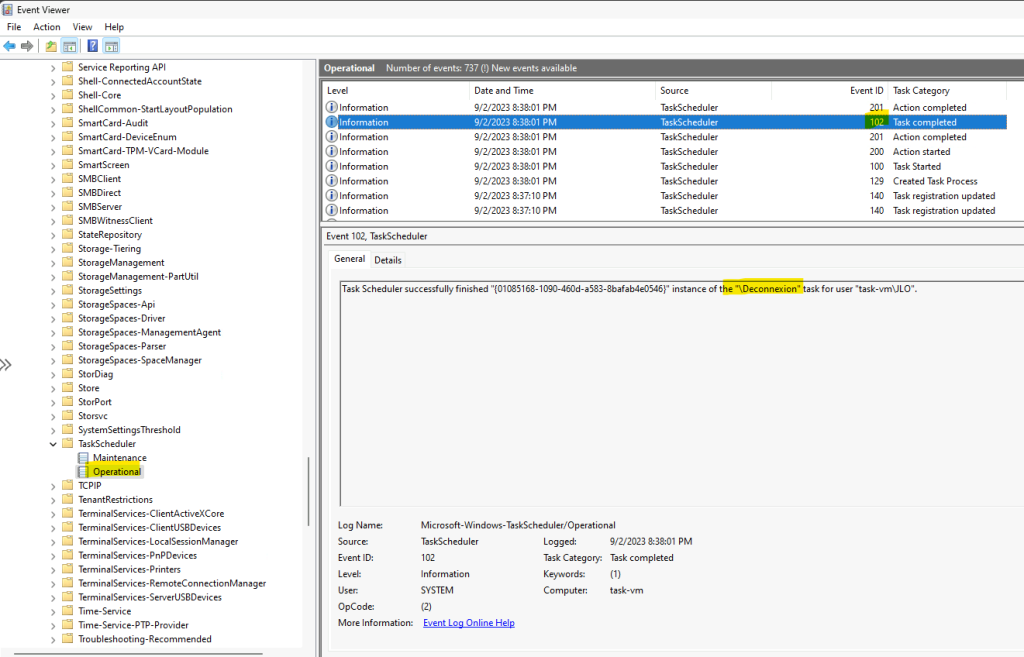

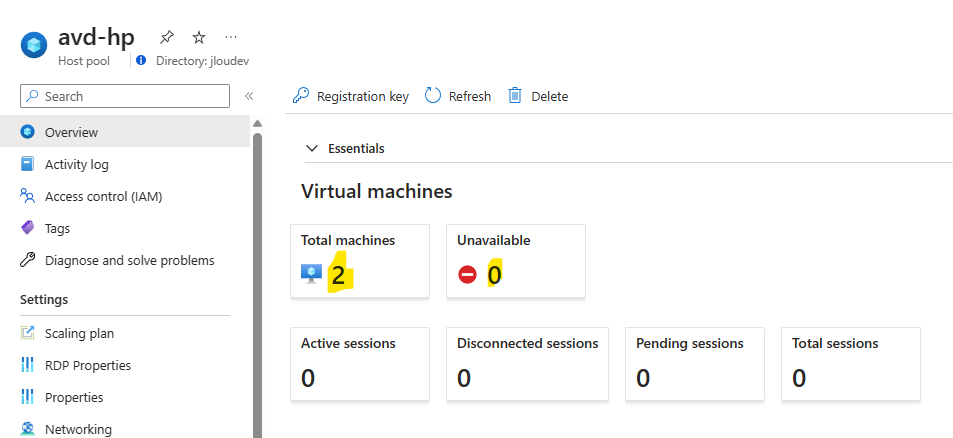

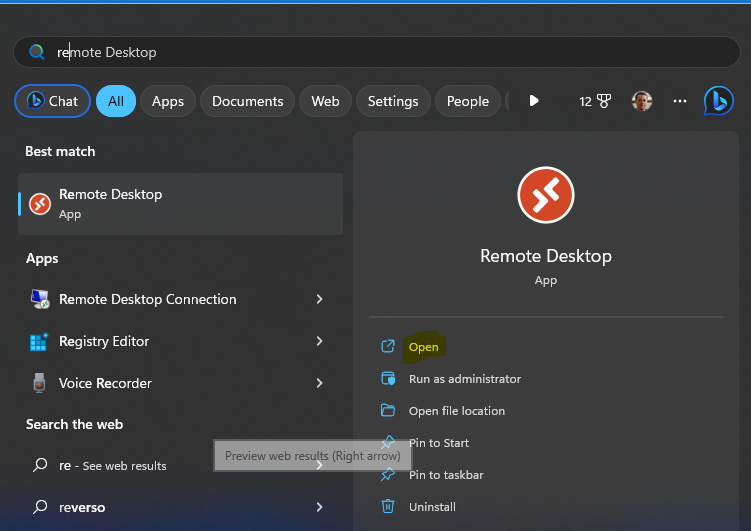

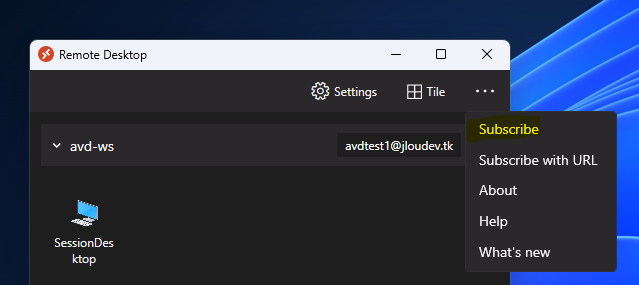

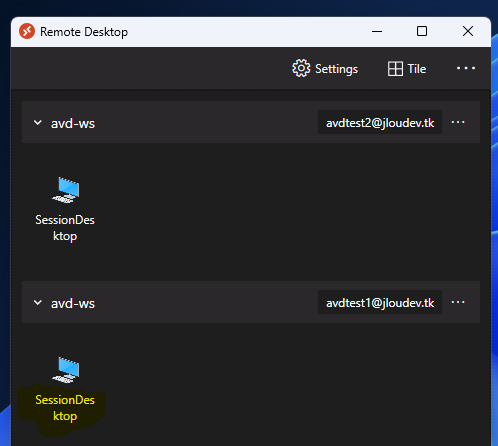

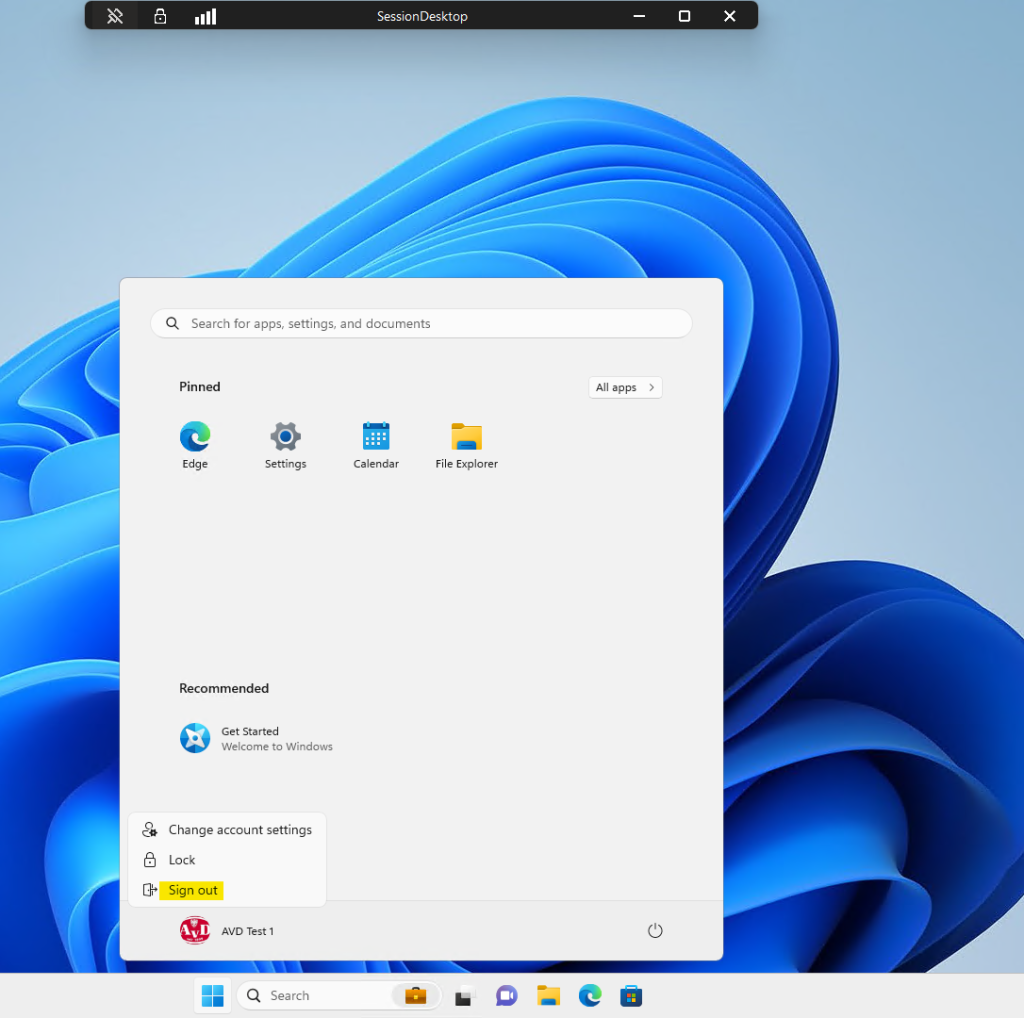

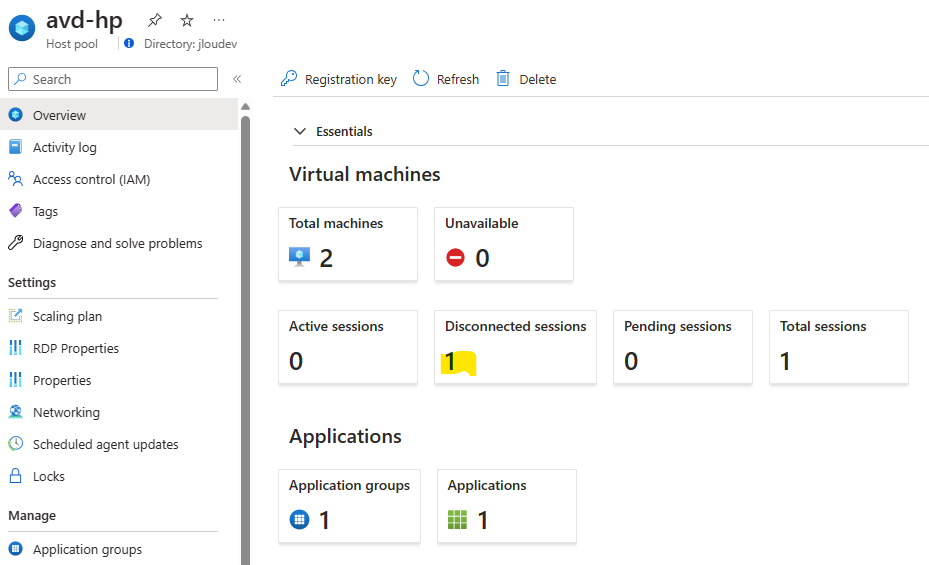

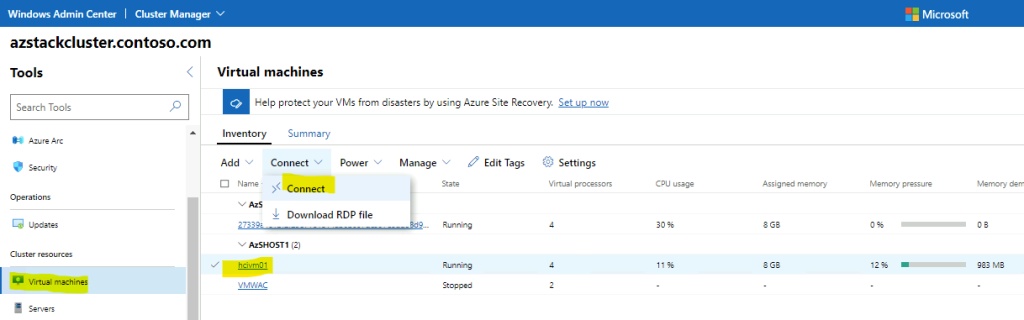

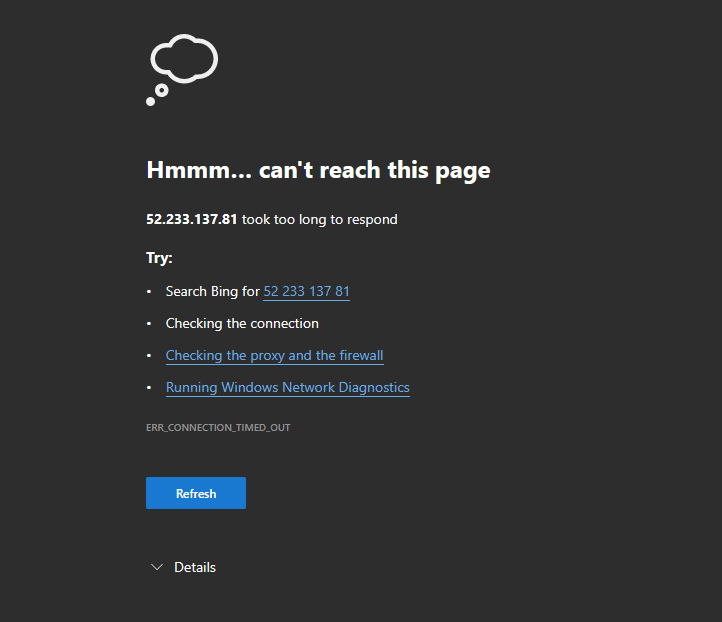

Pour tester notre AD dans Azure, nous utiliserons une machine virtuelle Windows 11 connectée au réseau on-premise (donc transitant par le lien VPN).

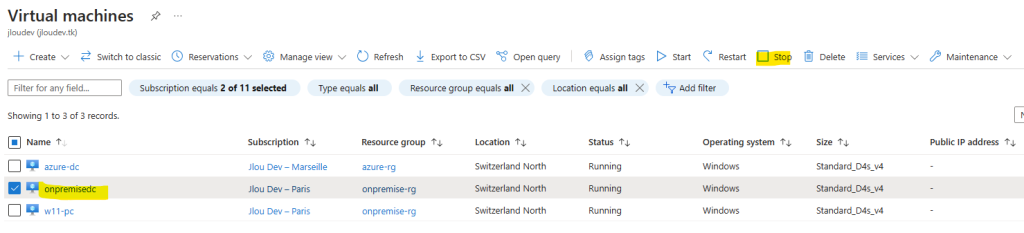

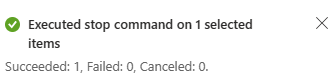

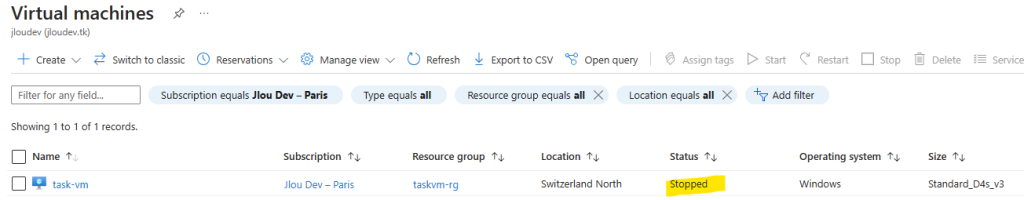

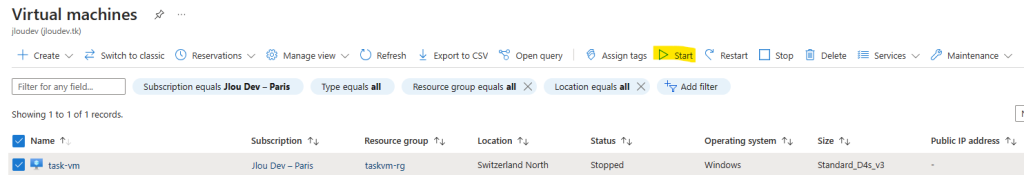

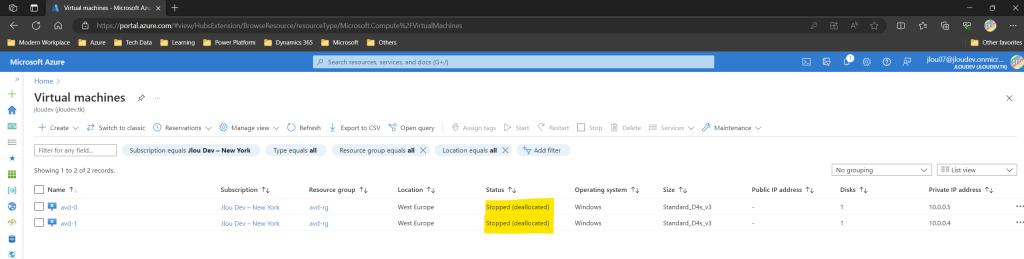

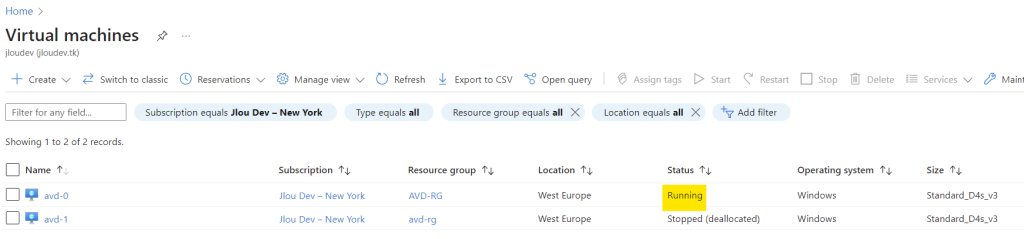

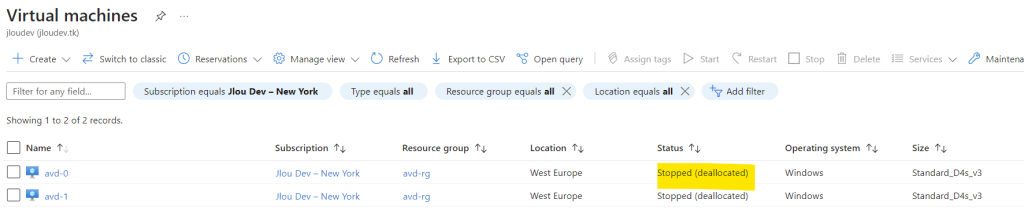

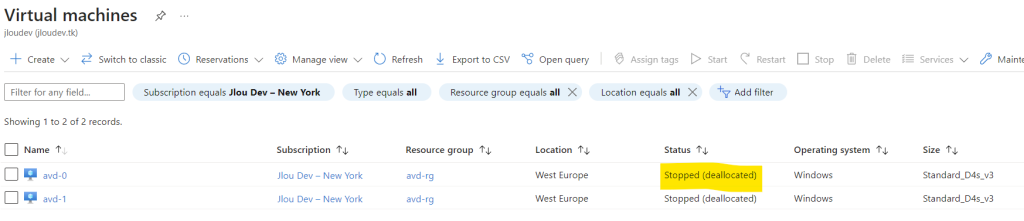

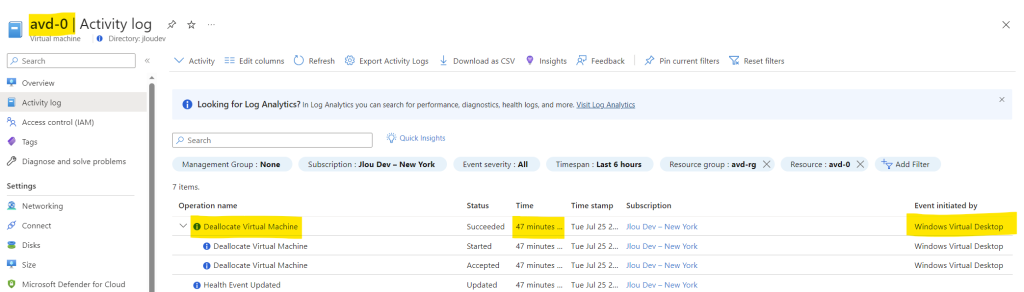

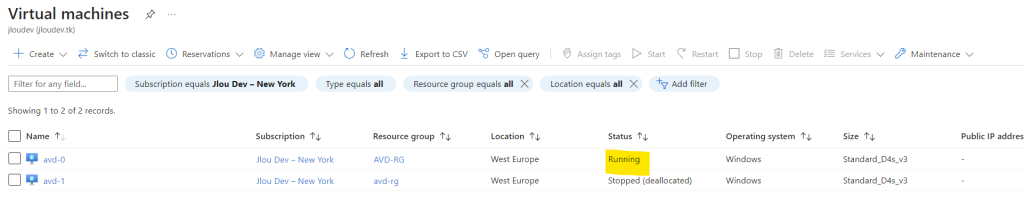

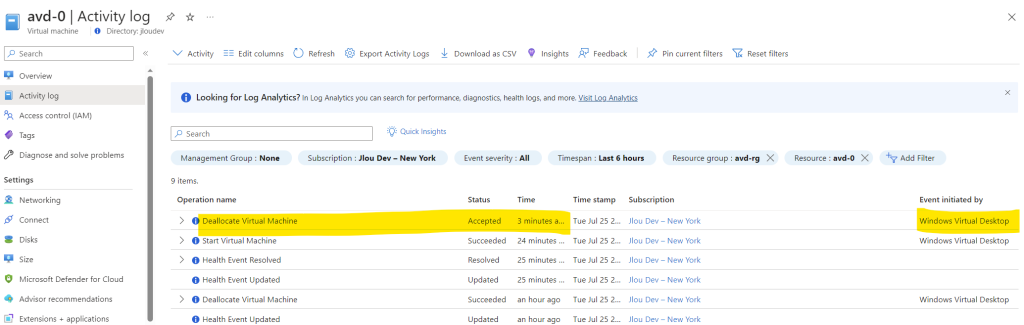

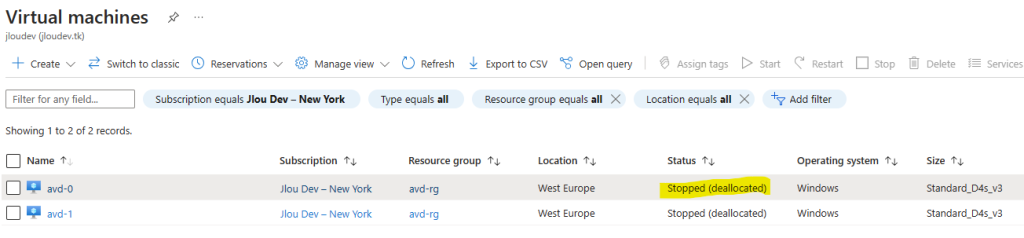

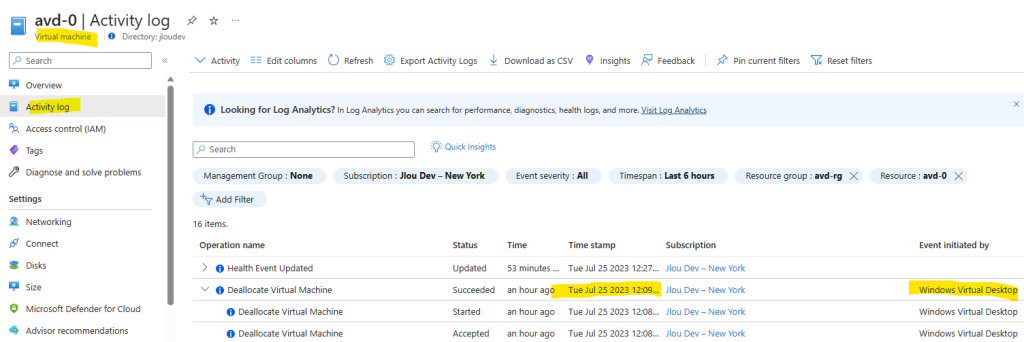

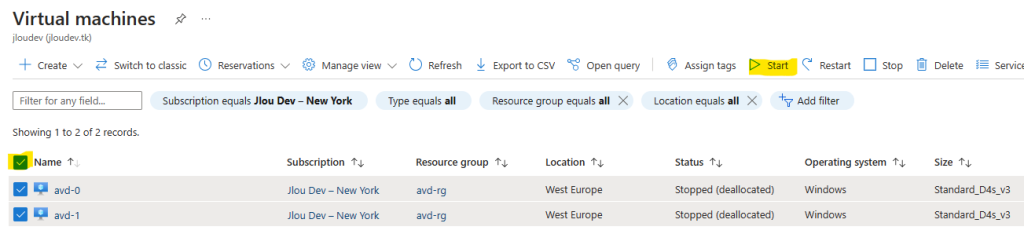

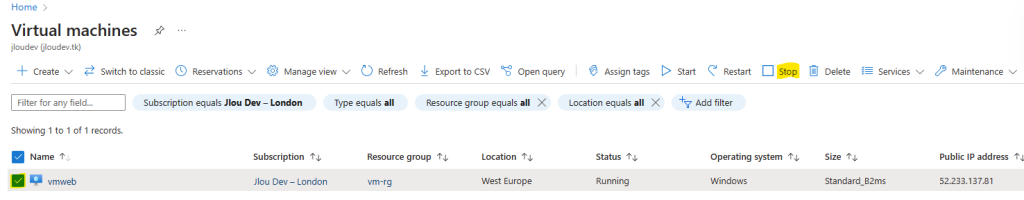

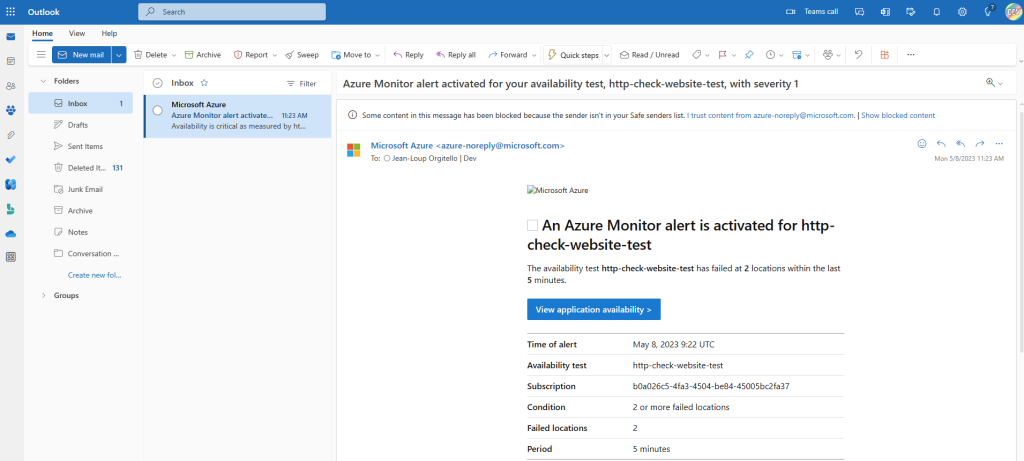

Sur la page de machines virtuelles Azure, éteignez le DC2012R2 afin de ne pas fausser le test de bon fonctionnement :

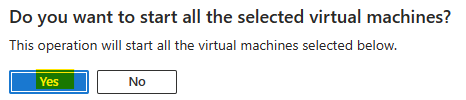

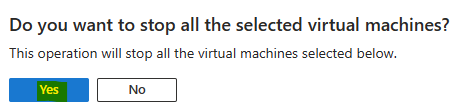

Confirmez votre choix en cliquant sur Oui :

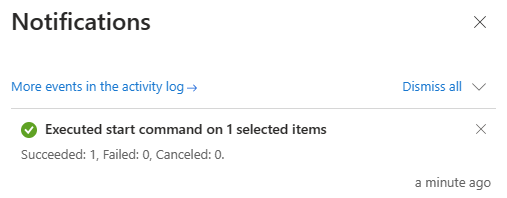

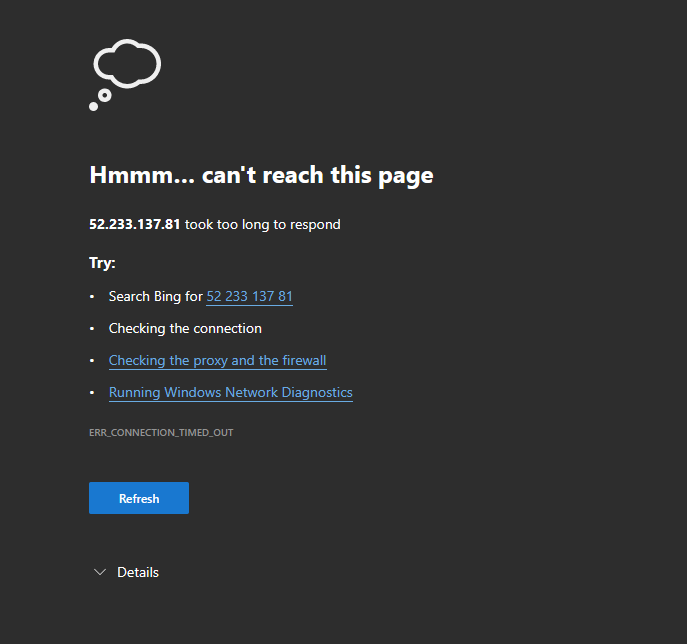

Attendez l’apparition de la notification Azure suivante :

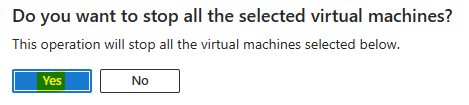

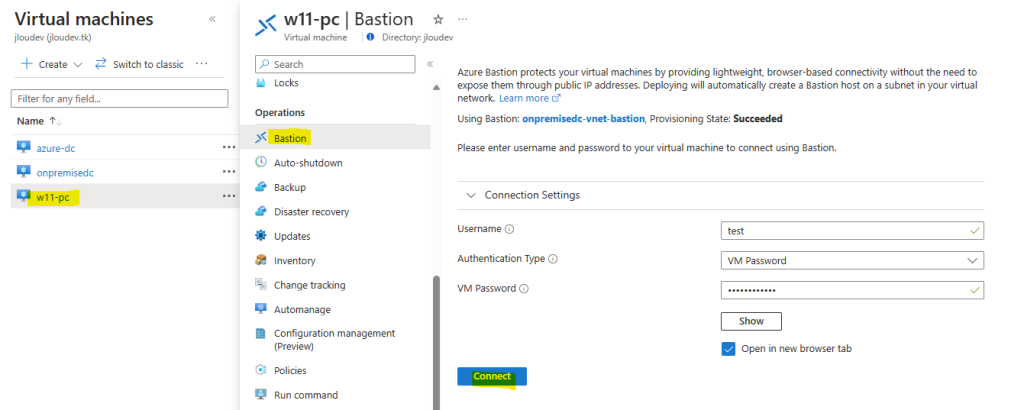

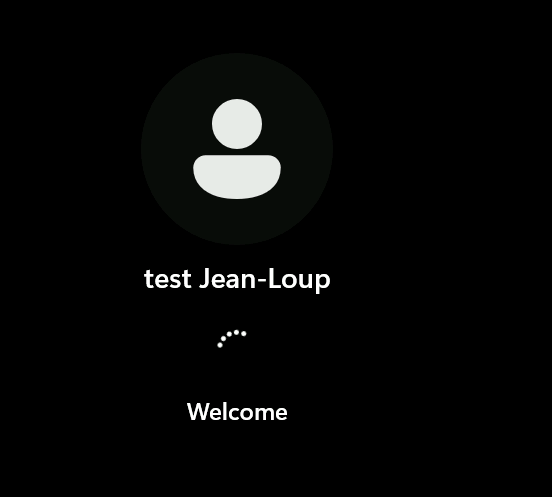

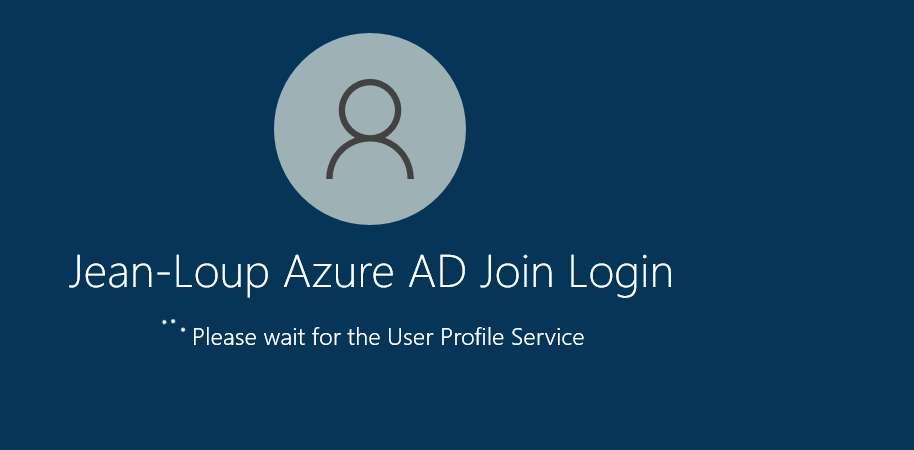

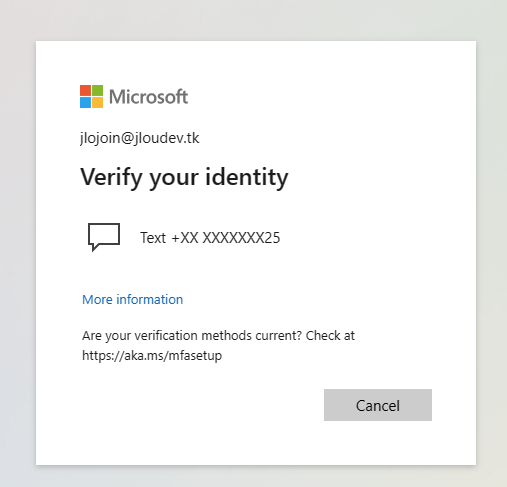

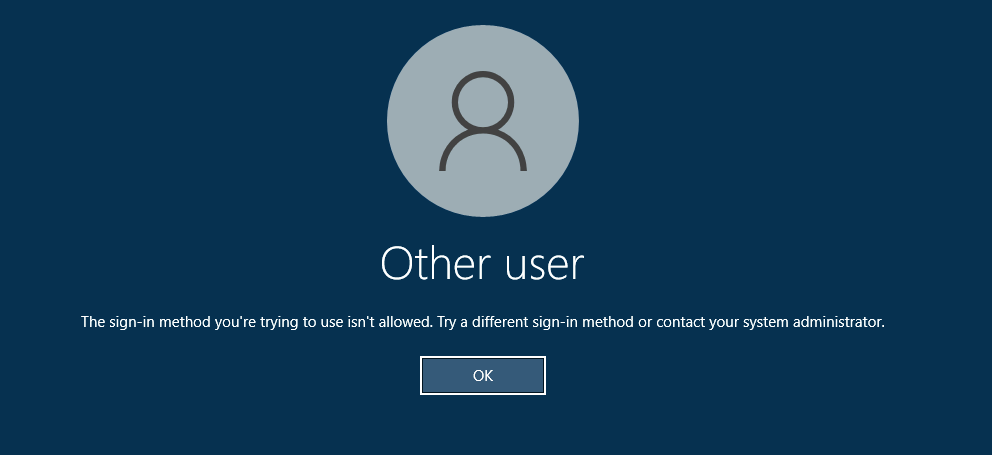

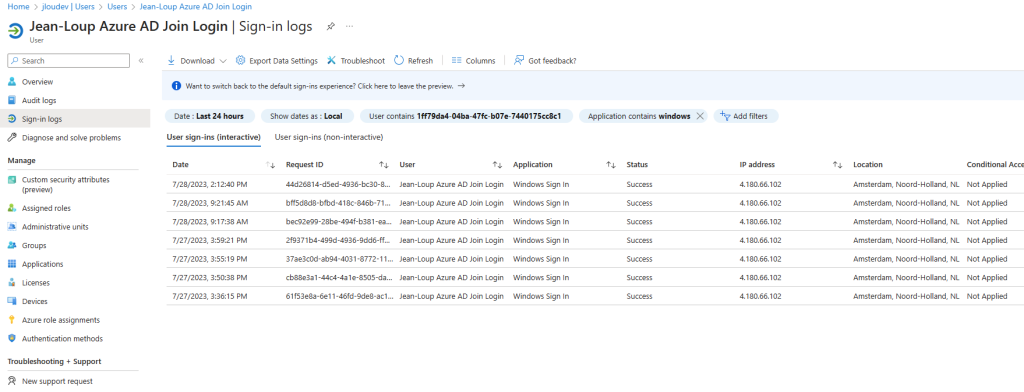

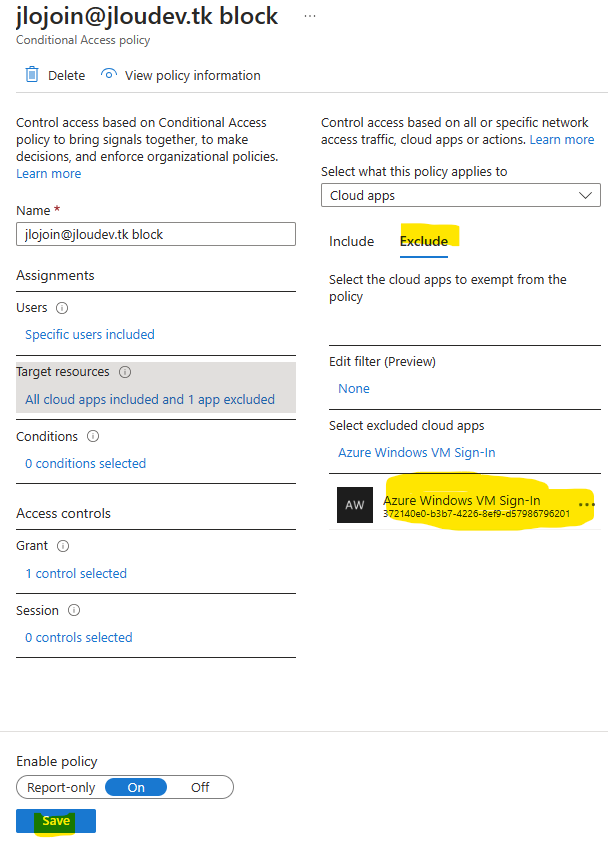

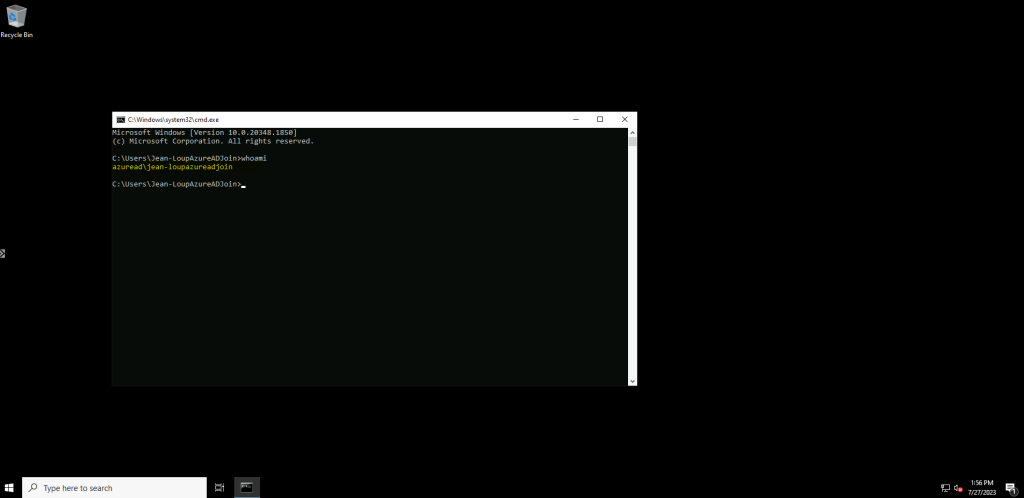

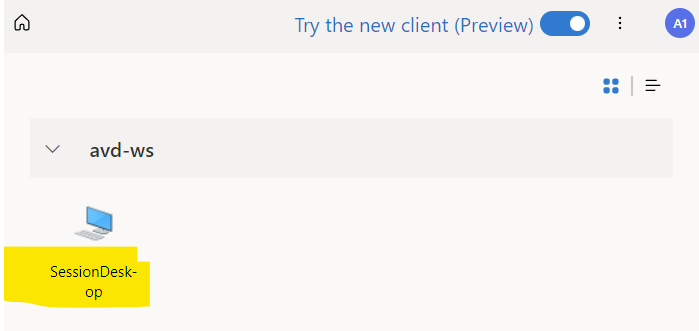

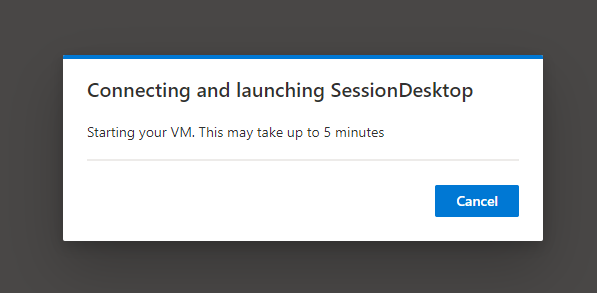

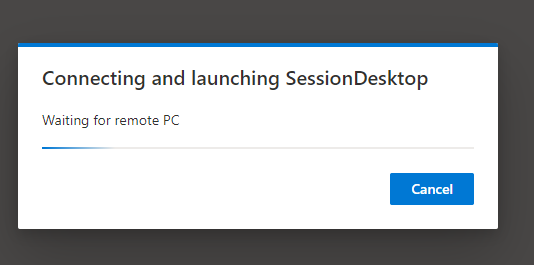

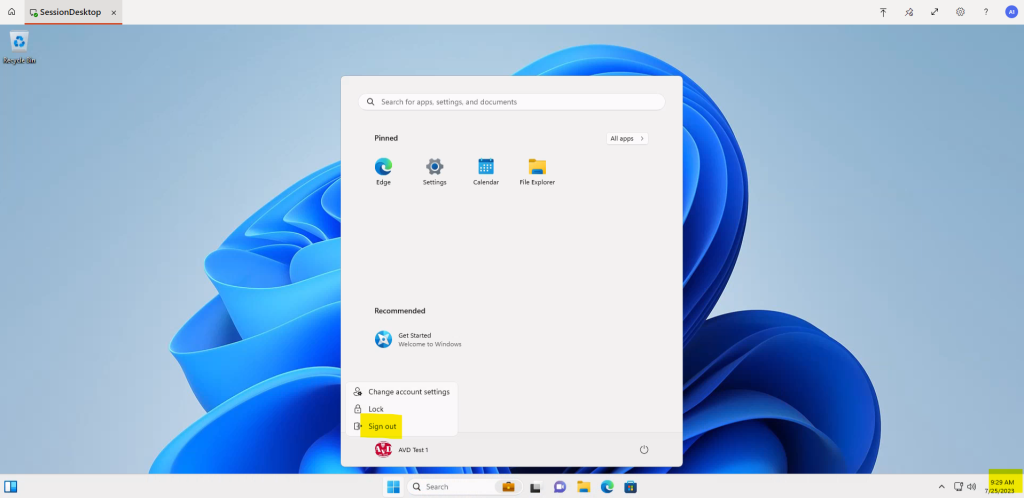

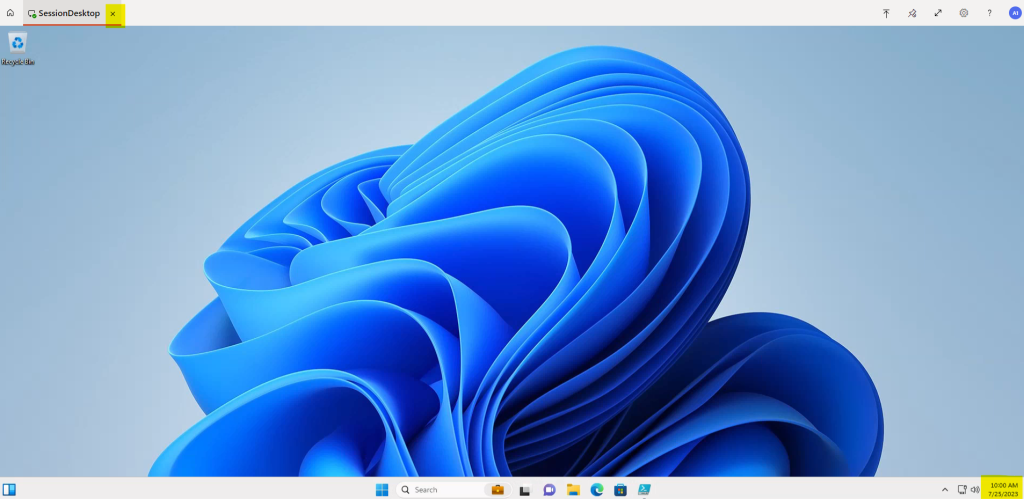

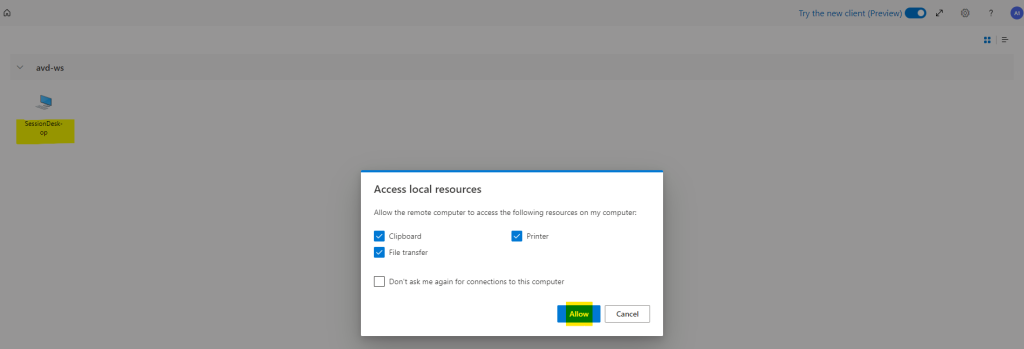

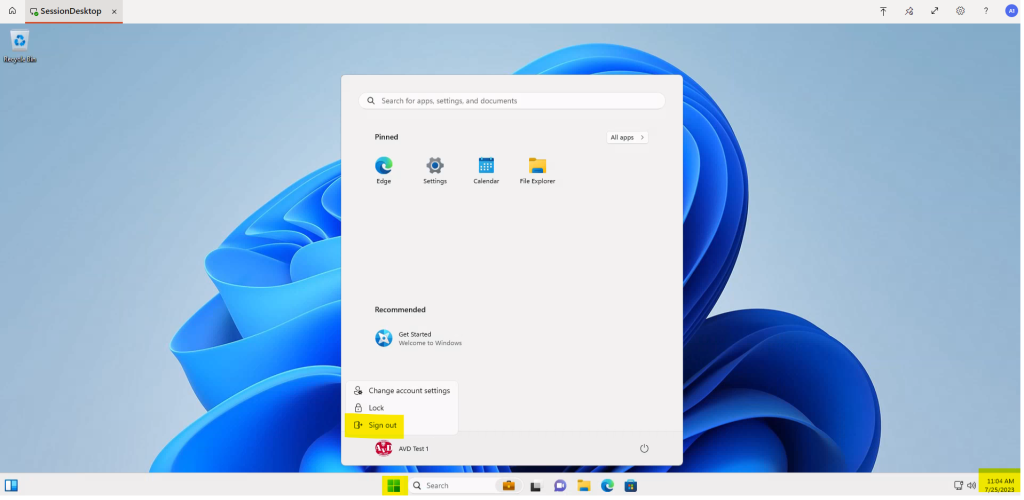

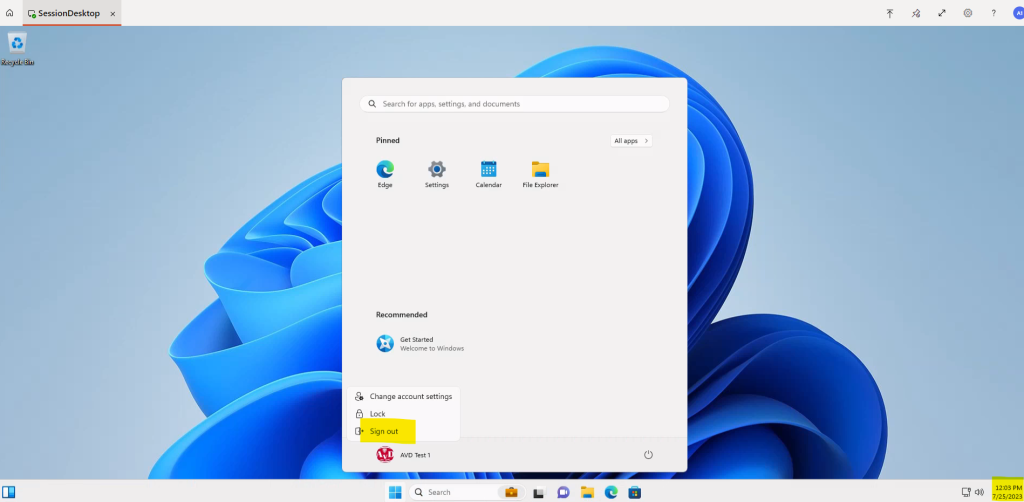

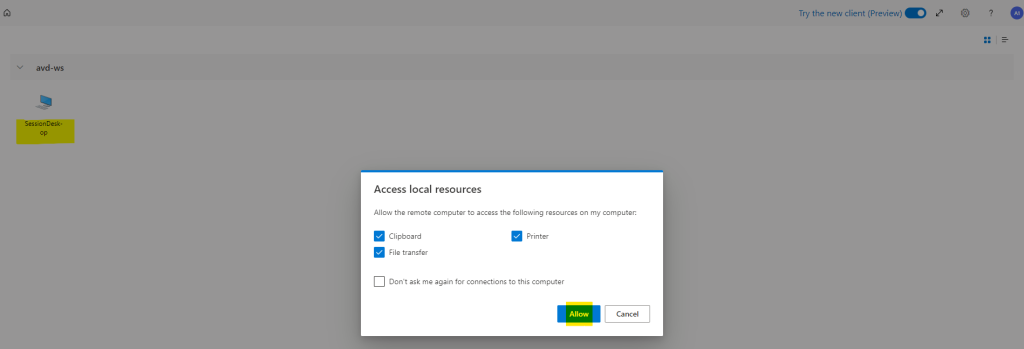

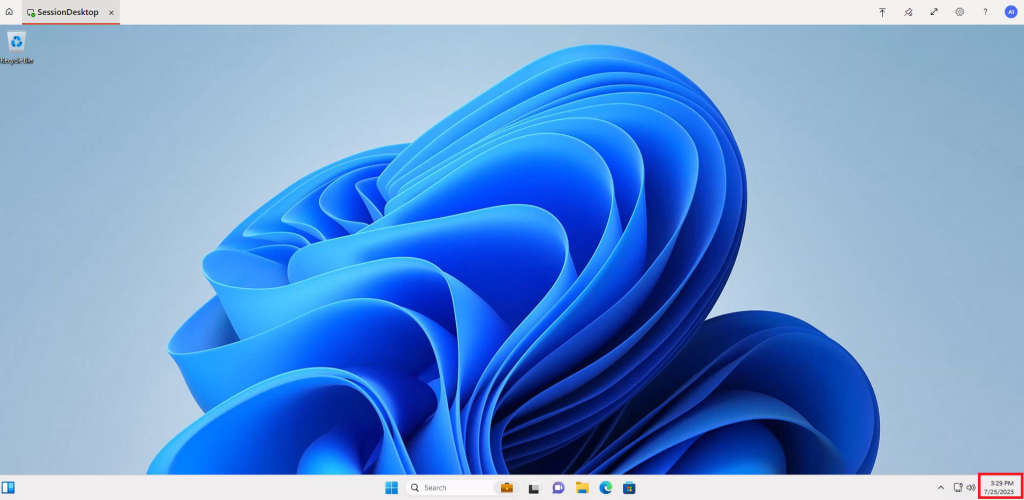

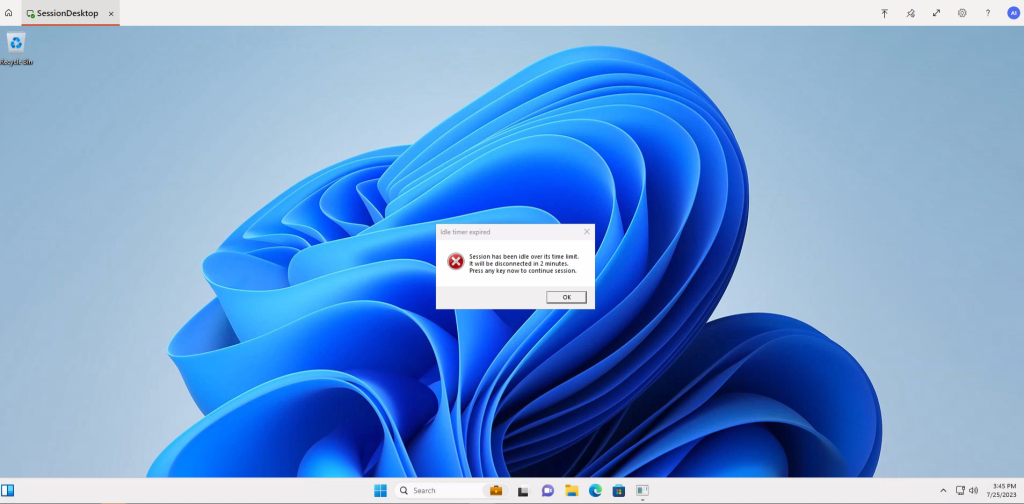

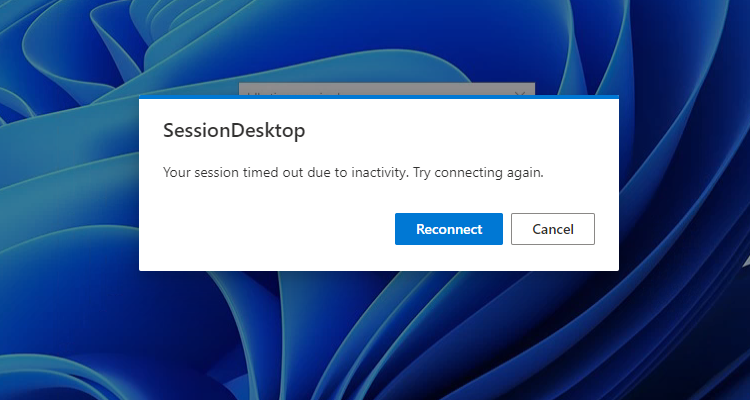

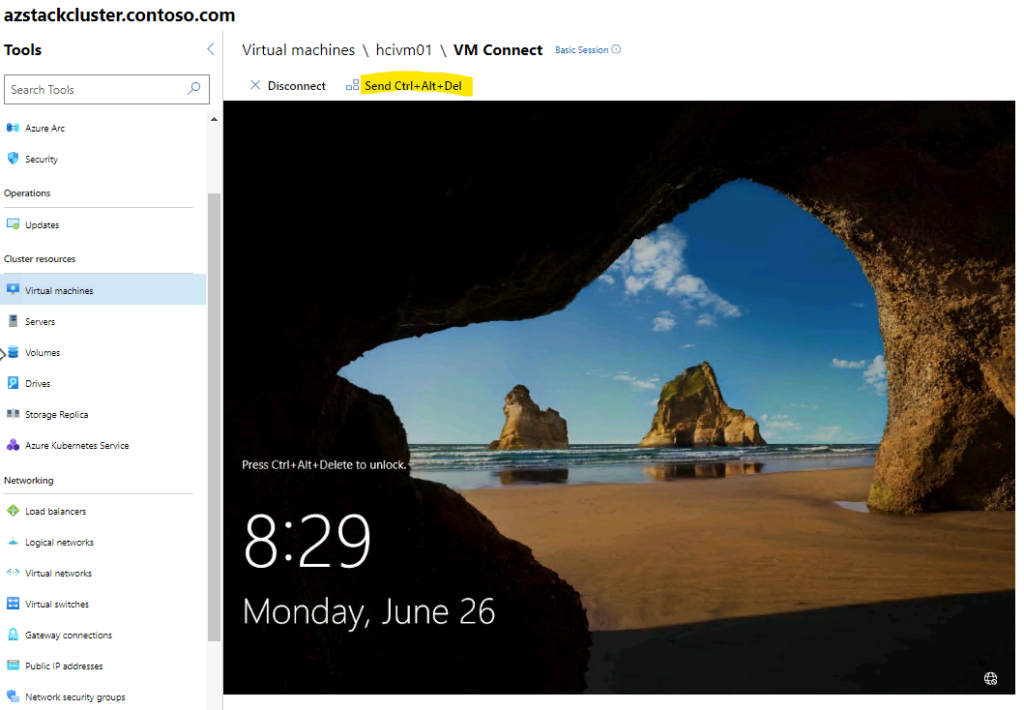

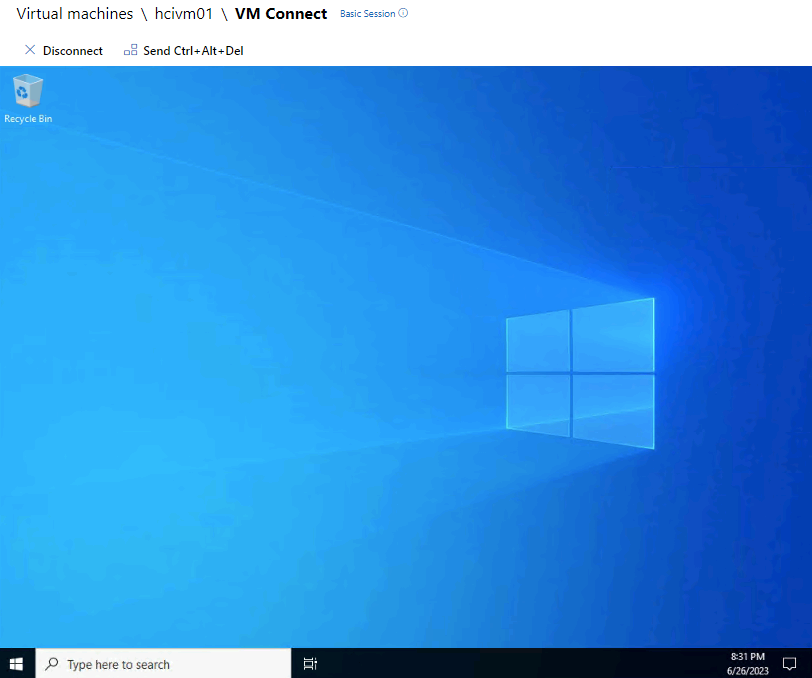

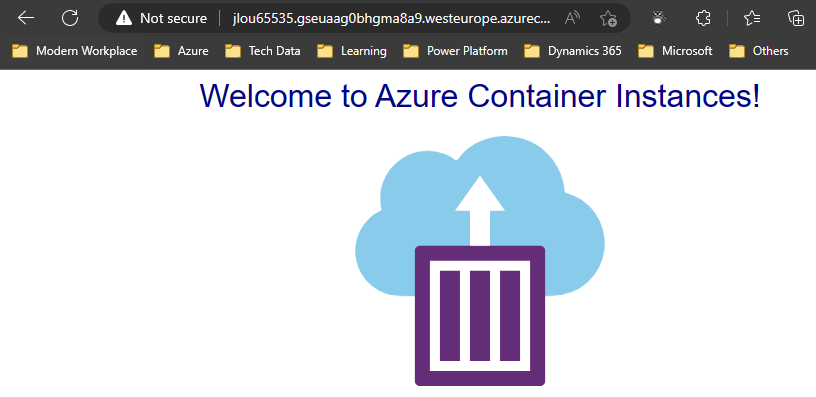

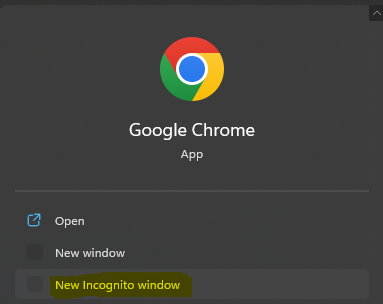

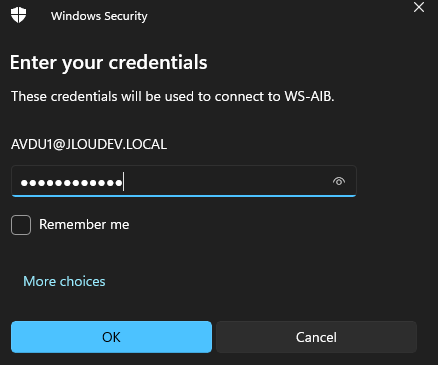

Ouvrez une session à distance sur votre machine Windows 11 de test via le service Azure Bastion en utilisant un compte de domaine :

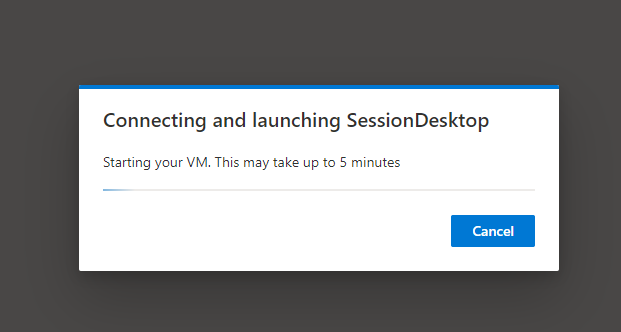

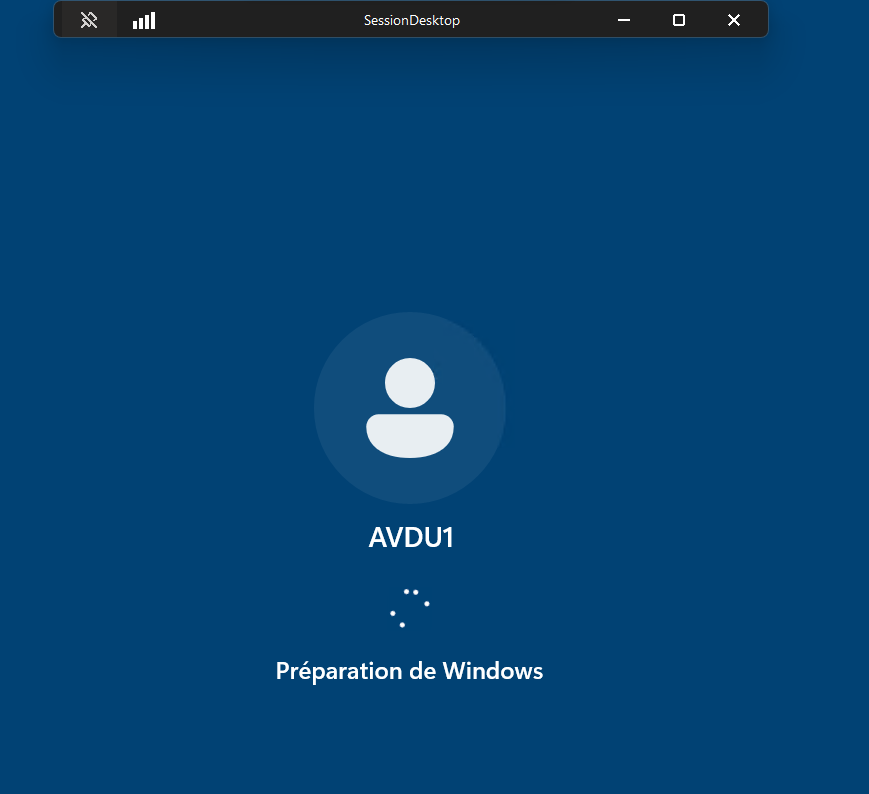

Attendez que la session Windows s’ouvre :

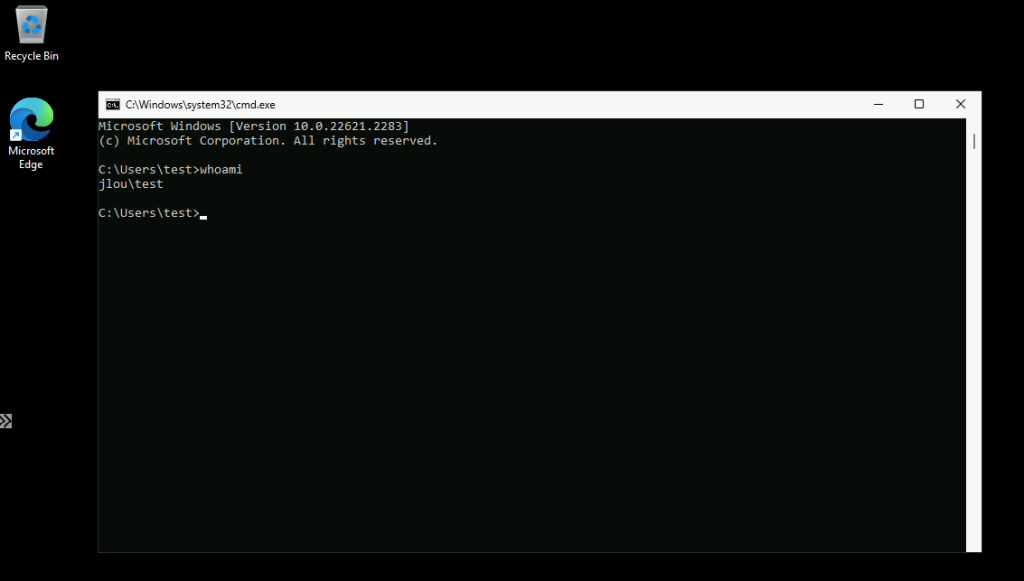

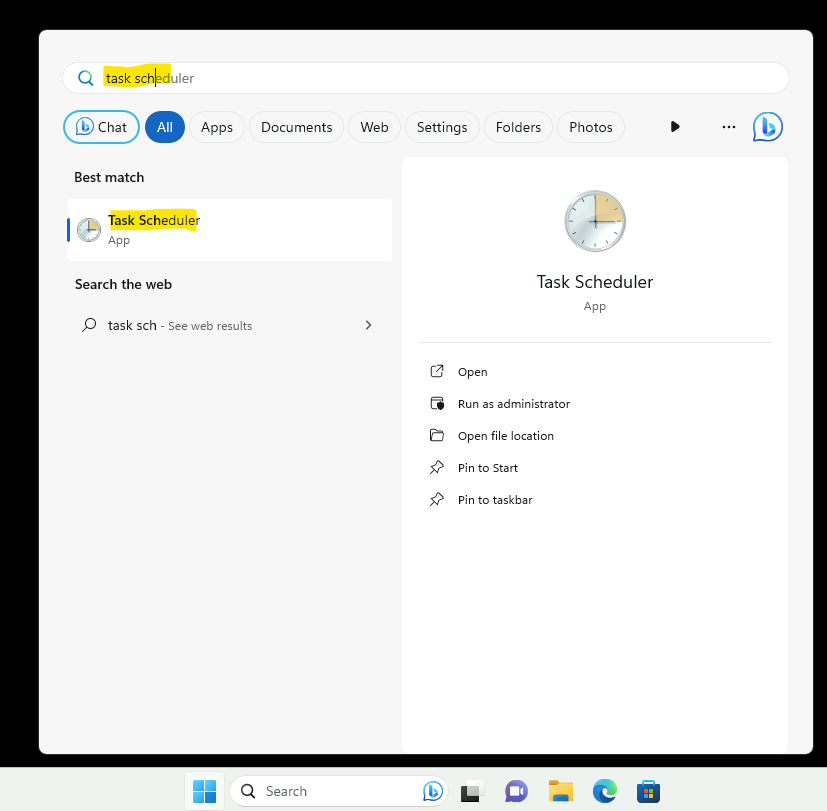

Saisissez la commande suivante afin de bien vérifier l’ouverture de session sur un compte du domaine AD :

whoamiConclusion :

Grâce à cet exercice, nous avons pu parcourir ensemble les principales étapes présentes dans une migration vers Azure d’un Active Directory, et via une version plus récente. Nul doute que le nombre et la répartition des DCs des infrastructures on-premise peut rajouter des tâches et de la complexité.